autor: Bartosz Świątek

AI AlphaStar od Google zmiażdżyło profesjonalnych graczy StarCraft 2

Zespół DeepMind firmy Google – zajmujący się pracą nad sztuczną inteligencją – poinformował, że stworzony przez niego program AlphaStar pokonał dwóch profesjonalnych graczy StarCraft 2 z Team Liquid. W obydwu wypadkach rozgrywki zakończyły się wynikiem 5:0.

W SKRÓCIE:

- AI AlphaStar pokonało profesjonalnych graczy StarCraft 2 z Team Liquid – Dario „TLO” Wünscha i Grzegorza „MaNa” Komincza;

- W obydwu przypadkach sztuczna inteligencja wygrała 5:0, choć Kominczowi udało się potem zwyciężyć w jednym dodatkowym spotkaniu;

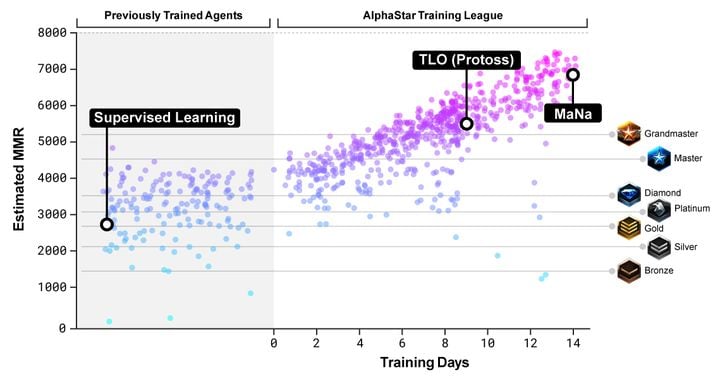

- AI uczyło się 14 dni, zdobywając w tym czasie doświadczenie porównywalne do 200 lat ciągłego grania.

Twórcy z zespołu DeepMind firmy Google poinformowali, że ich „wychowanek” – AI AlphaStar – rozbił profesjonalnych graczy Dario „TLO” Wünscha oraz Grzegorza „MaNa” Komincza z Team Liquid w rozgrywkach StarCraft 2. Rozegrano dwie oddzielne serie po pięć spotkań – w obydwu wypadkach starcia skończyły się wynikiem 5:0 dla sztucznej inteligencji. Warunki i zasady gry były porównywalne z tymi, które charakteryzują profesjonalne rozgrywki, jednak mecze mogły być rozgrywane wyłącznie z udziałem rasy Protossów.

Początkowo nic nie zapowiadało takich wyników – obserwując rozgrywki przeprowadzane przez AlphaStar Wünsch był absolutnie przekonany, że poradzi sobie ze sztuczną inteligencją, nawet pomimo wspomnianego ograniczenia (Protossi nie są jego ulubioną rasą – poziom umiejętności „TLO” w czasie grania nimi to GrandMaster). Kiedy jednak zaczął grać, AI za każdym razem stosowało zupełnie inną, niekonwencjonalną strategię, przed którą nie potrafił się obronić.

Skąd wziął się tak dobry wynik AlphaStar? Będąca podstawą programu sieć neuronowa początkowo uczyła się zasad StarCrafta 2 obserwując powtórki z meczów rozgrywanych przez ludzi. Następnie szkolenie AI weszło w drugą fazę – sztuczna inteligencja „rozszczepiła się” i zaczęła grać sama ze sobą. Zakończone spotkania skutkowały powstawaniem kolejnych podprogramów, które wykorzystywały zdobytą wiedzę, co jeszcze bardziej zwiększało różnorodność taktyk. Każdy z tzw. „agentów” zdobył w tym czasie doświadczenie stanowiące równowartość… 200 lat ciągłego grania w StarCrafta 2. Na koniec wybrano najbardziej efektywne z odkrytych strategii i zawarto je w jednym „agencie”, uruchomionym na pojedynczym desktopowym GPU.

Co ciekawe, pod względem czasu reakcji AI wcale nie było lepsze od profesjonalnych graczy. Jego wskaźnik APM (ang. actions per minute – akcje na minutę) wynosił około 280, co zdaniem programistów DeepMind jest wynikiem zdecydowanie słabszym od ludzkich profesjonalistów. Podobnie prezentują się statystyki dotyczące opóźnienia pomiędzy zaobserwowaniem danego stanu rzeczy a reakcją na niego – zajmowało to przeciętnie ok. 350 milisekund. Sztuczna inteligencja podejmuje jednak decyzje inaczej niż ludzie i inaczej postrzega grę – AI obserwowało całą mapę naraz, bez konieczności poruszania kamerą. Programiści opracowali także wersję, która musiała kontrolować kamerę tak jak ludzie – ta trenowała przez 7 dni, ale została pokonana przez „MaNa” (prace nad nią wciąż trwają).

Na koniec warto odnotować, że AI, z którym zmierzył się Grzegorz Komincz, było mądrzejsze o doświadczenie zdobyte w starciach z „TLO”. „MaNa” zdołał też ostatecznie uratować honor naszej rasy, zwyciężając w pojedynczym spotkaniu, streamowanym na żywo (zapis poniżej) przez Blizzard i DeepMind. Wygląda więc na to, że dla ludzkości jest jeszcze nadzieja, choć trzeba przyznać, że nasze szanse nie wyglądają najlepiej.