undervolting - ludziopm sie grzeja procki na slabym chlodzeniu i spada ich wydajnosc wiec robia undervolting aby obnizyc temperatury. A mozna po prostu kupic lepsze chlodzenie:)

Przy undervoltingu obcinasz napięcie karcie, żeby chodziła na zbliżonych do oryginalnych zegarach przy mniejszym zużyciu energii i w niższych temperaturach. Na bardzo dobrych kartach można zejść nawet ze 20% ze zużyciem bez utraty stabilności czy wydajności.

To coś jak overclocking, tylko nie podbijasz zegarów i napięć, tylko zmniejszasz napięcie przy bardzo nieznacznym spadku zegarów.

Czemu nie robi tego producent od nowości? Bo każda karta jest różna, każda nowa karta chodzi na stabilnych, bezpiecznych zegarach które użytkownik sam sobie może zmieniać.

A dobra, wy tu o CPU, a ja o GPU, ale zasada działania jest bardzo podobna :P

Czemu nie robi tego producent od nowości? Bo każda karta jest różna, każda nowa karta chodzi na stabilnych, bezpiecznych zegarach które użytkownik sam sobie może zmieniać.

Lepsze pytanie, czemu Intel tak poleciał z limitami mocy (i napięciami)?

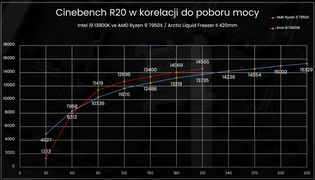

I to już każda szanująca redakcja rozgryzła w pierwszym dniu po otrzymaniu cpu - bo na niższych, dotychczasowych limitach przegrywali w syntetykach z AMD. Przy limicie 210W (najmocniejszy aktualnie procek AMD), byli 5% za nimi. Więc dawaj - cyferki muszą się zgadzać i ogień. https://youtu.be/vcjj1sOPeYc?si=USNFdWI_FvqGOH9T&t=732

Obrazek z morele>>>

Tak, niech więc użytkownik się martwi i kupuje lepsze, droższe chłodzenie, kij, że przy 330W, w stosunku do 210W, zyskujemy tylko 10% wydajności (za 50% więcej W), ale jesteśmy lepsi od AMD.

Użytkownik może zrobić:

- UV (obniżyć temp., pobór, nie tracąc na wydajności);

- ustawić sam limit mocy dla CPU (obniżyć temp, pobór, niewiele tracąc na wydajności);

- ustawić limit oraz zrobić UV (bardziej obniżyć temp, pobór, niewiele tracąc na wydajności).

Panowie, mam naprawdę głupie pytanie.

Razem z poprzednim sprzętem kupiłem oryginalnego Windowsa 10 na pendrajwie w pudełeczku. Czy bez problemu go zainstaluję na nowym kompie, skoro wciąż działa na starym? Aktywacja klucza przebiegnie bez problemu?

Zależy jaka wersja. Jeżeli to jest wersja oem to może być problem z aktywacją. Jeżeli box to nie powinno być problemu z aktywacją.

Od czasów Windows 8 nie ma OEM, a dokładnie to każda licencja jest przenoszalna

Musisz usunąć licencję ze starej płyty na koncie Microsoftu przed instalacją.

Nie do końca rozumiem.

No i prawie wszystkie komponenty już doszły. Jeszcze tylko płyta główna i chłodzenie. ;)

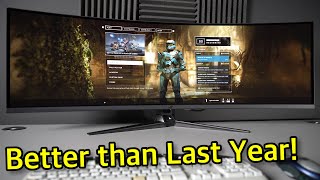

Mam nowy monitor do zestawu dla Bukarego

https://www.purepc.pl/porsche-design-aoc-agon-pro-pd49-zakrzywiony-monitor-dla-graczy-z-panelem-qd-oled-oraz-240-hz-odswiezaniem

Rozchorowałem się, a na Święta wyjeżdżam do rodziny. Wszystkie części już są, ale pewnie za tydzień będę w stanie z tym ruszyć. :)

Kto normalny kupuje nowego kompa na święta, a potem jedzie do rodziny?

Powinno Ci się odebrać przynajmniej jedną gwiazdkę...

Wszystkie części już są, ale pewnie za tydzień będę w stanie z tym ruszyć. :)

Podziwiam. U mnie kurier jeszcze z podwórka nie odjechał, a ja już miałem śrubokręt w ręce :P

Nie dziwię się.

Niektórzy kurierzy są dość aroganncy, a nawet agresywni...

Trzeba mieć się czym bronić.

Nie straszcie, że coś będzie nie tak. Cegły w pudełku mu przecież nie przysłali, nikt po sprzęcie też mu nie skakał. Jakby mu minął termin odstąpienia to ma rękojmie.

Rozchorowałem się, a na Święta wyjeżdżam do rodziny.

nie wierzę kupić zasilacz bez złącza 12vhpwr nowy z kartą 4080 ? poważnie :)

zwróć go jeśli jeszcze możesz a możesz bo 14 dni obowiązuje i kup zasilacz który ma modułowe podłączenie pod 12vhpwr na jednym kablu. Nie chodzi tylko o przejściówkę ten zasilacz ma na tym złączu 600W i dawkuje prąd zależnie od zapotrzebowania karty a nie obciąża w 100%. Różnica jest taka że sama wtyczka vs zamiennik to ok. 5C mniej a na prądzie urwiesz kilkanaście kWh miesięcznie, nie mówiąc o samej kulturze pracy całości. On jest oczywiście opisany jako PCIE5.0/ATX3.0 ale nie ma dedykowanego złącza. Druga kwestia która też zauważyłem ze ma wtyczkę z podłączeniem górnym które też nie jest najlepsze.

Kolejna kwestia to UV robi się tylko wtedy na CPU/GPU kiedy ktoś ma chodzenie które właściwe pracuje przy limicie i które bije wykresem pod drugie odcięcie. Temperatura przeskakuje limit np. przy boos na rdzeniu i z automatu spadają zegary poza ustawienia bazowe. Nie tylko masz ciągłą żonglerkę zegarami i złą prace karty graficznej co tracisz na wydajności. Wtedy i tylko wtedy wykonujesz UV. Robienie tego ma tylko sens kiedy twoje chłodzenie na GPU lub CPU nie wyrabia na zakrętach. W każdym innym przypadku powinieneś jeśli chcesz nawet wrzucić power limit na 120-130%. Różnice w poborze prądzie / temp są nieznacznie wyższe a zyskujesz np. 5-10% więcej fpsów.

za to kartę kupiłeś jedną z najlepszych z tej serii gainward phantom ma chyba najlepszą przy asusie strixie kulturę pracy a samo chłodzenie jest bardzo bardzo dobre.

zresztą nie tylko ciebie każdego kto chce porady zapraszam na steam -> odpisuje praktycznie zawsze po pewnym czasie.

Panowie, komp złożony (również dzięki nieocenionej pomocy kumpla z pracy). Testowałem jakieś 2 godziny. Chyba wszystko działa.

Ustawiłem CP2077 na maksa (z DLSS), pograłem przez 30 minut i obserwowałem wskaźniki. Mam na razie monitor 60 Hz, więc nie wiem, jaki maksymalny klatkaż osiągał komp, ale poniżej granicy 60 fps nie spadał. Przy ray tracingu i path tracingu najniższe wartości (czyli 99% FPS w nakładce Nvidii) były podobne - ok. 53-56 fps (ale to się zdarzało rzadko). Myślałem, że path tracing bardziej zarzyna kompy niż ray tracing, a różnicy wydajnościowej (w Cp2077) nie widzę.

Temperatura GPU - cały czas w okolicach 55-59.

Temperatura CPU - średnio 62 (czasem na jednym rdzeniu dochodziła do 80).

W przyszłym tygodniu więcej testów zrobię. Możecie polecić jakiś fajny benchmark (darmowy)? Pobrałem UserBenchamark, ale to dosyć prymitywny program. BTW, pokazywał, że wszystkie komponenty działają nadspodziewanie dobrze... poza karta graficzną, która mogłaby się sprawować lepiej. Nie za bardzo wiadomo, o co chodzi, więc chętnie bym wpróbował jakiś benchmark, który porówna wydajność zestawu z wydajnością podobnego sprzętu.

Dziękuję wszystkim za pomoc! To w sumie zestaw, który jest waszym "dziełem".

Wątku nie zamykam, bo pewnie będę miał jeszcze różne pytania. A poza tym wkrótce (za jakieś 2-3 tygodnie) trzeba kupić monitor. ;)

Przy okazji: z włączonym path tracingiem CP2077 rzeczywiście wygląda zjawiskowo z tymi wszystkim światłami. Ray tracing z kolei sprawia, że gra się czasem świeci jak... wiecie co. ;)

poza karta graficzną, która mogłaby się sprawować lepiej.

Dokładnie taki sam uczuć miałem, kiedy się przesiadłem z Radeona RX580 na RTX 3070.

Możesz odpalić sobie Furmarka i sprawdzić ile punktów wygenerował, a potem porównać z globalnym wynikiem.

U mnie był to taki sam score jak powinien.

Nie przejmuj się, prawdopodobnie to wina kiepskiej optymalizacji gier albo zbyt wygórowanych oczekiwań.

No chyba że naprawdę coś dziwnego się dzieje.

Możesz odpalić sobie Furmarka i sprawdzić ile punktów wygenerował, a potem porównać z globalnym wynikiem.

Odłączyłem już nowego kompa, żeby starego "wyczyścić" przed ostateczną przesiadką. Ale w przyszłym tygodniu (jak tylko wrócę do domu) na pewno pójdę za twoją radą. Dzięki za polecajkę! Szkoda, że nie pomyślałem o tym programie wcześniej.

Nie przejmuj się, prawdopodobnie to wina kiepskiej optymalizacji gier albo zbyt wygórowanych oczekiwań.

Nie wiem, czy dobrze wyjaśniłem, co mam na myśli. Mnie się wydaje, że karta się dobrze sprawuje. Pewnie jakiejś dużej różnicy na razie nie zauważyłem, bo system (monitor) nie puszczał powyżej 60 fps-ów. Miałem na myśli to, że w UserBenchmarku pojawił się taki właśnie komentarz przy karcie graficznej ("underperforming"), podczas gdy wszystkie inne elementy świeciły się na zielono ("overperforming"). Może chodzi właśnie o ograniczenie 60 fps? Nie mam pojęcia.

ja bym podpiął tak aby kable do GPU nie były pod kątem i już na pewno nie tak aby dotykały backplate karty. Tak samo kable od AIO oparte na GPU ta płytka będzie miała min. 40C a latem z 60. Tak nie powinno być to zmontowane. Powinieneś te kable podnieść do góry i odpowiednio wyprofilować.

Tak samo kable od AIO oparte na GPU ta płytka będzie miała min. 40C a latem z 60.

Hmmm... Nie za bardzo mam pomysł, jak można byłoby inaczej te kable od AIO umieścić.

Co do GPU... to pewnie by trzeba kable jakoś pod spodem puścić, zasłaniając ten napis "Phantom"?

- ja bym puścił kabel dołem byłby idealnie podpięty do GPU (zasilanie GPU) możesz próbować też górą ale to mała obudowa jest w sumie i nie wiem czy ci się to uda. A to że ci przysłoni napis i co z tego :) fajny jest ale lepiej jak coś technicznie lepiej jest pospinane

- przewody od AIO spokojnie możesz jak wyprostować i z czymś spiąć opaską aby nie dotykały do backplate one też są elastyczne. Nie możesz zostawić tego w ten sposób aby to leżało na tym. Pograsz teraz w coś godzinę to zobaczysz jaki on będzie gorący / nie ciepły a gorący.

GPU ma fajną temperaturę za to CPU taką sobie co nie znaczy broń Boże że jest zła. Po złożeniu komputera warto kupić jeśli nie masz 3DMarka całego teraz jest wyprzedaż na steam to kupisz za grosze i zrobić stress test na 20 loop tak z 3x wtedy na 100% będziesz wiedział czy wszystko jest okey. Dobrze złożony komputer nie ma żadnego crasha w żadnej grze. Sam ostatniego widziałem gdzieś w okolicach 2007 roku. Do testu CPU możesz użyć WinRara -> Narzędzia test wydajności i zostaw tak na 60 minut. Obie rzeczy to gwarancja solid rock.

ODIN85 - jeśli chodzi o poziom grafiki to HDR całkowicie zmienia odbiór gier (sam wiesz). Poziom cd/m2 ma znaczący wpływ pokrycie itd. Najlepiej wypadają obecnie oledy i qledy oraz qdoledy (najlepsze pokrycie). Nie da się bezpośrednio porównać HDR do HDRu. Ostatnio miałem w domu najlepszy obecnie wyświetlacz na rynku Sony A95L i porównałem go z moim G3 który uważany jest za jeden z 3 najlepszych. Jakież było moje żdziwienie nie tylko tym że jest inna kolorystyka (przewaga qdoledów jest ogromna) to w zestawieniu z S95C (też mam) i G3 na Sony obraz był o wiele bardziej głęboki prawie trójwymiarowy. I to już nie jest kwestia samej matrycy a elektroniki. Sony to jednak jest top topow. Różnice w detalach w obrazie są widoczne np. kółeczka na zbroi w Elden Ringu.

Bukary - powinieneś obrac sobie za cel min. C3 z 120Hz lub w promocji kupić S92C (144Hz) w połączeniu z 4080 zobaczysz coś czego nie widziałeś ;) HDR i jego jakość to niebo a ziemia względem obrazu SDR. Dodatkowo napisałeś o 60Hz przecież to jest mega lag z samego opóźnienia.

Nie musisz też celować w monitory 32:9 czy 21:9 każdy porządny TV jednym przyciskiem wybiera dowolny format a że czerń jest bez końca a ramka milimetrowa to nawet nie zobaczysz różnicy w wyobraźni.

Aleks, dzięki za rady!

Zaraz po Świętach będę szukał monitora. Ze względu na moje upodobania i określoną przestrzeń do pracy to będzie zakrzywiony monitor (a nie telewizor) o proporcjach ultrapanoramicznych (21:9). Niczego innego nie biorę pod uwagę.

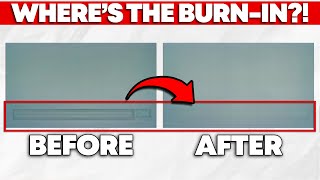

Zastanawiam się poważnie nad OLED-em. Niestety, gdziekolwiek bym nie zajrzał, widzę ostrzeżenia przed szybkim wypalaniem ekranu w przypadku tego rodzaju paneli. Ten film dobrze to wyjaśnia:

https://www.youtube.com/watch?v=Fa7V_OOu6B8

Na monitorze raczej oszczędzał nie będę, bo to dla mnie najważniejszy komponent zestawu. Zastanawiam się nad Dell Alienware AW3423DWF. Odstrasza mnie jednak ten problem, o którym wspomniałem wyżej. Nieco lepszy ("jaśniejszy") model (Dell Alienware AW3423DW) jest już poza moim zasięgiem cenowym.

https://www.rtings.com/monitor/reviews/dell/alienware-aw3423dwf

W oko wpadł mi również LG UltraGear 38GN950. Nie wiem jednak, czy moja karta da sobie radę z taką rozdzielczością (3840 x 1600). Jedni go chwalą, inni - trochę narzekają:

https://www.rtings.com/monitor/reviews/lg/38gn950-b

Jest jeszcze:

https://www.rtings.com/monitor/reviews/samsung/odyssey-oled-g8-g85sb-s34bg85

Ale to też OLED (z całym dobrodziejstwem inwentarza).

Próbuję znaleźć coś porządnego w cenie ok. 3-4 tysięcy, ale jest ciężko. :P

Akurat w monitorach masz gwarancję na wypalenie więc nie masz się czego obawiać.

Nie masz co się bać 3840 x 1600 bo 4080 nawet w 4k daje sobie radę.

Akurat w monitorach masz gwarancję na wypalenie więc nie masz się czego obawiać.

Niby gwarancja jest, ale tylko 3-letnia. A na filmiku, który zamieściłem powyżej, można znaleźć właśnie test Della Alienware, który pięknie się wypalił po niewielu godzinach użytkowania. :(

Czy ktoś z was ma dłużej OLED-a? Co sądzicie?

Propozycja niekonwencjonalna tutaj. Dell AlienWare AW3420DW 34 z Amso, poleasingowy w idealnym stanie - https://amso.pl/product-pol-106012-Monitor-Dell-AlienWare-AW3420DW-34-LED-3440x1440-IPS-HDMI-G-Sync-Dla-Gracza-Klasa-A.html

https://allegro.pl/oferta/gamingowy-monitor-alienware-34-3440x1440-gracz-14669482482

Siedzę na tym i do czasu aż OLED-y nie "wydorośleją" i nie pokażą, że działają po pięciu latach, to nie widzę sensu brać czegokolwiek innego.

Jeden rabin powie tak, drugi rabin powie nie :P

Osobiście być może już bym zakup OLED-a zaryzykował, ale nie przy ultrapanoramach i ich cenach - choć oczywiście wszystko zależy od zarobków i tego, jak szybko ty będziesz mógł się z nim pożegnać.

Dużo też chyba zależy od jasności ustawionej zazwyczaj poza grą...

Pasek zadań można ukrywać, choć osobiście by mnie to wpieniało, w samych grach to już kwestia tego jak długie masz sesje i znowu - z jaką jasnością...

Rzuć okiem na wątek na PCLab :)

Przewody od AiO chyba mogłyby być po lewej stronie CPU. Wtedy nie opierałyby się już o GPU. Te od GPU zdecydowanie puściłbym do dołu.

Łosiu - oszczędzi 1,5k by kupić potencjalnie zajechany sprzęt? Gdzie tu logika?

Bukary - to zależy od tego jak będziesz tego używał i o to dbał. Oledy mają ograniczoną żywotność i na 100% się wypalą to jest kwestia tylko czasu. Jeśli będziesz tylko grał a ekran statyczny zostawiał z wygaszaczem załączanym po 60 sekundach i to najlepiej ruchomymi falami to raczej prędzej go wymienisz niż się wypali. Jak będziesz pracował non stop w wordzie, excelu itd godzinami lub zostawiał z ikonami to na 100% się one utrwalą to jest to tez kwestia czasu. Gwarancja na wypalanie jest w większości monitorów jeśli chodzi o TV to jedynie taką gwarancje ma G3 model od LG. Przy normalnym jednak graniu i używaniu to raczej szans na to dużych nie ma. Poza tym te powidoki będą widoczne na jakimś konkretnym tle i przy konkretnym nasyceniu. Jeśli założysz że wymienisz monitor w ciągu 4-5 lat od zakupu to bym tego problemu nie brał pod uwagę jeśli jednak nie to wtedy bym szukał qleda porządnego. Jak wybierzesz to co ci pasuje to ci napiszę który najlepiej. Ważne aby był wysoki HDR ale też duże pokrycie barw i jeśli to nie oled to też porządny kontrast i lokalne wygaszanie. Weź też pod uwagę że monitor są droższe niż TV o tych samych parametrach. Ciekawym wyborem jest zakup np. 42" LG Oleda i jeśli tak lubisz używanie go w proporcji 32:9 lub 21:9. Na pewno w tej cenie monitor o takich parametrach kosztowałby 2x tyle. Ja bym rozważał właśnie taki wybór. Wszystko zależy od budżetu ale monitor/TV to jest najważniejsza rzecz jaką kupisz do doznań graficznych. Ja uruchomisz cyberpunka 2077 na porządnym wyświetlaczu HDR to skończysz go kolejny raz. W ogóle wrócisz do wszystkich wspaniałych gier i będziesz się nimi delektował. Właściwie dzisiaj większość ma kapitalnie wykonany HDR z takim BG3 na czele. Elden Ring z RT i HDR to przysłowiowe WOW.

Łosiu chce dobrze ale się nie zna :) Żadnych IPSów ! Jedyny wybór to oled lub qled czyli matryca qledowa na VA z lokalnym wygaszaniem. Czerń musi być czarna jeśli nie będzie idealna lub prawie idealna (wygaszanie ma to do siebie że wygasza strefy, w przypadku oledów każdy punkt jest strefą wygaszania) Najlepsze TV/monitory mają ponad 1000 takich stref + są na VA. qled to gwarancja kolorów a VA czerni jak czerń nie jest czarna to leci cała kolorystyka. Dlatego oledy a obecnie qdoledy (które mają pokrycie nawet 130% (w ogóle szok że coś może mieć 100%+). Są też różne inne wariacie nowych matryc ale to tak jak napisałem podaj albo budżet albo modele to ci wybiorę.

To jest uniwersalne b. dobre rozwiązanie (absolutnie najlepsza jakość do ceny w tym rozmiarze) ->https://youtu.be/gUdiwQt3SkA

To jest b. dobre rozwiązanie monitorowe z lepszą matrycą bo qdoledową ale cena jest wyższa -> https://youtu.be/IUwtDU96UtQ

Moje preferencje to 55" wtedy wybór jest ogromny tylko zależy to już od budżetu bo top topów to ok. 15K a super ekonomia do jakości to 6K PLN za S92C który jest absolutnie najlepiej wycenionym panelem na rynku cena do możliwości.

W cenie 4K PLN spokojnie kupisz 42" C3 oled

https://www.ceneo.pl/152219531

recenzja C3

https://www.rtings.com/tv/reviews/lg/c3-oled

Herr:

Rzuć okiem na wątek na PCLab :)

Właśnie przeglądam. Nie napawa optymizmem. A bardzo mi się podobał ten Alienware. :P

Przewody od AiO chyba mogłyby być po lewej stronie CPU.

Wtedy znowuż przeszkadzają wiatrakowi. ;) Przejrzałem szybko internety i znalazłem zapewnienie ze strony Corsaira, że kable dotykające GPU to nie jest problem (widać, że wiele osób ma tego rodzaju wątpliwości). Ale może coś jeszcze uda się wykombinować.

Aleks:

Jak będziesz pracował non stop w wordzie, excelu itd godzinami lub zostawiał z ikonami to na 100% się one utrwalą to jest to tez kwestia czasu.

Niestety, wygląda na to, że OLED u mnie odpada. Szkoda. :(

Muszę w takim razie szukać czegoś na innej matrycy.

Zepnij oba dosyć ciasno trytką, a następnie o tę trytkę zaczep drugą i zepnij do obudowy. Nie wierze, że nie da się ich jakoś estetycznie podnieść o 1cm. Weź, cienką czarną, obetnij końcówkę i będzie niewidocznie.

Co do programików do testów, to już polecałem - darmowy 3d mark ze steam - sprawdzić gpu i cpu score, czy odpowiada wynikom innych RTX 4080 i i7.

Co do monitora, to właśnie testuje Samsunga G8 OLED. Mam tez ostro przetestowanego S90c, Panasa 980 i Sony 80 Tv OLED.

W sumie nie wiem co napisać, by ci nie mieszać. Ja mam zupełnie inne spojrzenie na monitory i odradzam tego OLEDa (21:9 na matrycy samsunga jest 5 monitorów oled). Wrzucę poniżej porównanie z tekstu nt. testów, ale dalej robię pomiary, sprawdzam itd.;

Tekst własny (czemu G8 a nie DELL na testach)

Do wyboru było aż 5 monitorów – każdy na tej samej matrycy. Każdy też oferował podobną jakość z pudełka (fabryczne tryby), lecz nie wszystkie dawał takie same opcje kalibracji. Podobnie wypadały co do ergonomii (tilt, pivot, svilt itd.). Jest jednak kilka sporych zalet Samsunga nad innymi, ale po kolei:

1. MSI MEG 342C QD – oferował najlepsze podłączenia (zwykłe DP 1.4, HDMI 2.1 - 48gb, USB hub, jak i usb-c hub, c alt mode); ładowarkę PD65W, nie dawał natomiast opcji dostosowania gammy (czyli brak pełnej kalibracji, jedynie częściowa przez 1 point balance; zostaje profilowanie); PIP; wyjście audio, brak głośników.

2. Dell Alienware AW3423DW oraz AW3423DWF – oferowały najgorsze podłączenia (DP 1.4 i HDMI 2.0 – a nie ukrywam, że kiedyś może podepnę konsolę), miał najlepsze kolory z pudła, usb hub, brak ładowarki i podobnie jak MSI oferował częściową kalibrację. PIP; wyjście audio, brak głośników. Model z „F” różni się brakiem g-sync oraz 165hz zamiast 175hz, ale karty Nvidii działają z normalnym VRR, więc bez różnicy, tyle, że taniej.

3. Philips Evnia 34M2C8600 – bardzo zbliżona charakterystyka do Della (HDMI 2.0, b. dobry tryb z pudła), lecz praktycznie bez opcji kalibracji (nawet balansu bieli), PIP; wyjście audio, brak głośników.

4. Samsung G8 OLED (min DP 1.4, micro HDMI 2.1 - 40gb, c alt mode), ładowarka PD65W, brak usb huba, pełna opcja kalibracji. Brak PIP, głośniki 5W, brak wyjścia audio.

Powyższe aspekty nieco wpłynęły na wybór, ale nie były kluczowe (chociaż za ogromny minus uznaję brak usb huba, z którego zawsze w monitorach korzystałem oraz brak wyjścia audio pod głośniki). Tymi okazały się dodatkowe funkcje Samsunga. Przede wszystkim multimedialność i system Tizen. Aplikacje jak na TV (Netflix, Prime, HBO itd.) i wszystko spokojnie zadziała w HDR, a nie jak na Windows, gdzie nieraz to przeprawa przez piekło (chociaż dziś jest lepiej niż 2-3 lata temu, to nadal łańcuch uzyskania HDR jest nieco skomplikowany). Do tego HDR10+ (amazon prime, rakuten) oraz HDR10+ gaming (który niedługo debiutuje). Normalnie nie łapie się na takie zabiegi, ale HDR10+ znam i cenię (tak jak i Dolby Vision). Na dodatek pełna kalibracja (nie blokuje opcji w żadnym trybie obrazu) i opcja kalibracji przez apkę ze smartphona Samsung. Dorzucając do tego pełną opcję dostosowania formatu obrazu (czyli filmy 2.35:1 w full screen z aplikacji Netflix, prime itd.). I na ostatek – każdy pozostały QD-OLED 34” jest mniej (DELL z "F", MSI) lub bardziej (Philips oraz DEll bez F) słyszalny (chłodzenie wentylatorem). Ten od Samsunga nie. Możecie się śmiać, ale od lat siedzę przed monitorami chłodzonymi wentylatorami i te potrafią być irytujące, natomiast jestem w tym aspekcie przyzwyczajony do ciszy i nawet mój retro EIZO, po 12000h i 14 latach na karku, jest cichy (niesłyszalny ponad tło, nawet w nocy), gdy mu nie dowalę jakąś dużą jasnością na długo.

Kolejną ważną sprawą były gwarancje oraz wypalenia. Dell i MSI to 36 miesięcy gwarancji; Samsung i Philips 24 miesiące. Nie mam zamiaru go wypalać, ale to OLED. Gwarancje na wypalenia oferuje Dell. Samsung w teorii nie (chociaż to informacje zagranicznych oddziałów, nie wiem jak w PL). Reszta modeli - nie wiem. Ale nie miało to dla mnie większego znaczenia, gdyż przy moim użytkowaniu (80% w 80-120 nitów; 20% hdr) raczej w 2 lata nic się nie pojawi, tym bardziej, biorąc pod uwagę drugi najważniejszy punkt co do wypaleń – technologie przeciwdziałające. Samsung i Philips mają wszystkie opcje. Długi refresh (1h, zalecany po 1500h/2000h); krótki (6/7 min, po każdych 4h użytkowania i przejściu w standy/wymuszony); pixel Shift; jasność elementów statycznych – logo itd. (ABL). Dell oraz MSI mają krótki i długi refresh, brak info o przyciemnianiu elementów statycznych.

Ważna adnotacja – sam tego nie sprawdziłem, gdyż mam GPU Nvidii, ale Oledy na matrycach Samsunga nie chcą za bardzo gadać z GPU AMD. Jedynie MSI i Dell bez „F” nie miały tu problemów. Pozostałem ucinały maksymalną jasność na 500 nitach i/lub miały problem z migotaniem. Do tego, na ten moment HDR10+ gaming działa tylko na gpu Nvidii (tyczy się tylko Samsunga G8, jako jedynego wspierającego tę technologię). Z HDR10+ na ten moment mogą korzystać wszystkie gry na UE 5.2 i nowszym.

Jak widać, na podstawie powyższego, nie ma „idealnego” QD-OLEDa. Samsung byłby dla mnie, gdyby miał usb hub, wyjście audio pod głośniki oraz, może, dłuższą gwarancje z pokryciem wypaleń. Dell i Philips średnie pod ew. konsole, do tego bez smart systemu. MSI wygląda ok. prawie pod każdym względem, poza kalibracją. Ponadto tylko Samsung wspiera HDR10+ (też pod gry) i ma głośnik (nawet znośne), jeżeli to miałoby dla kogoś znaczenie. Poza Dellem z „F” brałem każdy pod uwagę i gdzieś już każdy miałem w koszyku, to jednak Samsung mnie przekonał. Oczywiście Tizen i HDR10+ to sporo marketingowego pierdu pierdu Samsunga, ale też trochę faktycznych zysków. Do tego bezproblemowe podpięcie konsoli z HDR i supersamplingiem z 4k (to oferuje też MSI); oraz pełna kalibracja (to już tylko Samsung).

Po pierwszych testach z marszu mogę powiedzieć, ze chociaż G8 ma własnego smart TV (co jest ogromnym plusem z uwagi na utrudnione życie HDR na windows - np. apki amazon czy Disney nie odpalają na Windows HDR), lecz ogromnym problemem okazuje się procesor obrazu tego monitora. Cokolwiek z niższym bitrate odpalam z apki na monitorze (ograniczone do 1080p i upscaling przez monitor do 1440p), to posteryzacja, pompowanie skalowania i to nie raz i już. Obraz mroczkuje kilka razy na sekundę. Przy wysokim bitrate jest w miarę ok. Rozwiązaniem jest np. podpięcie apple TV (dalej ma hdr10+, 4k - więc będzie supersampling, do tego fps to hz match).

Ale kupujesz monitor, a nie TV, więc pomijając multimedia, to sam monitor ma genialny zakres tonalny, średnią płynność obrazu (na 175hz - tylko w trybie gra jest powiedzmy ok; poza trybem gry 60 lub 120hz i tu jest już gorzej). VRR oczywiście działa (gsync compatible) i nieco pomaga. Miałem już też zonka z przestrzeniami kolorów. W jednej aktualizacji Sasmung niby naprawił tryb auto, w następnej naprawił native ehhhh... w 90% auto będzie odpowiednie, ale np. dla przerabianych hdr, robionych pod rec 2020 (m.in. Piraci z Karaibów na Disney+ w HDR), już trzeba zmienić na native, żeby było ok. Poza tym Kalibracja i profilowanie proste. Co do kalibracja przez smartphona, to jest robiona pod native, więc tak średnio użyteczna. Ale pozostawiając rzeczy, na które może nie zwrócisz uwagi:

- G8 ma przyzwoite głośniki jak na monitor,

- brakuje tego huba usb,

- Czerń, jak czerń, ok, w multimediach się przydaje, ale dalej do grafiki tego monitora się nie użyje.

- G8 jest też zbyt jasny na nocny użytek (min. jasność to niby 60 nitów, ale to przy prawie zerowym kontraście; jak chcemy coś zostawić w rozsądnych wartościach, to bliżej 100 nitów - vide, w zupełnie ciemnym pomieszczenie jako monitor do czytania czy coś, nieużytkowy).

Nie mam też zbyt dużego problemu z czytelnością tekstu (na co zwracają media uwagę przy tych matrycach). Powiedziałbym, że ta poświata przy literakach jest lekko widoczna, ale jest ok.

Podsumowując G8 (i w sumie pozostałem ultra wide na matrycach OLED od Samsunga):

- na TV się nie nadają, chyba, że w parze z apple tv;

- mistyczna płynność OLED jest w przypadku tych matryc średnia (obok CRT czy LCD z włączonym strobingiem to to nie stało) - dopowiem, ze matryce od LG, przede wszystkim te w TV panasa i Sony, gdzie mamy lepsze sterowanie BFI, radzą sobie lepiej; Dlaczego? Sample and hold i tyle w teamcie, a do tego błyskawiczny czas reakcji matrycy przy tej technice szkodzi, a nie pomaga - tworzy screen-door motion resolution effect(na 120hz dość widoczny, na 175hz mniej i widoczne bardziej w filmach niż grach, tym bardziej, że w tych jest opcjonalny VRR).

- genialny zakres tonalny i HDR (potrafią być jasne; przede wszystkim w HDR 10+, chociaż ten jest tylko w G8 - to najjaśniejszy OLED jakiego testowałem);

Co do wypaleń, to każdy z tych monitorów ma technologie przeciwdziałające i jak my ich nie odłączamy od prądu tuż po skończonym użytkowaniu (wtedy przeprowadzają szybki referesh - 6-7 min), to się raczej nie wypalą, tym bardziej jak w SDR będziemy siedzieli na 100 nitach, a nie 240 i wypalali nie tylko ekran, ale też sobie oczy.

Sam pewnie zwrócę/sprzedam G8 i dalej będę siedział na swoim Eizo. Aktualnie trzaskam porównania tej G8 z prawie topowym CRT ;)

Co do wyboru monitora przez Ciebie, to jeżeli nie celujesz w HDR (przynajmniej 20-30% użycia), to OLED ma średni sens. Lepszy będzie jakiś dobry LCD. I to nie kwestia wypaleń , jak pisze Aleks - wygaszacze ekranu nadal istnieją,. G8 po paru min sam włącza swój wygaszacz, do tego kluczowa jest jasność ekranu (240 nit wypali nam wszystko ok, 6 razy szybciej, niż 100 nitów).

Co do monitorów w tym budżecie:

- do SDR i pracy buirowej/lekkiej grafiki i okazjonalnego grania kupiłbym EIZO FlexScan EV2785-BK, a jak się uprzeć na 21:9 to poszukać Fujitsu P34-9;

- do początków z foto itp. kupiłbym EIZO ColorEdge CS2731;

- do CADa oraz wielozadaniowości BenQ PD2725U;

- do hardego grania kupiłbym BenQ Zowie XL2566K;

- pod multimedia i HDR kupiłbym TV.

Wielkie dzięki za wyczerpujący i dla mnie bardzo przydatny wpis!

W moim przypadku użytkowanie monitora to mniej więcej:

- 45%: aplikacje biurowe i do obróbki grafiki czy zdjęć, przeglądanie Internetu;

- 10%: multimedia (filmy, seriale);

- 45%: granie.

Zdecydowałem się też na format 21:9 (zakrzywiony), bo używam takiego od 6 lat i jestem przeszczęśliwy. Idealnie nadaje się do moich potrzeb. ;)

Rozumiem, że w tym wypadku odradzałbyś jednak OLED (i tę matrycę Samsunga)?

W czasie Świąt będę szukał czegoś, co spełnia moje potrzeby, ale nie jestem ekspertem, więc wszelkie opinie przyjmę z ogromną wdzięcznością. Co polecałbyś zatem pod kątem mojego profilu użytkowania? To Fujitsu nie jest już raczej dostępne. Jest jakiś jego następca? Czy z monitorów, które są aktualnie w sprzedaży, testowałeś może coś z dobrym HDR?

Z taką ostateczną oceną Samsunga G8 jeszcze się wstrzymam, bo trochę muszę go jeszcze potestować, a teraz czasu mniej.

Patrząc na twoje użycie i że ma być 21:9, może by było ok. ale przez duże "M"

- 45%: aplikacje biurowe i do obróbki grafiki czy zdjęć, przeglądanie Internetu;

Kolorki ma ok pod sRGB. Na kalibracji wyszła mi prawie identyczna korekcja co Rtings, więc nawet można te dane wklepać dla 2-punktowego balansu bieli. Problem to ta lekka poświata za literkami (jak pisałem - dla mnie tolerancyjna przy czytaniu/pisaniu), ale to też ma znaczenie przy obróbce photo i tu już może być większa lipa (np. gdybyś korygował poświatę krawędziową na zdjęciu - a ta byłaby tą z monitora).

- 45%: granie.

Właśnie granie muszę jeszcze bardziej przetestować, w szczególności z HDR. Ogólnie, tu by się bardziej nadawał, bo VRR robi swoje. Z 21:9 może nawet najbardziej (i niekoniecznie ten Samsung, ale ta matryca). Problem w tym, że spokojnie większą płynność da się uzyskać - na dowolnym LCD ze strobingiem (ULMB/DyAC+ czy jak tam to dany producent nazywa). Bardziej profesjonalne monitory używające PVM z marszu (strobingu), też, o dziwo, nie będą tak daleko za tym OLEDem. Na zdjęciu po prawej masz porównanie z OLED 240hz (27GR95 - pierwszy od lewej), potem w LCD 360 hz bez włączonego stroba i na koniec z włączonym strobem. Źródło techspot / monitors unboxed YT.

Ale mniejsza, bo większość wystarczy płynność jaką oferuje G8, a za większą zaletę uznają b.dobry HDR.

Sporo też zależy od tego, przed czym teraz siedzisz. Taki OLED pewnie się sprawdzi lepiej, a jak się uprzeć i koniecznie zostać na 21:9, to pytanie o ile jakiś inny LCD byłby lepsze od tego, co masz.

Lista "niby" najlepszy ultrawide: https://www.rtings.com/monitor/reviews/best/by-features/ultrawide

I może ma to sens, bo akurat matryc monitorów 21:9 to nie ma aż tak dużo.

Zostaje kwestia ewentualnych wypaleń, jak masz go mieć na kolejne 6 lat.

Czy z monitorów, które są aktualnie w sprzedaży, testowałeś może coś z dobrym HDR?

Ten G8 jest najlepszym, jaki testowałem z HDR.

Wiem, że nie jest prosto z decyzją, ale też ten monitor (czy sama technologia) nie jest taki jednoznaczny i chyba lepiej być świadomym wad.

Są jeszcze 2 monitorki z mini-led w 21:9. Nie testowałem ich, ale może w tę stronę: Philips Evnia 34M2C7600MV (zakrzywione VA - recka na purepc i toms hardware). Jakaś alternatywa dla OLED (też bardziej w stronę gier i HDR, ale z gorszą czernią, wyższa jasnością - znaczenie tylko przy HDR; i bez ryzyka wypaleń). Tylko będzie ghostling...

Drugi jest płaski i na ips AOC AGON AG344UXM. Zgaduję, że byłby lepszy pod photo, nieco lepsza płynność, ale IPS, nawet na mini led, słabo z czernią w ciemnych pomieszczaniach (większe znaczenie przy multimediach, więc ciebie pomijalne).

EDIT - na Philips Evnia 34M2C7600MV spory ghostling wg https://www.youtube.com/watch?v=k1HqNusTW5A

Sporo też zależy od tego, przed czym teraz siedzisz.

Teraz siedzę na starym LG 34UC88-B. Widzę, że wciąż jest dostępny w sprzedaży:

https://www.x-kom.pl/p/297176-monitor-led-32-i-wiekszy-lg-34uc88-b-curved.html

Jeśli chodzi o potrzeby związane z pracą biurową, jest w porządku. Podobnie ma się sprawa z amatorską obróbką zdjęć. Rzecz jasna, do grania z nowym sprzętem już się nie nadaje.

Jak miałby się ten Samsung do posiadanej przeze mnie matrycy (m.in. gdy idzie o właśnie potrzeby biurowo-obróbkowe czy multimedialne)?

Teraz siedzę na starym LG 34UC88-B. Widzę, że wciąż jest dostępny w sprzedaży

Monitor masz ok.

Jak chcesz coś pod HDR, to OLED chyba jednak najlepszy.

Jedyna alternatywa, by mieć monitor pod to i to, to płaski AOC Agon Pro AG344UXM - https://tftcentral.co.uk/reviews/aoc-agon-pro-ag344uxm i przy braku multimediów ips nadal ma sens. Tylko ten monitor ma fatalną najniższa jasność - 152 nity. To nawet w dzień, taki jak dziś (pochmurny), zdecydowanie za jasno...

Jak chcesz coś pod HDR, to OLED chyba jednak najlepszy.

A nada się też do komfortowej pracy biurowej? Pisałeś o problemie z wyglądem fontów. Będą się prezentować gorzej (mniej wyraźnie) niż na moim dotychczasowym monitorze?

A nada się też do komfortowej pracy biurowej? Pisałeś o problemie z wyglądem fontów. Będą się prezentować gorzej (mniej wyraźnie) niż na moim dotychczasowym monitorze?

Moim zdaniem tak - ja nie ma z tym dużego problemu teraz odpisuje z niego i jest dobrze. Moim zdaniem na woled jest nieco gorzej, a zwracałem na to uwagę, bo każda recenzja zwraca; i moim zdaniem ten problem jest zbyt uwypuklony. Lekko mniej wyraźnie w porównaniu do ips Eizo jest (nie da się ukryć), ale dramatu nie ma.

Z innej beczki, pograłem trochę w gry, przede wszystkim z HDR i pierwsze wrażenia bez szału. Spider-man albo jest mocno przyciemniony i zachowuje detale w pełnym zakresie, albo jest jasna jak trzeba w HDR (ustawienie bez HDR game w G8), ale gubi detale w highlightach (ustawienie z HDR game w G8) - a ustawiłem mu punkt maksymalnej luminacji oraz białej karty wg pomiarów, więc albo twórcy kręcą dla ogółu (tych co nie mierzą i chcą efektu wow - bez detali, ale jasności), albo coś jest nie tak.

W RE2 remake jest ok, ale ta gra jest taka se pod HDR.

Pobieram Metro Exodus EE - jak do tej pory najlepszy HDR w grach jakie testowałem i tam zobaczę.

Co do płynności w grach, to jest lepiej niż w filmach, gdzie jest to dziwne wrażenie błyskawicznego wznowienie ruchu (rozmycie na LCD wygląda bardziej naturalnie, niż błyskawiczna zmiana na OLED, wynikając z respons time i tego, że to sample and hold). Tu też robotę robi VRR i to, że w grach możemy dodać rozmycie ruchu.

Jak na razie najlepszy HDR jaki widziałem na G8 był a apce amazonu z HDR10+. Gry z HDR10+ dopiero nadchodzą (The First Descendant i inne produkowane na UE 5.2+), ale to też tak, że HDR10+ jest wyłącznie na G8 z monitorów na tej matrycy.

Dam znać, jak w Metro i Chernobylite (btw, w RDR2 było dziwnie z HDR).

Swoją drogą, na Samsungu to z jednej strony dobrze, że można tyle pozmieniać, z drugiej sami co aktualizacje mieszają i zmieniają działanie funkcji.

Kurcze, uwaga o mniej wyraźnych fontach mnie nieco przestraszyła. Przeglądam więc od wczoraj Sieć w poszukiwaniu dobrego monitora na zakrzywionej matrycy IPS o proporcjach 21:9 (do zróżnicowanego użytku) i... nawet po zwiększeniu budżetu do 5 tysięcy nic dostępnego w sklepach nie znajduję. :( Mam wrażenie, że wszyscy się przerzucili na OLED.

W 21:9 jakieś kompromisy będą. Najlepiej, jakbyś sam zobaczył, czy te fonty w QD OLED ci przeszkadzają. HDR na PC to dalej zamieszanie, chociaż jest lepiej.

Jak budżet poszedł trochę w górę, może trzeba zrezygnować z 21:9 (bo tu raczej twórcy uznali, ze to format adresowany pod rozrywkę - gry, multimedia, HDR) i np. iść w benq PD3220U lub bardziej pod HDR Asus ProArt PA32UCR-K.

Na nich obróbka spoko, wszystko spoko; i na Asusie na HDR da radę, tylko 60hz, 4k.

Najlepiej, jakbyś sam zobaczył, czy te fonty w QD OLED ci przeszkadzają.

Gdyby nie były "gorsze" niż na moim starym IPS, brałbym pewnie OLED, bo jednak z tego formatu 21:9 nie chcę zrezygnować (i potrzebuję więcej niż 60 Hz). Najbardziej odpowiada moim potrzebom. Nie mam za bardzo jak sprawdzić, czy fonty wyglądają OK (np. w sklepie). Musiałbym pewnie zamówić. :( O obróbkę zdjęć czy grafik się nie martwię (bo robię to zazwyczaj na swoje potrzeby "wydrukowe", a rzadziej dla innych). Odwzorowanie kolorów powinno być zresztą dobre. Zależy mi jednak na w miarę wygodnym czytaniu stron internetowych czy plików tekstowych. Jeśli jednak korzystasz z tego panelu i nie odczuwasz jakiegoś dyskomfortu, np. czytając ten wątek, to może nie jest źle. ;)

Szkoda, że w sklepach nie sposób znaleźć czegoś sensownego w tym formacie (z zakrzywieniem) na IPS. Widzę, ze starego dobre modele zostały zastąpione nowymi, ale już z matrycą OLED.

btw, w RDR2 było dziwnie z HDR

Z tego, co piszesz, wynika chyba, że nie warto szukać monitora z HDR na tej matrycy, bo ta technologia jakoś pozytywnie na obraz nie wplywa. :(

Gdyby nie były "gorsze" niż na moim starym IPS, brałbym pewnie OLED

Szybkie porównanie (nie wiem, czy będzie jakkolwiek przydatne, bo wyświetlane na innym monitorze, ale może...), nie patrz na efekt tęczowy/mory na środku - norma przy robieniu zdjęć ekranom oled. Zdjęcia robione z tej samej odległości:

- tekst word skala 120%, font 11, https://i.ibb.co/TTtqhqY/DSCF6864-JPEG.jpg

Bardzo podobnie do tekstu na forum - nie widać tych zielonych (od dołu) lub fioletowych (od góry) przekłamań. Może zielone są delikatnie widoczne.

- tekst word, skala 80%, font 11, https://i.ibb.co/6RqhKSN/DSCF6865-JPEG.jpg

Zielone przekłamanie bardziej widoczne od dołu.

Przybliżenie na piksele https://i.ibb.co/FVr0M2z/DSCF6865-JPEG-1.jpg

Na normalnych czcionkach nie przeszkadza, na małych może.

Możesz to odnieść do tego, co pokazują w reckach.

Z tego, co piszesz, wynika chyba, że nie warto szukać monitora z HDR na tej matrycy, bo ta technologia jakoś pozytywnie na obraz nie wplywa. :(

Co do HDR, to odpaliłem Metro EE i jest bardzo, bardzo dobrze, ale to już testowałem i wiedziałem, że tak będzie. Ogólnie dużo zależy od gier. Ważne też odpowiednie ustawienie monitora. HDR10 na Windows używa Rec 2100 (koordynaty kolorystyczne z Rec 2020), czyli inaczej niż filmy w apkach itd., gdzie większość to DCI P3. Do tego sporo gier ma ten hdr średnio zrobiony (z kolorystycznego oraz gradientowego punktu widzenia). Robią obraz przejaskrawiony i tyle.

Metro Exodus EE ma najlepszy HDR w grach jaki widziałem. RDR 2 robi się lekko pastelowe. Spider Man ma kłopot z maks jasnością, ale da się dostosować, tylko trzeba się pobawić (poświecić czas, potestować, bo wyprowadzenie wyników pomiarów nie daje odpowiedniej jasności). Residen Evil 2 też robi się lekko pastelowy, ale daje radę z jasnościami i zachowaniem detali (ma dobrą kalibrację HDR w grze).

Ogólnie czekam na HDR10+ gaiming, bo to powinno wyeliminować większość bolączek HDR na PC, stąd wybór G8, ale inne pytanie, jest takie, jak to będzie popularny format.

HDR10+ na tv miał ciężkie początki i wszyscy mówili o DolbyVision, ale dziś jest już w miarę dobrze (prime video, rakuten, appleTV, hulu, paramont).

O, dzięki za te zdjęcia! Jestem teraz przez kilka dni poza domem (Święta u rodziny), więc mam dostęp tylko do ekranu komórki. Trudno mi zatem stwierdzić, co i jak. Ale gdy tylko wrócę, natychmiast sprawdzę, jak to wygląda na monitorze. Na ekranie komórki fronty ze zdjęć wydają się nieco "rozmyte". :(

Co do HDR: w takim razie to pewnie nie kwestia panelu, tylko implementacji technologii w grach. Warto więc chyba w HDR zainwestować nawet "na zaś". OLED-a zatem całkiem nie wykluczam.

A dobre HDR na IPS-ach występuje i ma sens?

Żeby jak najbardziej zniwelować wpływ aparatu - masz porównanie z EIZO spva.

W tym gorszym scenariuszu

- tekst word, skala 80%, font 11, https://i.ibb.co/Z8YBgtv/DSCF6868-JPEG.jpg

Przybliżenie na piksele

https://i.ibb.co/wyhsLVH/DSCF6868-JPEG-1.jpg

W rzeczywistości pełna czystość tekstu

A dobre HDR na IPS-ach występuje i ma sens?

Tak, choćby ten Asus ProArt PA32UCR-K, którego polecałem (60hz i 4k), ale w 21:9 to ciężko.

Jest wspominany już AOC Agon Pro AG344UXM, ale on ma bardzo wysoką minimalna jasność.

Był jeszcze ASUS ProArt PA348CGV, ale HDR ma tylko w nazwie... HDR 400, więc tak mocno średnio. Byłby to upgrade względem twojego (120hz, nieco lepsze kolory, obsługa HDR, ale tylko 400, więc bez szans na prawdziwe wow), ale bez szału.

Z bardziej gamingowych będą monitory raczej na VA

21:9

Lenovo Y34wz-30

Philips Evnia 34M2C7600MV/00 (już wspominany - mocne smużenie)

AOC AG353UCG

MSI PAG344CQR

Tylko to VA, więc trzeba posprawdzać dokładnie smużenie.

Potem z campingowych zostają 16:9

ROG Swift PG43UQ (tylko tu kontrast jak na ips, czyli to co masz, ale na tyle duży, że tak ja pisał Alex, zrobisz sobie na nim 21:9 też);

Asus ROG Swift PG32UQXR (tu już lepszy kontrast, ale cena rośnie ostro)

W tym wypadku już bardziej rozważyłbym "wypożyczenie" Samsung G8 lub Della DWF (ew. MSI), by samemu zobaczyć i zdecydować.

Szybkie pytanko: jakbym chciał dokupić taśm na rzep, to takie zwykłe (jak poniżej) można też wykorzystywać do spinania kabli w środku obudowy? Są odporne na temperaturę? Czy może gdzieś znajdę coś specjalnego na tego typu "okazję". ;)

https://www.morele.net/organizer-wolfcraft-tasma-na-rzep-do-organizacji-czarna-wf3286000-8363777/

Można. Nie dostałeś do zasilacza i budy w komplecie? Ja miałem po kilka z logo seasonica i endorfy.

Na dodatkowe potrzeby kupiłem rolkę ugreena.

https://allegro.pl/listing?string=ugreen%20opaska

Coś tam było. Ale, jak napisałem, chciałbym dokupić więcej i może jeszcze się pobawić z kablami po powrocie z wyjazdu świątecznego.

Dzięki za polecajkę! :)

A nie trytytki?

Jaka jest legitna wersja?

Bukary, liczę na twoją ekspercką wiedzę.

Bukary - pamiętaj tylko że format 21:9 czy 32:9 uzyskasz na dowolnym monitorze/TV. Nie musi być on dedykowany. Możesz spokojnie kupić np. C3 42" i używać go jako 21:9 czy 32:9 np. w grach, filmach itd. a do pracy w 16:9.

w większości nowych TV nawet nie musisz ustawiać tego w windowsie tylko wybierasz w ustawieniach TV wtedy obraz się zmienia pojawiają się pasy góra i dół ale że to duży TV i oled to są to elementy wygaszone.

a jeżeli tak nie chcesz to wybór jest tylko jeden

tutaj masz też polską recenzje

https://www.youtube.com/watch?v=YCZnAMst4Mk

Polecam obejrzeć bo akurat prowadzący z Morele robi bardzo profesjonalne testy.

Aleks, dzięki za ciekawy wpis, ale ten Samsung jest, niestety, za duży, za drogi i za szeroki.

Doprecyzuję, bo może ktoś jeszcze wrzuci jakąś polecajkę. Interesuje mnie wyłącznie monitor (nie TV):

- o proporcjach 21:9;

- do zróżnicowanego użytku, a nie tylko do gier;

- może być na matrycy IPS (jeżeli OLED się nie sprawdzi w pracy biurowej);

- HDR byłby cudowny (ale monitor powinien mieć możliwość ustawienia niskiej jasności do pracy);

- mieszczący się w budżecie maks 5500 zł (choć wolałbym przedział 4-5 tys.).

Niestety, nie mogę znaleźć nic sensownego. :( Chyba najważniejsi gracze przerzucili się na OLED. I to w formie, która nadaje się wyłącznie do grania.

https://www.x-kom.pl/p/1165828-monitor-led-32-i-wiekszy-lg-ultragear-32gr93u-b.html#Specyfikacja

Odważę się polecić.

W tej chwili masz jeszcze promkę.

Wiem, że chcesz zakrzywiony ale... ;)

Aj... Kapusty się wczoraj nawąchałem. Nie ten format.

Fajny, ale nie takiego szukam. :)

Jestem już tak zdesperowany, że nawet przeglądam recenzje tego starszego modelu:

https://www.morele.net/monitor-lg-ultragear-34gn850p-b-12739604/

Słabo jest teraz z tym formatem 21:9 na IPS-ach.

Tutaj też porównanie monitorów, które testuje Raiden:

Potwierdza się chyba to, co Raiden pisze. Poza tym te OLED-y niezbyt się nadają do pracy. Do zróżnicowanego użytku trzeba pewnie szukać IPS. Szkoda tylko, że na nic sensownego na razie nie trafiłem.

Na pewno jest jednak jakiś dobry ultrapanoramiczny IPS do grania i do pracy. Święty Graal poszukiwany!

co byś nie wybrał za nim kupisz napisz co wybrałeś i nie kupuj niczego bez VESA HDR600 a najlepiej 1000. Taka karta jaką masz i taki komputer jaki masz i bez HDR dzisiaj to byłoby nie tylko smutne co nieuczciwe wobec samego siebie. Jeśli nie miałeś okazji zobaczyć co robi HDR w praktyce to będziesz oczarowany kolorystyką i punktami jasności. Ja pierwszy raz kiedy zobaczyłem wtedy jeszcze słaby HDR bo w okolicach 600 nitów pierwszy raz zobaczyłem kolor złoty w grze. W SDR nie wyświetlisz tej bary zresztą jak wielu innych które muszą mieć odpowiedni gradient i jasność. Kieruj się głownie tym wyborem HDR potem odświeżanie, potem dodatkowe funkcje jak VRR, G-sync, Freesync itd.

co byś nie wybrał za nim kupisz napisz co wybrałeś

Tak zrobię.

No właśnie u mnie jest ten problem, że sprzęt nabyłem w miarę dobry, więc przydałby się porządny monitor z HDR. Niestety, OLED-y niezbyt się nadają do pracy, a ta sfera aktywności to będzie pewnie połowa czasu działania monitora. No mogę sobie też pozwolić na dwa monitory (ze względów finansowych i ze względu na przestrzeń, w której pracuję). Itd.

Z OLED-ów na moją kieszeń zostaje powyższa czwórka opisywana przez Raidena i zrecenzowana w filmiku, który wkleiłem. Niestety, wszędzie słyszę, że to nie są monitory do pracy (poświata wokół fontów + problem wypalania statycznych elementów ekranu). Raiden sugeruje chyba ponadto, że HDR na tym panelu nie jest szczególnie dobry.

Szukam więc obecnie dobrego, zakrzywionego IPS 21:9 (w cenie do ok. 5 tys.). Ale to chyba rzeczywiście święty Graal na rynku, bo nic nie znalazłem. Albo źle szukam.

Moze w przypadku monitorów też już się sprawdza powiedzenie: "Jak coś jest do wszystkiego, to jest do niczego"? ;)

Teraz "obczajam" następujący model:

https://www.x-kom.pl/p/1133520-monitor-led-32-i-wiekszy-lg-34gn850p-b.html

Zostań z tym co masz.

Ironizujesz? Przecież nie będę grał w 60 FPS (60 Hz), skoro kupiłem 4080. Aleks miał rację: pewien lag jest nawet w tym wypadku wyczuwalny. :)

A to jakaś ujma? Ja nie mam problemu grać w 30 na Ps5 a potem na pc w większej ilości.

Serio to marnowanie kasy na ips jak za niewiele więcej masz oleda.

Przebolejesz te czcionki bo cała reszta będzie wow.

Weź sobie coś na testy 14 dni.

A to jakaś ujma?

E, nie. Przecież sam do tej pory grałem na starym sprzęcie. Nie jestem pod tym względem "klasistą".

Chodzi o to, że skoro wydałem kasę, to chciałbym zobaczyć zmianę. Na lepsze. Przynajmniej gdy idzie o granie. A jeśli chodzi o pracę - nie chciałbym zobaczyć zmiany na gorsze. ;)

Tylko nie IPS do zróżnicowanego użytku! IPS to praca biurowa plus grafika (bez filtrów na czerń z Eizo to chyba też tylko amatorsko albo w świetnie oświetlonym pomieszczeniu)...

W ogóle co się potwierdza? Ten problem z frontami? Składasz do druku jakieś materiały z mikroprintem?

BTW - Pewnie Raiden ma sporą wiedzę, ale jak widzę elaborat na temat gorszego niż na IPS/VA postrzegania ruchu, bo tam jest ładne rozmycie, a na OLED z super czasem reakcji jest zbyt gwałtowne (!) sample plus hold, i jeszcze to skupienie na strobo (że to niby fajne na tych TN 240 Hz?) to zapala mi się wielka czerwona lampka. :)

Nie wiem czy sa jakieś IPS-y na miniled, a w każdym razie z dobrym wygaszaniem... Jeszcze ten niezrozumiały fetysz giętego (!) ultrawide... ;) Poświata ma rujnować pracę, a wygięte zdjęcia ci jej nie rujnują? Jak ty tam sprawdzasz geometrię? :)

Wybór monitora pod własne potrzeby to masakra (Wiesz jak mało jest dobrych płaskich VA 32"? Praktycznie już nie ma, a OLED-ów mało, plus niby ryzyko wypalenia..), ale ty będziesz miał szczególnie ciężko. To nie jest robota na jeden wieczór :P

Ja bym patrzył na czerń, odwzorowanie barw plus czas reakcji, ale nie tak ortodoksyjny, że CRT a potem nic. HDR traktowałbym jako miły dodatek. Nie wiem jak można się do tego brandzlować - mozolne ustawienia, połowa gier pod win działa źle, bo inny standard, bo nie taki monitor, bo nie taki tryb, bo nie taki punkt bieli, bo nie ta faza księżyca... Ale w akcji widziałem ledwie kilka razy... i OK, pewne szczegóły były OK, ale strasznie męczyło to wzrok... Niemiej, może się mylę. Ale widzę dyskusje o tym i ciągle problemy.

W ogóle co się potwierdza? Może i Raiden ma sporą wiedzę ale jak widzę elaborat na temat gorszego niż na IPS/VA postrzegania ruchu bo tam jest ładne rozmycie, a na OLED z super cssem reakcji jest zbyt gwałtowne sample plus hold. i jeszcze to skupienie na strobo (że to niby fajne na tych TN 240 Hz?) to zapala mi się wielka czerwona lampka. Ogromniasta :)

Przecież mam przed sobą te ekrany i CRT, i IPS oraz OLED. Widzę co jak powstaje, w testach ufo można przestawać wszystko i widać, co jest czym. Point sample (czyli stroboskop CRT lub oszukane Point sample ze stroba LCD) zawsze będzie miało przewagę nad sample nad hold w odwzorowaniu ruchu. Nie bez powodu w radarach wojskowych systemów jest to wymóg agencyjny. Ale nie odklejając się. Opisałem to o widzę i napisałem też, że na testowanych OLED Panas i Sony było lepiej.

Ogólnie pomiary rtings, monitors unboxed itd. są bardzo fajnie i pokazują potencjał technologii, lecz wlepianie przy każdym 0,1ms 10 i nadawanie dużej wagi w ocenie końcowej, to trochę marketing.

Tu najbardziej profesjonalne podejście do odwzorowania ruchu https://learn.microsoft.com/en-us/previous-versions/windows/hardware/design/dn642112(v=vs.85)?redirectedfrom=MSDN

Tylko nie IPS do zróżnicowanego użytku!

Hmm... Co w takim razie?

Skoro HDR to tylko fajny dodatek, a OLED może być problematyczny, gdy na ekranie ciągle PS lub Lightroom, to co zostaje? VA?

Pytam serio, a nie złośliwie. Naprawdę potrzebuję pomocy. :)

Jak pisałem, mój IPS jest całkiem, całkiem do pracy. Ale do grania już - nie.

Bukary - Her Pietrus ma zwyczaj wypowiadać się na tematy o których nie ma żadnego pojęcia. HDR to standard taki jak 4k czy 1080p. 99% gier go obsługuje a jak się nawet zdarzy że jakaś nie to za moment dostajesz autoHDR z W11 i sterownika Nvidii. Granie w gry bez HDR to jak granie 35 lat temu na monitorze monochromatycznym. HDR mają takie gry jak Rogue Trader która wygląda w HDR super. To jest przykład bo gry AAA to mają zawsze. To jest taka przepaść że nie da się tego opisać. Oczywiście wymóg to min 600 nitów na oledzie i ok. 1000 na LCD. Her Pietrus pewnie widział fakeHDR na jakimś low endzie gdzie nawet go nie było.

No właśnie wiem, że HDR mocno zachwalasz, Aleks. Raiden jest nieco sceptyczny. A z kolei Herr Pietrus ostro dissuje.

I jestem trochę skonfundowany. ;)

A jak to się ma w ogóle do komfortu oczu, kiedy siedzimy w miarę blisko przy monitorze? Wzrok się HDR-em nie męczy?

Ostro dissuje? Bez przesady, zresztą chyba nie muszę się tłumaczyć z urojeń i zarzutów kogoś takiego jak kleks. :D

W co bym celował sam? W dobre VA albo mimo wszystko w OLED, nawet ryzykując wypalenia, bo przy pracy z niską jasnością one nie powinny się pojawić szybko. W OLED będziesz miał HDR tak czy inaczej w VA na mini led pewnie też.

Ja po prostu, inaczej niż Alex, nie stawiałbym go na pierwszym miejscu.

Jak widzisz nie doradzam ci żadnego modelu.

Co sugeruje? Mocno zastanowić się nad potrzebami, poczytać dużo recenzji i dyskusji, zrozumieć, jakie są POTENCJALNE problemy i pomyśleć o tym, które są REALNE dla ciebie, bo ty może chcesz mieć czerń plus kolory, a ktoś inny ruch jak na wojskowym radarze czy CRT sprzed 30 lat.

Możliwe, że będziesz musiał iść na kompromis. Pewnie w OLED jest ich najmniej, za co płacisz ryzykiem...

Jeszcze jedno - nie możesz poczekać do przyszłego roku? Ponoć w segmencie OLED ma być sporo nowości.

Jeszcze jedno - nie możesz poczekać do przyszłego roku? Ponoć w segmencie OLED ma być sporo nowości.

Nie za bardzo. Chcę coś kupić najpóźniej w styczniu.

Poszukam więc jeszcze czegoś na VA i ponownie poczytam recenzje OLED-ów. Wszędzie jednak słyszę i czytam głosy, że do pracy z programami i pracy biurowej średnio się nadają.

Swoje potrzeby już opisałem. Gdy idzie o pracę, wystarczy mi coś na poziomie IPS, który mam. Ale nie chciałbym pogorszenia jakości obrazu (np. fontów). Gdy idzie o gry, wolałbym coś lepszego.

:)

Taaa, czekac na nowosci. W ten sposob to nigdy nic nie kupisz bo za chwile cos nowszego bedzie na rynku.

A tak poza tym, to zadnych nowinek technologicznych na 2024 nikt nie przewiduje. W segmencie OLEd bedzie dalsze ulepszanie MLA od LG i poprawa QD-OLED Samsunga. Poza kosmetycznymi zmianami nie oczekiwalbym zadnych przelomow w 2024.

Ci co umią ustawić zachwalają hdr a Ci co nie to nie. Ot cała tajemnica.

W tym akurat Alex ma racje. To robi lepszą robotę niż to całe rt gdzie różnic z lupą trzeba szukać.

Doskonale rozumiem chcicę, ale może warto zacisnąć zęby i przeczekać, żeby potem sobie podziękować?

Tak czy inaczej - po prostu dobrze się zastanów :)

Drackula - nie chodzi mi o rewolucję, a o większy wybór, być może nieco dojrzalszych modeli.

Wiem, co znaczy brak zdecydowania co do sprzętu i trudne wybory. Wtedy najlepiej podejść na chłodno, choć oczywiście nie ma co pół roku deliberować :)

Bukary nie jest z tych, co mówią, że jakby co, to za dwa lata kupią co innego albo nawet wcześniej opchną ekran na OLX, więc presja większa :)

HDR to standard taki jak 4k czy 1080p. 99% gier go obsługuje a jak się nawet zdarzy że jakaś nie to

Pytanie jak go obsługują, bo by nie szukać daleko na to Windzie jednak są problemy HDR. Wspominany przeze mnie Spider-man, ogólnie znane problemy z Destiny 2 (swoją drogą na Xbox Series X, po podpięciu do G8, obie gry działają poprawnie z HDR, a na Windows nie). Nie piszę tego, by hejtować technologię, która jest dobra i powinna być standardem. Piszę, bardziej, by uświadomić

za moment dostajesz autoHDR z W11 i sterownika Nvidii.

Auto hdr mod w sumie już jest i jest ok, jak się dostosuje i pobawi nim zależnie od gry - Special K HDR Retrofit

Auto HDR na Xbox działa całkiem, całkiem.

Oczywiście wymóg to min 600 nitów na oledzie i ok. 1000 na LCD. Her Pietrus pewnie widział fakeHDR na jakimś low endzie gdzie nawet go nie było.

Optymalne byłoby 1000 nitów pełnoekranowe. W końcu HDR10 na Windows to Rec. 2100 (koordynaty Rec. 2020), 1000 nitów. To osiągają jedynie monitory profesjonalne (jak Dual layer na matrycach panasa - Sony i Eizo) i może ze 2 mini-ledy. Na swoim G8 w bardzo jasnych scenach wiem, że nie uda się oddać wszystkiego (będzie albo kompresja - czyli wypłowienie; albo hard clip, czyli utrata detali powyżej maksymalnej jasności wyświetlacza w danej scenie - czyli np. oprócz słońca połowa nieba stanie się biała i nie będzie widać chmur, tylko biel).

Mimo wszystko kierowałbym się mniej więcej wytycznymi od Alexa

Kieruj się głownie tym wyborem HDR potem odświeżanie, potem dodatkowe funkcje jak VRR, G-sync, Freesync itd.

W innym wypadku zmiana wyświetlacza, ma mniejszy sens (raz, że użyteczność; dwa, że koszt).

Czyli OLED jednak wraca do gry. ;)

Wkrótce sobie zrobię listę monitorów do rozważenia i poproszę w takim razie o konkretną polecajkę. Zaciekawiliście mnie też z tym Win 10 i 11 oraz efektem HDR. Nie wiem, czy dobrze zrozumiałem: Win 11 jest pod tym względem lepsze? Tylko na tym systemie jest (lub pojawi się) Auto HDR?

Pomijając graczy konsolowych to czemu ekran o przekątnej większej niż 27 cali jest nazywany jako "monitor dla gracza" przecież wtedy nie da się grać w żadną grę wieloosobową chyba, że jako bot i mięso armatnie dla innych?

Bukary jakbym dziś kupował monitor to mój wybór pada na Dell Alienware AW3423DW

Bardzo fajny. I mnie się podoba. Również go rozważam.

Problemy: jest podobno głośny (najgłośniejszy z monitorów na tym panelu Samsunga). No i to OLED, więc długa praca z aplikacjami może skutkować wypaleniem ekranu w miejscu stałych elementów interfejsu.

Lepszy jest podobno Samsung z tym samym panelem.

Jeszcze jest jeden problem z tymi panelami OLED. Nie mają matowej powłoki. Nie wiem, czy to bardzo przeszkadza.

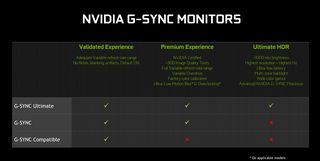

Czy lepszy to nie wiem. Warto sprawdzić czy Samsungi maja natywny g- sync. Oglądałem jakiś model Odyssey i nie miał. Samsung maja lepsze wsparcie dla konsol ale chyba to nie jest coś wartego uwagi w twoim przypadku.

No właśnie monitory mają mat a tv to lustra.

W recenzji, którą wkleiłem, wyraźnie stwierdzono, że na tym panelu OLED ( w 4 monitorach) nie ma powłoki matowej, co negatywnie wpływa na jakość obrazu w jasnym pomieszczeniu. Ale sprawdzę jeszcze, czy to prawda w jakiejś specyfikacji.

Czy lepszy to nie wiem. Warto sprawdzić czy Samsungi maja natywny g- sync. Oglądałem jakiś model Odyssey i nie miał. Samsung maja lepsze wsparcie dla konsol ale chyba to nie jest coś wartego uwagi w twoim przypadku.

G-sync w 2023 działa trochę inaczej. W zasadzie każdy wyświetlacz VRR jest g-sync compatible (nie potrzebuje do tego chipu Nvidii, bo ma ten od VRR na płycie).

Tu wszystkie stopnie aktualnego g-sync https://www.nvidia.com/en-us/geforce/news/gfecnt/g-sync-ces-2019-announcements/

Obrazek po prawej

Wyższe standardy to tak naprawdę tylko certyfikat Nvidii, że jest HDR1000 i konieczność użycia ich procesora g-sync, który wymaga chłodzenia (przez to Dell AW3423DW hałasuje). Czy jest w jakimś aspekcie lepszy od tych chipów, które dziś montuje się prawie wszędzie do VRR? Kij wie.

Czyli dobrze rozumiem, że moja karta Nvidii bez problemu korzystałaby z synchronizacji nie tylko na DW, ale też na DWF (który ma FreeSync, a nie G-Sync)?

Tak, bez problemów. Ja korzystam z g-sync na G8, który też nie ma modułu NV.

Ważne jest poprawne ustawienie (niezależnie od modułu i wlepki NV):

https://blurbusters.com/gsync/gsync101-input-lag-tests-and-settings/14/

Fajna recka. Potwierdza i plusy, i minusy tego panelu.

Minusy to:

- prawdopodobieństwo wypalenia;

- brak powłoki, która "chroniłaby" czerń w oświetlonym pomieszczeniu;

- mniej ostre fonty.

technologia tak gna do przodu że na 5 lat Ci wystarczy a za 5 lat to będziesz po pierwsze zarabiał o wiele, wiele więcej, po drugie ceny sprzętu znowu spadną itd. Jeśli chodzi o fonty to nie demonizowałbym tego ponieważ jest to oparte na pixel / w układzie trójkąta. Moim zdaniem nie ma żadnej szansy abyś stwierdził że jest nieostro lub nie tak jak powinno przy takiej plamce i pełnym chroma. Co więcej będziesz w szoku jak go podłączysz względem tego co masz (jakbyś z poloneza wsiadł w ferrari). Pozostaje też jeszcze jedna kwestia że masz 14 dni na zwrot bez podania przyczyn jedyny twój koszt to odesłanie kurierem o ile taki podejmiesz ruch w kwocie 100 PLN dodatkowo ubezpieczone i zabezpieczone.

Może faktycznie poczekać na na jakieś 21:9 w QD-oled gen 2, gdzie czcionki będą nieco czytelniejsze?

https://www.youtube.com/watch?v=puwJBwR-Guw

Co do samego dbania o Oled, to warto w Windzie:

- schować pasek zadań (automatyczne ukrywanie);

- ustawić wygaszacz ekranu na np. "ukryj swe myśli".

Z takich rad użytkowych G8:

- denerwuje mnie brak automatyzacji przy HDR w Windows. skrót "win+alt+b", ale muszę jeszcze za każdym razem wyłączyć/zmienić profil kolorystyczny, a następnie w ustawieniach monitora przestrzeń kolorów z auto (konieczna do uzyskania sRGB) na rec 2020/native;

Aż tyle kombinowania na monitorze?

Na tv odpalam hdr w Windzie i tyle. Czasem nawet nie bo gra sama to robi.

jedynego oleda jakiego zajeździłem to CX i S95B i to na zasadzie w windowsie zawsze włączony HDR + zostawianie po 5-10 godzin włączony TV bez wygaszacza aż sam się włączał automatycznie po paru godzinach. CX padł w takim trybie po ok. roku a S95B po 4 miesiącach ale co znaczy padł ? Pojawiły się lekkie powidoki głownie widoczne zgodnie z kolorystyką i to takie że bez testu tła bym ich nie zobaczył. Właściwie zobaczyłem przez przypadek. Oledów mam w domu całą masę i żaden nie dostał powidoku przy normalnym użytkowaniu. Moim zdaniem aby utrwaliły się ikony z windowsa a tym bardziej pasek (nigdy się nie utrwalił) to musiałbyś zostawiać TV na wiele godzin bezczynnie x wielokrotność tego (pewnie z 3000 godzin jaki nic w takim czymś) a większość osób pracuje po 2-3 godziny i robi coś innego, ma wygaszacze, itd. W takim przypadku mogę śmiało stwierdzić że przez 3-5 lat żadnego powidoku nikt nie zobaczy.

CX zostawiłem na sam koniec na próbę wytrzymałości z bardzo jaskrawą tapetą z mass effect z ogniami wbitymi na min. 500 nitów i tak po 24 godzinach zero miejsc wypalenia. Więc moim zdaniem ten test udowadnia że aby zajeździć oleda to trzeba chcieć i to bardzo. TV poszedł do znajomego który do dzisiaj ogląda na nim filmy i TV i twierdzi że powidoków nie widział a jak mu pokazałem że są to się zaśmiał z tego.

Czemu G8 jest tutaj tańszy o niemal 2 tys. zł niż na x-komie?

Sklep wygląda na legitny (współpracuje z nim morele).

Nie wiem czy legitny, to, że sprzedają na Morelkach nic nie znaczy...

Inna sprawa, że Morele mają za tyle samo obecnie, a Vobis za niewiele więcej. :)

Google pokazuje przy stronie Samsunga 4,5k, na samej stronie już normalne 6k, ale może była jakaś ogólna duża promocja i idzie przez różne sklepy?...

A może to wszystko ze zwrotów, he he :P

Ja, pomimo opinii o morelkach, brałbym jednak tam albo w Vobisie.

Choc niby na wszystko jest teraz zwrot, gwarancję i tak Samsung ogarnia...

No dobra. :) Oto lista monitorów, których zakup rozważam:

OLED:

Dell Alienware AW3423DWF

Samsung Odyssey G8

IPS:

Asus ROG Strix XG349C

BenQ Mobiuz EX3415R

LG UltraGear 34GN850P-B

VA:

Lenovo Y34WZ-30

AOC AG353UCG

MSI PAG344CQR

Co, waszym zdaniem, od razu wyeliminować z tej listy że względu na jakieś wady czy braki? Co zostawić? Może ktoś miał do czynienia z tymi monitorami (poza Raidenem)?

wszystkie z IPS -> HDR na nich nie istnieje poza znaczkiem

Lenovo Y34WZ-30 - całkiem niezły (jeden z najlepszych tutaj wymienionych)

AOC AG353UCG - matryca fejkowa 8bit+fr

MSI PAG344CQR - słabe pokrycie, hdr to tylko napis

Dell Alienware AW3423DWF - świetny, kolorystyka, pokrycie, właściwie wszystko

Samsung Odyssey G8 - to samo jak wyżej bo ta sama matryca tylko inna elektronika Alienware ma wszystko minimalnie lepsze ale jednak

Najlepszy z tego to Alienware bezdyskusyjnie, potem Odyssey a potem Lenovo. Alienware ma nawet o 100 nitów więcej + jeszcze lepsze korycie dla kolorystyki oraz jest lepiej skalibrowany po wyjęciu z pudełka.

Dzięki za opinię, Aleks!

Zrezygnowałem z DW i zastąpiłem go DWF, bo ten pierwszy jest podobno głośny i nie ma możliwości aktualizacji oprogramowania. Tracę chyba tylko G-Sync, choć DWF i tak współpracuje z kartami Nvidii, gdy idzie o synchronizację. A do tego jest znacznie tańszy.

A dlaczego nie masz tu https://www.philips.pl/c-p/34M2C8600_00/evnia-curved-gaming-monitor-monitor-do-gier-qd-oled ?

Najnowszy z zestawienia Alieni Samsung

Dell Alienware zakupiony. Jak dojdzie, dam znać, co o nim myślę. ;)

Raz jeszcze dziękuję wszystkim za pomoc!

zobaczenie pierwszy raz HDR 1000 nitów na qdoledzie to będzie jak wspomnienie pierwszego razu :) będziesz chciał więcej i więcej. Każda stara gra będzie jak nowa. Zazdroszczę bo wszystko przed tobą :)

Sam się nad nim zastanawiam, ale trochę się obawiam nietypowego rozkładu subpixeli, co ponoć niektórym przeszkadza w czytaniu tekstu. Także czekam na Twoje odczucia.

BTW Gdzie kupiłeś?

Wziąłem w Morele. Mieli super cenę, a do tego jeszcze promocję (-100 zł). Taniej w sensownym sklepie nie było.

Sam się boję o te fonty. Wkrótce się okaże, czy słusznie.

Nie tak dawno sam skompletowałem komputer, który pozwala mi na granie w każdą grę w 2k i wszystko na ultra. W 4k też ale już nie dam radę zawsze dać na full. Od tej pory każda gra mi się wydaje inna. W te co do tej pory grałem choć ledwo działały i wydawały się fajne to ich teraz nie poznaje. Wydają się jak całkiem nowe gry i aż mi się chce jeszcze raz je przejść. Ostatnio kupiłem sobie parę nowych gierek to jak kupowałem to chwilę się zastanawiałem czy mi w ogóle pójdzie, ale dotarło do mnie że nie muszę się przez jakiś czas przejmować wymaganiami.

Kupienie nowego komputera po 10 latach grania na takim że ledwo co chodziło robi mega różnice.

zobaczenie pierwszy raz HDR 1000 nitów na qdoledzie to będzie jak wspomnienie pierwszego razu :)

Chryste, krindż taki, że aż bolą zęby.

Herr Pietrus - starałem się jak mogłem żeby podkreślić co się wydarzy ;) wiem że jeszcze wszystko przed tobą na obu polach ;)

Po tobie niczego innego niż gimbusiarskie odzywki się nie spodziewałem. Kontynuuj, bo zabawa jest przednia, naprawdę mnie intryguje, jak bardzo jeszcze zdołasz się ośmieszyć.

Aż jestem ciekaw twojego zdania.

Czy podobnie jak mi:

- czcionki nie będą jakoś specjalnie przeszkadzały (przed mdoem), chociaż zauważalnie gorsze niż na ips;

- stutter będzie mocno przeszkadzał - to co pisałem o płynności w filmach (czyli efekt pojawiający się przy błyskawicznych wyświetlaczach, ale w technologi sample and hold - za opisem rtings: Due to the near-instantaneous response time, there's noticeable stutter as each frame is held on longer with low-frame-rate content. It's especially noticeable in slow panning shots.);

- hdr uznasz za najlepszy jaki widziałeś (chociaż ja mam spore porównanie i najlepiej wyglądało to tu z hdr10+ w filmach, a ty tego nie doświadczysz).

A tak btw, testowałeś już pc? Jakie temp?

Elo mordy i wariaty.

W 2018 opusciłem łono PC na rzecz PS4 a nastepnie Nintendo. Teraz pojawiła sie opcja nabycia od spoko mordy kompa za 850zł. Wymagajacy nie jestem jak juz wiecie z racji konsol, które posiadam.

Sprzet to i5 3470, RX6400 dysk SSD 256gb i 16gb ram.

Raczej na bank to wezme. Tylko pytanie co ja na tym odpale czego NIE MA na PS4 i switchu.

W sumie RDR2 pyknałbym jak człowiek jesli sie da chociaz ograne na PS4. Da to rade?

dzieki. Elo.

Wczoraj wszystko ustawiałem, aktualizowałem itp., więc wkrótce coś więcej napiszę. Muszę system i monitor potestować.

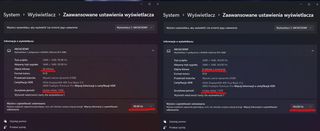

Pierwsze wrażenie: tak, na matrycy OLED fonty są nieco gorszej "jakości" (rozmyte) niż na IPS. Zobaczę, czy da się coś z tym zrobić i jak bardzo będzie mi to przeszkadzało. Dell Alienware nie jest najlepiej wykonany, podejrzewam, że G8 będzie pod tym względem "z wyższej półki". Alienware ma mocno "plastikowy" vibe, dolna belka jest bardzo duża. Fatalna jest również podstawa, która mocno wystaje i z przodu, i z tyłu poza płaszczyznę ekranu, zabierając dużo miejsca na biurku zarówno przed monitorem, jak i za monitorem. Co więcej, monitor jest lekko przechylony w jedną stronę (różnica między blatem a krawędzią ekranu po obu stronach wynosi ok. 4 mm) i nie znalazłem sposobu na to, żeby go wyrównać (choć w instrukcji monitora znajduje się obrazek, który pokazuje, że istnieje możliwość regulacji do 5 stopni). (Może ktoś ma podobny sprzęt i wie, czy to w ogóle możliwe?). Wziąłem jednak Della (a nie Samsunga) ze względu na 3-letnią gwarancję na wypalenie. Jeśli komuś nie zależy na tej gwarancji, to pewnie bym poważnie doradzał wypróbowanie G8.

Jakość obrazu: tak, widać różnicę. Czerń jest czarna, a kolory bardziej "żywe". Gry wyglądają świetnie. Filmów jeszcze nie zdążyłem przetestować. Dziwi mnie natomiast pewna "poświata", która pojawia się wokół krawędzi np. filmów na YouTube, które nie są uruchomione w trybie pełnego ekranu, tylko w przeglądarce. Monitor ma najnowszy firmware, więc przełączanie się na tryb HDR bywa uciążliwe, gdyż trwa ok 4-5 sekund (w tym czasie ekran staje się czarny). Dawny firmware był wadliwy w trybie HDR, ale umożliwiał natychmiastową zmianę ustawień.

Trudno też znaleźć mi "sweet spot" między jasnością a kontrastem. Albo biel jest za jasna, albo ekran staje się zbyt rozmyty. Ale może to kwestia dłuższego stosowania metody prób i błędów. Tak czy owak, gdy idzie o wykorzystanie "desktopowe", to na razie mój stary monitor rozwala tego Della w przedbiegach; gdy jednak idzie o gry, przegrywa. ;)

Biorę się więc za testowanie i ustawianie (monitora i podzespołów).

Nie do końca rozumiem zasady działania HDR-u w grach i w systemie. Czy powinienem przejść z Win 10 na Win 11? Czy muszę ustawiać HDR w grach czy też wystarczy ustawić HDR na monitorze. Czy muszę coś zmienić w panelu Nvidii albo ustawieniach Windows, żeby korzystać w pełni (i poprawnie z tego trybu)? Np. w przypadku CP2077 w ustawieniach gry nie jestem w stanie włączyć trybu HDR (jest szary). (A zainstalowałem najnowsze sterowniki monitora).

Nie wiem też do końca, czy tryb synchronizacji (ten monitor współpracuje z kartami Nvidii) uruchamiany jest automatycznie czy też muszę coś włączyć, żeby z niego korzystać. Wtedy Vsync ma być włączony czy wyłączony? Pewnie coś mi umyka.

I wreszcie pytanie o poświatę (także wokół elementów interfejsu), która pojawia się np. w CP2077. Zaznaczyłem ją na zrzucie. To normalne, bo nie pamiętam, żebym miał coś takiego na starym monitorze (ale może mnie pamięć zawodzi)?

Dajcie znać, co i jak przetestować. I jak ten monitor ustawić. Na razie w 3D Marku testy obciążeniowe wychodzą dobrze, a testy wydajnościowe dają zielone wyniki. O temperaturach już pisałem wcześniej (są chyba OK).

Np. w przypadku CP2077 w ustawieniach gry nie jestem w stanie włączyć trybu HDR (jest szary)

Upewnij się, że grasz w Full Screen - w jakimkolwiek innym trybie HDR się nie włączy. No i niestety musisz włączyć HDR w łindołsie (ustawienia ekranu).

No i niestety musisz włączyć HDR w łindołsie (ustawienia ekranu).

Jak włączę HDR w Win 10, to czerń robi się cholernie szara, wyblakła. Fatalnie to wygląda. Serio. Nie ma szans, żebym tego używał. ;)

Upewnij się, że grasz w Full Screen - w jakimkolwiek innym trybie HDR się nie włączy.

Gram w trybie pełnego ekranu, a mimo to HDR jest niedostępne w CP2077.

Ja to włączam tylko przed uruchomieniem gry,

Niestety windows nie umie w HDR i tak to wygląda...

Jednak już w grze będzie ok.

A - jak zrobisz zrzut ekranu w grze w trybie HDR i wkleisz go gdziekolwiek, to nie zdziw się, jeśli będzie wyglądał... dziwnie ;)

OK. Po włączeniu HDR w Windows rzeczywiście pojawiła się możliwość ustawienia HDR w CP2077.

Ale to jest tak ch***** rozwiązane, że się za głowę złapałem. Desktop i menu gry wyglądają fatalnie (wypłowiałe, szare). Ale sama gra....

Rzeczywiście: WOW! Musze przyznać, że Aleks miał w znacznej mierze rację. HDR wygląda w CP2077 olśniewająco. :) Nie wyobrażam sobie jednak (na razie), żeby kilka godzin w ten sposób grać. Oczy sobie można wypalić. ;)

Naprawdę nie da się czegoś zrobić, żeby ten tryb HDR w Windows tak nie rozwalał całego profilu kolorów i kontrastu?

Poczytaj sobie o swoim monitorze.

Prawdopodobnie ma w ciul opcji. Tak samo jak mój LG, którego nigdy nie chciało mi się rozkminiać tak na 100%.

No i niestety - nic się nie da zrobić, chyba że ustawieniami monitora ale nie sądzę aby to przyniosło zadowalające wyniki.

Dalej mam też straszny screen tearing w grze, choć działa bardzo płynnie. Nie za bardzo wiem, co ustawić i jak. :)

Wejdź w panel sterowania NVIDIA ( z ikonki w trayu), przejdź na Wyświetlanie -> Konfigurowanie funkcji G-SYNC i upewnij się, że u Ciebie jest wszystko tak samo ustawione jak na screenie obok.

Dzięki, Leo Tar.

Nie miałem zaznaczonego ostatniego okienka, bo ten monitor oficjalnie nie wspiera G-Sync. Zaznaczyłem mimo wszystko. Zobaczymy, co się zmieni. :)

A co Ci przeszkadzają te kolory w hdr na pulpicie jak na nim wtedy nic nie robisz.

Odpala to się tylko jak chce się grać albo film obejrzeć.

Aby uzyskać najlepsze efekty hdru pod daną grę musisz ustawiać monitor jak i opcje w grze.

Tu dobry kanał

https://youtube.com/@GamingTech-YouTube?si=hMFg8fe7veUifpvs

Opcjonalnie:

Zainstaluj i uruchom aplikację Windows HDR Calibration. Aplikacja ta jest Windowsową wersją narzędzia Microsoftu oryginalnie przygotowanego na potrzeby Xboksów i pozwala przekazać systemowi, jakie możliwości ma monitor podłączony do komputera. Dzięki temu HDR powinien wyglądać lepiej w grach.

Do załączania/wyłączania HDR służy skrót

Win + Alt + B

Nie do końca rozumiem zasady działania HDR-u w grach i w systemie. Czy powinienem przejść z Win 10 na Win 11? Czy muszę ustawiać HDR w grach czy też wystarczy ustawić HDR na monitorze. Czy muszę coś zmienić w panelu Nvidii albo ustawieniach Windows, żeby korzystać w pełni (i poprawnie z tego trybu)? Np. w przypadku CP2077 w ustawieniach gry nie jestem w stanie włączyć trybu HDR (jest szary). (A zainstalowałem najnowsze sterowniki monitora).

Kleks ci przecież wyjaśnił, wszystko działa od strzała, włączasz i zapominasz. Odin też o tym pisał.

I nie, nie jest za jasno, w ogóle minimum to powinno być 1500 nitów ciągle, żeby mówić o jakości.

Zainstaluj i uruchom aplikację Windows HDR Calibration.

Dzięki za informację! Ten program wymaga chyba Win 11. Czytałem już kilka razy, że najlepiej zainstalować nowy system, żeby w pełni korzystać z HDR-u.

Kleks ci przecież wyjaśnił, wszystko działa od strzała, włączasz i zapominasz. Odin też o tym pisał.

I nie, nie jest za jasno, w ogóle minimum to powinno być 1500 nitów ciągle, żeby mówić o jakości.

Ironia ironią, ale rzeczywiście HDR w np. CP2077 robi wrażenie. Może nie na miarę pierwszego razu, ale jednak... ;)

Cyberpunk to nie jest najlepiej wyglądająca gra w HDR to tak w połowie drogi bliżej góry

1. przede wszystkim musisz ustawić HDR dobrze w danej grze bo ustawiasz go zawsze pod dany monitor / TV

2. nigdy nie zrobisz zdjęcia w HDR aby pokazać innym więc jeśli je robisz to znaczy że HDR się nie włączył

3. w przypadku steam od razu zobaczysz różnice jak włączysz HDR bo włączając nakładkę steam wszystko co jest nakładką ma inną kolorystykę

4. po testuj sobie na różnych grach bo różne mają różny typ ustawień jedne pod zdjęcia i biel np. gry ubisoftu inne np microsoftu box co jest b. proste do ustawienia itd. itd.

5. HDR wspierają prawie wszystkie gry obecnie a te co nie mają autoHDR dla W11 więc właściwie wszystkie w jakieś formie. Masz monitor pod 1000 nitów czyli właściwie b. wysoki poziom jakości więc to że coś nie wygląda "o ja pier...." to dlatego że źle na razie coś ustawiłeś :) ale spokojnie kwestia paru dni i będziesz mistrzem jedi.

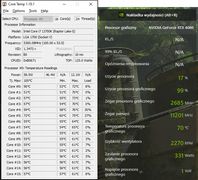

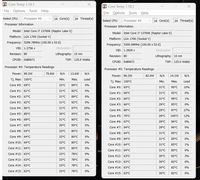

Pograłem jakąś godzinę w "Avatara" (na maksymalnych ustawieniach ultra). Sytuacja z temperaturami jest następująca (przy największym obciążeniu) ---->

Czy wszystko w porządku?

Tak, jest ok, lecz w tej grze masz bottlwnck od strony karty graficznej (sytuacja porządna) i ogranicza to wykorzystanie cpu (czyli też temp.).

Wcześniej wymienialem gry najbardziej jadące na cpu.

70C@2270rpm, moim zdaniem nie jest dobrze.

oczywiście że jest dobrze zrzuty na GPU są dopiero przy 88C więc jeszcze +18 do tego momentu a dead GPU przy 119C :) oczywiście możesz zmienić krzywą dla wiatraków ale to już od własnych preferencji podbijesz RPM spadnie temp. tylko po co ?

2300rpm to odrzutowiec, a temp. na GPU taka sobie. Nie wiem w czym ta karta wyroznia sie na tle innych 4080, ale na pewno nie kultura pracy.

Aż się prosi o UV grafy...

No i wyrzuć Gf Experience.

70C@2270rpm, moim zdaniem nie jest dobrze.

W przypadku CP2077 (wszystko na ultra + Ray Tracing i Path Tracing) temperatura wynosi ok. 65-66 stopni przy zużyciu GPU 98%, a rpm wynosi 1755 (klatkaż wtedy to ok. 60-66 fps).

Wziąłem "Avatara", bo to gra, która chyba najbardziej zarzyna GPU.

Aż się prosi o UV grafy...

No i wyrzuć Gf Experience.

UV czyli undervolting? GF Experience rzeczywiście wywalę, bo chyba źle wpływa na wydajność gier. Czym w takim razie mierzyć działanie GPU?

Czym w takim razie mierzyć działanie GPU?

Wszystko jest w HWiNFO, tylko troche zajmuje ogarniecie czujników. ->>>

Bukary - Her Pierdus nie ma pojęcia nic o HDR więc możesz go wygasić w dalszym temacie ;)

Bukary - to jest twój debiut więc jeszcze nic nie wiesz ;) tak załóż a za moment będziesz wiedział wszystko. Po pierwsze przesiadka na W11 to absolutna konieczność i to na najnowszą kompilacje wynika to właśnie z tego że HDR na W10 nie działa dobrze lub i wcale z różnymi nowszymi ekranami.

Kolejna kwestia to że pojawia się napis HDR czy SDR na monitorze to nic nie znaczy. Jak ustawisz wszystko dobrze będziesz miał wszystko jak trzeba w HDR non stop w Windowsie.

więc:

1. zainstaluj W11 + najnowszą kompilacje

2. włącz tryb Użyj protokołu HDR włączone - jak naciśniesz potem na strzałkę to masz Janość zawartości w formacie SDR suwak i dwa przykładowe zdjęcia jedno w SDR lewe i HDR prawe ustaw tak aby było dobrze i tutaj i tutaj pod ustawienia monitora

3. sprawdź jak masz ustawiony monitor (nie koniecznie po wyjęciu z pudełka jest idealnie) poczytaj na forum

4. włącz panel sterowania Nvidii -> zmiana rozdzielczości sprawdź czy masz tam ustawione poprawnie rozdzielczość + wyjściowa głębia kolorów 10bpc -format kolorów RGB wyjściowy zakres tonalny pełny

5. wyreguluj ustawienia kolorów ustaw tak jak ci pasuje

Tryb HDR używasz cały czas i czerń i kolory będą w pełnych 10 bitach. Ustawiłbym ci to w 10 sekund ale niestety mogę tylko pomóc w formie albo na steam jak mnie złapiesz albo jak przeczytasz moje posty. W każdej grze ustawienia HDR ustawiasz pod dany monitor w Cyberpunku ustawiasz max peak na 1000 a biel na 250-300. Zresztą masz pokazane zawsze przykładowe rysunki aby nie ucięło detali. Nauczysz się z czasem i jak wyżej śmiało pisz do mnie albo do Odina.

Ja bym zaczal od tego:

Ktoś po użyciu tej aplikacji napisał tak ->

BTW: promka za 3777

I chyba znalazłem grę, która rzuca mój system na kolana. Ustawiłem w niej wszystko na maksa (DLSS + RT + PT) i klatkaż wynosi 28-30 fps.

To

spoiler start

Alan Wake II

spoiler stop

I mam problem z ustawieniem czegokolwiek tak, żeby osiągnąć powyżej 60 fps. Chyba że wyłączę PT i RT. Też tak macie czy coś jest u mnie nie w porządku?

Jedyna karta, ktora jest w stanie utrzymac 60 fps+ z DLSS quality Ultra 4K PT to RTX 4090, wiec wszystko w porzadku.

Moze dupa zapiec jak sie wydaje 6k na karte, a tu taki zonk, dlatego wielu idzie od razu w 4090. Jeszcze nie tak dawno do ogarniecia za 7.5k w duzych polskich sklepach. Troche sie spozniles z tym upgradem kompa.

albo nie przepłaca i kupuje kartę za 3000zł bo po co płacić tyle jak i tak nie jest wstanie osiągnąć na takie 4k i 60FPS.

Ustawiłem wszystko praktycznie na maksa, tylko RT dałem na średni i udało się wyciągnąć w AWII ok. 60-75 fps. Gra się bardzo przyjemnie. A sama gra wygląda naprawdę niesamowicie.