Nie zaoferuje, zaoferuje wydajność minimalnie lepszą niż 4070, po prostu NVIDIA walnęła marketingową sciemę bo teraz DLSS będzie generował 3 klatki w FG zamiast jednej ;)

Że też nie macie wstydu wrzucać takie baity i brednie, które wyjaśnił już Kuba wyżej...

Orgazm alexa wystarczy żeby wiedzieć, aby trzymać się od tej generacji z daleka.

Podsumujmy.

Rynek cały czas idzie w stronę AI (zrozumiałe i oczywiście do przewidzenia). Czysta wydajność bez AI w tych pieniądzach jest śmiesznie lepsza w stosunku do poprzednich kart (również bez zaskoczenia a te tendencja będzie się nasilać). Nividia sprzedaje w zasadzie podobną fizycznie serię do poprzedniej ale odcina kupony oprogramowaniem. W porządku, mogą, ale pytanie czy to jest tyle warte? Są ograniczenia w produkcji procesorów dla zwykłego konsumenta i AI może być rozwiązaniem (wręcz wygląda na to, że musi) i jesteśmy sakazni na tę tendencję.

Ale...

Mam 4080 do 2k z zamysłem siedzenia na niej dobre kilka lat. I teraz pytanie ile w zasadzie odpaliłem gier wykorzystujących DLSS 3/3.5 oraz ile jest takich gier na rynku na ten moment (dodatkowo wciąż są gry które mają DLSS źle zaimplementowany). Z pamięci zmieszczę się na palcach dwóch rąk i oczywiście można teraz wylistować wszystkie gry, ale przypominam że wczystkich nie odpalicie. Po prostu jeden odpala co się da, a drugi uderzy tylko w kilka tytułów. Subiektywna kwestia.

Biorąc to wszystko pod uwagę to zakres odbiorców którym realnie opłaca się iść w nowe karty jest mały. Więc dwa razy zastanówcie się przed zakupem.

Osobiście nie podoba mi się taka tendencja i wszelkie stwierdzenia, że obraz generowany z DLSS nie odbiega jakością są śmieszne. Szególnie w dynamicznych grach. Zawsze obraz generowany przez AI będzie gorszy (patrzę na Ciebie STALKER 2). Mniej lub bardziej. Lepsza lub gorsza implementacja. Bardziej lub gorzej wprawne oko to wyłapie. Ale finalnie płacimy jakością i kuriozalnie optymalizacją w imię grafiki i drogiej technologii. Czegoś co niewielu chce a wielu się wmawia że ma sens.

Jesteśmy na portalu głównie o grach. Zatem. Chcemy lepszych gier i dobrze działających a niekoniecznie wyśrubowanych graficznie. Gdzie postęp w animacjach? Mechanikach (tu jest co raz gorzej)?

Finalnie jestem zniesmaczony obecnymi trendami rynkowymi częściowo popychanymi producentami podzespołów, a kolejna seria kart ponownie skłania do refleksji i sensowności zakupów.

Obrzydzenie mnie bierze jak czytam twoje posty i patrzę na twoją naiwność.

Dają ci te technologie do gier które wyglądają gorzej niż to co ma 9 lat, a ty się cieszysz jak głupi:

h ttps://www.youtube.com/watch?v=eKGqtZc-xsQ

Buahahaha chociaż RTX 4070 super jest pomiędzy 3090/3080TI tylko że bez DLSS czyli w natywnej RTX 5070 nie przegoni 4070 Super.

Powoli, pomalutku, nVidia właśnie skręca z "nowa karta, więcej mocy w bonusie DLSS" do "nowa karta, nowy DLSS, trochę więcej mocy". Trzeba być naprawdę bardzo krótkowzrocznym, aby nie zauważyć gdzie to zmierza (zwłaszcza biorąc pod uwagę, że nVidia nie otwiera się ze swoimi rozwiązaniami na innych) i trzeba mieć naprawdę wyprany mózg, aby to pochwalać. Uzależnianie wydajności od AI to tragedia, bo wchodzimy tutaj bardzo mocno w uzależnienie od softu. Wszystkim przyklaskującym gratuluje braku wyobraźni, bo jeśli to się przyjmie, to znając nVidię, zaraz będziecie mieli dodatkowe, zablokowane przez software, płatne ficzery do kart. Intel starał się to zrobić w prockach, nie wyszło, ale nVidia jak już za pośrednictwem swoich wyznawców będzie miała wszystko, to...powodzenia :) Wisienka na torcie jest sama jakość gier pod względem kodu + to jak będzie to działać u konkurencji.

A jeśli komuś się wydaje, że przesadzam, to niech przejrzy jak postępował rozwój tej firmy i dzięki inwestycjom w co tak się rozrosła. Trzeba być bardzo, bardzo naiwnym aby założyć, że nVidia nie będzie chciała zarobić na tym samym w przypadku rynku konsumenckiego, wszystko już mają :]

Zaoferuje wydajność na poziomie RTX 4090, ale... I tu lista gwiazdek z objaśnieniami. Jeśli już coś takiego ma być możliwe, to zapewne w użyciem nowego DLSS i FG. Niby spoko, bo liczy się efekt końcowy w postaci ilości klatek, tylko nie mówmy wtedy o wydajności. Po drugie, generowanie trzech klatek na jedną rzeczywistą? Pachnie potężnym input lagiem, zwłaszcza, jeśli bazowe będzie coś w stylu 30 fps. Chyba, że nowy Reflex uczyni cuda. Trzeba poczekać na rzeczywiste testy, a nie od razu się podniecać czy hejtować.

Jeśli wyjdzie, że 5070 jest szybszy od 4090 to ludzie tego psychicznie nie wytrzymają ale na otarcie łez 24 GB vram.

Widzę ze już nie które pelikany łapią ten bełkot marketingowy. Problem ze ten frame generator nie działa idealnie. (artefakty, ghosting, input lag ale to maja poprawić). Ta technologia potrzebuje jeszcze czasu żeby się rozwinąć.

Techpowerup gotowy na premiere 50x0. Nowa platforma na procesorze 9800X3D i nowe gry do testow.

"Aby przygotować się na pojawienie się kart graficznych nowej generacji, które pojawią się na rynku w styczniu 2025 r., przeprowadziliśmy ponowne testy wszystkich istniejących kart graficznych na nowym komputerze. Na przystawkę postanowiliśmy zaprezentować wyniki wydajności tych kart."

https://www.techpowerup.com/review/gpu-test-system-update-for-2025/

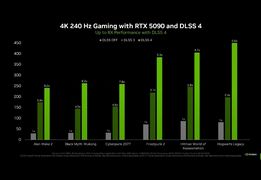

Te karty to wielka ściema i robienie z ludzi idiotów. Natywnie mają moc na poziomie poprzedniej generacji serii 4000. Spokojnie ta technologia Multi Frame Generation mogła być zaimplementowana w serii 4000 tylko chodzi o skok na kasę. Już w sieci latają "cudowne" testy wydajnościowe kart RTX 5090 które NIE RADZĄ sobie natywnie w 60 FPS przy rozdzielczości 4K w takich tytułach jak: Alan Wake 2, Black Myth Wukong, Cyberpunk 2077. To tylko pokazuje jak można się dać nabić w butelkę.Ale jest ponoć szansa że nieoficjalnie uda sie odblokować obsługę Multi Frame Generation na kartach serii 4000 które już mają Frame Generation. Przypominam że Multi Frame Generation wymaga również mocnego procesora by móc wygenerować do 3 dodatkowych klatek z wykorzystaniem AI a nie 1 dodatkową jak miało to miejsce w Frame Generation (to nie są oczywiście klatki generowane w 100% zgodnie z prawdziwym obrazem który wytwarza karta a tylko ich imitacja, co może oczywiście prowadzić do artefaktów graficznych). Poza tym generowanie az 3 dodatkowych klatek powoduje znaczny input lag który juz był odczuwalny w niektórych tytułach przy włączonym Frame Generation. Nie byłbym tak optymistyczny patrząc na prawdziwą wydajność tych kart - stąd też ta niby "niska" cena sugerowana przez NVIDIA.

No i ostatnia sprawa to że NVIDIA ma ponoć wydawac teraz nowe serie kart znacznie częściej jak to miało miejsce w poprzednich latach. Czyli doszli do wniosku że mniejszym kosztem ale częściej będą sprzedawać prawie ten sam produkt pod inną nazwą z wykorzystaniem technologii które mogły być swobodnie implemetowane wcześniej i nie wymagają znaczących modyfikacji sprzetowych.

Obawiam sie że może to być najgorsza seria kart ze względu na korzystanie z ułomnego generowania wielu klatek przez AI a na dodatek zwolni to deweloperów z optymalizacji swoich produktów w przyszłości co będzie tragiczne w skutkach.

Czyli zaoferuje coś co wygląda jak wyższa wydajność.

Coś co ją przypomina. Imituje.

No i git, dzięki DLSS4 będzie można lecieć na RTX5060 i mieć wydajność 5090, szkoda tylko tych naiwniaków co faktycznie przepłacą za te droższe modele, niż 5060.

ale bzdury :) tak to jest jak nie ma się żadnego pojęcia o czym się mówi :)

DLSS4 będzie dostępne dla wszystkich poczynając od serii 2xxx, jedynie FG będzie dla 4xxx i MFG dla 5xxx. Poprawa w DLSS4 jest bardzo duża względem 3.5 co i tak dawno ustawiło NV daleko przed kartami i technologią FSR od AMD.

Jeśli chodzi o DLSS to w zależności od wybranego trybu P/B/Q mamy inną wejściową rozdzielczość do budowy obrazu. I teraz uwaga bo dalej powielanie głupot. Opóźnienie jest tym mniejsze im jest więcej klatek bazowych. Czym więcej na początku klatek bazowych a wiadomo że w DLSS będzie więcej tym mniejsze ms dla budowanego obrazu niż w Natywnej (zupełnie inna wydajność np. 1440p -> 4K względem 4K bazowego). I teraz uwaga bo dalej niektórzy muszą włączyć myślenie dodanie FG czy MFG może spowodować (to zależy od bazowej wydajności budowy obrazu) niższe opóźnienie niż przy obrazie natywnym. Z prostego przełożenia obraz budowany jest z 1440p np. ma 60 klatek wyjściowych do 4K, a w natywnym np. ma 45 klatek (to jest tylko przykład) który i tak zawsze będzie pokazywał to samo obraz budowany w DLSS ma więcej klatek bazowych i niższe opóźnienie na starcie.

I teraz przezabawne jest to że ktoś pisze (włączenie FG czy MFG wywali opóźnienie w kosmos). Doda opóźnienie ale do bazowego które sumarycznie może być niższe / podobne jak przy natywnym.

3 dodatkowe klatki przez AI które są generowane na podstawie bazowej to nie wrzucenie mirrora klatki (jak ktoś nie wie jak to działa to powiela kolejne bzdury o "fejkowych" klatkach). Jeśli wszystko będzie działać poprawnie a wychodzi że będzie to dostaniecie w zależności od wybranego trybu przemnożenie bazowej wartości. I teraz uwaga seria 4xxx ma FG a seria 5xxx ma MGF i jeśli wyjściowe dla np. 4090 będzie 70fps a z FG np. 120 to w przypadku takiej karty jak 5070 wyjściowe może być np. 45 ale przemnożone przez 3-4 może dać 120-140 i w tym przypadku pokryje się wydajność. I teraz ktoś napisze ale to są sztucznie włożone klatki. I też nie to nie są klatki zduplikowane jako rama tego samego obrazu. Już prościej chyba też się nie da wytłumaczyć.

Jak ktoś przeczyta to co wyżej z dwa razy to może w końcu zrozumie że to co dostarczyła NV to jest najlepsze co gracze dostali od dawna. Jeśli wszystko będzie działać poprawnie nie trzeba będzie kupować karty za 10K aby mieć 100-120fpsów taka karta jak 5090 będzie skierowana do osób które chcą wycisnąć 166-240 lub i więcej fpsów pod pokrycie ich odbiorników w odświeżaniu 1:1.

I za moment pojawi się kuba czy inny twardogłowy i napisze :) ale przecież to nie jest wydajność w czystej restyryzacji (sucha wydajność bez DLSS/FSR) no nie jest ale co z tego ? Użytkownika końcowego interesuje to jak wygląda obraz i jak coś działa a nie na jakiej zasadzie to działa. Istotne jest to aby działało to dobrze.