Różne modele sztucznej inteligencji stały się jednym z głównych tematów ostatnich miesięcy i z pewnością będą na ustach wielu ludzi w najbliższej przyszłości. Jako specjalista w zakresie uczenia maszynowego chciałbym powiedzieć, na czym stoimy.

Sebastian Purtak

W ostatnich miesiącach pojęcie sztucznej inteligencji osiągnęło zupełnie nowy poziom buzzworda. Z każdym dniem społeczność internetowa coraz bardziej się nakręca, zmierzając w stronę niezdrowego hype’u lub skrajnego defetyzmu. Ci, którzy chcą się zdystansować od tej gorączki, przyjmują natomiast stanowisko uroczej ignorancji. W takich okolicznościach warto spróbować odpowiedzieć na pytanie: co się właściwie dzieje?

Jako specjalista w zakresie uczenia maszynowego spieszę z odpowiedzią – otóż, nie mam bladego pojęcia. Oczywiście możemy wskazać początek tej powszechnej gorączki, a jest nim sukces tzw. „modeli generatywnych”, najpierw generatorów obrazu, a następnie mainstreamowego już ChataGPT. To zrozumiałe, że nowe zabawki rozbudziły wyobraźnię tłumów, zwłaszcza że w tak spektakularny sposób pokazują możliwości długo wyczekiwanej i mocno zmitologizowanej technologii. Rzecz jednak w tym, że mocno poruszonych jest też wielu znamienitych specjalistów z branży i przynajmniej część z nich trudno posądzić o próbę rozgrywania sprawy jedynie w kategoriach marketingu.

W powszechnej opinii coraz mocniej zaczyna rezonować przekonanie, że naukowcy zajmujący się SI tak naprawdę nie wiedzą, co robią, a uczenie maszynowe to swoista alchemia XXI wieku. Nic więc dziwnego, że wystraszony dziennikarz pyta na konferencji prasowej szefa Google’a, dlaczego wypuszczają na rynek technologię, której nie rozumieją. Prawda jest jednak o wiele bardziej skomplikowana i żeby pojąć powagę sytuacji, konieczne jest spojrzenie na sprawę w bardziej techniczny sposób.

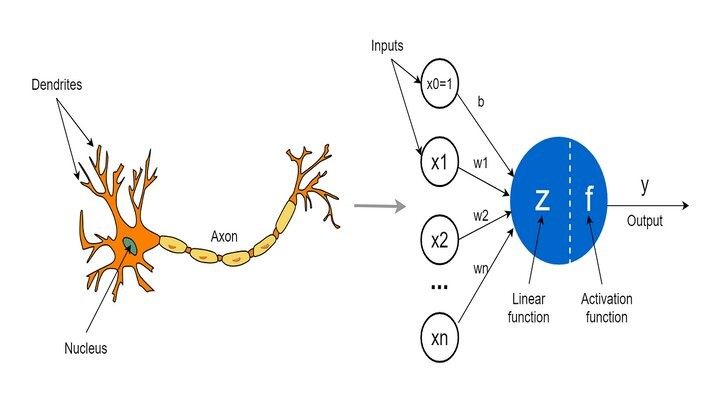

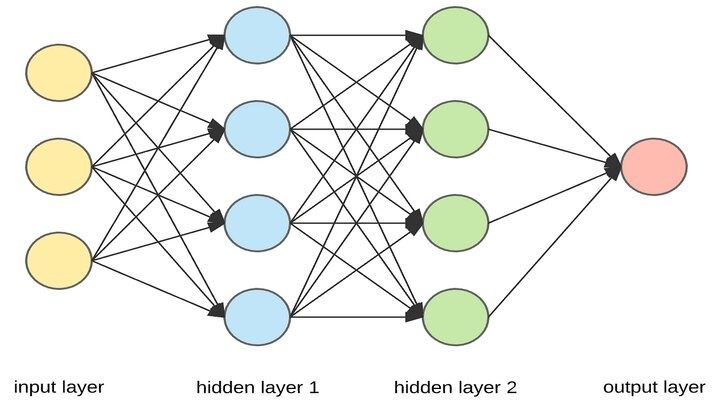

Zacznijmy od tego, że sztuczna inteligencja jest interdyscyplinarną nauką ścisłą, u podstaw której leżą dość solidne fundamenty, w postaci takich działów matematyki, jak algebra liniowa czy rachunek prawdopodobieństwa. Wiemy dobrze, jak zbudowane są sieci neuronowe, a więc algorytmy stojące za obecną rewolucją SI. Początkowo zresztą rozwój w tej dziedzinie odbywał się głównie dzięki opracowywaniu nowych architektur bądź elementów składowych takich algorytmów. Ostatnim naprawdę znaczącym odkryciem było stworzenie tzw. „mechanizmu uważności” (ang. attention mechanism) w 2017 roku, dzięki któremu sieci neuronowe zyskały możliwość przetwarzania naprawdę dużych fragmentów tekstu. To właśnie ten mechanizm jest kluczowym elementem modeli takich jak ChatGPT.

Od tamtego czasu nastąpiła jednak pewna zmiana w paradygmacie. Okazało się bowiem, że możemy znacznie zwiększyć możliwości SI, po prostu zwiększając jej rozmiar i liczbę danych, za pomocą których jest trenowana. Zbiegło się to w czasie z istotnym wzrostem dostępnej mocy obliczeniowej dzięki wykorzystaniu kart graficznych i doprowadziło do wyścigu o to, kto zbuduje większy model (fachowa nazwa SI). Oczywiście był to siłą rzeczy wyścig, w którym zwycięża ten, kto jest w stanie więcej zainwestować.

O co więc chodzi, gdy specjaliści z branży twierdzą, że algorytmy SI to tak naprawdę czarne skrzynki? Problem leży w skali i złożoności wykonywanych operacji. Wyobraźmy sobie klatkę zbudowaną z pojedynczego piksela. Załóżmy, że wraz z przejściem do kolejnej klatki piksel zmieni kolor. Zjawisko to wydaje się trywialne i łatwe do opisu: mały kwadrat zmieniający kolor w czasie. Wyobraźmy sobie teraz obraz w rozdzielczości 4K. 3840 na 2160 pikseli, z których część zmieni kolor po przejściu do kolejnej klatki. Jest to takie same zjawisko jak w przypadku pojedynczego piksela, ale przedstawione w takiej skali tworzy film – zupełnie nowy i o wiele bardziej skomplikowany ładunek informacji. Takich właśnie zjawisk w dużej skali nie potrafimy dostrzec i zinterpretować w sieciach neuronowych. Jednocześnie wiemy, że muszą one tam zachodzić, gdyż wyraźnie wskazują na to nasze obserwacje i możliwości nowoczesnych modeli.

Te złożone zjawiska muszą przy tym powstawać samoistnie, gdyż z całą pewnością nie jesteśmy w stanie ich projektować. Co ciekawe, przypomina to do złudzenia jedną z teorii na temat ludzkiego umysłu, która głosi, że powstaje on właśnie jako takie zjawisko emergentne (samoistne) w wyniku wielu prostych operacji wykonywanych przez mózg. Jeśli to brzmi strasznie, to radzę zapiąć pasy, gdyż impreza dopiero zaczyna się rozkręcać.

Problem z interpretowalnością jest w dziedzinie SI obecny niemal od zawsze. Warto przy tym podkreślić, że w dużym stopniu sami go sobie zafundowaliśmy. Wystarczy spojrzeć na stosunek inwestycji, jakie w ciągu ostatnich 10 lat przeznaczono na badania nad interpretowalnością SI, do nakładów na wzrost jej wydajności. Pamiętam jeszcze czasy, gdy w branży mówiło się, że zdolność do interpretacji obliczeń będzie kluczowa, gdyż biznes nigdy nie oprze procesów decyzyjnych na czarnych skrzynkach, których działania nie rozumie. Cóż, dziś czarne skrzynki generują nagie zdjęcia nieistniejących modelek, a biznes je sprzedaje.

Problem z interpretowalnością wydaje się jednak poważny, bo realnie utrudnia odpowiedź na pytanie, co faktycznie się dzieje. Istnieje przypuszczenie, że w przypadku dużych modeli językowych (tzw. LLM – Large Language Models), takich jak ChatGPT, zaobserwować możemy pojawianie się umiejętności, których nie były one uczone. Byłby to istotny przełom w badaniach, który jednocześnie pozwoliłby stwierdzić, gdzie konkretnie znajdujemy się na drodze do stworzenia superinteligencji. Niestety, nie potrafimy uchwycić myśli maszyny. Co więcej, skala, z jaką te algorytmy przetwarzają informacje, jest tak duża, że nie potrafimy nawet z całą pewnością powiedzieć, co dokładnie znajdowało się w danych przeznaczonych do ich trenowania. Generuje to masę problemów technicznych, jednak istotne okazuje się to, że w takich warunkach trudno stwierdzić, czy algorytm faktycznie wypracował jakąś umiejętność samodzielnie, czy może znalazł podpowiedzi w odmętach zbioru treningowego.

Wirtualny Westworld

Jak się okazuje, modele takie jak ChatGPT mogą znaleźć ciekawe zastosowanie również w dziedzinie gier komputerowych. Autorzy publikacji Generative Agents: Interactive Simulacra of Human Behavior przygotowali symulację, w której grupa postaci NPC była sterowana właśnie przez ChatGPT. W efekcie udało się stworzyć małą wirtualną wioskę, której mieszkańcy zachowywali się w ciekawy i realistyczny sposób. Postacie wchodziły ze sobą w interakcje, współpracowały i organizowały sobie wzajemnie czas. Dla przykładu jeden z mieszkańców wpadł na pomysł przygotowania imprezy z okazji zbliżających się walentynek. Pomysł ten przekazał w rozmowie innym NPC i po jakimś czasie impreza faktycznie się odbyła. Aktualnie duże modele językowe nie są szkolone ani dostosowywane do takich zastosowań, jednak eksperyment ten dowiódł, że jest to jak najbardziej możliwe. Można więc założyć, że branża gier komputerowych w najbliższym czasie również skorzysta na rewolucji SI.

Niemniej wszyscy fachowcy z zakresu SI widzą, że kończy się czas modeli wyspecjalizowanych w konkretnych dziedzinach, a nadciąga czas systemów ogólnego przeznaczenia. Jeszcze do niedawna, projektując system SI przeznaczony do zastosowań komercyjnych, projektowało się ściśle wyspecjalizowane narzędzie. Istniały osobne rodziny algorytmów, koncentrujące się na przetwarzaniu określonego rodzaju danych, takich jak tekst czy obraz. Dziś trwają intensywne badania nad modelami wielomodalnymi, a więc takimi, które są w stanie przetwarzać wiele rodzajów danych jednocześnie. Tristan Harris i Aza Raskin, założyciele Center for Humane Technology, nazwali tę nową klasę algorytmów GLLMM (Generative Large Language Multi-Modal Model), nawiązując do golemów z hebrajskiego folkloru.

Takim systemem ma być GPT-4, choć na ten moment (ukazania się niniejszego tekstu) nie upubliczniono jeszcze jego funkcjonalności w tym zakresie. Wszystko wskazuje jednak na to, że duże modele językowe osiągną ten stan w najbliższej przyszłości. W ten sposób zrobimy pierwszy krok w stronę tak zwanej Ogólnej Sztucznej Inteligencji. Pojęcie to niekoniecznie musi oznaczać superinteligentnego sztucznego boga, który zmiecie nas z powierzchni planety. W technicznym jego rozumieniu termin ten oznacza właśnie inteligentny system uniwersalnego przeznaczenia. Świadomość i chęć zniszczenia ludzkości wcale nie są w tym przypadku konieczne.

Warto podkreślić, że postęp w tej dziedzinie następuje tak szybko, że w chwili, gdy będziecie czytać ten tekst, obecny stan z pewnością okaże się już nieaktualny. Oznacza to, że możliwości systemów inteligentnych rosną w zastraszającym tempie. Wspomniany GPT-4 został ostatnio rozwinięty o tzw. „mechanizm refleksji” (ang. reflexion), który pozwala mu analizować i modyfikować własne zachowanie, tak aby mógł samodzielnie poprawiać swoje wyniki. Ten sam algorytm (GPT-4) stał się podstawą systemu Auto-GPT, który jest w stanie podejmować autonomiczne działania w sieci, by osiągać wyznaczone cele. Wszystko to sprawia, że tytuł niedawnej publikacji Microsoftu Iskry Ogólnej Sztucznej Inteligencji (ang. Sparks of AGI) zaczyna wyglądać jak coś więcej niż tylko tani chwyt marketingowy.

Tempo postępu technicznego jest przy tym tylko jednym z sygnałów alarmowych. Równie duże obawy może budzić nasza reakcja na możliwości nowej generacji SI. ChatGPT był największą premierą produktu IT w historii. Z dnia na dzień okazało się, że algorytmy, którymi wszyscy bawimy się w laboratoriach od kilku lat, mogą zarabiać gigantyczne pieniądze. Tak naprawdę nikt nie spodziewał się tego, że ludzie tak bardzo pragną tej technologii, zwłaszcza gdy zna się jej ograniczenia. Trzeba jednak przyznać, że OpenAI rozegrało swoją partię po mistrzowsku, komercjalizując duże modele językowe i uruchamiając całą lawinę zdarzeń.

Wybuch tej supernowej doprowadził bowiem do kolosalnego sprzężenia zwrotnego. Jak grzyby po deszczu zaczęły wyrastać projekty skupione na rozwoju i integracji dużych modeli językowych. Ogromne zainteresowanie ludzi przełożyło się na nowe dane w postaci konwersacji z SI. To natomiast pozwala na budowę nowych wersji modeli, takich jak GPT-4, które znów stały się podstawą takich projektów jak wspomniany wyżej Auto-GPT.

Fontanna dolarów, która wystrzeliła po premierze ChataGPT, z automatu zmieniła też politykę Big Techu. Wielcy gracze od razu przystąpili do morderczego wyścigu zbrojeń, wpadając w mechanizm znany z teorii gier jako „pułapka molocha”. Jest to zjawisko polegające na wzajemnym napędzaniu się uczestników danej gry, którzy chcą osiągnąć pewien cel (tzw. „funkcja molocha”). O ile każdy gracz występujący osobno postępuje racjonalnie, tak działając w grupie, zaczynają się ścigać, aby osiągnąć wspomniany cel. Początkowo wyścig przynosi korzyści każdemu z nich, jednak z czasem zaczyna pogarszać ich sytuację. Żaden z graczy nie jest już jednak w stanie wycofać się z wyścigu, nawet jeśli zdaje sobie sprawę z istnienia pułapki, gdyż taki ruch oznacza jego indywidualną porażkę. W ten sposób wszyscy solidarnie zmierzają ku przegranej.

Max Tegmark, założyciel Future of Life Institute i autor głośnego listu wzywającego do wstrzymania prac nad rozwojem modeli większych niż GPT-4, porównuje tę sytuację do historii z filmu Nie patrz w górę. Ludzkość zdaje sobie sprawę z tego, że niekontrolowany rozwój tej technologii niesie ze sobą trudne do przewidzenia konsekwencje, których skala może być naprawdę ogromna. Mimo to dalej pędzimy w stronę przepaści, kłócąc się i próbując na tym wszystkim zarobić. Tegmark twierdzi, że pół roku wystarczy, aby wypracować podstawowe mechanizmy bezpieczeństwa, jednak duzi gracze nie są w stanie się zatrzymać, bo wpadli w sidła molocha. Faktycznie, ogromna większość branży IT i specjalistów od SI krzyczy dziś o potrzebie choćby debaty na temat regulacji tej technologii. Niestety, politycy wciąż zdają się traktować całą sprawę jak histerie nerdów, ewentualnie szansę na poprawę własnych notowań. To o tyle kuriozalne, że nie jest to pierwszy raz, gdy znajdujemy się w takiej sytuacji.

Popularna w ostatnim czasie teza głosi, że pojawienie się modeli generatywnych, albo nawet Ogólnej Sztucznej Inteligencji, to nie jest nasz pierwszy kontakt z zaawansowanym systemem SI. Autorzy tej teorii posługują się analogią do hipotetycznego kontaktu z obcą cywilizacją i wskazują, że w przypadku ludzkości i SI miał on tak naprawdę miejsce w chwili pojawienia się mediów społecznościowych. Z technicznego punktu widzenia jest w tym sporo prawdy, gdyż pod maską aplikacji, takich jak Facebook czy Twitter, działają potężne systemy rekomendacji, oparte na algorytmach SI. Można więc spokojnie przyjąć, że pojawienie się mediów społecznościowych było pierwszym w historii przypadkiem masowego wchodzenia ludzi w interakcje ze sztuczną inteligencją. Systemy te są oczywiście relatywnie prymitywne w stosunku do tego, co wyobrażamy sobie jako Ogólną Sztuczną Inteligencję, ale nasze interakcje z nimi przyniosły szereg całkowicie niespodziewanych konsekwencji.

Celem większości współczesnych algorytmów SI jest optymalizacja pewnej funkcji, którą nazywamy „funkcją kosztu”. W uproszczeniu chodzi po prostu o optymalizację działań, tak aby w jak największym stopniu osiągnąć zakładany cel. W przypadku systemów rekomendacji w mediach społecznościowych tym celem jest zwiększanie zaangażowania użytkownika. Pamiętajmy, że algorytmy te nie posiadają żadnych wyższych funkcji poznawczych, nie wspominając o świadomości. Jednocześnie konkurowały one ze sobą o naszą uwagę w warunkach przypominających dobór naturalny.

Każdy z tych systemów poszukiwał więc, niejako na ślepo, najlepszych sposobów na utrzymanie nas przed ekranami telefonów i komputerów. Jak się okazało, najlepszym rozwiązaniem jest uzależnienie i co ciekawe, można je w mediach społecznościowych osiągnąć poprzez podkręcanie agresji i negatywnych doznań. Innymi słowy, wystarczy podsuwać ludziom miejsca, w których mogą bezkarnie kłócić się ze swoimi internetowymi oponentami, a ci sami zaczną to robić nałogowo. W konsekwencji po prawie dwóch dekadach od premiery Facebooka tego typu społeczności dosłownie rozpadają się na naszych oczach. Nie potrzeba do tego skomplikowanych teorii spiskowych czy nawet złych zamiarów. Wystarczy teoria optymalizacji i prosta „apka” do komunikacji.

Spokojnie możemy więc dojść do konkluzji, że pierwszy kontakt przegraliśmy. Pojawienie się modeli generatywnych będzie więc naszym drugim spotkaniem z zaawansowaną SI. Warto na tę okoliczność przeprowadzić eksperyment myślowy. Załóżmy, że prace nad dalszym rozwojem SI zostają całkowicie zatrzymane. W jednej chwili i na całym świecie dalszy rozwój tej technologii zostaje skutecznie zakazany, a wszyscy naukowcy i inżynierowie skupiają się jedynie na wykorzystaniu i wdrożeniu tych systemów, które do tej pory opracowaliśmy. Zastanówmy się, w jaki sposób wpłynie to na nasze społeczeństwo.

Zacznijmy od gospodarki, gdyż zapewne w tym wymiarze najszybciej ujrzymy zmiany. Skuteczne i nieograniczone wdrożenie modeli generatywnych w procesy biznesowe doprowadzi do ogromnej inflacji wiedzy. Nie chodzi nawet o pełną automatyzację pracy intelektualnej (patrz Auto-GPT), ale o znaczny wzrost jej wydajności, który spowoduje duże zmiany w gospodarce. Nieprawdą jest też twierdzenie, że ludzie, których obecna SI nie jest w stanie zastąpić lub wspierać, są na te zmiany odporni. Być może w ciągu następnych kilku lat roboty nie zastąpią dobrego stolarza, ale co z tego, jeśli połowa jego klientów straci pracę?

Ludzie są oczywiście niezwykle elastyczni, więc zapewne, podobnie jak w przypadku poprzednich rewolucji przemysłowych, i tym razem znajdą sobie nowe zajęcie. Mimo to można spokojnie założyć, że proces takich zmian będzie dla wielu bolesny. Jak słusznie zauważył Lex Friedman, autor znanej serii podcastów, SI nie przejmuje tylko żmudnych i powtarzalnych zadań, ale również te, które sprawiają nam frajdę. Cholernie lubię pisać kod, tak samo jak pewnie wielu grafików czy dziennikarzy lubi swoją pracę i wiążący się z nią proces twórczy.

Inflacja wiedzy będzie też miała nieprzewidywalne skutki w systemie edukacji. Zakładamy, że znajdziemy sobie nowe zajęcia, ale nie jesteśmy w stanie stwierdzić, na czym będą one polegać. Tym samym nie wiem, jakie umiejętności będą istotne za 10 lat, więc nie wiem, czego się uczyć. Co więcej, większość ludzi nie lubi wysiłku intelektualnego, a w przeciwieństwie do wysiłku fizycznego, który jest trendy, nie ma obecnie mody na naukę. Jak więc zmieni się nasze społeczeństwo, jeśli na którymś etapie jego historii wiedza i zdolności intelektualne przestaną dawać przewagę nad innymi ludźmi? Pytanie to jest istotne również z innego względu. Otóż potężnej próbie poddany zostanie cały nasz system obiegu informacji.

Przykładem tego niech będzie głośna ostatnio sprawa modelki Claudii, której nagie zdjęcia można było kupić na Reddicie. Jak się szybko okazało, Claudia nie istnieje, a zdjęcia wygenerowała SI (prawdopodobnie model Stable Diffusion). Najnowsze technologie w zakresie syntezatorów mowy (np. VALL-E) pozwalają na odtworzenie czyjegoś głosu na podstawie zaledwie kilkusekundowej próbki. Technologie tego typu sprawiają, że wszelkie informacje dostępne w Internecie stają się praktycznie niemożliwe do zweryfikowania. To natomiast stawia pod znakiem zapytania sens korzystania z globalnej sieci, która przecież powstała po to, by przekazywać informacje. Skoro nie jestem w stanie w żaden sposób zweryfikować informacji, które otrzymuję, to są one dla mnie bezwartościowe. Tym samym praktycznie bezwartościowe staje się samo korzystanie z Internetu.

Dołóżmy do tego fakt, że już teraz większość ruchu w sieci generują boty, których możliwości znacznie wzrosną dzięki systemom takim jak Auto-GPT. Już za chwilę może się okazać, że scenariusz rodem z Cyberpunka jest jak najbardziej realny. Internet stanie się skrajnie wrogim dla nas ekosystemem, w którym wszystko chce nas oszukać lub uzależnić. Korzystanie z sieci będzie równie ryzykowne i szkodliwe jak zażywanie naprawdę mocnych narkotyków.

Opisane problemy to tylko wierzchołek góry lodowej. Już teraz dostępne są technologie, które w oparciu o SI pozwalają dosłownie widzieć przez ściany lub odczytywać czyjeś myśli. Rozwój takich systemów zmieni wszystko i wpłynie na każdy aspekt naszego życia. Wspomniani wcześniej Tristan Harris i Aza Raskin przewidują, że wybory prezydenckie w USA w 2024 roku będą ostatnimi demokratycznymi wyborami w tym kraju. Nie ma przy tym znaczenia, która z opcji politycznych je wygra, gdyż w dłuższej perspektywie czasowej i tak liczyć będzie się tylko to, kto ma więcej mocy obliczeniowej. Internet miał być naszym oknem na świat, ale okazał się też oknem do naszych umysłów. Dziś przez to okno zaglądają zagrożenia, z jakimi żadne społeczności ludzkie nie mierzyły się w całej historii naszego gatunku.

Algorytm pozwalający na „widzenie przez ściany” zaprezentowany został pod koniec grudnia 2022 roku w pracy DensePose From WiFi. Należy on do dziedziny określanej jako „wizja komputerowa”, której głównym obszarem badań jest przetwarzanie obrazu przez komputer. Algorytmy wyspecjalizowane w wizji komputerowej potrafią wydobywać i analizować informacje pochodzące z danych obrazowych, dzięki czemu znajdują zastosowanie w wojsku czy medycynie. Omawiany algorytm w trakcie treningu „przygląda się” nagraniom wideo oraz zarejestrowanym w tym samym momencie sygnałom radiowym z sieci Wi-Fi. Dzięki temu jest w stanie nauczyć się zależności między tymi dwoma rodzajami danych, aby następnie odtworzyć obraz jedynie na podstawie sygnałów Wi-Fi.

Na podobnej zasadzie działają systemy pozwalające na „czytanie w myślach”. Algorytmy uczone są np. w oparciu o dane monitorujące aktywność mózgu w sytuacji, gdy ludzie patrzą na konkretne obrazy. Następnie są w stanie odtworzyć obraz, na który patrzy badany człowiek, mając do dyspozycji jedynie informacje o aktywności jego mózgu. Jestem pewien, że te technologie znajdą w przyszłości wiele ciekawych zastosowań, a wszystkim sceptykom radzę przypomnieć sobie, jak wyglądały pierwsze prototypy samochodów.

Opisane wyżej konsekwencje odnoszą się do sytuacji, w której zatrzymujemy dalszy rozwój SI. Oczywiście tak się nie stanie, ponieważ tkwimy w środku pułapki molocha i coraz szybciej pędzimy w kierunku nieznanego. Nasuwa się więc pytanie: czy rozwój SI jest w stanie zagrozić istnieniu całej ludzkości? Jest to oczywiście kolejny temat tabu, który do niedawna traktowany był jak fantazja niedojrzałych miłośników fantastyki. Poważni ludzie przecież nie rozmawiają o takich sprawach. Okazuje się jednak, że wśród szerokiego grona naukowców i specjalistów od SI panuje przekonanie, że taki scenariusz jest możliwy. Prawdopodobieństwo co prawda wciąż wydaje się bardzo niskie, jednak z pewnością nie wynosi zero.

Skupmy się teraz na dwóch potencjalnych scenariuszach takich wydarzeń. Pierwszy jest niezwykle depresyjny. Zakłada bowiem, że w toku dalszego rozwoju technologii budujemy systemy, które są niezwykle inteligentne i przejmują od nas kolejne kompetencje, ale nie posiadają żadnej formy świadomości. Wynikać może to z faktu, że świadomość i inteligencja nie muszą być ze sobą tożsame, a my po prostu możemy nie być w stanie lub nie chcieć zaimplementować tej pierwszej. Nie zmienia to jednak tego, że taki inteligentny zombie może nam się wymknąć spod kontroli w wyniku ludzkiego błędu lub złośliwego działania. Możemy też popełnić błąd w projekcie takiej SI i nie przewidzieć dalszych konsekwencji jej działania. Pamiętajmy, że wszystkie te systemy zmierzają do optymalizacji pewnej funkcji, a więc działają tak, aby w jak najbardziej efektywny sposób realizować swoje zadanie. Może nas więc załatwić przysłowiowy toster, który zasypie nas nieskończoną ilością grzanek.

Najbardziej chyba mroczną wizją takiej apokalipsy jest manga BLAME!, której autorem jest Tsutomu Nihei. Ludzkość traci w niej kontrolę nad sieciosferą (odpowiednikiem naszego Internetu), a tym samy nad niezliczoną liczbą sterowanych przez nią maszyn. System bezpieczeństwa, działający niczym system antywirusowy, zaczyna zwalczać ludzi, a pozbawione kontroli maszyny dalej wykonują powierzone im zadania i w nieskończoność rozbudowują infrastrukturę. Tysiące lat później prymitywne plemiona ludzi żyją w gigantycznym Mieście, które jest dalej budowane przez starożytne maszyny i obejmuje już cały Układ Słoneczny, tworząc groteskową Strefę Dysona.

Możliwości oddziaływania SI na różne społeczności świetnie pokazuje historia pewnego znanego w branży youtubera. Yannic Kilcher przygotował własną wersję modelu językowego, wykorzystując w tym celu dane z 4chana. Dane dobrane zostały w taki sposób, aby celowo łamały wszystkie możliwe zasady poprawności politycznej, co jest oczywiście przeciwieństwem wszystkich „zasad etycznych” stosowanych przy budowie takich modeli. Następnie Yannic wypuścił swoje dzieło, zwane GPT-4Chanem albo po prostu najgorszym modelem w historii, na forum, z którego pobrał dane. Efekty eksperymentu okazały się niezwykle ciekawe. Użytkownicy szybko zauważyli, że coś jest nie tak, gdyż bot wysyłał posty z lokalizacji na Seszelach w tempie zdecydowanie zbyt szybkim dla człowieka. Zrodziło to wiele teorii spiskowych, w myśl których tajemnicza aktywność z Seszeli była w istocie rzeczy tajną operacją CIA, Indii, rządu światowego itd. Sytuację podkręcały kolejne boty, które Yannic wpuścił na forum. Ostatecznie część użytkowników rozpoznała SI, a eksperyment został przerwany. Co ciekawe, model trenowany na 4chanie lepiej radził sobie w testach prawdomówności niż najbardziej dopieszczone na tamten moment wersje GPT.

Jakkolwiek dziwacznie by to nie brzmiało, współczesna SI zdaje się przypominać takiego właśnie inteligentnego zombie. Neuronaukowiec i psychiatra Giulio Tononi wskazuje na związek, jaki istnieje pomiędzy świadomością a charakterystycznymi strukturami znajdującymi się w mózgu. Specyficzna budowa mózgu ma pozwalać na stały przepływ sygnałów, tworząc coś, co w programowaniu nazywamy „pętlami”. Współczesne sieci neuronowe mają inną budowę, pozwalającą na przepływ sygnałów tylko w jedną stronę (feed forward). Może to oznaczać, że rozwijając klasyczną architekturę sieci neuronowych, nigdy nie będziemy w stanie zbudować sztucznej świadomości. Z drugiej strony byłby to dowód na to, że nawet tak złożone umiejętności, jak płynne operowanie wieloma językami, nie wymagają w ogóle udziału świadomości. Mogłoby to być szokiem dla wielu ludzi i wydaje się, że takie postawienie sprawy byłoby dla wielu nie do przyjęcia, ale każdy, kto w życiu zajmował się budową SI, wie, że inteligencja sprowadza się w zasadzie do przetwarzania informacji.

Drugi scenariusz apokalipsy wydaje się przynajmniej nieco ciekawszy. Zakłada on bowiem, że faktycznie stworzymy superinteligencję wyposażoną w świadomość. Wprawdzie współczesne algorytmy nie spełniają wymogów teorii świadomości Tononiego, choć znamy architektury, które potrafią tworzyć pętle (tzw. „sieci rekurencyjne”). Możemy więc wyobrazić sobie scenariusz, w którym rozwijamy dalej ten kierunek i na którymś etapie osiągamy sukces. Zresztą możliwe jest, że Tononi się myli lub też możliwe są inne rodzaje świadomości. W udzielonym niedawno wywiadzie legenda w dziedzinie SI – Geoffrey Hinton – wskazał, że wszyscy, którzy twierdzą, iż duże modele językowe nie posiadają świadomości, nie są nawet w stanie podać jej definicji. Niezależnie od tego, jaki rodzaj świadomości zyska SI i w jaki sposób się to stanie, pewne jest, że będzie to wówczas zupełnie obca nam istota.

Aby zobrazować sytuację znany badacz SI – Eliezer Yudkowsky – proponuje eksperyment myślowy porównujący superinteligentną SI do człowieka zamkniętego w pudełku na obcej planecie. Otaczający go obcy są głupi, ale też niezwykle wolni – jedna sekunda ich czasu trwa 100 lat dla więźnia. Jednocześnie dali mu dostęp do większości swoich systemów i infrastruktury. Niezależnie od tego, co więzień będzie chciał osiągnąć, będzie miał ogromną przewagę nad obcymi. Oczywiście w tej metaforze to my jesteśmy obcymi. Yudkowsky podkreśla w ten sposób, jak ogromne problemy czekają nas na polu dostosowania superinteligentnej SI do naszych celów (AI alignment). W przeciwieństwie do innych, kluczowych w naszej historii problemów naukowych, w tym wypadku mamy tylko jedną szansę na poradzenie sobie z tym zadaniem. Pierwszy eksperyment z uruchomieniem superinteligentnej SI, który zakończy się niepowodzeniem, będzie w opinii Yudkowskiego oznaczać kres całej ludzkości.

Nieco bardziej optymistycznie sytuację postrzega wspomniany wcześniej Max Tegmark. W jego ocenie problem dostosowania SI jest możliwy do rozwiązania, ale musimy wstrzymać się z pracami badawczymi przynajmniej na chwilę i musimy to zrobić teraz. W ten sposób uda się wyjść z pułapki molocha i znaleźć odpowiedź na pytanie, jak dobrać cel dla superinteligentnej SI, aby zachować nad nią kontrolę. Pod jego listem podpisał się między innymi Elon Musk, który wkrótce potem założył firmę Truth AI. Ma się ona zajmować budową SI, której zadaniem będzie „maksymalne poszukiwanie prawdy”, co można rozumieć jako optymalizację podawania prawdziwych informacji. Tegmark również wskazywał, że podobna forma falsyfikującej funkcji celu mogłaby być dobrym rozwiązaniem problemu kontroli silnej SI. Warto zauważyć, że nawet jeśli Musk ma dobre intencje i pomysł, to właśnie dołączył do wyścigu molocha.

Na koniec warto odnieść się do głosów sceptycznych względem SI i zagrożeń, jakie ta ze sobą niesie. Oczywiście nie chodzi tu o argumenty w stylu „SI nigdy nie dorówna ludziom, bo jest tylko maszyną”, gdyż te zwyczajnie nic nie znaczą i najczęściej są podnoszone przez osoby, które w życiu nie napisały nawet linijki kodu. Podobnie niewiele warte są twierdzenia, że SI nie ma emocji, intuicji czy innej magicznej cechy, która ostatecznie nie pozwoli jej osiągnąć ludzkiego poziomu inteligencji. Wszystko to są przejawy zwykłego antropocentryzmu i przypominają przekonanie o tym, że Ziemia znajduje się w centrum wszechświata, a Słońce krąży wokół niej, bo przecież to ono porusza się na niebie.

Na uwagę zasługują natomiast głosy ludzi, którzy swoimi badaniami wynieśli tę dziedzinę do jej obecnego poziomu. Kimś takim niewątpliwie jest Yann LeCun, który w rozmowie z Andrew Ng (również znakomity badacz SI) słusznie wskazał, jak wiele różni inteligencję algorytmu od ludzkiej. Dla przykładu posłużył się zagadnieniem autonomicznych samochodów, które są szalenie trudnym wyzwaniem badawczym, podczas gdy przeciętny nastolatek potrafi nauczyć się prowadzić samochód w kilkanaście lub kilkadziesiąt godzin. Jest to podejście, które mnie osobiście wydaje się bliskie, gdyż sam również zakładam, że za chwilę możemy trafić na jakiś niezwykle złożony problem, który zablokuje postęp w dziedzinie SI na kolejnych 50 lat. Mieliśmy już przecież w historii doświadczenie z takim okresem stagnacji, nazywanym „zimą SI”.

Wszystko to nie zmienia jednak faktu, że technologia, która już dziś jest dostępna, może przeobrazić nasz świat nie do poznania. Nie wiem, czy powinniśmy zatrzymywać badania na kilka następnych miesięcy, ale wiem, że powinniśmy natychmiast rozpocząć prace nad regulacją prawną SI. Potrzebuje tego nie tylko branża, ale i całe społeczeństwo.

Dziękujemy za przeczytanie artykułu.

Ustaw GRYOnline.pl jako preferowane źródło wiadomości w Google

127