Upscaling, generowanie klatek i ray tracing to najważniejsze technologie w nowych grach, a Black Myth: Wukong jest t...

Roslinność to jedno

Wy jak gracie to patrzycie na te wszystkie rzeźby? Zauważyliście że one bardzo rzadko sie powtarzają? Przecież tam jest tysiące modeli. Nie wiem czy jakakolwiek gra kiedykolwiek tak mało powtarzała tła. A w tej grze często nawet najdalsze elementy są też zrobione ze starannością. Których NIGDY nie obejrzysz z bliska, ale jak się zatrzymasz to widzisz że i one są zrobione dobrze.

Nie zgadzam sie. Te technologie to powody czemu deweloperzy nie marnuja pieniedzy na optymalizacje gier. Framerate generator doslownie powoduja potezny ghosting i input lag.

Jak widzę ten wysryw komentarzy i opinii na temat input laga i ghosting'u, to mi się śmiać chce i zarazem niedobrze się robi. Aktualnie opcja włączenia DLSS i FG automatycznie powoduje włączenie opcji Nvidia Reflex (i innych opcji), gdzie na rzetelnych testach masz jak byk pokazane, że masz wręcz mniejszy input lag niż przed włączeniem FG i tak jakbyś grał bez tych wszystkich bajerów. Więc te "wasze" bajki o niedorzecznym input lagu i ghosting'u możecie sobie wsadzić w buty. Następnym razem dowiedzcie się więcej na ten temat.

Podobno sprawa tyczy się opinii, że DLSS to "rozmydlacz", a FG to upłynniacz ruchu taki sam jaki był w telewizorach z XX lat temu. Dzisiejsza technologia DLSS jest tak rozwinięta (i rozwija się ciągle), że daje o wiele lepsze efekty i pozytywne wrażenia wizualne niżeli natywna rozdziałka bez tych bajerów. A FG to serii 40xx game changer (bez tego te karty byłyby g*wna warte) i daje o niebo lepsze obcowanie z grami i nie działa na zasadzie ww. upłynniaczy ruchu które już dawno były dostępne. Tylko ktoś sceptycznie nastawiony, z folią na głowie bojkotuje te technologie nie zagłębiając się nawet jak wyglądają w praktyce i jak się z nimi gra. Od już dobrego roku obcuje z tym wszystkim i gra mi się wyśmienicie.

I tak - twórcom należy się porządny ... gdzieś, za to, że zasłaniają się takim FG zamiast dobrze zoptymalizować grę. Tym bardziej, że w niewielu produkcjach widać jakiś postęp graficzny, a taki RDR2 dalej po już X latach zachwyca i nie odstaje od dzisiejszych standardów.

robertj25 Gram w 4K i dla mnie natywna rozdzielczość wygląda o wiele lepiej niż z DLSS. Chyba, że jakaś gra ma do bani zaimplementowane opcje antyaliasingu to wtedy DLSS wygląda lepiej. To jak twórcy zaimplementują DLSS w danej grze też jest chyba ważne, bo np. w RDR2 DLSS wygląda okropnie.

W Wukongu z czystym sumieniem mogę napisać, że nie widzę różnicy (może jakbym analizował każdy cm monitora) między DLSS Q, a natywną w 4k.

to ty masz cos z oczami skoro nie czujesz input laga po wlaczeniu frame gena. skad ty bierzesz te bzdury? 5 sekund szukania i masz tutaj pokazane jak frame gen muli: https://www.youtube.com/watch?v=CbG-N90UJ4I

ty w ogole nie ogarniasz ze nvidia reflex dziala tez jak nie masz frame gena wlaczonego? myslisz ze jak on wczesniej dzialal, przeciez to technologia starsza niz frame gen nvidii? typie xDDD nie znasz sie i jeszcze bedziesz z taka pewnoscia i wywyzszaniem sie pisal te farmazony. zalosny jestes.

Dla mnie to największe przekleństwo obecnego gamingu. Sam mam 4080S ale zdaje sobie sprawę że za chwilę ta karta nie będzie nic warta. Twórcy chyba specjalnie nie optymalizują poprawnie gier aby wykladac kasę na kolejne karty a rok po premierze karty i tak trzeba ratować się FG etc. aby wyciągnąć stabilne 60fps. Właśnie wtedy producenci chwala się swoimi technologami dzięki którym rzekomo masz 60fps a tym czasem to albonspecjalna zagrywka że strony wydawcy albo zwyczajna nieumiejętność/brak kosztów/czasu przy produkcji. Waszym zdaniem jest ok kiedy wychodzi jakąś śmieciową gra która wygląda jak gra z 2014 a śmiga tylko dobrze z włączonymi generatorami itp na 4090? Nawet Wukong powinien być lepiej zoptymalizowany

DLSS jeszcze ujdzie, ale Frame Generator to do kitu jest. FG tak psuje grafikę, że masakra. Jakieś artefakty, migające tekstury. Napisy powielające się nienaturalnie. A w dodatku z 45 fps zrobione 90 fps i nie czuję żeby było 90 fps. Obniżyłem detale w grze, wyłączyłem FG zrobiłem ok 60 fps i działało płynniej niż te pseudo 90 fps. Nie tylko w Wukongu ale w wielu innych grach mam te same doświadczenia z FG.

Bo to tylko wyświetla 90FPS, gra działa gorzej z samego założenia. Bo to nie dość że nie dodaje klatek grze (tylko samemu obrazowy), to jeszcze go dodatkowo opóźnia o klatkę, na czym traci responsywność. I całkiem możliwe, że liczba rzeczywistych klatek gry spada(tutaj ciężko to stwierdzić bez testów na ile to jest realne zjawisko, bo nikt takich testów nie zrobi, bo liczniki FPS dotyczą klatek wyświetlanego obrazu, a nie generowanych w grze).

Pokażcie gdzieś na YT te problemy wyraźne z FG.

Dzięki FSR+FG z kolei stare maszyny piękne ciągną np tą gierkę. Coś tu miga i jest porwane?

Procek 4 generacji! + dobry GTX I znów zabawa 60-100 fps na medium/high w 1080p. Ja tu nie widzę w grafie nic niepokojącego gdy FG wyciska z 30 fps - 60. Choć wg moich testów najlepiej zmniejszyć parę rzeczy na medium by nie spadało poniżej 70 fps.

Martwicie się o swoje mocne RTX w 1440p gdy my na GTX mamy nadal tony zabawy w 1080p. Why?

https://m.youtube.com/watch?v=46VaHKLJ2Lg&si=krfw4P-_P0Muznx2

Nie da się pokazać na YT poważnych problemów z FG. Przede wszystkim dlatego, że to nie Ty klikasz w przyciski, więc nie masz zielonego pojęcia z jaką prędkością działa gra i jaki ma input lag. Bo ewentualne artefakty (które pewnie i tak zabiłaby kompresja YT), nie przeszkadzają tak mocno, jak to, że gra działa gorzej (nie płynność obrazu, a płynność gry, która się odrywa od płynności obrazu przy FG).

Jeśli mnie pamięć nie myli, to jeśli przyśpieszymy sobie grę z 60FPS do 120FPSów, to input lag, jaki temu towarzyszy, wzrasta co najmniej do takiego, jaki by był przy 45FPSach (kwestia opóźnienia jednej klatki przy 120FPSach).

Oprócz tego gra może delikatnie stracić na FPSach (ze wzgledu na większe obciążenie GPU-gra nie obraz).

Ogólnie gra się w grę, a nie w obraz. To jest spora różnica. Jak strzelasz komuś heada w grze, to strzelasz w klatce gry, a nie w klatce obrazu (chociaż tutaj shootery dość mocno nas oszukują- nie byłby pewny czy zawsze to klatka gry).

Obraz z YT też ma stałe 60FPSów i do tej prędkości się go renderuje.

Jeśli nie wierzysz, weź sobie i ogranicz klatki w CSie do 30, po czym ogranicz do 60 i nagraj sobie obie rozgrywki i ślepym testem pokaż, który jest który ? W Grze na pewno wyczujesz. Po obrazie, nie będzie już tak łatwo, szczególnie jak wrzucisz na YT.

Chociaż i tak CS ograniczony do 30klatek nie będzie ta tragiczny, jak CS na komputerze, który generuje 30klatek bez ograniczeń. Bo klatki się będą przy Vsyncu dużo krócej renderowały i rzeczywiście będziesz czuć tylko przeskoki, podczas gdy input lag będzie zupełnie nieporównywalny.

Artykuł sponsorowany przez NVIDIA i wszystko jasne. Te technologie to o kant tyłka można potłuc.

Żadna kupa. Grałem z FG na 4090. Coś masz skasztanione w ustawieniach. Teraz każda gra wygląda jakoś tak biednie po Wukongu.

Gre przechodzilem w ustawieniu:

-> Nvidia RTX HDR on, w grze poziom jasnosci na zero. Reszte dostroilem w TV, a gram na C3 42".

-> rozdzielczość 4K

-> DLSS Q - max tam idzie ustawic 89%

-> FG on

-> ustawienia graficzne max czyli cinematic

-> RT max

ZERO problemów! Obraz żyleta. Spędziłem w grze ponad 100h.

Filmiki, te historyjki między aktami, cutscenki przed bosami i rozmowy z NPCami. Tu i tam zero problemów z napisami.

Każda gra która korzysta z tych technologii powinna być bojkotowana.

Z FG tak naprawdę nie jest aż tak różowo. Ta technologia wymaga mocy, więc trzeba poświęcić część na jej działanie. Dla przykładu macie 60 fpsów bez, więc można by oczekiwać, że z włączonym FG dostaniecie 90, ale tak nie będzie. Bo jak wspomniałem wcześniej, wymaga ona mocy, więc najpierw bez dodawania klatki to z włączonym FG z 60 spadnie np. do 50 czy może nawet 40. A więc przy dodawaniu klatek gra rzeczywiście będzie mieć 75 lub 60. W każdym razie na pewno fps nie zwiększa się o połowę.

A co do dlss to polemizowałbym. Nierzadko się zdarza, że wiele obiektów rozmywa się, a szczególnie tych ruchomych. To technologia wciąż daleka od ideału. To jeszcze nie jest niezawodna technologia, wciąż wymaga dużo do poprawienia, bo choć potrafi dobrze działać, tak jednak czasami nie.

RT to jest absolutnie technologia marketingowa. Ona ma na celu przede wszystkim oszczędzać pracę grafikom oraz budżet projektu. A więc celem nie jest nic innego jak szybkie i tanie stworzenie konkretnych elementów grafiki co oznacza też bylejakość i dlatego jest słabo zoptymalizowane i wymaga kupę mocy. Technologia też daleka od ideału, ale w sumie nigdy nie mogło być tak inaczej, bo to było od początku dla celów marketingowych. Ba, nawet potrzebuje do swojego działania sprzętu dedykowanego do tej funkcji jak karty z rdzeniami do renderowania RT, co tylko pokazuje poważne problemy z technologią.

To jak wytłumaczyć to video które teraz nagrałem. U mnie 50-70% na dzień dobry.

To samo w Tlou, z 30-50 fps cyka w okolicy 60-80 fps

https://www.youtube.com/watch?v=Dn0b5VeXlAk

Sponsorowany artykuł o niczym bez ważnych detali jak np:

Frame Gen NALEŻY używać mają przynajmniej na czysto 60fps (bądź więcej) inaczej ta technologia więcej szkodzi niż przynosi pożytku.

Co prawda piszę to AMD u siebie w swojej dokumentacji, ale dotyczy to również FG od Nvidia.

To w sumie antyreklama Nvidii. Jeśli FG jest niezbędny dla słabszych kart to na 3070 można tylko używać FSR. Mam 4070 i jedynie upscaling jest przydatny w tej grze. FG jest dobry jak się stoi w miejscu, a przy większym ruchu mam wrażenie że 60fps + vsync są o niebo lepsze. Co innego gdybym miał 40fps bez FG. RT nie widać w tej grze, bo nie ma prawie kałuż większość czasu. RT to dobry ficzer na remastery gier poprzedniej generacji i niżej.

Ale wy te Chińskie cudo z denuvo wielbicie.Twu.Chinom kompletnie nie ufam ich produktom jeszcze mniej,a rak denuvo,stop,niet

Qrwa serio... Chwalenie FG jest jak cieszenie się, że przecież nie ma sera w sklepie ale za to wczoraj dowiezli wyrób sero-podobny. Qrwa serio... RT nadal wymaga tyle mocy mocy obliczeniowej, że w stosunku do efektów jakie daje jest zwyczajnie mało opłacalne żeby nie powiedzieć, że po prostu nie ma sensu. Od początku istnienia i w miarę rozwoju RT aż do teraz, nadal nie rozumiem zachwytów nad tą technolgią, może gdyby wymagał 50-60% mniej mocy obliczeniowej to faktycznie byłoby czym się podniecać i warto w to iść. Generalnie w temacie RT jest takie "Nvidia ale to Ty dzwonisz", próbują to wciskać jak i gdzie się da ale raczej kiepsko idzie bo ludzie debilami nie są. Jedyne z czym się zgodzę to DLSS, które faktycznie jest na tyle dojrzałą technologią że robi różnicę dając dodatkowe klatki bez utraty jakości, a czasem nawet ją poprawiając.

Ulubione gamingowe skróty ostatnich lat to dlss, fsr i dei :)

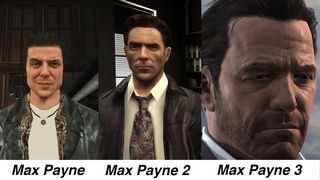

Mam w wielkim poważaniu te nowe technologie, poproszę mi z powrotem zacząć robić postacie tak jak w pierwszej części Max Payne a nie tak jak poszło to dalej bo to jest kupa. To wszystko tylko wymaga dużo mocy obliczeniowej a widać że można było mieć dobry obraz na słabych kartach, wystarczy to teraz polepszyć na nasze czasy i mamy grafikę jak w filmach która działać będzie na każdym dzisiejszym ziemniaku bez zająknięcia.

Szkoda mi czasu i kasy już na te wszystkie karty graficzne i związane z nimi skróty. Mam wrażenie, że ostatnio rynek za mocno ciśnie w stronę wysokobudżetowych sprzętów, a gry-online ewidentnie bierze w tym udział. Oczekuje się od nas graczy, że będziemy wyskakiwać z pieniędzy na każde zawołanie i pod wręcz pewną presją, aby doświadczyć "współczesnego grania". To ja już wolę cieszyć się swoim skromnym handheldem wszędzie tam gdzie pojadę, niż trzymać w pokoju świecącego na kolorowo potwora za kilkanaście/kilkadziesiąt tysięcy PLN. A na te wszystkie innowacje i wodotryski zaczekam może, aż granie w chmurze całkiem się upowszechni.