Złe czasy dla kart graficznych AMD. Ich sprzedaż spadła o ponad 50 procent

Tak tylko chce cos dopowiedziec, bo wiele ludzi pisze jakies bzdury typu "moja karta to nie piekarnik, ma tylko 70 stopni". Nie wazne jaka karta ma tempereture, a ile wydziela ciepla. Karta, ktora pobiera 200W bedzie wydzielac wiecej ciepla od karty 100W chocby miala nawet nizsza od niej temperature. Po prostu jest na niej zastosowane lepsze chlodzenie lub wiatraki chodza na wiekszych obrotach.

Podam przyklad: karta 230W majaca temperature 60 stopni wydziela wiecej ciepla do otoczenia niz karta 100W majaca 80 stopni.

Nie dziwi mnie to. Karty AMD to piekarniki biorące dużo prądu i jedyne co przemawia na ich korzyść to duża ilość VRAMu wkładana nawet w tańsze modele podczas gdy Nvidia skąpi VRAM i żeby mieć te 16GB musiałem kupić kartę za 4 tysiące. Ale wydajność energetyczna kart Nvidii, kultura pracy no i przede wszystkim technologie typu DLSS czy Frame Generation które AMD stara się co najwyżej kopiować z marnym skutkiem sprawiają, że jeśli ktoś ma kasę na droższą kartę to zawsze wybierze Nvidię. Nie wspominając już o kompatybilności ze starymi grami, Radeony ciągle mają jakieś problemy które trzeba rozwiązywać nieoficjalnymi patchami.

Może kiedyś się ogarną, tak jak jeszcze kilka generacji temu nie było powodu żeby rozważać coś innego niż procesory Intela, to teraz trzeba być głupim żeby wybrać coś innego niż procki AMD, które są bezproblemowe i biorą o połowę mniej mocy niż Intele, a AMD wspiera jeden socket przez wiele lat więc pewnie jeszcze dwie generacje Ryzenów w przód będzie można wsadzić do AM5.

Skoro ceny są podobne jak Nvidii to po co kupować AMD? Brak DLSS, problemy ze stabilnością, mniejszy prestiż. Jak chcą sprzedawać to muszą obniżyć ceny o 20%, wtedy miałoby to sens.

mniejszy prestiż

właśnie większy, skoro użytkowników AMD jest mniej to mogą się okrzyknąć elitą.

Podobne? A czemu nie powiesz, że Radeony są tansze, bo dalej są. To amd patrzy na rynek 24/7 i czeka, żeby obnizyć cene swoich alternatyw dla Nvidia. Jak wyszla 4080S , to cena 7900XTX została obniżona tak, że wszedzie jes tansza o 200zł albo 100$, co czyni tą karte zajebisty dealem z tym że ma 24GB VRAM. Pozdrawiam ludzi co maja 16GB VRAM jak już gry zjadaja 14GB VRAM :) "BRAK DLSS" FSR3 nie odstaje od DLSS preset Jakość, a do tego mamy INTEL XeSS, ktore jest dosłownie prawie identyczne jak DLSS i ma lepszą wydajność od FSR. "mniejszy prestiż" AHA. "Jak chca sprzedać to musza obnizyc ceny o 20%" ty nie masz pojecia o rynku GPU, nie?

I co ci z 24 GB w Radeonie jak ma mniejszą wydajność nawet od GeForce RTX z 8 GB

Użytkownicy Linuksa akurat wybiorą kartę tej marki, która jest lepiej wspierana na ten system. W tym przypadku wybór jest oczywisty...

Użytkownicy Linuksa akurat wybiorą kartę tej marki, która jest lepiej wspierana na ten system. W tym przypadku wybór jest oczywisty...

Intel? 2024/2025+ Nvidia?

https://www.youtube.com/watch?v=yBfME4VIVk8

Zobaczy się jak będzie, ale na razie pod tym względem nadal wygrywa AMD.

Z tego co słyszałem/czytałem NVidia niby jakiś czas temu coś tam otworzyła jeśli chodzi o specyfikację, ale podobno potem wycofała się z tej inicjatywy.

NVidia w takim wypadku musi albo otworzyć specyfikację kart/sterowników przynajmniej w takim stopniu, jaki zrobiło to AMD, albo sami wziąć się ostro za stworzenie naprawdę dobrze i wydajnie działających sterowników do Linuksa(pytanie, czy lepiej X, czy Wayland).

Dlatego 13 i 14 generacja sie pali i crashuje pcty, a 7950x3d jest uzywane do testowania 4090 xD Kolejny baran. O jakich problemach z ryzenami mowisz? jestem na prawde ciekawy, kurcze, jakie to są problemy z ryzenami.

W tym roku przesiadłem się ze starego i5-8600k na nową platformę z Ryzenem 7600x. Zero problemów, świetny procesor, pobór prądu w porównaniu z równorzędnymi intelami o połowę mniejszy. W dodatku potencjał do rozbudowy na dobre kilka lat w przód bo AM5 jeszcze długo pożyje.

Kurde. Zastanawiam się jak to jest, że mój "piekarnik" 6700xt bierze maksymalnie 170 watów w stresie w nowych grach, a temperatura GPU teraz w lecie, przy 30sto stopniowym upale w domu, dochodzi do 70 stopni Celsjusza? Ewenement na skalę światową.

Gadanie ludzi siedzących na Nvidi od lat nie posiadających AMD od lat. Ja w zeszłym roku zmieniłem Nvidie na AMD i mój 7900 xtx nie pobierał więcej niż 230 watów.

Przecież 6700XT to low end, wydajność 4060 RTX który jest tak naprawdę RTXem 4050 w przebraniu.

Oficjalnie Radeon-220W, 4060 RTX-115W. Prawie 2x większy pobór prądu przy tej samej wydajności.

Maxxgroo porównanie 3 letniej karty z nowsza generacja smierdzie fanbojstwem albo głupotą, wybierz sam.... 6900xt 280wat max nigdy nie przekroczyla 75 stopni zazwyczaj 68.

To porównajmy obceną generację.

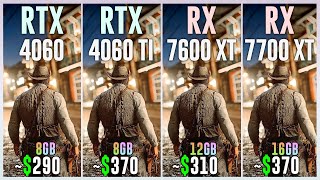

7600XT bierze 190W maks, wydajnościowo jest równy 4060RTX.

190W vs 115W przy tej samej wydajnosci, a ty mówisz o fanbojstwie i głupocie?

Zanim zaczniesz pisać z agresją dobrze byłoby żebyś miał rację

MaxxGroo

Pokaż mi te równość ale bez DLSS oczywiście między RX7700Xt vs RTX4060

Bo ja tu widzę że RTX4060 karta dostaje srogie Baty

https://youtu.be/UA6XCwzB7Fc

Tak tak. Kocham do gdakanie zielonych fanboyów Nvidii. "nie ma sensu radeonów brać" W miedzyczasie 7900xtx z wydajnoscia 4080super i wieksza iloscia VRAM jest o 200 zł tanszy od 4080SUPER. "sterowniki są chujowe" a no tak bo nvidia nie ma tragiczny sterowników, to pewnie dlatego forum nvidia jest zajebane tematami o crashe, stuttery, lagujacy geforce experience, dziwne problemy z wiatrakami w gpu. Nvidia wali w kakao swoch klientów, a oni sie jeszcze z tego cieszą. RT jest bezuzyteczny nawet na 4080 jak ledwo masz 60fps z DLSS balanced, ale "kupuje nvidia bo ray tracing" a potem taki adaś czy maciuś nawet nie odpala tego albo wyłącza bo nie da sie z tym płynnie grać. Jako 10 letni fan nvidia do 2020 roku, moim zdaniem Nvidia leci już tylko na renomie, nostalgii i ślepym fanboystwie swoich klientów. Dlatego z roku na rok rożnica wydajnosci karta znacznie spada, a cena rośnie. Kolega w pierwszym komentarzu pisze o PALĄCYCH radeonach. Mam dziadka RX6800 kupionego 2 lata temu, do tego wersja zwykła sapphire. Ani razu nie przekroczyła ona 70 stopni, a mielismy dni po 32stopnie w czerwcu. No, ale to tylko typowe gadanie fanboyów niebieskich i zielonych korporacji, ktorzy maja budżetkówki pokroju 3060, 4060 albo i nawet 1080/1660, a gdakają sobie jakie to radeony są chujowe. Zostaliscie mentalnie w 2017. Współczuje

mam 7900 xtx i sterowniki raz mi crashneły na naszym polskim cp 2077

Jako 10 letni fan nvidia do 2020 roku, moim zdaniem Nvidia leci już tylko na renomie, nostalgii i ślepym fanboystwie swoich klientów.

AMEN

Obydwie firmy są do bani. Jak tylko AMD zaczęło się lepiej powodzić (procesory) zaczęła traktować klientów gorzej.

NVidia znowu z zewnętrznych względów zaczęła traktować klientów trochę lepiej (celują w biznes a on sobie nie pozwala, do tego problemy z research)

A że porównując sprzęt NVidia wypada lepiej, to ludzie ją kupują (co zresztą potwierdzają wykresy - nie wiem o co pienią się fanboje czerwonych kiedy sprawa jest oczywista).

A zanim jakiś fanboj z mlekiem pod nosem, zarzuci mi fanbojstwo konkurencyjnych firm - dekadami siedziałem praktycznie tylko na sprzęcie AMD/ATI, bo nie podobały mi się praktyki konkurencji a glosuje portfelem,

ale skoro postanowili bawić się w rekiny, to zamiast płakać niech pływają szybciej...

A i jescze jakby ktos chcial opowiadac bzdury o tym jakie złe sterowniki ma amd to pare lat temu jakas firma to sprawdzała :

https://www.benchmark.pl/aktualnosci/qa-consultants-amd-oferuje-stabilniejsze-sterowniki-graficzne-niz.html

Uff, dobrze, że to sprawdzili, dzięki temu, że przeczytałem co tam piszą w magiczny sposób na moim RX 6800 XT przy setupie 2 monitory o różnych refresh rate'ach przestało 2-3 dziennie wywalać sterowniki przy minimalizowaniu/maksymalizowaniu okien, dzięki!

Nie dziwię się, bo przestali konkurować z nVidią.

Miałem 3 Radeony gdy ATI/AMD było na propsie...

Nie przestali tylko NVIDIA się wycwaniła i wszystko robi na Licencji

Kiedy Nvida zaczęła dominować wtedy ATI było na Upadku AMD przejęło firmę ale zanim zaczęły Radeony konkurować Nvida miał już Physix.

Dziś podobne jest z CUDA

mimo że da się obejść nieoficjalnie i AMD też może z tego korzystać i to nawet bardzo dobrze to niestety trzeba to wgrywać i mordować

NVIDIA jest już zbyt potężna firma.

AMD miała swoje technologie jednak nie przebije się bo konkurencja jest większa i to ona wyznacza trendy.

Tak było w przypadku AMD TressFX

NVIDIA jest zbyt dużym molochem i może sobie robić co chce.

Dlatego AMD nie będzie miało też zamkniętych standardów a NVIDIA tak.

Nie przestali tylko NVIDIA się wycwaniła i wszystko robi na Licencji

Kiedy Nvida zaczęła dominować wtedy ATI było na Upadku AMD przejęło firmę ale zanim zaczęły Radeony konkurować Nvida miał już Physix.

Dziś podobne jest z CUDA

mimo że da się obejść nieoficjalnie i AMD też może z tego korzystać i to nawet bardzo dobrze to niestety trzeba to wgrywać i mordować

NVIDIA jest już zbyt potężna firma.

AMD miała swoje technologie jednak nie przebije się bo konkurencja jest większa i to ona wyznacza trendy.

Tak było w przypadku AMD TressFX

NVIDIA jest zbyt dużym molochem i może sobie robić co chce.

Dlatego AMD nie będzie miało też zamkniętych standardów a NVIDIA tak.

Gadasz o czasach zamierzchłych - Nvidia zawsze tak robiła a AMD robiło swoje i sobie radziło (okresowo świetnie, zwłaszcza podczas krypto)

Do tego, sytuacja obecnie jest praktycznie odwróciła - AMD nie implementuje otwartych standardów latami wymuszając zakup nowego sprzętu za premium, w przeciwieństwie do intela i nvidi części komponentów nie dostarcza samodzielnie tylko bierze darmowe (co samo w sobie nie jest złe, ale jak pojawia się problem to mam nagle latać za jakimś przypadkowym kolesiem który kodzi jakiś projekt po pracy za frajer - i się "domagać" bo zapłaciłem AMD a oni się nie poczuwają?)

Znowu z drugiej strony NVidia podobno otwiera sterowniki, a jest przecież jeszcze intel (który akurat pod tym względem otwartych standardów bije AMD).

Jeśli idzie o potencjalne zakupy, to pomijając może najnowsze APU (gdybym szukał integry) AMD jest u mnie dosłownie na ostatnim miejscu....

Karty AMD to piekarniki biorące dużo prądu

Nie wiem jak to było kiedyś (moja poprzednia karta to był geforce 210 i 1030 a amd wówczas nie próbowałam) ale 6600 Eagle w porównaniu do 3060 (które według wielu żródeł to odpowiednik półki wydajnościowej od Nvidii) jest następujące:

-100W na max(amd) vs 180-190 W (nvidia)

-temperatury to stabilne 68-69 stopni gdy gpu jest maksymalnie obciążone podczas lata (bo temperature w pokoju też ma znaczenie)

Nie wspominając już o kompatybilności ze starymi grami, Radeony ciągle mają jakieś problemy które trzeba rozwiązywać nieoficjalnymi patchami. O dziwo miałam tylko sytuacje gdy to windows 10 uniemożliwiał mi granie w starsze tytuły niż gpu , np Prototype 1 i 2

I co ci z 24 GB w Radeonie jak ma mniejszą wydajność nawet od GeForce RTX z 8 GB to byłaby prawda ale tylko gdy dany rtx ma szybszą pamięc. Ogólnie to dla gier i programów które wymagają dużo VRAM'u nadal lepiej będzie mieć więcej GB (ale to oczywiście zależeć będzie od programu ,ile wymaga ,bo może być tak jak mówisz i 8 GB wystarczy,ale może i nie)

Ale cóż.. mi tam nie potrzeba grać w więcej niż 1080x1920 , DLSS, RTX to tylko bajer. Plus dla mnie to ile karta pobiera jest nadal dosyć ważne wiec nvidia i lepsze karty od amd -nope , szczególnie z tymi cenami prądu.A ci co narzekają na AMD i tak będą narzekać. Ja tam aktualnie amd lubie ale kto wie jak to będzie za parę lat jak gpu będę zmieniać..może nvidia..może intel a moze amd

Ja mam Rx6800 i zrobiłem Undervolting karta pobiera mniej prądu niż GTX1070 którego poprzednio miałem

A przy tym jest wydajniejsza.

Mam kilka profili

Na jednym mam tak że przy wiedźminie 3 karta pobiera 110 Wat oczywiście z drobną stratą na wydajność z rzędu około 5% .

Tutaj przykład na trochę mocniejszej karcie

Gościu zrobił Undervolting bez straty i z 280W karta brała 210W

https://youtu.be/2oUfXyHFO88

Widzę zielone fanboye w natarciu. Żałośni jesteście.

Żałosny jesteś ty - ołowiane klapki na oczach normalnie, AMD najzwyczajniej w świecie się sprzedało. Zaślepiła ich kasa a teraz ponoszą konsekwencje...

Mówisz do goscia w który w swoim życiu miał 5 kompów z czego 3 z Nvidią i dwa z ATI/AMD

Przebijam twoje 5ke 10tką :p (było więcej ale nawet nie mam jak zliczyć) - jeśli idzie o moje diversity ;) to intel, amd, ati, s3, nvidia, via, (matrox - kojarzę coś, ale to mógł być inny sprzęt (peryferia rozszerzenie czy coś)), ppc i coś tam jeszcze było na 286/386'tkach, cyrix (chyba ze oprócz cyrixam amd czy intela było coś jeszcze - to wtedy to nie był cyrix tylko to). O tym co się przewinęło w nowszym sprzęcie nie mam pojęcia bo na specyfikacje patrze tylko podczas zakupu (no i sami często mieszają).

Generalnie wielu ludzi zetknęło się (pozytywnie) z AMD dopiero przy okazji ryzena i dla niektórych z nich było to doświadczenie praktycznie religijne... (a korporacyjny fanatyzm nie jest jakoś szczególnie zdrowy)

No i co z tego? Mam 7900 xt i nie zamieniłbym go na żaden odpowiednik z żydvidii xD Więcej pamięci, tańszy niż 4070 ti, wydajniejszy. RT? Włącz PT w CP2077 albo Alan Wake 2, to Nvidia zrzyga się tak samo jak AMD ?? Przy normalnym RT gram i nie mam żadnych problemów.

Dla użytkownika Linuksa karta NVidii raczej nie będzie pierwszym wyborem - chyba, że NV w PEŁNI otworzy specyfikacje swoich kart, tak jak zrobiło to AMD, albo przynajmniej zaczną sami porządnie wspierać RTXy na ten system.

Dzięki temu, że AMD udostępnili pełną specyfikację danych kart graficznych Radeonów, deweloperzy systemów linuksowych mogą sami wspierać je w systemach Linuksowych, tworząc porządnie działające sterowniki.

Tak tylko chce cos dopowiedziec, bo wiele ludzi pisze jakies bzdury typu "moja karta to nie piekarnik, ma tylko 70 stopni". Nie wazne jaka karta ma tempereture, a ile wydziela ciepla. Karta, ktora pobiera 200W bedzie wydzielac wiecej ciepla od karty 100W chocby miala nawet nizsza od niej temperature. Po prostu jest na niej zastosowane lepsze chlodzenie lub wiatraki chodza na wiekszych obrotach.

Podam przyklad: karta 230W majaca temperature 60 stopni wydziela wiecej ciepla do otoczenia niz karta 100W majaca 80 stopni.

Podam jeszcze jeden przyklad dla opornych: Od czego sie zrobi cieplej w pokoju po 30 minutach ? Od zapalniczki, z bardzo wysoka temperatura, ktora pobiera malo gazu, czy grzejnika, ktory ma o wiele nizsza temperature, ale nagrzanie go zuzywa znacznie wiecej gazu ?

Czy teraz widzicie jaka to jest glupota, ktora pisaliscie ?

Może nich jeszcze bardziej podniosą ceny - sprzedaż się polepszy znajdą więcej nabywców.

Śmieszne kiedy gracze myślą, że to oni mają jakiekolwiek znaczenie dla rynku AMD xD

Że Nvidia sponsoruje nawet takie chamskie artykuły i to wprowadzające w błąd to już jest bezczelne...

Dawno nie czytałem artykuły, w którym autor nie ma tak bardzo pojęcia o czym pisze. AMD samo na spotkaniach z inwestorami powiedziało, że sprzedaż serii 6000 i 7000 rok do roku znacznie wzrosła, a sprzedaż układów do konsol drastycznie spadła z powodu zmniejszonego zainteresowania konsolami po 5 latach od premiery i zapowiedziach nowych wersji konsol. No, a w artykule napisane, że sprzedaż Radeonow drastycznie spadła i być może sprzedaż układów do konsol ich uratuje jak jest dokładnie na odwrót. Wystarczyło 5 minut reaserchu, ale lepiej wyciągać wnioski z tyłka i powielać bzdury.

Zbychu nie obraź się, ale wróć lepiej do pisania rzeczy, o których masz pojęcie, jak np. "Nie wiem, jakim cudem opłaca im się sprzedawać Samsunga Galaxy Z Flip6 blisko o 2000 zł taniej...". ;P

Albo jeżeli chcesz pisać, to rób to rzetelnie. Nie zmyślaj własnej historii do obrazka, to nie matura z języka angielskiego, żebyś opisywał, co widzisz na obrazku. ;) Nie musisz snuć swoich domysłów, czym jest to spowodowane, bo to zostało powiedziane przez AMD. Sprzedaż układów spadła, bo spadła sprzedaż konsol. Sprzedaż detaliczna dla graczy jest niemal taka sama.