Forspoken ma horrendalne wymagania sprzętowe; 30 fps na RTX 3070

Deweloperzy kiedyś: Zoptymalizujemy grę pod słabsze podzespoły aby jak największa baza graczy PC mogła zagrać!

Deweloperzy dzisiaj: Szkoda czasu na optymalizację gry, gracze już dawno powinni się zaopatrzyć w najnowsze RTXy, może nawet Nvidia nam coś sypnie za boost sprzedaży!

Widzę optymalizacja gier to już dawno i nie prawda teraz nastał nowy trend chcesz grać w 30 FPS ? to zapierdalaj do biedry po RTX 4090 może gra ci pójdzie.

Znamy już potencjalnego kandydata na crap roku z półki AAA.

Powtórka z Babylon's Fall będzie, ta gra wygląda jak za czasów gier na PS3, optymalizacja zero, niech te Square Enix wreszcie padnie ma pysk, a resztki wykupi MS i po robocie.

Wymagania do 1440p i 30 FPS xD

Kto tak gra?

Co za dzban wymyślił podawanie wymagań pod takie ustawienia obrazu.

Ja jestem bardziej zdzwiony, że podali wymagania dla 720p, a nie dla 1080p.

Za to w 4K podali już dla 60 fpsów, i dali RTX4080 - co można skwitować tylko XD

No 1440p jest podane, by nie podawać 1080p. Bo wychodzi, że trzeba tam z 20GB ramu i dość mocnej reszty sprzętu. Można sobie wyśrodkować dane z 720p i 1440p, bo 1080p to 2x wiecej pixeli niż 720p i 2x mniej, niż 1440p.

20GB ramu dla 1080p mogłoby lekko szokować...

1080p to 2x wiecej pixeli niż 720p i 2x mniej, niż 1440p

Wracaj do podstawówki powtórzyć tabliczkę mnożenia...

Zastanów się dłużej, zanim coś napiszesz.

Nie jest to co prawda dokładna liczba, bo gdyby było 1018p, to by idealnie wychodziło 2x tyle pixeli w 1 i w 2, ale 1018p nie ma, a 1080 nie jest tak daleko od 1018...

720p=921600pixeli

1080p=2073600pixeli

1440p=3686400pixeli

4k=8294400pixeli.

No 1440p jest podane, by nie podawać 1080p.

Ale co to za pokraczna logika wydawcy? 1080p to jest najpopularniejsza rozdzielczość wśród graczy, a 720p ma mniej niż 1% graczy (wg steama). Nikt już nie podaje takiej rozdzielczości w wymaganiach, bo prawie nikt takiej rozdzielczości nie używa.

Na ue5 bedzie schodzilo ponizej 40 fps na 1440p dopiero gdy wrzucisz se quality very high przy graniu na rtx 3070.

Te wymagania są idiotyczne i chodzi mi o ich wysokość tylko w jakim świecie RX 6800 XT ma podobną wydajność co RTX 4080 i to że 6700XT jest kilka procent mniej wydajny niż 6800XT i jest do 30fps w 1440p a 6800XT już jest do 60FPS w 4k

"Karta graficzna: AMD Radeon RX 6800 XT 16GB / Nvidia GeForce RTX 4080 16GB"

hahah

Widzę optymalizacja gier to już dawno i nie prawda teraz nastał nowy trend chcesz grać w 30 FPS ? to zapierdalaj do biedry po RTX 4090 może gra ci pójdzie.

Deweloperzy kiedyś: Zoptymalizujemy grę pod słabsze podzespoły aby jak największa baza graczy PC mogła zagrać!

Deweloperzy dzisiaj: Szkoda czasu na optymalizację gry, gracze już dawno powinni się zaopatrzyć w najnowsze RTXy, może nawet Nvidia nam coś sypnie za boost sprzedaży!

RTX 3000 istnieli na rynku od bardzo dawna. Ale deweloperzy zapomnieli, że z różnych powodów te karty graficzne były straszne drogie i bardzo trudne do zdobycia przez kilka lat. Nawet w tej chwili są nadal drogie dla przeciętne graczy. Chyba żyją w innym świecie...

Seria RTX 2000 jest na rynku już 5 lat ziomuś powinni optymalizować gry pod te właśnie karty nie wiem czego oczekujesz od 7 letnich grafik , poza tym faktycznie do duże wymagania do tej konkretnej gierki.

Dobrze czytałem. RTX 4080 jest potrzebny tylko do 4K, jak twórcy podali wymaganie sprzętowe. RTX 3000 są wystarczające, by móc grać Forspoken płynnie na dobre ustawienie graficzne, choć tylko na 30 FPS (minimum dla grywalność). Chyba to oczywiste? ;)

RTX 4000 są zbyt młode na rynku, żeby wszyscy gracze to mają. 4K + 60 FPS + Ultra to nadal luksus tylko dla nieliczni, a 1080p i 1440p to nadal standard dla przeciętni gracze, jeśli chodzi o PC. Mylę się?

16GB bieda RAM jest tanie... ale za 32GB dobrych to chyba z 700-800 zł trzeba dać? Kiedyś to był prawie cały CPU... Teraz, jak się uprzesz na jakieś i5 czy R5, to też...

Herr Pietrus - Jak przyjdzie kupić pozostałe podzespoły to tanio.

Przecież te wymagania są złe. RTX 4080 jest prawie 2 razy lepszy od RTXa 3070, wiec gdyby to były dobrze podane wymagania, to RTX 3070 powinien ogarnąć 4K w 30 klatkach, a nie 1440p.

W dodatku czemu w 1440p i 30 klatkach wymagany jest znacznie lepszy procek niz 720p i 30 klatkach?

Te wymagania robione chyba na oko, bo tu nic nie ma sensu.

Wygląda na to, że gra ma dość duży narzut na CPU. Denuvo może być współwinnym... I przy 720p po prostu dłużej liczy się na CPU (GPU zostaje mniej czasu na wyświetlenie klatki), a przy 4K, co jest rozdzielczością 8x większą, CPU musi być mocniejsze, bo 4080 może nie być 8x mocniejszy od 1060. Przez co CPU musi szybciej liczyć, by GPU nadążał generować 30klatek.

Wbrew pozorom te wymagania mimo, że nienormalnie wysokie, kogoś poniosło z modelami do gry prawdopodobnie. To mają trochę sensu.

Jest RT pod postacią cieni z ghostingiem, wyglądają gorzej niż bez RT.

Szykuje się 20 goty Alexa w 2023.

I ten NVMe w 4k. Pewnie dodaje 30 fps

Samo NVMe ma zakres dolny od zwyklych ssd sata więc nic tu nie wnosi

Żeby oni chociaż te gry z mega wymaganiami ładne robili, jak pierwszy Crisis AD2023 ale ta tutaj wygada bardzo przeciętnie jak nie słabo, najwyżej jak gry z PS4 z początków generacji

Sporo...

Widzę też, że 32 GB RAM to już nowy standard od niedawna.

x

Znamy już potencjalnego kandydata na crap roku z półki AAA.

Każdy wybierze 1080p 60 zamiast 1440p 30, a 32 GB RAM to dziś standard, więc kompletnie nie rozumiem napisanych wymagań pod takie dziwne ustawienia

a 32 GB RAM to dziś standard

Łoł łoł stary zwolnij od kiedy to się zrobił standart?

Dopiero co Returnal miał w rekomendowanych, a to było w grudniu 2022r. więc standard wszedł w grudniu 2022r.?

https://www.digitaltrends.com/computing/returnal-might-be-first-pc-game-to-recommend-32gb/

SquarEnix i kiepskie porty pecetowe to chyba jakiś nierozerwalny duet. Nawet FFVIIR na UE4 nie jest idealny.

Grałem w Forspoken demo na PS5 i ta gra to porazka ze strasznie pustym swiatem, ciekawe czy naprawia RT bo w demie ustawiajac RT gra była niegrywalna z góra 20fps-ami. Chociaz widze w wymaganiach, ze o RT nie ma nawet wzmianki to moze w ogole z tego zrezygnowali xD

Jeśli chodzi o tereny i krajobraz to graficznie to Elden Ring, więc nie wiem na co idą te wymagania? Na powiewanie pelerynki głównej bohaterki? Zresztą pomiędzy trybem jakości, a wydajności na PS5, to nie odczułem jakiejś wielkiej różnicy.

Z taką grafiką?!

I wy śmiecie pluć na Ubisoft? :) To są mistrzowie branży - tylko fabularnie i gatunkowo "trochę" się pogubili, ale pod względem mechaniki i technikaliów będzie ich bardzo brakowało. Ba, już brakuje, ze względu na to, że porzucili tyle dobrych marek...

Po namyśle stwierdzam, że to musi być jakiś japoński trolling albo to ich specyficzne poczucie humoru. Może oni w styczniu jakiś Septimus Decimus Ianuarius obchodzą?

No Ubisoft ma niezłą grafikę i niewiele poza tym.

Może lepiej, żeby animacje zaczął robić.

;]

Takie wymagania to powi ien być wstyd i dyshonor dla developerów, że taki szajs ludziom chcą sprzedawać.

Zalecany hardware do 1440p i 30 fps jest ok 30-50% wydajniejszy od paystation5 na którym ta gra będzie działać pewnie lepiej.

Na drzewo z tą grą i jej developerami. Jak mają takie partackie badziewie wydawać to niech lepiej nic nie wydają.

Tylko, że na PS5 będzie działać na low z teksturami high i może coś tam na medium, a tu pewnie są ustawienia high.

Te 4K to zapewne ultra, 720p (very) low.

Wymagania jak wymagania, nie odbiegają od obecnego standardu.

Problem widzę jedynie w tym, że są one tutaj najwidoczniej marnowane, bo ta gra jest zwyczajnie brzydka.

Ale cóż, GPU nie ocenia czy to co ma wyrenderować jest ładne czy nie, tylko renderuje co jej każą. Jak jakieś studio nie ma skilla w grafikę od strony artystycznej to tak się to kończy.

Jest wiele głupot/absurdów w tych wymaganiach, ale serio podanie minimalnych dla 720p i 30 fps w 2023 roku XDDD Cofamy się do ery x360 i ps3, nie mogę z tego.

Powód jest prostu i aż dziwi, że tego ludzie nie rozumieją, bo dokładnie taka sama sytuacja była z tym Harrym Potterem co też teraz ma wyjść.

Podają wymagania minimalne do 720p, bo jakby podawali do 1080p to by się odcięli od tej całej rzeszy potencjalnych klientów, których komputer kosztuje obecnie mniej niż sama gra, a ani myślą o żadnym upgradzie. Tak to sobie odpalą w 720p, może z jakimś FSR i wydawca zadowolony, że sprzedał grę i gracz zadowolony, że komputer "odpala wszystkie gierki jak leci" już 12 rok od zakupu.

Po samym tutejszym forum zobacz ile ludzi jeszcze tu myśli, że 1060 to wciąż jest karta do grania w nowa gry.

Problem w tym, że ja na 1070 grałem np w asasyna valhallę w 1440p na średnich ustawieniach spokojnie mając 40-60 klatek. A oni zalecają trochę słabszą kartę do 2x niższej rozdzielczości i ledwie 30klatek. Jeśli te wymagania się sprawdzą to będą jaja bo żeby ta gra graficznie wygląda na nową generację to bym zrozumiał, że kilkuletnia karta ze średniej półki nie wystarczy do 1080p 30fps, ale jak to wygląda jak wygląda to tym gorzej dla tej gry.

Zapomniałeś tylko o jednym małym szczególe. Valhalla to już ponad 2-letnia gra.

Nikt ci wymagań do gier wydanych 2 lata temu nie zmienia, więc jak chcesz to graj sobie w te stare gry i wszyscy będą zadowoleni.

Komiczne jest tylko to wielkie zaskoczenie, że nowe gry nie działają już dobrze na prawie 7-letniej karcie ze średniej półki.

A to, że akurat ta gra wygląda jak nieszczęście nie zmienia faktu, że z każdym rokiem wymagania rosną i tak było zawsze i tak będzie zawsze.

Zapomniałeś tylko o jednym małym szczególe. Valhalla to już ponad 2-letnia gra.

Taa, tylko że wygląda 2x lepiej od Forspoken i ma o wiele żywszy świat... Nie pomyślałeś, że może jednak lepiej oceniać wymagania sprzętowe przez pryzmat oprawy graficznej i złożoności mechanicznej, a nie wieku gry? Nowsze musi z automatu oznaczać bardziej sprzętożerne, choćby nawet nie było dla tego żadnego uzasadnienia?

rlistek -> napisałem wyraźnie, że jakby ta gra robiła robotę pod względem graficznym to nie miałbym problemu z wysokimi wymaganiami, ale jak prezentuje się to co najwyżej przeciętnie i powiedziałbym, że gorzej od valhalli no to sorry, ale tym gorzej dla forspoken i rok wydania gry nic tu nie zmienia. Niech wymagania rosną, ale razem z tym idzie poprawa grafiki a nie regres jak w forspoken.

Ale już o tym pisałem - to, że jakieś studio ma słabych grafików nie wpływa na wymagania. Wymagania mają gdzieś czy coś się komuś podoba czy nie. Te są dostosowane do użytej technologii i sprzętu który jest na rynku.

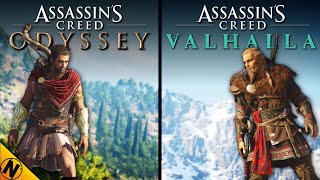

No i teraz wróć sobie i porównaj wymagania tej Valhalli (2020) z wydanym dwa lata wcześniej Odyssey (2018).

Jak ci się nie chce szukać to przykładowo:

minium:

Odyssey - GTX 660 2GB

Valhalla - GTX 990 4GB

Za to GTX 1080 daje nam takie ustawienia w tych grach:

Odyssey - 4K High

Valhalla - 1080p High

I co teraz na to powiesz? Że Valhalla "wYglĄdA 4 rAzY lEpieJ" niż Odyssey?

Czy wam się to podoba czy nie, wymagania gier nieubłaganie rosną z każdym rokiem i tak było od zawsze.

Czepiać się takich wymagań gry AAA w 2023, to trochę brzmi jak płacz i lament, że zabytkowy sprzęt nie odpala nowych gier i to, że akurat ta gra jest brzydka nic tu nie zmienia, o czym pisałem wyżej, nie będę się powtarzał.

rlistek -> mam wrażenie, że trochę sam sobie przeczysz. To mogę zjechać grę za słabą grafikę, ale nie mogę zjechać gry za zawyżone wymagania względem oprawy? Rozumiem, że jakby forspoken wyszedł za 2 lata z taką samą grafiką jak teraz i w wymaganiach miałby rtx3080 to będzie normalne bo to gra z 2025? Niech ta gra wymaga mocniejszego sprzętu od valhalli jak się trzymamy tego przykładu, ale niech wygląda od niej chociaż trochę lepiej a nie gorzej, o to mi chodzi. Trudno zaakceptować gorszą grafikę a wyższe wymagania tylko dlatego, że to gra z 2023 roku.

Powtarzam, niech nowe gry zrzucą kaganiec starych konsol i starego sprzętu, ale żebym zauważył przy okazji jakiś skok jakości a nie spadek jak w tym przypadku. Nie oczekuję, że 2x wyższe wymagania dadzą 2x lepszą jakość cokolwiek miałoby to oznaczać bo wiadomo, że to nie możliwe, ale jednak jakiegoś progresu myślę można oczekiwać a takiego forspoken nie pokazuje.

Myślę po prostu, że dyskutujemy nie do końca o tym samym. Zgadzam się z tym, że nowe gry mogą mieć wysokie wymagania względem tych starszych i jest to jak najbardziej normalne, ale dla mnie nie tłumaczy to sytuacji forspoken bo ta gra wygląda przeciętnie i to jak na standardy nie roku 2023 a gry sprzed 2 czy nawet 4 lat.

Albo mogliby no wiesz, zoptymalizować porządnie swoją grę? Wtedy też by nie ograniczali sobie bazy potencjalnych klientów.

Po samym tutejszym forum zobacz ile ludzi jeszcze tu myśli, że 1060 to wciąż jest karta do grania w nowa gry.

No bo taka jest prawda, tylko gra musi być zoptymalizowane. W 2022 roku było co najmniej kilka nowych gier, które śmigały na 1060 spokojnie na wysokich w 60 klatkach.

Komiczne jest tylko to wielkie zaskoczenie, że nowe gry nie działają już dobrze na prawie 7-letniej karcie ze średniej półki.

A to, że akurat ta gra wygląda jak nieszczęście nie zmienia faktu, że z każdym rokiem wymagania rosną i tak było zawsze i tak będzie zawsze.

No tylko, że właśnie tak nie powinno być. Postępu graficznego nie widać, nowe gry nie wyglądają wcale lepiej niż gry sprzed 5-7 lat więc czemu nie miałyby spokojnie działać na 5-7 letnich kartach? Tym bardziej jeżeli wychodzą na 10 letnie konsole.

No ale to jest właśnie problem ludzi nie mających pojęcia o tworzeniu oprogramowania i ich niezrozumienia skąd się biorą wymagania sprzętowe.

Jeśli w 2007 wyszła by gra, która korzystałaby z dokładnie tej samej technologii i rozdzielczości assetów co Crysis, tylko była robiona przez kogoś kto ma krzywe oczy i nie potrafi zrobić nic ładnego, to i tak by miała takie same wymagania. To czy model albo tekstura o takiej i takiej rozdzielczości jest ładna czy nie, karty graficznej nie interesuje. Jak i jedną tak i drugą wyświetli tak samo szybko.

Jeśli gra ma zarówno wymagania gry AAA jak i jej cenę, ale już grafika zdecydowanie odbiega od współczesnych standardów to należy się hate za grafikę.

Jakby to była gra indie za 100zł to wtedy taka grafika byłaby do przyjęcia, ale można by hateować wymagania.

A to co ja tu czytam w tych postach to w większości jest płacz, że nowe gry AAA nie działają już za dobrze na 7-letnich Pascalach, bo dokładnie ten sam płacz nie występuje tylko w temacie tej gry, ale to samo było właściwie w każdym temacie o wymaganiach nowej gry AAA w przeciągu kilku ostatnich miesięcy, niezależnie czy gra wyglądała tak brzydko jak ten Forspoken czy tak ładnie jak A Plague Tale: Requiem.

Postępu graficznego nie widać, nowe gry nie wyglądają wcale lepiej niż gry sprzed 5-7 lat więc czemu nie miałyby spokojnie działać na 5-7 letnich kartach?

Przeskok graficzny w ostatnich 5 latach jest OGROMNY, tylko no właśnie, ty na swoim pascalu już go nie zobaczysz.

"pOstĘpU grAfIcZnEgO nIe WidAĆ" to standardowe hasełko powtarzane przez zakompleksionych ludzi bez sprzętu, żeby sobie mogli złagodzić ból tyłka, że niby "nic nie tracą".

Ale już o tym pisałem - to, że jakieś studio ma słabych grafików nie wpływa na wymagania.

Ale "graficy" (rozumiani jako ludzie odpowiedzialni za tworzenie modeli, animacji, tekstur, materiałów itd.) nie odpowiadają za niedostatki samej technologii. Dzieła wychodzące spod ich ręki mają z reguły bardzo wysoką jakość, dopiero później są odpowiednio "przycinane", żeby silnik mógł je udźwignąć. Nie wspominając o tym, że lwią część roboty w całej oprawie graficznej robi oświetlenie, a ono leży w gestii przede wszystkim programistów, nie artystów.

Wymagania mają gdzieś czy coś się komuś podoba czy nie. Te są dostosowane do użytej technologii i sprzętu który jest na rynku.

Owszem, ale w granicach zdrowego rozsądku. Jeżeli masz grę, która wygląda jak z wczesnego PS4, a w minimalnych do 1440p / 30FPS dajesz RTX 3060, to znaczy, że robisz coś bardzo nie tak w kwestii zarządzania pamięcią i mocą obliczeniową. Poza tym wymagania dostosowuje się do DOMINUJĄCEGO na rynku sprzętu, a nie wyłącznie topowego.

I co teraz na to powiesz? Że Valhalla "wYglĄdA 4 rAzY lEpieJ" niż Odyssey?

Nie wiem czy 4 razy, ale z całą pewnością wygląda o wiele lepiej. Przede wszystkim ma dużo więcej detali i dodatkowych efektów, które może trudno wychwycić gołym okiem, ale mają one zauważalny wpływ na ogólną prezentację gry. Ma też większy zasięg rysowania i niższą degradację jakości obiektów na dalszych planach:

https://www.youtube.com/watch?v=5FWOmZRQyF0&ab_channel=Nick930

Czy wam się to podoba czy nie, wymagania gier nieubłaganie rosną z każdym rokiem i tak było od zawsze.

Tak, ale wraz z nimi musi rosnąć też jakość grafiki. Jeżeli tak nie jest, wina leży po stronie developerów.

Obejrzałem to porównanie, po czym od razu gameplay trailer Forspoken. Technologiczna różnica między Forspoken a Valhallą jest nie mniejszą niż między Valhallą a Odyssey.

I jest dokładnie odwrotnie niż to co mówisz. Forspoken jest brzydkie pod względem artystycznym, nie technologicznym.

Największą bolączką są zdecydowanie animacje i bardzo słabej jakości modele postaci. Do tego dochodzą te komiczne wręcz projekty map.

Z technologicznego punktu widzenia mapy są wyraźnie lepsze niż w Valhalli, są ujęcia w tym trailerze, gdzie poziom detali, ich ilość i zasięg rysowania są bezsprzecznie większe. Problem w tym, że zostały one tragicznie zaprojektowane przez "artystów".

W Forspoken masz masę tych efektów cząsteczkowych, które znów - technologicznie z osobna trzymają poziom, aczkolwiek jest tam nimi taki spam - znów, decyzją "artystów", że to wygląda niczym wiejski festyn.

Takich efektów cząsteczkowych w AC praktycznie nie ma wcale, a takie rzeczy bardzo mocno podbijają wymagania.

W Forspoken rzuca się jeszcze w oczy kwestia oświetlenia, które zwyczajnie ssie, ale nie ma co się oszukiwać, żadne oświetlenie bez RT GI+AO nie wygląda już ładnie. W AC pod tym względem też lepiej nie jest, aczkolwiek ze względu na nieporównywalnie lepiej zaprojektowany świat gry, nie rzuca się to aż tak w oczy.

Gra ssie artystycznie, ale dla GPU nie ma już najmniejszego znaczenia. Od strony technologicznej wymagania są jak najbardziej na miejscu.

Inna sprawa, że po obejrzeniu teraz tego gameplayu to ja nie wierzę, że oni chcą to sprzedawać jako AAA za pełną cenę. Gra artystycznie na tle innych współczesnych gier wygląda niczym dawno temu wydawany Technomancer przy ówczesnych jemu grach. Z tym, że ten Technomancer to była niemal indie gierka za ułamek ceny gier AAA.

Technologiczna różnica między Forspoken a Valhallą jest nie mniejszą niż między Valhallą a Odyssey.

Nie chcę być złośliwy, ale założyłeś okulary przed oglądaniem?

I jest dokładnie odwrotnie niż to co mówisz. Forspoken jest brzydkie pod względem artystycznym, nie technologicznym.

Największą bolączką są zdecydowanie animacje i bardzo słabej jakości modele postaci. Do tego dochodzą te komiczne wręcz projekty map.

No właśnie absolutnie nie, bo brzydota assetów użytych w grze ewidentnie wynika z ich bardzo niskiej jakości. Nie z dobranej kolorystyki czy ogólnej estetyki, bo to już zależy od gustu, tylko z obiektywnie słabej jakości (niskiej rozdzielczości tekstur i małej ilości poligonów w modelach). Przygotowując takie assety na potrzeby gry, zwykle opracowuje się najpierw obiekty w bardzo wysokiej jakości (znacznie wykraczającej poza możliwości sprzętu), a potem się je skaluje w dół, w zależności od kontekstu użycia w danej scenie.

Zresztą, nawet jeżeli przyjmiemy, że to artyści z jakiegoś powodu dostarczyli assety w tak niskiej jakości, to powinno to mieć bezpośredni wpływ na wydajność gry, a tym samym wymagania sprzętowe. Nie wspominając o tym, że gra ma bardzo słabe oświetlenie, cieniowanie i wygładzanie krawędzi obiektów, czyli znowu, wszystko to, co jest domeną programistów, nie artystów.

Z technologicznego punktu widzenia mapy są wyraźnie lepsze niż w Valhalli, są ujęcia w tym trailerze, gdzie poziom detali, ich ilość i zasięg rysowania są bezsprzecznie większe.

A co niby świadczy o ich technologicznej "lepszości"? I w którym miejscu Forspoken ma większy zasięg rysowania niż Valhalla?

W Forspoken masz masę tych efektów cząsteczkowych, które znów - technologicznie z osobna trzymają poziom, aczkolwiek jest tam nimi taki spam - znów, decyzją "artystów", że to wygląda niczym wiejski festyn.

Jeżeli efekty cząsteczkowe zażynają wydajność i nie da się tego w rozsądny sposób zoptymalizować, to powinno się je po prostu przyciąć (ograniczyć). Artyści nie mają w tej kwestii nic do gadania.

Gra ssie artystycznie, ale dla GPU nie ma już najmniejszego znaczenia. Od strony technologicznej wymagania są jak najbardziej na miejscu.

Nie są, bo niska jakość assetów (technologiczna, nie artystyczna) nie usprawiedliwia takich wymagań sprzętowych. Nie jestem profesjonalnym developerem, ale umiem programować na tyle, że byłem w stanie napisać własny silnik 3D (a właściwie kilka iteracji tego samego silnika, w różnych językach i w oparciu o różne biblioteki oraz architekturę), więc wiem co nieco o optymalizacji i wydajności. Wystarczy zrobić podstawowe profilowanie dowolnej sceny, by zobaczyć jak bardzo czas klatki różni się przy assetach w niskiej i wysokiej jakości (zwłaszcza ilość wierzchołków robi kolosalną różnicę). Jeżeli do wyświetlania takiej rozmytej brei w 30 klatkach twórcy oczekują RTX 3060, to gdzieś musieli popełnić poważny błąd.

przy takich wymaganiach pewnie jeszcze będą pretensje do graczy, że gra się słabo sprzedała

i7 do 720p ? to chyba pomyłka albo kiepski żart

Jaki i7? Spójrz jeszcze raz. Ten procesor ma ledwie 4 rdzenie i wyszedł przeszło dekadę temu.

RTX 4080 obok RX 6800 XT. Ciekawe zestawienie. Przecież te karty dzieli przepaść.

Przyjęli min. 16GB do 4K, a ze pierwsza od dolu karta Nvidii z 16 GB vram to 4080, wiec wyszlo "troche" nieproporcjonalnie.

Ciekawe ilu narzekajacych na wymagania zamierzalo faktycznie zagrac. Demo nie urwalo dupy ani redakcji "Forspoken jest tak nudne, jak myślicie" ani Alexowi a to juz bardzo zle wrozy ;)

A gdzie jest ten system nanite z UE5, co miał płynnie podmieniać obiekty w tle i powodować, że wymagania sprzętowe będą niższe?

Gra nie działa na UE5, a na tym samym silniku co FF15

Te technologie zdecydowanie nie będą powodować, że wymagania sprzętowe będą niższe tylko, że gry będą wyglądać ładniej.

to czekajcie na minmalne wukonga jak tamta gra ma być tylko i tylko pod 4090 reszta kart nie istnieje.

Granie stało się dla bogatych. Wychodzi na to żeby pograć w najnowsze gry to będzie trzeba kupić komputer za 10 000zł i to minimum.

Masz Xboxa SX za 1800zł jak się pojawia promka na kupony. Nie trzeba wydawać 10k na pc.

No trzeba, tylko te twoje oczekiwania są wielokrotnie większe niż to co oferują konsole. Nic zatem dziwnego, że koszt takiego PC też jest wielokrotnie większy.

Granie na najwyższych ustawieniach to nigdy nie była tania zabawa. Od tego właśnie są konsole i komputery oferujące podobne ustawienia.

Spokojnie. Na screenie widać że chodzi o GTXy a nie RTXy. Więc w sumie ma małe wymagania xD

Gra na PS5 w trybie wydajności wygląda jak średnio ładny i mocno rozmyty tytuł z PS4 z tragicznym rysowaniem obiektów i paskudnie wyglądającym dalszym planem. Rozdzielczość spada do 900p. W trybie jakości jest trochę lepiej i prezentuje się jak średniak na PS4 Pro w 30FPS.

Optymalizacja będzie skandaliczna, tego jestem pewny. Nie kupuję na pewno, bo demo było niesamowicie nijakie, a główna bohaterka to jedna z bardziej irytujących postaci jakie widziałem.

a kogo to obchodzi ? przecież to gniot po pierwsze nie warty złotówki aby go kupić a już na pewno nie warty czasu aby z tym spędzić (zmarnować).

Klasyczny giotek od Ubi taki 5/10 dla niedzielnego gracza co obejrzy trailer i pójdzie do marketu wydać z nudów te 70euro następnie rzuci pudełko w kont / albo już zostanie ta cudowna cyfra na koncie ;) jak będzie bardziej nierozgarnięty to nawet twórcy zarobią bo kupi jakąś skórkę dla tej *upki biegającej i czarującej ;)

Mi wszystko jedno, może mieć nawet 4090 do minimalnych, w ogóle mnie ta gra nie interesuje, ale to trochę wstyd, bo niby co tam ma takie wymagania? Efekty? Gęsta trawa? Cienie? RT?

Gdzie to demo można pobrać?

Rekomendowane 24 GB RAM? Obawiam się że o wiele więcej radości dadzą gry, które do pełni szczęścia wymagają 24 MB RAM.

Coś w tym jest. Na starym kompie mam H3, Desperados, Original War, Lula The Sexy Empire, Stronghold Crusader, Blade of Darkness, FM2022, a obok RDR2, GTA, Cyberpunki, Total Wary, a najlepsze to, że sobie poklikuje właśnie na tym starszym kompie.

RDR2 to jest stara, ponad 4-letnia gra.

10-letnie GTA V to już w zasadzie zasługuje na miano retro gierki.

Miałem się kłócić, ale faktycznie, grafika na tym filmiku nie wygląda jakoś fenomenalnie, a twarze to kompletna porażka. Wiem, że zawsze można lepiej grę zoptymalizować, chociaż do tego potrzeba więcej czasu, kasy a i pewnie zdolniejszych ludzi. Wiem też, że zawsze to będzie temat kontrowersyjny, bo gra może być dobrze zoptymalizowana, a jednak mieć wysokie wymagania, co dla niektórych jest tożsame. Aż przykro się patrzy na te trend... czyżby deweloperzy chcieli zniszczyć rynek gier? Czy to jakaś konspiracja przeciwników cyfrowej rozrywki, którzy od lat zarzucają grom brutalność, ogłupianie ludzi, marnowanie czasu. Bo innego wytłumaczenia nie widzę.

A przy obecnym kryzysie i chorych cenach gpu, większość graczy porzuci swoje zamiłowanie do gier. Nawet, jeśli pociągniemy na minimalnych, albo będziemy grać w starsze tytuły, to sprzęt się zużywa i w końcu nadejdzie ten dzień, gdy odmówi posłuszeństwa. Zakup zamiennika będzie wiązał się z koniecznością wzięcia kredytu na 10 lat lub... nieco mniejszego kredytu, na zdobycie używki z koparki. Cóż za okropne czasy.

Nauczcie się mojego sloganu

Wymagania gier wzrastają wraz z premierą nowych podzespołów

cO tY gAdAsZ, gTx 1o6O tO jeSt KaRtA nA kTóREj móŻnA grAć We WSzYStkO, A jAk nIe móŻnA tO zNAcZY, Że DeWElOpER nIe UmIe w OpTYmAlIZacjĘ, cHociAż nAwEt nIe WiEm cO tO sŁOwO znAcZY!!

Wymagania z kosmosu a grafika nie zabija oczu zajebistością. PL nie ma, nie kupię nawet za 30zł :E

Ja w 2007 roku: Kupuję monitor 1680x1050 60 FPS.

Twórcy Forspoken w 2023 roku: Optymalizujemy grę pod 1280x720 i 30 FPS.

Podoba mi się jaki ból dupy ludzie mają że ich GTX 1060 6GB tylko 720p 30fps XDDDD jak dla mnie gra ma dobre wymagania i że tyle ramu... No w końcu pojawiają się te 32GB ram i to normalnie nawet mnie nie dziwi w tych czasach to powinna już być norma w każdym pc...