Hej!

Jak zobaczyłem RTX 4090 to nie mogłem uwierzyć. Takie duże bydle z tej karty. RTX 3080 Ti również nie należy do małych, ale jak sobie porównałem z RTX 4090 to prezentuje się dosyć skromnie. Zresztą sami zobaczcie.

Wait - what?

To na pewno ten sam raziel, który jeszcze niedawno pisał, że nie może sobie pozwolić na kupno nowej konsoli i wymianę swojego TV 720p przez żonę i kredyt, a teraz nagle wyjazd z dwiema (prawie) najdroższymi kartami ze swoich serii i telewizorem z HDR?

Czyli taki Gęstochowa też może mieć majątek Alexa, a my tylko możemy czekać, aż sam się nam objawi.

A tak to wygląda w obudowie.

Pograłem sobie i trzeba przyznać, że karta bardzo wydajna. Świetnie sobie radzi z rozdzielczością 4K. Swoją drogą 3080 Ti również spisywało się znakomicie, choć osiągało gorsze wyniki. Jednakże nie są to różnice widoczne dla ludzkiego oka.

Test odbył się na Assassin's Creed: Valhalla w 4K z wszystkimi opcjami na full. HDR na porządnym telewizorze miażdży SDR.

Zrobiłeś upgrade z 3080ti na 4090? Nie żałujesz biorąc pod uwagę że 3080ti i tak daje ze wszystkim radę?

Ta laska przypomina mi widok bebechów jednego pieca, gdzie ktoś wcisnął papier między kartą muzyczną a pasywnym chłodzeniem starej karty graficznej w ramach czekania na nowy model by móc swobodnie cisnąć w Soldier of Fortune 2...

Masz rację. Ja wolę wymienić karta graficzna za tylko 1000-2000 zł co 2-3 generacji, a nie za prawie 10000 zł... Jestem szczęśliwy z RTX 3060 i mogę pograć nawet w Plague Tale 2.

Ale to jego wybór. Mam nadzieję, że wie, co robi i nie wziął duże pożyczki od banku.

Wait - what?

To na pewno ten sam raziel, który jeszcze niedawno pisał, że nie może sobie pozwolić na kupno nowej konsoli i wymianę swojego TV 720p przez żonę i kredyt, a teraz nagle wyjazd z dwiema (prawie) najdroższymi kartami ze swoich serii i telewizorem z HDR?

Czyli taki Gęstochowa też może mieć majątek Alexa, a my tylko możemy czekać, aż sam się nam objawi.

Witam w gronie prawdziwych PCMR, nie jakiś biedaków co mają karty poniżej 10k (/s oczywiście).

Przeskok ogromny, sam wymieniłem ze zwykłej 3080 i nowe funkcje miażdżą - szczególnie Frame generator. Polecam do testów jeszcze Plague Tale - tam już zaimplementowane są wszystkie nowe funkcje 4 generacji RTXów.

nadal nie ma dodanego RT do Plague Tale i nie zapowiada się aby to się szybko zmieniło. Najważniejsza funkcja to moim zdaniem to co będzie za miesiąc czyli Nvidia RTX Remix AI

Rozumiem, ze na serii 3 mogę zapomnieć?

Remix dotyczy tylko starszych gier (chyba że coś przegapiłem), więc dla mnie mogłoby go w ogóle nie być - ale może spowoduje, że młodsze pokolenie sięgnie po starsze klasyki.

Remix ma być dla każdej karty obsługującej DLSS. RTX4XXX mają na wyłączność Frame Generator, Reflexa i DLSS3.0.

nie jakiś biedaków co mają karty poniżej 10k (/s oczywiście)

/s znaczy sarkazm, dobrze trafiłem? ;P

Remix ma być dla każdej karty obsługującej DLSS. RTX4XXX mają na wyłączność Frame Generator, Reflexa i DLSS3.0

Jakoś to mnie nie boli. To tylko dodatkowe klatki na sekund, a nie unikalne efekty graficzne. Dopóki mogę grać przykładowy Plague Tale 2 na 1080p Ultra z dobre płynności (jeśli tylko 30-40, nie 60 FPS) czy przyszły Hogwart Legacy, to mogę jeszcze żyć z RTX 3060. Nadal jestem zachwycony ray tracking w przykładowy Cyberpunk 2077 (po rozstaniu z ukochany GTX 1060), a także mogę grać w Elden Ring z ponad 60 FPS.

Nie chcę marnować 10k złotych na RTX 4090, bo wiem, że później czy prędzej tak będzie RTX 5090, 6090, 7090 i tak dalej. Takie są zagrywki NVIDIA. I tak będzie RTX 4060, RTX 5060 i tak dalej, który można ograć we wszystko z ponad 60 FPS.

RTX 4090 ma sens tylko dla tych, co chcą grać na 4K. Po to jest do tego stworzony. 4K to luksus nie dla każdego (jeśli mowa o tylko nowe gry AAA).

To zależy od gusta, potrzeby i ... zasoby portfeli gracza. Niech raziel88ck się cieszy z tego, co ma i życzę dużo szczęścia.

Dokładnie, punkt widzenia zależy od punktu siedzenia. Dla mnie RTX4090 to był mus, bo posiadam ogromny monitor wielkości dwóch 27 calowe używany zarówno do pracy, jak i gier. RTX3080 dławił się bez DLSS w nim, szczególnie w nowych grach. To też nie jest karta dla graczy, tylko dla największych zapaleńców.

I tak, /s to sarkazm, bo osobiście życzę każdemu graczowi aby rynek podzespołów upadł i sobie głupi ryj rozwalił, a RTX5090 kosztował z 3 koła.

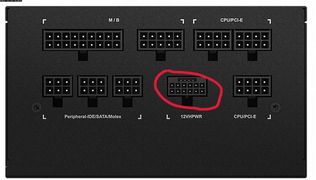

musi być podpórka inaczej wygięło by mobo / karta jednak sporo waży ten gamerock fajnie się prezentuje, gratuluję zakupu ! kabel jednak jest zawinięty dodatkowo widzę że nie zmieniłeś zasilacza na gigabyte (obecnie jedyny który ma kabel do karty na 12vhpwr) to jednak bym go wyprostował bardziej przy wtyczce do karty i zobaczył czy przejściówki nie powyginane. Dodatkowo sprawdź czy power limit możesz przesunąć powyżej 100% czy masz zablokowany bo jak zablokowany to przejściówka do wymiany.

Jeśli ktoś pyta czy zmiana z 3080ti na 4090 ma sens to jest mniej więcej taka sama jak z 3090 na 4090 bardziej można powiedzieć techniczna jeśli nie grasz w gry VR na porządnych googlach np. pimaxach w 4K lub nie planujesz grać w 8K. Będzie parę gier którym 4090 pomoże jak np. Cyberpunk 2077 czy Kingdomcome Deliverance(i chyba to wszystko na ten moment), bo o ile będą gry 4K które 4090 pociągnie w 120fpsach o tyle już różnica pomiędzy 65 fps na 3080ti a 105 na 4090 to już bardziej sztuka dla sztuki. Szczególnie że nie jest to przysłowiowa przepaść (jak w 8K) że masz 25fpsów i nie grasz a masz 60fpsów i grasz jak było w przypadku wprowadzenia serii 2080Ti po 1080Ti dla 4K.

Teraz tylko podpiąć całość pod porządny TV z wyśrubowany HDR albo neoqled 8K z indexem 3000-4000cm/m2 albo nowy sony/samsung na qdoledzie jak sony / samsung + dobre nagłośnienie i można grać.

Jak nic na Callisto Protocol zdążyłeś :):):)

Mówił, że dokupił kabel pod RTX 4090, aby nie bawić się w adaptery.

zasilacz jest b. dobry ale niestety nie ma jednego kabla ten ma tylko w jedynym obecnie na rynku gigiabyte 1000W sam go zamówiłem właśnie z tego powodu i robię przesiadkę z TT1475 na G1000 ale że jedne GPU to 1000W wystarczy.

Ten Gigabyte bardzo srednio wypada. Poza nowym kablem i gniazdem nie błyszczy.

https://www.techpowerup.com/review/gigabyte-ud1000gm-pg5-1000-w/

Najtrudniejsze są obciążenia przejściowe 180% i 160%, ponieważ trwają one znacznie dłużej, odpowiednio 1 ms i 10 ms, a w tych testach zasilacz wyłączał się przy każdej podjętej przeze mnie próbie. To sprawia, że UD1000GM PG5 jest niezgodny ze specyfikacją ATX v3.0

Lepiej kupic adapter 90 stopni od cablemod (ma byc tez wersja 180 stopni) i poczekac na wysyp porzadnych zasilaczy, ktore spelniaja standard ATX v3.0. Przepinac wszystko dla tego srednio udanego zasilacza to przerost formy nad trescia.

https://store.cablemod.com/cablemod-12vhpwr-right-angle-adapter/

Albo zamowic np. Seasonic Vertex z dostawa przed swietami.

https://proline.pl/zasilacz-seasonic-vertex-gx-1200-80plus-gold-1200w-p8115664

Data dostepnosci: 14-12-2022

Jest jeszcze dostepny "od reki" odpowiednik tego Gigabyte od MSI MPG A1000G PCI-E5 (nowy kabel i gniazdo +12VHPWR, ale zasilacz tez bez pelnego wsparcia ATX 3.0 "compatible only"), ale tu tez warto poczekac na MSI MEG Ai1000P i Ai1300P, ktore wypadaja rewelacyjnie w testach.

https://www.amazon.pl/dp/B0B434DB7Y/ref=cm_sw_r_cp_apa_i_V04D58QKDW64D5F0AWB1

Jutro premiera Thermaltake GF3 (na razie tylko 850W). Sprzedaz przez amazon z oficjalnej dystrybucji.

https://www.amazon.pl/dp/B0BF5SYZX6/ref=cm_sw_r_cp_apa_i_F1YHAYRZEFX6V0KY9QS6

Jeszcze chwila i rynek bedzie zalany nowymi PSU. Moim zdaniem z tym Gigabyte niepotrzebnie wysprzęgliłes sie.

Godfire - na Seasonic za dużo czekania ;) poza tym wszystko co napisałeś sama prawda. Gigabyte to średniak ale jak to się mówi na bezrybiu i rak ryba ;)

3080Ti w pelni starcza do VR w 120 fps przynajmniej na Q2 ze skalowaniem 200% lub Pimaxie 8KX bez skalowania w 90 fps

Ten komputer należy do kuzyna. TV to 43 calowy Samsung Neo QLED 4K QN91B (2022).

https://www.samsung.com/pl/tvs/qled-tv/qn91b-43-inch-neo-qled-4k-smart-tv-qe43qn91batxxh/

A oto mój "potwór". GeForce GTX 770 DirectCU II OC.

Taaa, czysta porażka inżynieryjna.

Za tę cenę wolę obie konsole i tv.

Bo wturwia mnie rozmiar i cena tego badziewia? To tak, jestem konsolowcem.

A mojego 6 letniego kompa z 1050TI trzymam dla strategii/rpg i filmów/seriali :D

Konsole na których nie ma za bardzo w co grać (w stosunku do kosztów) i TV w którym nic ciekawego nie ma.

Słaby deal...

może być potwór, byle miał otwór

może być bydle, byle..nie wiem

Tak, teraz to sobie możesz...

Widziałem Twoją wcześniejszą wypowiedź i będę z Tobą szczery. Pochwaliłbym się w prosty sposób. Coś w stylu: "Nareszcie kupiłem nowy komputer!"

Zdjęcia z bananem zrobiłbym specjalnie dla Was itd.

Na przeglądarce w telefonie, faktycznie nie widać opisu edycji postu Qverty, ale na kompie już jest.

Moja wcześniejszą wypowiedź była nie na miejscu i przepraszam za nią.

Byłem po prostu zawiedziony, że raziel, człowiek który na tym forum jest symbolem retro nagle porzucił swoją tożsamość. Na szczęście okazało się, że wszystko jest na swoim miejscu.

Jak będziesz miał chwilę, to może przeprowadzisz teścik https://www.gry-online.pl/S043.asp?ID=16074446&N=1

Ciekawe jak RTX 4090 w 4k czy 1440p wyjdzie

Ładna karta i gratulację, ale co z kabel 12-pin? Czy jest nowy i pewniejszy niż wadliwy poprzednik, który kiedyś spalił port prądu z powodu wysokie temperatury? Ostatnio było głośno. Pytam to dla Twojego dobra.

Nie ma czegoś takiego jak nowy czy stary kabel 12-pinowy.

Nvidia i AIB nie wypuścili nowej wersji adaptera. To adaptery się niekiedy palą.

Na zdjęciach widać, że do karty podpięty jest przewód bez adaptera, bezpośrednio z PSU - czyli bezpieczne rozwiązanie, gdzie do tej pory nie było (jeszcze) przypadku spalenia.

Tym lepiej dla niego. Nie obejrzałem niektóre zdjęcia wcześniej.

micin3 jest nowy pojedynczy kabel bez adaptera jest to 12vhpwr i będzie dostępne w przyszłych nowych zasilaczach obecnie jest tylko jeden taki na rynku

Nie rozumiem zbytnio, do czego pijesz.

Na zdjęciu Raziela nie ma pojedyńczego kabla - jest adapter producenta PSU (bequieta) - wiem, bo mam tą samą:

https://www.bequiet.com/en/accessories/3959

micin3 - jest adapter z 2 na 1 lub z 3 na 1 lub nawet z 4 na 1 oczywiście że w tym wypadku najlepszy jest 2 na 1 tylko trzeba sprawdzić czy dostarczy 600W i masz możliwość podnieść power limit powyżej 100% do 133% a nie kończy się na 450W. Niemniej trzeba czekać na nowe PSU z dedykowanym wyjściem lub kupić jedyny dostępny Giganyte wtedy masz nie tylko standard dla PCI5.0 i komunikacje po jednym kablu co zarządzanie zapotrzebowaniem na energię dla GPU w zależności od obciążenia. Inna kwestią jest to że każda przejściówka jak pokazują testy z kamerą termowizyjną dodatkowo się grzeje.

wyjście te w nowych zasilaczach wygląda tak.

Co dopiero kupiłem nowe zasilanie za niemało pieniędzy tylko po to, by za kilka tygodni się dowiedzieć, że jest już nowy standard zasilanie ATX 3.0... Już możesz się wyobrazić te uczucie... Nie mam zamiaru sprzedać świeży zasilanie na Allegro za niższe ceny, by kupić nowe zasilanie. Co dopiero już składałem nowy PC. Już wolę czekać na nowy, ale usprawniony i bezpieczniejszy adapter 12-pin, a nie ten przereklamowany adapter od NVIDIA i inżynier-amator.

Ale obawiam się, że mój zasilanie PC może dłużej nie obsługuje nowe płyty główne w przyszłości. Bo już zauważyłem, że zasilanie ATX 3.0 używa 18-pin + 10-pin dla płyta główna, kiedy "stare" zasilanie używa 20-pin + 4-pin (w moim przypadku). I nie tylko to.

Link - to jest ewidentna wina Nvidii że wprowadza nowe rozwiązanie a partnerzy którzy produkują PSU dopiero po premierze kart dodają takie do rynku. Ten wyżej pokazany bequiet to b. dobry zasilacz premium (i to nowy na 2021-2022 rok) i co ? I nic większość producentów dopiero będzie dodawać nowe na rynek jedynie Gigabyte dostał informacje wcześniej to i wcześniej wypuścił. Fakt że do Q1 2023 pewnie na rynku każdy producent wypuści zasilacz w nowym standardzie ale na dzisiaj to jest ewidentnie lecenie w... To co Nvidia dała jako przejściówkę to w ogóle zostawię bez komentarza.

Mam tylko nadzieję, że nie potrzebuję nowe zasilanie ATX 3.0 dla przyszły RTX 4060, RTX 5060 i tak dalej, bo przecież nie potrzebują aż tyle prądu w przeciwieństwie do RTX 4080 czy RTX 4090. Jak nie, to poszukam osobny adapter 12-pin, ale profesjonalnie zrobiony i wielokrotnie sprawdzony w teście (taki polecony przez PurePC, Linus Tech Tips i tak dalej). Później czy prędzej tak musi być. Ale na pewno nie od NVIDIA.

Tym bardziej, że nowe zasilanie ATX 3.0 nie są kompatybilne z starsze płyty główne. Nie wystarczy tylko wymienić zasilanie, ale też trzeba wymienić również płyta główna (nowe płyty są strasznie drogie). Choć moja płyta główna obsługuje PCIe 5.0 dla karta graficzna, więc ma być bardziej przyszłościowa. Niezła ironia, co? To nic więcej jak tylko środkowy palec ze strony NVIDIA i inne producenci do nas i nasze portfeli.

Czas pokaże. Miłego grania!

W takich chwilach jestem zachwycony nie posiadajac problemow pierwszego swiata. Za biedny na to jestem...

Zawsze jak kupuje nowego kompa nachodzi mnie pustka i refleksja na temat tego, że mogłem wydać mniej, mieć te max 60fpsów w najnowszych grach, ale kupić sobie fajniejsze rzeczy. Jakbym kupił kartę za prawie 10koła żeby pograć w te dzisiejsze słabe gry niewarte nawet marnowania czasu to bym chyba popadł w totalną depresje.

Nawet jeśli ulepszyłem PC za wyższa cena, to niczego nie żałuję i nigdy nie będę. Ciesz się, co masz.

Nie zawsze podejmujemy dobre decyzji, ale już tego nie cofniemy. Uczymy się na błędach, by na przyszłość podejmujemy bardziej przemyślane decyzji.

No, nikt nie jest w stanie przewidzieć, jakie wymaganie sprzętowe będą mieli nowe gry za rok. Też nikt nie wie, jak daleko może rozwijać technologia PC w ciągu 5-10 lat. Łatwo Ci pisać.

Za 5 - 10 lat to te karty będą leciały o połowę taniej, wtedy rozważę ich zakupy za tą połowę ceny. Obecnie gry hulają na maksymalnej grafice na kartach za 1/4 ceny RTXa 4090.

W dodatku to rynek dostosowuje sie do konsumenta, a nie odwrotnie. Tak długo będę powstawać gry na gorsze karty jak długo większość graczy będzie leciała na tych gorszych modelach to dość oczywiste.

Za 5 - 10 lat to te karty będą leciały o połowę taniej

Nic nie wiadomo o tym. Nikt nie wie, co będzie za 5-10 lat. Nie zapominaj, że starsze karty graficzne nie obsługują nowe standardy technologiczne takich jak ray tracking czy DLSS 3.0. Nikt nie wie, co jeszcze wymyśli NVIDIA, by wyciągnąć więcej pieniędzy z naszych portfeli. Taki jest urok PC.

To nie jest usprawiedliwienie na kupno sprzętu znacznie na wyrost za chorą cenę

Wiem i słusznie. Dlatego nie kupiłem RTX 3060 za ponad 3000-6000 zł przez parę lat i czekałem, aż cena zejdzie do odpowiedni poziomu. Nigdy nie kupujemy niczego od śmierdzące skalperzy.

Nie bez powodu wybrałem i5-12400f, który mogę ograć w wszystkie gry AAA na Ultra, a nie i5-12600k czy i5-13600k za chora cena (za tyle, który można kupić i7).

Miłego grania i oby jak najdłużej nowe gry będą działać płynnie na Twoim PC. ;)

Chyba dobrze zrobiłem zmieniając peceta na konsolę. Za mojej kadencji wystarczył GeForce 9600 i komp za ~2,5k żeby uciągnąć większość tytułów z tamtego okresu, a teraz? Głowa mała jakie ceny sobie wołają

W 2008 minimalne wynagrodzenie wynosiło 1126 złotych.

W 2022 minimalne wynagrodzenie wynosi 3010 złotych.

Za 7.5k, czyli 3 razy więcej niż 2.5k, złożysz kompa który udźwignie nie większość, a każdą grę z tego okresu.

ale co ma minimalna do rzeczy? W Polsce za minimalna nigdy nie dało się w ogóle przeżyć a co dopiero odłożyć na komputer. Przychody przeciętnie zarabiających raczej nie wzrosły 3 krotnie. Także obecnie jest drożej niż było

Piję do wypowiedzi, że komp za 2.5k był w stanie udźwignąć wszystko w 2008 roku (czyli daty wypuszczenia GeForce 9600).

Tamte 2.5k, to obecne 7.5k - czyli 2.5krotność minimalnego wynagrodzenia.

Obecnie nie jest drożej niż było - bo drogo złożyć kompa zawsze było, tylko kiedyś składało się byle co i za młodu cieszyło się, że gra działa w 640p i 20 klatkach. Ludzie po prostu zapomnieli ile to kosztuje, bo jak ktoś od "zawsze" ma PC, i co jakiś czas go modernizuje, to nie zdaje sobie sprawy ile kosztuje kupno kompa od zera.

Co do zaś:

Przychody przeciętnie zarabiających raczej nie wzrosły 3 krotnie

Minimalna wzrosła 3 krotnie od 2008 roku.

Mediana wzrosła z 3800 do 5700 (2021 rok, nie widzę mediany do 2022).

Za mojej kadencji wystarczył GeForce 9600 i komp za ~2,5k żeby uciągnąć większość tytułów z tamtego okresu, a teraz? Głowa mała jakie ceny sobie wołają

No ile? Za około 2.8-3.5 tysiąca można dostać komputer który pociągnie wszystkie gry w ustawieniach High/Ultra 60FPS, albo High 80-100FPS w 1080p albo High w 60+FPS w 1440p. To że górna granica cenowa jest bardzo wysoka nie oznacza że nie można grać w bardzo dobrych ustawieniach za przyzwoitą cenę. A jak ktoś ma rzeczywiście bardzo ograniczony budżet to za około 2000zł może złożyć sprzęt z używanych (w miarę nowych) częściach który też da mu te 60FPS w 1080p przy ustawieniach wysokich.

bo drogo złożyć kompa zawsze było, tylko kiedyś składało się byle co i za młodu cieszyło się, że gra działa w 640p i 20 klatkach.

Dokładnie. Śmieszne jest patrzenie na ludzi, co piszą "kiedyś to było" - no było, tak samo jak dzisiaj jeśli chodzi o PCty. Granie w wysokich detalach i dobrym klatkażu zawsze było domeną najwyższej półki i zawsze była "głowa mała" jakie ceny za to wołali. Pamiętam jak zakup Core2Duo E4600, 2GB DDR2 i GT8500 to był niemały wydatek. A w 2008 roku to wcale bestia nie była.

już jakieś dwie nieszczęśliwe życiem osoby dały minusa na górze w temacie / gry powodują że ludzie mają uśmiech na twarzy a tutaj niby wszyscy hobbiści a jakieś frustrację ;( ja tam dałem +1

Nie wiem, po co w ogóle piszesz to?

Nie liczy sie rozmiar...tylko grubosc.

spoiler start

Portfela oczywiscie!

spoiler stop

No, potwor jest. Teraz trzeba tylko czekac na gry przy ktorych ta karta bedzie sie meczyc :)

Ja poczekam na kartę energooszczędną, która zapewni taką samą wydajność. Krótko i na temat. Właśnie to osiągnąłem w kwestii CPU. Zyskałem znaczną wydajność bez zwiększania poboru energii. Wystarczyło poczekać 4 lata. Cena o 60% taniej :)

A z mocy tej karty do gier? Chyba tak naprawdę mało kto na tym skorzysta!

Nie liczy sie rozmiar...tylko grubosc.

spoiler start

Portfela oczywiscie!

spoiler stop

się przypomina ten obrazek

Prądu zjada tyle samo co taki RTX3090Ti, zapewniając 50% większą wydajność.

Dla mnie osobiście limit to max. 200 W TDP. Nie więcej dla karty graficznej. Ale im mniej, tym lepiej. Bo bez problemu da się grać na słabszych...

Pogubiłem się już, o co Ci chodzi.

Zapytałeś ile prądu ta karta zjada. Dostałeś odpowiedź, że tyle co poprzednia generacja.

Teraz wyskakujesz z jakimś arbitralnym 200 TDP.

I tak, da się grać na słabszych. Da się grać także na starym 960GT, ale co to w ogóle wnosi? Kogoś stać, to ktoś kupuje. A jak kogoś stać na kartę powyżej 10k, to raczej nie myśli, ile zapłaci za prąd.

Kogoś stać, ale czy mu to potrzebne to już inna sprawa. Mnie może stać, ale mi to niepotrzebne. Więc tu nie chodzi o to, "czy kogoś stać"

Chłopie, o czym ty w ogóle piszesz? Jaki artykuł?

Napisałeś:

OK, a ile prądu to zjada? 2x tyle, 3x tyle? '

Dostałeś odpowiedź, że 1x tyle.

A po mojej odpowiedzi wyskoczyłeś z jakimś artykułem, którego nawet nie podlinkowałeś, i odwróciłeś kota ogonem, że i tak nie warto, bo 200TDP to limit.

Ja się opieram na testach Tomshardware i PurePc pod obciążeniem, nie na tym co Nvidia podała. RTX4090 jest bardziej "opłacalny" pod kątem prądu niż poprzednia generacja, szczególnie z DLSS.

I weź mi, prostemu chłopu, wytłumacz, jak karta może pobrać więcej TDP, niż przewód zasilający.

OK, ale kosztuje ile razy tyle? Trzeba by to dokładnie przeliczyć, czy i komu się to opłaca xD

O mój borze leśny. Toś się ośmieszył.

Twój artykuł nie mówi o tym, że karta ciągnie 60 procent więcej.

Artykuł mówi, że niektórzy AIB mogą przygotować silniejsze karty, z odpowiednio większą ilością wejść.

Artykuł nigdzie nie wskazuje, że referencyjne karty mogą pobrac 60 procent więcej TDP - to już sobie ty dopowiedziałeś.

Nie, nagłówki bywają bardzo podchwytliwe. Nie mam powodu do wstydu. Sam to wcześniej ogarnąłem po przeczytaniu...

>Przeczytaj tylko treść nagłówka

>Dopowiedz sobie wygodne dla siebie "fakty".

Chociażby byś się do błędu przyznał, bo nagłówka nie był w cale w żaden sposób wprowadzający w błąd.

Poczekam 2 generacje i będę miał taką moc w 200 W TDP. Wtedy o wiele bardziej się mi przyda niż dziś. Taka moja rada.

Do błędu się już przyznałem, nie czytając od razu całości.

Brzmisz, jak jakiś pracownik z Nividi albo CDP xD

Jednak to nie kwestia tego, czy Cię stać, tylko kwestia osobistych potrzeb. To trzeba tu podkreślić.

Za to Ty brzmisz, jakbyś nie mial bladego pojęcia o czym piszesz.

Poczekam 2 generacje i będę miał taką moc za 200 W TDP.

Skąd taka rewelacja?

Czekaj, żebym to dobrze podsumował.

1. Zapytałeś ile prądu ta karta zjada.

2.Dostałeś odpowiedź, że tyle co poprzednia generacja.

3.Wyskoczyłeś z arbitralnym 200 TDP.

4. Zarzuciłeś mi brak czytania ze zrozumieniem.

6. Link który wrzuciłeś ukazał, że albo nie umiesz into english, albo przeczytałeś tylko nagłówek (w żaden sposób nie manipulacjy) i sam sobie dopowiedziałeś 60 procent więcej TDP.

7. Zamiast powiedzieć "my bad mate" I zakończyć dyskusje, zwalasz wszystko na nagłówek.

8. Zarzucasz mi, korpo hejtera i wielbiciela regulacji, że brzmie jak pracownik NVIDII (pewnie przez to, że poprosiłem o wyjaśnienie jak karta może pobrać więcej "prądu" niż przewód pozwala).

Nie było punktu 5. Coś pominąłem?

Już tak się nakręciłeś, że nawet nie czytasz ze zrozumieniem. Człowieku, teraz ja pytam. O co Ci chodzi? Tak, dokładnie tak, reagujesz i zachowujesz się tak, jakbyś pracował dla nVidii i bronił ich interesów. Albo Twój fanatyzm, bo wydałeś 20K na kartę i przy niej się...

ja nie w temacie, ale ile taka karta z pierwszego posta kosztuje? i pytam o cenę rynkową a nie scalperów

10k-11k - Palit, jak i Inno3D, to najtańsze opcje 4090.

Bo ja wiem czy gówniane? 3 generacja RTXów to karty na wiele lat, dzięki DLSS. RTX4090 to także nie jest karta dla przeciętnego gracza - ot, odpowiednik dawnego Tytana.

NVIDIa jak zwykle robi po prostu przeskoki cenowe co generacje. RTX2XXX był drogie, RTX3XXX był dobrze wycenione. RTX4XXX są drogie, stawiam orzechy przeciw orzechom że RTX5XXX będzie tym samy, czym 3 generacja była dla drugiej - czyli więcej, lepiej i taniej.

A jeszcze jak się wiatraki wyłączy to i pół chaty ogrzeje, taka karta to niezły biznes w dzisiejszych czasach.

Normalnie powrót do przeszłości, może niekoniecznie jeśli chodzi o grubość. Ale wysokość i długość niczym karty ISA do PC, pamietam swoje grafiki jak i karty dźwiękowe jakie były gigantyczne choć mieściły się w jednym gnieździe.

Pocieszające jest to, że wersja 4080/16GB jest (trochę) niższa - 75.1mm vs. 61mm -)

Załóżmy, że RTX 4090 jest na AMD Ryzen 7 5800X3D, to tak wygląda pod obciążeniem według PurePC:

https://www.purepc.pl/test-karty-graficznej-nvidia-geforce-rtx-4090-kosmiczna-wydajnosc-w-kosmicznej-cenie-mocna-premiera?page=0,32

Jeśli RTX 4090 zużywa trochę mniej niż RTX 3090, to przy blokadzie 60 FPS będzie zużywać znacznie mniej prądu wobec mniej wymagające gry i inne aplikacji. Czyli lepszy stosunek mocy/wydajność.

Ale posiadanie zasilanie 1000W jest jak najbardziej wskazany (minimalnie 850W).