„Generowanie klatek jest dla casuali”. RTX 50, DLSS 4 i multigenerowanie klatek wzburzyły Internet

Via Tenor

Z drugiej strony nie brakuje głosów, że jest dokładnie na odwrót i Nvidia wypuszcza nowe wersje upscalera i funkcje generowania klatek, bo gry działają słabo, a „zieloni” starają się temu zaradzić.

Taaa... Dziwny zbieg okoliczność sprawił, że Indiana Jones został wspierany przez NVIDIA i za to nie wspiera FSR od AMD. Ta gra ma zbyt absurdalne wysokie wymaganie sprzętowe i RT jest absolutnie "musi mieć", a grafika nie za bardzo się różni od niektórych grach AAA. Nawet Alan Wake 2 czy Red Dead Redemption 2 jest bardzo ładny i może działać bez RT. Zbieg okoliczność?

Odkąd Frame Generations od DLSS 3 się pojawił, to niektóre gry nagle mają wyższe wymaganie sprzętowe i nie da się grać na Ultra bez FG.

Coś tu śmierdzi. Heh.

Coś za coś.

narzekają i narzekają, a w momencie premiery karty znikną z półek XD

Chyba nie zdają sobie sprawy, że hardware nie bierze się z niczego. Dzisiejsze karty nawet nie potrafią dać dobry klatkaż w 4k przy tradycyjnym rasterze. Jeśli chcą, to niech szykują zasilacze po 2000 watów i chłodzenie na pół obudowy żeby ich karta nie wskakiwała po sekundzie na 100 stopni. Albo niech wymyślą inny sposób, by hardware mógł być tak mocny i pozwalać na komfortowe granie w 4k, z full detalami w 60+ fps. Żyjemy w czasach, gdzie powoli AI jest wszędzie pchane i na tym polega DLSS i Frame Gen. Niech się z tym pogodzą.

Zdałem sobie sprawy z tego.

Nawet Intel i AMD nie mogą wyciskać aż tyle mocy obliczeniowe z pojedynczy rdzeń CPU bez kosztem wysoki pobór prądu i temperatury. O cenie nie wspomnę. Więc musieli wymyśleć wielu rdzeni i wielu wątków i inne technologii. To był strzał w dziesiątkę.

NVIDIA i AMD też zdali sobie sprawę z tego. Ale nie zmienia to faktu, że już wypróbowałem DLSS i Frame Gen i muszę przyznać, że robi wrażenie. 10-20 lat temu nigdy nie myślałem, że to takie możliwe. Ludzka technologia nie przestaje mnie zaskakiwać.

Ale jeśli gracze nie są zadowoleni z takiego rozwiązanie, to niech nie kupują nowe karty graficzne i nie kupują nowe gry uzależnione od DLSS/FSR. Niech kupują tylko gry wolne od DLSS, a są mnóstwo w STEAM.

Ale gracze kupili RTX 2000/4000, więc chcieli RT i DLSS/FSR mimo wszystko. Przecież głosujemy portfelem. Czyż to nie jest hipokryzja?

Wymieniać na nową serie nie ma sensu. No chyba, że ktoś kupuje teraz nową, to i tak te 50x0 nie będą dużo droższe od 40x0 (te drugie nvidia celowo przestała produkować na długo przed premierą nowych- ma ich jeszcze sporo w magazynach, ale zawyża ceny). Pewnie też 50x0 będą miały lepszą efektywnośc energetyczną(bo TDP teoretycznie mają większe, ale to po wliczeniu rdzeni RT i AI, jeśli ich nie używamy to będzie sporo mniejsze, bo bez nich te karty niewiele różnią się wydajnościowo, a mają niższy proces produkcyjny).

Dzisiejsze karty nawet nie potrafią dać dobry klatkaż w 4k przy tradycyjnym rasterze. Jeśli chcą, to niech szykują zasilacze po 2000 watów i chłodzenie na pół obudowy żeby ich karta nie wskakiwała po sekundzie na 100 stopni. Albo niech wymyślą inny sposób, by hardware mógł być tak mocny i pozwalać na komfortowe granie w 4k, z full detalami w 60+ fps.

Z tym, że problemem są głównie skopane optymalizacje wielu gier wydanych na przestrzeni ostatnich lat bez mocno zauważalnego skoku graficznego, a może nawet widać regres.

Niestety ciągłe parcie na coraz szybsze wydawanie gier dla potencjalnie większych zysków dla producenta i wydawcy, w połączeniu z coraz większymi oczekiwaniami funkcjonalnymi gier ze strony graczy, musi gdzieś mieć swoje konsekwencje i m.in. jest to brak wspomnianej optymalizacji.

Podejrzewam, że do tej górki wstydu dorzuciłbym jeszcze kwestię zatrudniania, może tańszych (ale za to mniej kompetentnych ;) ) deweloperów do tworzenia produkcji.

Tak więc w żadne AI, DLSS, FrameGen nie trzeba się bawić, choć niestety Nvidia w takiej sytuacji też wyczuła interes i wcale nie ma parcia do wydawania normalnych kart z generacji na generację, zamiast tego woli użyć wypełniacza wydajności.

Dodatkowo, z tego względu, że Nvidia na ten moment dominuje rynek i dzięki sile swojego marketingu wciśnie graczom nawet najgłupsze rzeczy, to i konkurencja ze strony Intela i AMD musi się temu poddać i ślepo podążać tworząc swoje odpowiedniki, żeby nie być z tyłu w "przełomowych" rozwiązaniach.

ale to wystarczy przecież nie używać DLSS/RT. Nie ma takiego obowiązku w grach.

To prawda. Problem polega na tym, że lustrzane odbicie od RT w Alan Wake 2, Cyberpunk 2077, albo Indiana Jones potrzebują DLSS/FSR, by gra działa płynnie bez poniżej 30-60 FPS na 1440p.

Albo po prostu zapomnij o RT. A ja kupuję gry AAA po to, by mieć jak najlepiej wrażenie z gry. Liczą się pierwsze wrażenie.

Wymieniać na nową serie nie ma sensu. No chyba, że ktoś kupuje teraz nową, to i tak te 50x0 nie będą dużo droższe od 40x0

Dlatego nie kupuję karty w dniu premiery, lecz poczekam, aż ceny spadną. Zadowolę RTX 4070 i nie narzekam.

Ta generacja to największy wał invidi. Widać brak konkurencji.

Trole AMD w akcji. Zapomnieli o tym, że AMD również takie ma plany i generowanie kilku klatek prze AI

Gdyby faktycznie ten FrameGeneration przewidywał przyszłość, to miałoby to sens. Niestety nie przewiduje, zamiast tego kisi jedną klatkę do przodu w buforze i dogenerowuje na tej podstawie międzyklatki przed tą klatką.

Na 4070 obecnie da się grać w większośc gier na wysokich i to w znośnym klatkarzu, bez żadnego generowania klatek, bo to powoduje, że gra się gorzej, mimo że animacje są płynniejsze (dłużej trzeba czekać na reakcje ekranu po wykonaniu ruchu/przeciwnik wykona ruch).

Bo to są testy na klientach. Z jedna klatka maja problem, a co dopiero z trzema. Ta technologia potrzebuje jeszcze ze 2 lat na rozwój. Marketingowa sciema żeby kupić nowa generacje. Większość ludzi nie używa tego frame genertora bo pogarsza obraz i daje gorsze odczucia, jak nie musi.

Dlss/fsr miały umożliwić grę w najnowsze tytuły na starszych kartach, a przyczyniły się do olania optymalizacji.

A za rok 5000 Super z DLSS 4.5 i kolejne 10% więcej standardowej mocy ;). To w tym tempie to poczekam sobie na gen 7000 Super :)

Tylko mam nadzieje, że potrafią liczyć do 7 normalnie :D

Gdyby te wszystkie nowe generacje kart graficznych nie wychodziły co roku tylko np. co 4-5 lat to twórcy gier musieliby optymalizować swoje produkcje, a tak wystarczy, że podniosą wymagania co do potrzebnego sprzętu i już nie muszą martwić się o optymalizacje. Gdyby to jeszcze z każdą nową generacją kart wychodziły by gry, które faktycznie wyglądają dużo lepiej dzięki nim a nie tylko więcej klatek będzie w danej grze.

Oczywiście, że Nvidia ma ogromny wpływ na to, by nowe gry wymagały najnowszych kart graficznych, bo dzięki temu mogą sprzedawać swój sprzęt.

Z jednej strony "Ignorance is bliss" z drugiej, gdyby tylko ten kurczak smakował tak samo :/ Obraz z wygenerowanych klatek, w dynamicznych momentach wygląda znacznie gorzej. Na przykładzie mielonego już wszędzie Cyberpunka (ale miałem to także m. in. w Spider-Manie czy innych tytułach) - szlag mnie trafiał i myślałem, że mam trefioną kartę, bo przy szybszym ruchu miałem straszne smużenie przy krawędziach. Jazda samochodem, bujanie się na sieci — wyglądało to bardzo źle. Po wygrzebaniu detali okazuje się, że cała wina leży właśnie po stronie DLSSA. Fajnie, że wszędzie pokazują screeny albo statyczne sceny i cyferkę jak to FPSy wywalają sufit. Niech pochwalą się, jak wygląda dynamiczna rozgrywka na mocno teksturowanym tle.

Przyjrzyjcie się na karton i kubek, który leży ze słomką. Bardzo ładnie MFG dodaje sobie tekstury, których nie ma. Ciekawe jakie glitche zaoferuje w dynamicznych scenach, a nie na takiej statycznie. Skoro już teraz taka wtopa. Według mnie MFG wygląda gorzej niż FG :) DLSS akceptuję, FG nie.

szczerze jako osoba która ma 1060 wole grać z 30fps bez FSR3 niż te niecałe 60fps z generowaniem klatek, mocno odczuwalne jest odklejanie się jakości.

Większość czasu przez ostatnie lata spędziłem przy takim RimWorld. Co roku to dla mnie gra roku i jak potrafi przymulać. Bardziej nie akceptuje redukcji pewnego typu detali jak to bywało z każdym następnym FarCry, na rzecz grafiki. Brak pomysłów na gry to poważniejszy problem niż jakość grafiki, bo niemal wszystko aaa z gier roku stawia na minimalizm symulacji.

Najbardziej uśmiałem się z tego komentarza, że 10 letni Batman wygląda tak jak obecne gry.

Ten kto to napisał to chyba nie widział Alan Wake 2 czy Hellblade 2.

Winne są studia, bo zamiast optymalizować, idą na łatwiznę i korzystają z gotowych rozwiązań sprzętowych, a powiem wam że mam Kate RTX i czasem gra wygląda lepiej bez RT, mam wrażenie że te rozmyte odbicia są jednak bardziej "filmowe"/klimatyczne niż te ostre jak żyleta z RT. W RT brakuje artyzmu, nie wiem czy z braku wiedzy/umiejetnosci ludzi którzy z tym pracują czy z braku implementacji w samym RT.

Winni są gracze, bo ciągle jęczą na optymalizację i grafikę. Nie da się mieć ciastka i zjeść ciastka. Dlatego powstaje DLSS, można mieć wszystkie bajery, upscale'ować z mniejszej rozdzielczości i jeszcze dodać tyle klatek ile się chce. Ulepszanie raw power w tej samej cenie jest coraz trudniejsze.

Najpierw trzeba sobie zadać pytanie na czym polega optymalizowanie gry przez studio bo dla mnie to zwyczajny downgrade graficzny żeby gra zyskała kilka fps więcej. Szczególnie znane z tego jest Ubisoft kiedy majstrował przy AC, a w szczególności Origins który co kilka patchy tracił na jakości.

Dla mnie wszystkie technologie Nvidii są ważne i lubię z nich korzystać. DLSS/FSR uratował mi granie na 3080 przez 4 lata!!!! przecież kiedyś co chwila kupowałem nową kartę i to jeszcze sprzedawałem starą na gwarancji. Obecnie na 3080 straciłem 4 letnią gwarancję i dalej z powodzeniem używam chociaż już na bajery nie mogę sobie pozwolić. Za DLSS jestem bardzo wdzięćzny i 50xx kupuje tylko dla DLSS 4.0, a nawet na ten VRAM nie patrzę bo wiem, że jak kupie np 5080 to na kolejne 4-5 lat.

Sama technologia nie jest zła i sam ochoczo korzystam,bo znacznie to poprawia grafikę i wydajność. Tu NVIDIA zrobiła ogromny postęp i liczę na więcej.

Problem zaczyna się kiedy developer gry, ma wywalone na optymalizację bo AI zrobi to za niego.Tego już nie akceptuje.

AI powinno wspomagać i ulepszać a nie naprawiać to,co developer nie zrobił.

Zajebista technologia. Jak na necie już nazywają to generatorem przekłamania obrazu, tyle jest glitchy. https://www.youtube.com/watch?v=nxuQoj6_JLA&ab_channel=Vex

To jest kolejny powód, dlaczego nie zamierzam kupić RTX 5000 w dniu premiery, a nie tylko cena. DLSS 4 wygląda piękno w teorii, ale praktyka i rzeczywistość to coś innego.

Reflex 2 i inne ulepszenie sprawią, że DLSS 3 i FG może coś zyskują w jakość obrazu. To też jest dla RTX 2000/3000/4000. Ale nie wiemy, jak działają na multi FG w praktyce, jeśli chodzi o anomalie i smużenie, bo za dużo "fałszywe" klatki. Zawsze jest ryzyko, że im mniej prawdziwe FPS dla grze, tym FG gorzej działa, bo SI nie nadąży się za wszystkiego. Wszystko ma swoją cenę.

Dlatego trzeba poczekać, aż ktoś to potestuje porządnie.

Nie.

Jestem zadowolony z RTX 4070 i to bardzo. Indiana Jones czy Alan Wake 2 na 1440p jest dla mnie grywalny. Cieszę się bardzo też, że RTX 4070 dostanie udoskonalony DLSS 4, co poprawi jakość obrazu i redukuje opóźnienie (oby!). Multi Frame Generation tylko dla RTX 5000 nie jest mi potrzebny. Na razie.

To też jest jedna z powodów, dlaczego nie kupuję RTX 5070 w dniu premiery. Nie widzę sensu, by przepłacić pieniędzy za mały zysk FPS (te prawdziwe, nie sztuczne).

Ale po prostu jestem ciekawy o nowe technologii DLSS 4 i jak wygląda multi Frame Generation w praktyce. Od tego jest YouTube i PurePC i GryOnline. Lubię czytać komentarzy i opinie o nowe generacji karty graficzne. Niektóre komentarzy są zabawne. ;)

FG powinien byś wykorzystywany by "dogenerować" sobie brakujące klatki do pełnego odświeżania monitora, a nie po to aby mieć płynniejszy obraz sam w sobie. Do tego służy DLSS który skaluje obraz (i robi to świetnie) zwiększając wydajność i bardzo dobrze wygładzając krawędzie. Nie zwiększa też on opóźnień tak jak DLSS 3 (wręcz przeciwnie).

Najgorsze jest to że Generator klatek jest wykorzystywany w marketingu by sztucznie zwiększać wydajność nowych kart w stosunku do starszych produktów oraz tych od rywali.

Zwiększane w ten sposób wykresy porównujące wydajność zakrzywiają stan faktyczny działania karty. FG nie jest bez wad i wiąże się z dość poważnymi kompromisami w jakości obrazu. Jest to niesprawiedliwe, to tak jakby na zawodach używać nielegalnych sterydów i się tym chwalić że inni tego nie mają.

Nie zwiększa też on opóźnień tak jak DLSS 3 (wręcz przeciwnie)

DLSS 3 = poprawiony DLSS i Frame Generation w jednym zestawie.

DLSS 3.5 = poprawiony DLSS i Frame Generation i Ray Reconstruction w jednym zestawie.

Da się włączyć DLSS 3 i Ray Reconstruction bez włączenie Frame Generation (ten powoduje opóźnienie). Cyberpunk 2077 i inne gry oferują takiej możliwość.

Właśnie dlatego stworzyli DLSS 4. NVIDIA DLSS 4 będzie pierwszą techniką skalowania, która wykorzysta nowy model transformatora w czasie rzeczywistym. Rozwiązania Super Resolution oraz Ray Reconstruction, które będą oparte na nowych transformatorach, wykorzystają teraz dwa razy więcej parametrów oraz czterokrotnie wyższą moc obliczeniową, co poskutkuje większą stabilnością obrazu w ruchu, zminimalizowaniem efektu smużenia (ghostingu) na poruszających się obiektach.

Powtarzam, nowe techniki w DLSS 4 redukuje opóźnienie dla Frame Generation. RTX 2000/3000/4000 dostaną DLSS 4 za wyjątkiem MULTI Frame Generation (ulepszony Frame Generation). Krótko pisząc, Frame Generation z RTX 4000 niedługo zostanie poprawiony i zużywa trochę mniej VRAM dzięki nowe sterowniki NVIDIA.

Jeśli twórcy gier nie zaktualizują DLSS w grach, to NVIDIA Apps pomoże uzupełnić te braki i zastąpi te przestarzałe pliki na nowsze. Ale tylko dla gry, co obsługują DLSS. Tak czytałem.

Zobaczymy, jak to wygląda w praktyce.

Ciekawe czy gracze zaczną kiedykolwiek dyskutować, że ogólnie wymagania gier to fikcja i jeden wielki wałek, a ci się kłócą o to kto jeszcze lepszy Nvidia czy AMD jak 20 lat temu, tragedia jak gracze są ciemni.

ogólnie wymagania gier to fikcja i jeden wielki wałek

Niektórzy już o to zauważyli. Nawet niektóre opcji graficzne na Medium/High w Indiana Jones nie różnią się od Ultra poza podwyższenie wymaganie sprzętowe "za darmo". Nawet cienie i oświetlenie w PT wyglądają gorzej niż zwykły, tańszy RT.

Poza tym, OFICJALNE wymaganie sprzętowe dla gier nigdy nie są 100% dokładne.

a ci się kłócą o to kto jeszcze lepszy Nvidia czy AMD

Tylko ogarnięci użytkownicy PC nie kłócą się i wiedzą swoje. Tylko głupcy się kłócą o jakieś błahostki, nie tylko o NVIDIA i AMD. Zawsze tak było i to od dawna. Nic nowego.

tragedia jak gracze są ciemni

Ale po co to piszesz? To ty dzwonisz.

Mnie bardziej zastanawia czemu przy rozdzielczości Full HD czy 2k stare gry wyglądają ładniej niż te dzisiejsze. Szczególnie te większe tytuły. W dzisiejszych grach przy rozdzielczości 2k i danym wszystko na ultra gra wygląda gorzej niż ta przed 10 lat. W nowej grze trzeba jeszcze dawać w opcjach np. skalowanie obrazu. W tedy gra wydaje się ładniejsza.

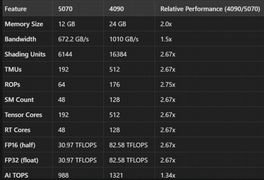

RTX 3080 (30 TFLOPS)

RTX 5070 (31 TFLOPS)=RTX 4090??

RTX 3090 (36 TFLOPS)

RTX 4070TI SUPER (44 TFLOPS)

RTX 5070TI (44 TFLOPS)

RTX 4080 (48 TFLOPS)

RTX 5080 (56 TFLOPS)

RTX 4090 (82 TFLOPS)

RTX 5090 (104 TFLOPS)

Nvidia wymyśliła nową abstrakcyjną matematykę gdzie prawdziwe są:

82 = 31

oraz

104 = 41 czyli 82 / 2

Jeżeli mówimy o tematyce grania to sprawa jest raczej prosta, nie grasz TFLOPS'ami tylko FPS'ami i nie widzę tutaj żadnego przekłamania jeżeli mam być szczery.

Co innego w przypadku jakichś obliczeń/kopania ale raczej nie to jest targetem tych kart.

RTX 5070 (31 TFLOPS)=RTX 4090?

Ogólnie trzeba powiedzieć jedno. Reflex 2 (-10% imput laga) może być totalnie udane i sensowne jako exkluziw 5xxx. Ale to tyle. Nie rośnie moc bazowa zbytnio a frame gen nie warto odpalać poniżej 50 klatek, bo zbytnio wpłynie na jakość tych sztucznych. Więc 3 czy 4 x frame niewiele zmienia = Dalej imput lag jest zbyt duży i rosnie przy 3x 4x, tym bardziej dla kogoś kto gra na tv może to być całkowicie niszczące.

Props za dlss 4 bo w tym przypadku zyska każda generacja na jakości i kilka procent klatek.

Ale reflex 2 , 20 % więcej mocy i MFG to za mało by sprzedać tą kartę(i usprawiedliwić cenę)

To wszystko ma sens przy wzroście bazowej mocy o 40-50 % na większości kart. Bo wtedy straty jakości sztucznych klatek będą małe, imput lag mniejszy i więcej klatek. Więc warto poczekać na super i zdecydowanie NIE ma sensu zmieniać z generacji 4xxx na 5xxx. Niewiele zyskacie bo w grach kompetetywnych i tak macie sporo klatek i dość mały imput lag. Mało kto gra w csa z 4k msaa8x

ps mam nadzieję na hdmi 2.2 w superach :D Ale raczej dopiero 6kseris ;/ W końcu niedawno zapowiedzieli o czym cicho a 8k i 120 hz + 4k i 240 nadchodzi :D Dla grających na tv to dobre wieści jako że 8k tanieje. Co też sporo oznacza dla rozwoju MFG (odpalanego w sensownym klatkażu by nie tracić jakości)

Reflex 2 (-10% imput laga) może być totalnie udane i sensowne jako exkluziw 5xxx.

Nie, nie będzie ekskluzywny. Musisz wiedzieć, że Reflex 2 i wszelkie udoskonaleń od DLSS 4 będą dostępne również dla RTX 2000/3000/4000. Wystarczy tylko zaktualizować sterowniki NVIDIA i pobrać NVIDIA App (ten program podmienia starsze plików na nowsze dla niektórych grach). Podobnie jak Ray Reconstruction od DLSS 3.5 dla wszystkich kart RTX, a nie tylko RTX 4000.

Frame Generation tylko dla RTX 4000 zostanie trochę usprawniony, np. mniejsze opóźnienie i zużycie VRAM.

Masz tu screen i link dla porównanie:

https://www.nvidia.com/pl-pl/geforce/graphics-cards/compare/

Tylko MULTI Frame Generation od DLSS 4 będzie ekskluzywny dla RTX 5000.

To wszystko ma sens przy wzroście bazowej mocy o 40-50 % na większości kart

Dlatego karty RTX 5000 dostają szybszy pamięci GDDR7, więcej CUDA i inne parametry techniczne. Jak dużo dostajemy prawdziwe ilości FPS? Tego się przekonamy na prawdziwe testy PurePC.pl i podobne strony.

Tyle wiem.

Obejrzyj jeszcze raz końcówkę filmu nvidi. Mówi że ma być czasowa ekskluzywność 5k i z tego co wyczytałem z innych źródeł to nawet rok jako beta

Co do samych mniejszych opóźnień to tez zobacz digital foundry gdzie wyniki skrajnie inne wychodzą niż nvidi która zwyczajnie liczy to inaczej. Z magicznego mniejszego imputa zrobił sie 35 ms większy względem natywu.

zużycie vramu to tez żart w ilościach do 400 mb mniej. Wiadomo że coś to daje ale no nie mi bo planuje i tak 16gb xD Ja bym nie liczył na więcej niż 30 % poprawy natywnej. Widać to po flopsach no ale to pokażą wyniki testerów. Jak dla mnie not worth zmieniać z 4k na 5k i dopłacać 2k zł, jeśli nie będzie tego przyrostu 50 % A raczej na to się zapowiada ogólnie

Obejrzyj jeszcze raz końcówkę filmu nvidi.

Tak, już widziałem to. Dzięki za przypomnienia. Ale przynajmniej to nie będzie trwały ekskluzywność w przeciwieństwie do Frame Generation. Tylko tymczasowy, a to jest różnica. Wszyscy posiadacze RTX dostaną to później czy prędzej, ale to tylko kwestia czasu. Wtedy dostaniemy Reflex 2, ale jako dopracowana wersja, nie BETA.

Trwała a tymczasowa ekskluzywność to dla mnie OGROMNA różnica. Tak jak dostaniemy Spider-Man 2, Stellar Blade i Final Fantasy VII Rebirth na PC już niedługo. Dlatego nie widzę powodu, by kupić konsola PS5, jak mam dobry PC z gamepad. :)

Jak dla mnie not worth zmieniać z 4k na 5k i dopłacać 2k zł, jeśli nie będzie tego przyrostu 50 %

Też nie mam zamiaru kupić RTX 5000, bo nie ma gry AAA, które nie działają płynnie na moim RTX 4070 i to na High/Ultra, a co dopiero nowe gry Indie i Retro. Przynajmniej nie za taką cenę w dniu premiery. Nie kupiłem RTX 4070 tylko po to, by szybko wymieniać.

Lepiej późno niż wcale. Miłej nocy.

Crysis z 2007 ma lepszą grafikę i lepszą optymalizację niż 99,9% gier które wyszły po 2007 roku :D ...

To chyba na oczy nie widziałeś króla optymalizacji Dooma i Dooma Ethereal i oczywiście nie pamiętasz jak tragicznie Crisis chodził w 2007 i do dziś chodzi tylko sprzęt jest dużo mocniejszy

Gier wychodzi po 10000 sztuk rocznie a gier z lepszą grafiką mógłbym policzyć na palcach dwóch rąk, więc raczej nie przesadziłem.

"że w Cyberpunku 2077 udało się awansować z 27 klatek bez DLSS do 71 z DLSS 2, 140 z DLSS 3.5 i 248 z DLSS 4"

Tu ktoś popełnił fatalny błąd. Jak można do prezentacji nowego sprzętu wybrać grę w 27FPSach nativ :D Same sztuczne cyferki mocy sprzętowi nie dodadzą a ten poza rtx 5090 jest zwyczajnie pociachany ile się dało, by nie trzeba produkcji zapychać jakimiś tam GPU dla graczy i więcej sprzętu pod AI wypchnąć.

Płaczków jak zwykle nie brakuje, to najczęściej ci których na te karty zwyczajnie nie stać, albo grają na konsolach:) No cóż...czekam na luty i 5070Ti.

Przesądzasz.

Stać mnie na to. Stać mnie na RTX 5070 Ti, ale cena jest po prostu za wysoka. Wszystkie gry są grywalne na moim karcie, więc po prostu nie opłaca się kupić RTX 5000 w tej chwili. Szkoda mi ciężko, zarobione pieniędzy.

Poza tym, nie wszyscy są fani "sztuczne" klatki FPS i metoda DLSS. Wolą prawdziwe FPS na natywne rozdzielczości. Jak usuniemy DLSS 4 z karty RTX 5000, to niewiele mają do zaoferowanie za taką cenę w porównaniu do poprzednie generacji. No, nie wszyscy lubią ray tracing, jak czytałem niektóre komentarzy na forum.

Obrażanie innymi to nie jest dobry powód, by możesz być dumny. Więcej dystansu i wyrozumiałość. ;)

Czyli ciebie również nie stać klaunie. 5070 ti to srednia półka cenowa i wydajnościowa. Więc nie wiem czy się chwalisz

Pierdu, pierdu a i tak masa ludzi kupi. I dobrze, bo DLSS 4 jest niesamowitą technologią!

Niech kupią więc karty od AMD. Gracze :) mówimy o tych dzwonach którzy grając w gry mają wyświetlone 50 statystyk dotyczących GPU i CPU ;) na ekranie ?

Widzę ze deb... którzy nie umieją dodawać 2 do 2 tez nie brakuje. Którym można wmówić wszystko i zakręcić marketingiem. Tylko problem ze przez takich jak wy, ja tez dostaje po głowie. Bo wy kupicie wszystko, to teraz mamy gry bez optymalizacji i wybrakowane produkty. Najśmieszniejsze jest to ze uważacie się za fajnych i inteligentnych. Gdzie ja wam współczuje, bo jesteście jak dzieci. Ciężko teraz o myślącego klienta takie mamy czas.

Akoro karty generują fałszywe klatki, to ja chcę zapłacić za nie piniędzmi z Monopoly.

Z ciekawości wbiłem na aukcje i ludzie na gwałt sprzedają 4080/4090. Jedni piszą wprost, że chcą kupić 50xx, a inni udają że ich nie potrzebują (w sensie 40xx) i oddają za skromną cenę mniej więcej za ile kupili szczególnie 4090 za 11 000 pln :D

Sprzedaje bo bede kupowal RTX 5090 za 18,000zl w lutym tego roku.

Praktycznie każda generacja kart dawała boost rzędu do 5% do 20% wydajności, w zależności od półki cenowej. Większy przeskok w ostatnich latach był chyba tylko między serią Maxwell a Pascal u Nvidii, czyli serii gtx 900 na gtx 1000. Ludzie o tym zapomnieli chyba przez zasłonę dymną w postaci technologii podbijających liczbę klatek na różne sposoby. Developerzy zaczęli przez to olewać optymalizację, co też pewnie przyczyniło się do postrzegania nowych układów za słabsze, niż są w rzeczywistości.

Z drugiej strony zmieniły się przyzwyczajenia graczy. Kiedyś dominowało 1080p, do którego dziś wystarcza karta z dolnej półki, tyle że do karty trzeba też dobrać procka, a niektórzy robią upgrade GPU i siedzą na dziesięcioletnich CPU.

Spopularyzowało się granie w 1440p, które wymaga większego nakładu środków. Dziś da się grać w 1440p na kartach w cenie, która kiedyś pozwalała max na 1080p.

4k to w ogóle luksus i nie powinno to nikogo dziwić, że najbardziej wymagające gry mogą mieć problemy z płynnością nawet na kartach z górnej półki - w końcu grafika nie stoi w miejscu. Normą było, że wychodziły gry, które w 1080p miały problem z trzymaniem 60 klatek na max ustawieniach na topowych układach graficznych (pomijam karty typu Titan X, bo to zupełnie inny segment i nisza). Jeśli dobrze pamiętam, to nawet Wiedźmin 3 nie trzymał 60 klatek na GTX 970, a na 980 co najwyżej bez hairworks a i tak dropiło w Novigradzie.

Chyba nikt cudów nie oczekiwał po nowych RTX-ach, skoro Nvidia dalej robi karty w technologii 4 nm. Boost 10-20%, do którego wszyscy powinni być przyzwyczajeni. No i przede wszystkim wszyscy powinni czekać na niezależne testy, bo marketing to sobie można w dupę wsadzić. Nawet demo, które puścili na CES nie miało pełnej rozdzielczości, bo renderowany obraz zajmował tylko pół ekranu. Wykresy z DLSS i MFG też nie powinny nikogo interesować, bo to może ratować graczy w sytuacji, gdy karta już nie domaga albo gdy daje radę, ale chcą więcej niż 60 klatek.

Jest szansa, że radeon 9070 XT odbije część rynku z rąk Nvidii, bo jeśli wycieki okażą się prawdziwe i zostanie dobrze wyceniony, to konkurencja będzie. Intel też sobie świetnie radzi w niższej półce, nawet do grania w 2k, problemem są sterowniki. Jeszcze 2-3 lata i może będzie liczniejsza konkurencja na rynku GPU. Tylko gracze muszą się ogarnąć i patrzeć na czystą moc układów, a technologie zwiększające klatki idąc na pewne ustępstwa traktować jako dodatek i zabezpieczenie na czarną godzinę.

Zabawne kiedy technologia DLSS miała na samym początku służyć temu by w większych rozdzielczościach można było utrzymywać stałe 60fps w grach (skalowanie oczywiście od 1080p minimum) to teraz stało się to być niezbędne by dawać rozsądną ilosć klatek w nieoptymalizowanych grach gdzie skaluje się gry do 1080p z 720p....

Nvidia waliła w ch, ale teraz dzięki tymi "sztuczkami" pokazując niby tą super wydajność to już odjechali na całego.

Całe to AMFM2 to jeden wielki chuj i ściema. Próbowałem to w Kiku grach. Owszem licznik FPS pokazuje zamiast 35FPS 70FPS ale te 70fps to tylko liczba. Odczucie z grania jest niewiele lepsze niż te owe 35FPS zwłaszcza przy bardziej dynamicznym ruchu. Obraz rwie, szarpie, laguje i wrażenie jest że gra się ciągle w owych 35FPS.

Po co mi AMFM2 w grach które bez niego mają 60fps a z nim 120fps? Żadna różnica. AMFM2 skoro już takie robią z tego halo powinno działać głównie w grach które słabo działają. Owszem licznik pokazuje piękne FPSy ale nic poza tym.

Poza tym te dodatkowe klatki to pokazuje tych licznik FPS wbudowany w sterownik grafiki. Zewnętrzne programy do liczenia FPSów nie pokazuję poza natywną liczbę FPSów - czyli te pokazują prawdę.

Próbowałem AMFMF2 na konsolach PC przenośnych w kilkunastu grach - wszystko o kant dupy potłuc.

Ta technologia nadaje się tylko i wyłącznie by w czasie rzeczywistym oglądać film w ponad 100k/s na "wybajerzonym" telewizorze lub monitorze, projektorze. W grach za duży input lag, a jak będzie technologia na tyle mocna by nie powodować input laga to procesor powinien wtedy dawać radę bez tych już "sztuczek".

Jest już test DLSS4 na RTX 5080. DLSS4 dostana wszystkie RTX'y a seia RTX 4000 otrzyma dodatkowe generowanie klatki i będa teraz generowane 2 a nie jedna dodatkowa klatka. Przy Multi Frame Generation dla 4 klatek jest aż 65 ms opóżnienia input lag i do tego opóźnienia na serwerze i łączu. Przy takim opóźnieniu nie ma sensu grać w gry multi...

https://www.youtube.com/watch?v=xpzufsxtZpA

https://www.youtube.com/watch?v=1UONsv11a8c&ab_channel=PlasmaTVforGaming teraz mam 5090. Tak invdia nas oszukuje. Ten program lepiej działa od skalowania invidi.

Panie Zbigniewie, trochę refleksji. Już opisywanie (i to pogrubioną czcionką) jakichś dziecinnych wymysłów z reddita wydało mi się mało rozsądne, ale pan jeszcze na koniec cytuje wypowiedzi z forum osób, które mają rynsztokową jakość. Może to są młode osoby, które muszą dojrzeć do pewnych rzeczy, zanim przestaną z byle powodu rzucać "kupami", "ch...ami", czy będą w stanie napisać komentarz bez "xD". Tylko po co to wszystko odgrzebywać i dodatkowo wyróżniać?