RTX 5070 zaoferuje „wydajność RTX-a 4090 za ułamek ceny”. Nvidia zaprezentowała najnowszą serię kart graficznych

Nie zaoferuje, zaoferuje wydajność minimalnie lepszą niż 4070, po prostu NVIDIA walnęła marketingową sciemę bo teraz DLSS będzie generował 3 klatki w FG zamiast jednej ;)

Że też nie macie wstydu wrzucać takie baity i brednie, które wyjaśnił już Kuba wyżej...

Orgazm alexa wystarczy żeby wiedzieć, aby trzymać się od tej generacji z daleka.

Podsumujmy.

Rynek cały czas idzie w stronę AI (zrozumiałe i oczywiście do przewidzenia). Czysta wydajność bez AI w tych pieniądzach jest śmiesznie lepsza w stosunku do poprzednich kart (również bez zaskoczenia a te tendencja będzie się nasilać). Nividia sprzedaje w zasadzie podobną fizycznie serię do poprzedniej ale odcina kupony oprogramowaniem. W porządku, mogą, ale pytanie czy to jest tyle warte? Są ograniczenia w produkcji procesorów dla zwykłego konsumenta i AI może być rozwiązaniem (wręcz wygląda na to, że musi) i jesteśmy sakazni na tę tendencję.

Ale...

Mam 4080 do 2k z zamysłem siedzenia na niej dobre kilka lat. I teraz pytanie ile w zasadzie odpaliłem gier wykorzystujących DLSS 3/3.5 oraz ile jest takich gier na rynku na ten moment (dodatkowo wciąż są gry które mają DLSS źle zaimplementowany). Z pamięci zmieszczę się na palcach dwóch rąk i oczywiście można teraz wylistować wszystkie gry, ale przypominam że wczystkich nie odpalicie. Po prostu jeden odpala co się da, a drugi uderzy tylko w kilka tytułów. Subiektywna kwestia.

Biorąc to wszystko pod uwagę to zakres odbiorców którym realnie opłaca się iść w nowe karty jest mały. Więc dwa razy zastanówcie się przed zakupem.

Osobiście nie podoba mi się taka tendencja i wszelkie stwierdzenia, że obraz generowany z DLSS nie odbiega jakością są śmieszne. Szególnie w dynamicznych grach. Zawsze obraz generowany przez AI będzie gorszy (patrzę na Ciebie STALKER 2). Mniej lub bardziej. Lepsza lub gorsza implementacja. Bardziej lub gorzej wprawne oko to wyłapie. Ale finalnie płacimy jakością i kuriozalnie optymalizacją w imię grafiki i drogiej technologii. Czegoś co niewielu chce a wielu się wmawia że ma sens.

Jesteśmy na portalu głównie o grach. Zatem. Chcemy lepszych gier i dobrze działających a niekoniecznie wyśrubowanych graficznie. Gdzie postęp w animacjach? Mechanikach (tu jest co raz gorzej)?

Finalnie jestem zniesmaczony obecnymi trendami rynkowymi częściowo popychanymi producentami podzespołów, a kolejna seria kart ponownie skłania do refleksji i sensowności zakupów.

Nie zaoferuje, zaoferuje wydajność minimalnie lepszą niż 4070, po prostu NVIDIA walnęła marketingową sciemę bo teraz DLSS będzie generował 3 klatki w FG zamiast jednej ;)

i o to chodzi abyś wykorzystał AI i miał realnie większą ilość FPSów. Przy spadku ms dla FG2 to właściwie to się nazywa postęp. Jak przeczytałem dzisiaj komentarze pod purelol to ludzie jednak nie mają żadnego pojęcia o czym piszą.

Że też nie macie wstydu wrzucać takie baity i brednie, które wyjaśnił już Kuba wyżej...

Nie spamuj już swojego copium.

Buahahaha chociaż RTX 4070 super jest pomiędzy 3090/3080TI tylko że bez DLSS czyli w natywnej RTX 5070 nie przegoni 4070 Super.

Dokładnie tak, a np w przypadku RTX 5070 Ti wydajność bez DLSS jest dokładnie taka sama jak w 4070 Ti Super - 44 TFLOPs.

i jakie ma to znaczenie jak z DLSS masz nie tylko więcej fps ale i lepszą jakość obrazu.

Takie, że żeby używać DLSS, a już szczególnie generowania klatek musisz spełnić szereg warunków - gra musi to obsługiwać (większość starszych tytułów zapewne nie dostanie patchy) + musisz mieć monitor/telewizor który obsługuje VRR. Ja np mam do PC podłączony bardzo porządny, ale już leciwy telewizor Sony, który ma HDMI 2.0 więc żadnego VRR nie obsługuje, stąd żadne generowanie klatek mnie nie interesuje, a wymieniać TV na razie nie planuję.

dla starych tytułów to 2080 jest overpower i limitem przy kilkuset fps staje się CPU.

Takie, że żeby używać DLSS, a już szczególnie generowania klatek musisz spełnić szereg warunków - gra musi to obsługiwać (większość starszych tytułów zapewne nie dostanie patchy) + musisz mieć monitor/telewizor który obsługuje VRR.

że co ? DLSS nigdy nie wymagał VRR co więcej FG też nie wymaga VRR, VRR to Variable Refresh Rate i odpowiada za zupełnie co innego. Co do implementacji DLSS to możesz zaimplementować to w każdej grze i każdy silnik.

Nie możesz włączyć FG z V-Sync, a bez V-Sync masz na ekranie potężny tearing, który jak dla mnie uniemożliwia komfortową rozgrywkę więc tak, bez VRR nie ma sensu podchodzić do FG.

lepszą jakość obrazu

No z tym to żeś akurat nieźle poleciał. Akurat DLSS pogarsza obraz, często co prawda nieznacznie, ale pogarsza.

Kuba_3 - sama technologia wyklucza działanie z VS ale działa z GS/FS pomijam już że te technologie są zaimplementowane obecnie w monitorach w cenie lepszej myszki czy klawiatury.

Herr Pietrus - to i jest przezabawne taki mądry pierdus a dalej mieszka w boomowie :) wykorzystaj swoje IQ (chyba że już wykorzystane maksymalnie a efekty są jakie są) :)

Gimemoa - to już było od czasów DLSS 2.0. chodzi o sam sposób działania w/w technologii

To akurat może być rewolucja (która przejdzie bez echa, bo nie ma słupków z pierdylionem FPS i 10x the performance), jeżeli input lag będzie porównywalny do grania "natywnie" to wyeliminowana zostanie największa wada frame generatora.

Trudno też uwierzyć że pazerna nVidia udostępni to dla starszych kart.

No i git, dzięki DLSS4 będzie można lecieć na RTX5060 i mieć wydajność 5090, szkoda tylko tych naiwniaków co faktycznie przepłacą za te droższe modele, niż 5060.

Przecież DLSS4 wszystko pokryje. Ważne, żeby gra chodziło w tych 60FPS minimum. Ja rozumiem, że żyjecie mentalnie jeszcze w czasach gdy powstawały jednostki nie mogące udźwignąć jakiejś gry na minimalnej grafice, ale te czasy są za nami.

W sumie to fajne czasy nadchodzą w których klasa sprzętu przestaje mieć znaczenie <3

Jeszcze trzeba miec z czego te fejkowe klatki generowac, a 5060 bazowych fps w bardziej wymagajacych tytulach da Tobie cale.. gowno, bo chyba nie myslisz, ze z bazowych 5 fps zrobisz sensowne 60 fps. Z gowna masla nie bedzie.

Zaoferuje wydajność na poziomie RTX 4090, ale... I tu lista gwiazdek z objaśnieniami. Jeśli już coś takiego ma być możliwe, to zapewne w użyciem nowego DLSS i FG. Niby spoko, bo liczy się efekt końcowy w postaci ilości klatek, tylko nie mówmy wtedy o wydajności. Po drugie, generowanie trzech klatek na jedną rzeczywistą? Pachnie potężnym input lagiem, zwłaszcza, jeśli bazowe będzie coś w stylu 30 fps. Chyba, że nowy Reflex uczyni cuda. Trzeba poczekać na rzeczywiste testy, a nie od razu się podniecać czy hejtować.

Obrzydzenie mnie bierze jak czytam twoje posty i patrzę na twoją naiwność.

Dają ci te technologie do gier które wyglądają gorzej niż to co ma 9 lat, a ty się cieszysz jak głupi:

h ttps://www.youtube.com/watch?v=eKGqtZc-xsQ

Wnioskuję, że nie jesteś długo na forum. Alex to totalny odklejeniec, jego nikt tutaj nie traktuje poważnie - on podnieca się dosłownie wszystkim co wychodzi na rynek.

on to cud postępu natury, jego GTX spokojnie se radzi na średnich w CP77 bez bugów i glitchów, u niego wszystko działa o niebo lepiej, dowodem na to są sponsorowane filmiki jakiegoś gościa z neta

dopóki będzie karmiony, to będzie wiecznie szczęśliwy

Podsumujmy.

Rynek cały czas idzie w stronę AI (zrozumiałe i oczywiście do przewidzenia). Czysta wydajność bez AI w tych pieniądzach jest śmiesznie lepsza w stosunku do poprzednich kart (również bez zaskoczenia a te tendencja będzie się nasilać). Nividia sprzedaje w zasadzie podobną fizycznie serię do poprzedniej ale odcina kupony oprogramowaniem. W porządku, mogą, ale pytanie czy to jest tyle warte? Są ograniczenia w produkcji procesorów dla zwykłego konsumenta i AI może być rozwiązaniem (wręcz wygląda na to, że musi) i jesteśmy sakazni na tę tendencję.

Ale...

Mam 4080 do 2k z zamysłem siedzenia na niej dobre kilka lat. I teraz pytanie ile w zasadzie odpaliłem gier wykorzystujących DLSS 3/3.5 oraz ile jest takich gier na rynku na ten moment (dodatkowo wciąż są gry które mają DLSS źle zaimplementowany). Z pamięci zmieszczę się na palcach dwóch rąk i oczywiście można teraz wylistować wszystkie gry, ale przypominam że wczystkich nie odpalicie. Po prostu jeden odpala co się da, a drugi uderzy tylko w kilka tytułów. Subiektywna kwestia.

Biorąc to wszystko pod uwagę to zakres odbiorców którym realnie opłaca się iść w nowe karty jest mały. Więc dwa razy zastanówcie się przed zakupem.

Osobiście nie podoba mi się taka tendencja i wszelkie stwierdzenia, że obraz generowany z DLSS nie odbiega jakością są śmieszne. Szególnie w dynamicznych grach. Zawsze obraz generowany przez AI będzie gorszy (patrzę na Ciebie STALKER 2). Mniej lub bardziej. Lepsza lub gorsza implementacja. Bardziej lub gorzej wprawne oko to wyłapie. Ale finalnie płacimy jakością i kuriozalnie optymalizacją w imię grafiki i drogiej technologii. Czegoś co niewielu chce a wielu się wmawia że ma sens.

Jesteśmy na portalu głównie o grach. Zatem. Chcemy lepszych gier i dobrze działających a niekoniecznie wyśrubowanych graficznie. Gdzie postęp w animacjach? Mechanikach (tu jest co raz gorzej)?

Finalnie jestem zniesmaczony obecnymi trendami rynkowymi częściowo popychanymi producentami podzespołów, a kolejna seria kart ponownie skłania do refleksji i sensowności zakupów.

Nareszcie sensowny post.

ze szczególnym uwzględnieniem:

/// Zawsze obraz generowany przez AI będzie gorszy ........ Mniej lub bardziej. Lepsza lub gorsza implementacja. Bardziej lub gorzej wprawne oko to wyłapie. ///

Wystarczy popatrzeć co się stało z ... Google Maps.

TRAGEDIA po całości.

To, że Ty mając kartę z górnej półki rzadko korzystasz z DLSS nie oznacza, że każdy ma podobnie. Ja na 4070 Super dość często go używam. Przykład? Cyberpunk 2077 w 4K, z najwyższymi detalami i RT (nie PT). Mam włączony zbalansowany DLSS, co oznacza rozdzielczość renderowania trochę poniżej 1440p. Nie mam zastrzeżeń do generowanego obrazu, chociaż gdybym zaczął się przyglądać, to bym pewnie wyłapał niedoskonałości. No ale coś za coś. Gdyby nie DLSS, to musiałbym zrezygnować z RT albo ciąć detale, co w znacznie większym stopniu odbiłoby się na grafice. O to w tym chodzi, żeby zyskać dodatkowe klatki bez znaczącego uszczerbku na jakości oprawy. Z tego powodu DLSS sam w sobie, to dobra technika, no tylko trzeba wiedzieć z czym to się je i jakie ma wady, a później dokonać wyboru. Nikt nie zmusza.

Jeśli zaś chodzi o newsy w stylu, że 5070 dorówna 4090, to cóż - w Internecie od dawna mniejszych czy większych bzdurek jest na pęczki. Nie wiem, czy autorem tej konkretnej jest sama Nvidia czy redaktorów poniosły wodze fantazji. Bez znaczenia. Trzeba poczekać na realne testy i ocenić. Chyba, że ktoś nie może wytrzymać i już preorder puścił, to sam będzie sobie winien, jeśli się zawiedzie. Tak, jak z grami. Tyle jest dzisiaj gadania, że wychodzą w stanie karygodnym, ale na preorderkach wydawcy chyba coraz więcej zarabiają. Bo nie można poczekać tygodnia czy dwóch, żeby zobaczyć, co jest grane.

Zgadzam się też, że nie każdemu nowe karty graficzne będą potrzebne, więc powinien pomyśleć dwa razy i być może sobie odpuścić. Myślenie nie boli, a mimo to mam wrażenie, że dzisiaj za ludzi muszą myśleć inni. Na przykład marketingowcy producenta kart graficznych, którzy próbują im wmówić, że nowe, wspaniałe karty uczynią ich życie lepszym. Nie uczynią, to tylko urządzenia do pykania w głupie gierki, a ludzie w dyskusjach, jak pod tym newsem, o mało sobie do gardeł nie skaczą, bo "moja racja jest najmojsza".

Jesteśmy na portalu głównie o grach. Zatem. Chcemy lepszych gier i dobrze działających a niekoniecznie wyśrubowanych graficznie. Gdzie postęp w animacjach? Mechanikach (tu jest co raz gorzej)?

To polecam kupic okulary VR.Paradoksalnie to tutaj gpu sa najslabszym ogniwem. Gry VR moglyby wygladac lepiej, ale sprzetowo po prostu nie da sie to spiac.

No i w VR wlasnie teraz sa najnowsze mechaniki i ciekawe rozwiazania. Widzialem teraz promke na q3 +gra+meta na 6 msc za 2k. To juz jest cena sredniego segmentu dobrego monitora. Na okularach mamy tryb kinowy, gdzie mozna ogladac filmy majac wrazenie rozmiaru obrazu jak w kinie. Juz nie mowie o yt i filmach 360 stopni.Naprawde czujemy sie jakbysmy tam byli fizycznie.

Gier VR jest zatrzesienie. Naprawde normalnie funkcjonujacy czlowiek nie ma szans tego ograc.A jeszcze mody, ktore umozliwiaja odpalenie gier , ktore nigdy nie byly robione pod VR to wisienka na torcie (GTA 5, RDR 2). Piszac o grach nie mam na mysli jakies podpierdolki.

Takie gry jak Lone Echo i 2 czesc powinny byc w topie gier i bija na glowe wiekszosc zeszlorocznych GOTY na nalesnikach. No, a nawet nie napisalem o symulatorach jazdy,samolotow w ktore mozna wykrecac tysiace godzin. Ja coraz mniej gram w gry nalesnikowe.

Wszystkie sa juz praktycznie na jedno kopyto. Zmieniaja sie settingi, ale mechanicznie to wszystko to samo. Nawet wielbione BG3 to wszystko juz bylo.Czy moge w nich bronic sie krzeslem przed headcrabem? Czy mam brazowe gacie bo wlasnie w Fallout 4 bedac w pancerzu i majac w reku dzialko vulkan szarzowal na mnie dorosly Deathclaw.

Moglbym wymieniac i wymieniac momentyw grach VR,ktore bede pamietal do konca zycia i w mojej dlugiej karierze gracza w koncu cos pachnie nowoscia jak pamietam w latach 90.Gdzie praktycznie kazda gra to bylo cos nowego graficznie i gameplayowo.No, a nie przemielona milion razy ta sama parowka opakowana w ladne opakowanie i przyklepana znaczkiem AAAA.

Podsumowujac moj wywod. Jezeli ktos chce cos nowego w grach to dzisiaj to znajdzie, ale w grach VR. Nowe doznania i interakcje, ktore sa niedostepne dla gier na 2d monitorach i tv. Niestety tak jak w czasach dos, kiedy walczylo sie o kazdy kb pamieci. Tak teraz sie walczyl o kazdy fps w grach VR i ich najlepszy wyglad. Mam nadzieje, ze nowe gpu dadza kopa grom w VR. Bo dzisiaj posiadajac nawet 4090 trzeba isc na duze ustepstwa.

Dokładnie, też mnie to nie cieszy takie podejście.

Grafika niby coraz lepsza, ale wymagania też coraz większe, choć graficznie wygląda podobnie co 5 lat temu. A nie tylko animacje i mechaniki, ale również wiele innych elementów stoi, choćby fizyka i AI wrogów.

Jeśli wyjdzie, że 5070 jest szybszy od 4090 to ludzie tego psychicznie nie wytrzymają ale na otarcie łez 24 GB vram.

5070 nie bedzie nawet szybsze niż 4080, będzie to poziom 4070ti super +/-

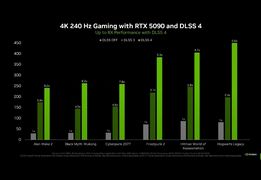

Skoro 5080 w teście CP77 pokazuje dwukrotną moc 4080s to tak zapewne będzie.

Skończyła się walka na czystą moc. Teraz walczą programowe generatory. Bang!

Ciekawy jestem działania FSR 4. Może być też spora różnica między rx9070 a rx7800 pomimo że komuś teraz wydaje się że to podobne karty.

Skończyła się walka na czystą moc. Teraz walczą programowe generatory. Bang!

Jak uplynniacz MFG bedzie we wszystkich grach dostepny i bedzie dzialal bez opoznienia, i artefaktow w obrazie to mozna sie cieszyc.

Wiadomo tez, ze jak karta natywnie wygeneruje mala ilosc bazowych fps to MFG magicznie nie zrobi z tego masełka. Na pokazie Nvidii MFG prezentowany był z DLSS Performance (skalowanie 1080p na ekranie 4K), ktorego malo kto uzywa.

Pozostaje tez kwestia vramu. W przypadku Indiany w 4K z PT zabraklo dla 4080/4080S pamieci i roznica siegnela prawie 70% na korzysc 4090 gdzie normalnie wynosi 30-35%.

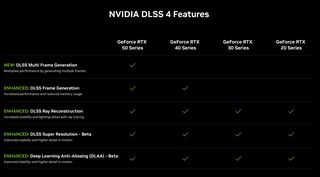

Nie wiem tez czy wiesz, ale seria 40x0 dostanie wszystki skladowe DLSS4, oprocz MFG, wiec korzysci nowego skalowania dotycza tez serii 40x0.

"Gdy karty graficzne GeForce RTX serii 50 trafią na półki sklepowe, gracze korzystający z kart GeForce RTX serii 50 będą mogli zwiększyć wydajność dzięki technologii DLSS Multi Frame Generation w 75 grach, a wszyscy użytkownicy kart GeForce RTX będą mogli zapoznać się z nowymi technologiami Transformer-Based DLSS Ray Reconstruction, DLSS Super Resolution i DLAA w ponad 50 grach"

Mnie osobiscie interesuje 5090 albo przeskok juz na 6090.

Widzę ze już nie które pelikany łapią ten bełkot marketingowy. Problem ze ten frame generator nie działa idealnie. (artefakty, ghosting, input lag ale to maja poprawić). Ta technologia potrzebuje jeszcze czasu żeby się rozwinąć.

Czyli zaoferuje coś co wygląda jak wyższa wydajność.

Coś co ją przypomina. Imituje.

ale bzdury :) tak to jest jak nie ma się żadnego pojęcia o czym się mówi :)

DLSS4 będzie dostępne dla wszystkich poczynając od serii 2xxx, jedynie FG będzie dla 4xxx i MFG dla 5xxx. Poprawa w DLSS4 jest bardzo duża względem 3.5 co i tak dawno ustawiło NV daleko przed kartami i technologią FSR od AMD.

Jeśli chodzi o DLSS to w zależności od wybranego trybu P/B/Q mamy inną wejściową rozdzielczość do budowy obrazu. I teraz uwaga bo dalej powielanie głupot. Opóźnienie jest tym mniejsze im jest więcej klatek bazowych. Czym więcej na początku klatek bazowych a wiadomo że w DLSS będzie więcej tym mniejsze ms dla budowanego obrazu niż w Natywnej (zupełnie inna wydajność np. 1440p -> 4K względem 4K bazowego). I teraz uwaga bo dalej niektórzy muszą włączyć myślenie dodanie FG czy MFG może spowodować (to zależy od bazowej wydajności budowy obrazu) niższe opóźnienie niż przy obrazie natywnym. Z prostego przełożenia obraz budowany jest z 1440p np. ma 60 klatek wyjściowych do 4K, a w natywnym np. ma 45 klatek (to jest tylko przykład) który i tak zawsze będzie pokazywał to samo obraz budowany w DLSS ma więcej klatek bazowych i niższe opóźnienie na starcie.

I teraz przezabawne jest to że ktoś pisze (włączenie FG czy MFG wywali opóźnienie w kosmos). Doda opóźnienie ale do bazowego które sumarycznie może być niższe / podobne jak przy natywnym.

3 dodatkowe klatki przez AI które są generowane na podstawie bazowej to nie wrzucenie mirrora klatki (jak ktoś nie wie jak to działa to powiela kolejne bzdury o "fejkowych" klatkach). Jeśli wszystko będzie działać poprawnie a wychodzi że będzie to dostaniecie w zależności od wybranego trybu przemnożenie bazowej wartości. I teraz uwaga seria 4xxx ma FG a seria 5xxx ma MGF i jeśli wyjściowe dla np. 4090 będzie 70fps a z FG np. 120 to w przypadku takiej karty jak 5070 wyjściowe może być np. 45 ale przemnożone przez 3-4 może dać 120-140 i w tym przypadku pokryje się wydajność. I teraz ktoś napisze ale to są sztucznie włożone klatki. I też nie to nie są klatki zduplikowane jako rama tego samego obrazu. Już prościej chyba też się nie da wytłumaczyć.

Jak ktoś przeczyta to co wyżej z dwa razy to może w końcu zrozumie że to co dostarczyła NV to jest najlepsze co gracze dostali od dawna. Jeśli wszystko będzie działać poprawnie nie trzeba będzie kupować karty za 10K aby mieć 100-120fpsów taka karta jak 5090 będzie skierowana do osób które chcą wycisnąć 166-240 lub i więcej fpsów pod pokrycie ich odbiorników w odświeżaniu 1:1.

I za moment pojawi się kuba czy inny twardogłowy i napisze :) ale przecież to nie jest wydajność w czystej restyryzacji (sucha wydajność bez DLSS/FSR) no nie jest ale co z tego ? Użytkownika końcowego interesuje to jak wygląda obraz i jak coś działa a nie na jakiej zasadzie to działa. Istotne jest to aby działało to dobrze.

I teraz uwaga seria 4xxx ma FG a seria 5xxx ma MGF i jeśli wyjściowe dla np. 4090 będzie 70fps a z FG np. 120 to w przypadku takiej karty jak 5070 wyjściowe może być np. 45 ale przemnożone przez 3-4 może dać 120-140 i w tym przypadku pokryje się wydajność. I teraz ktoś napisze ale to są sztucznie włożone klatki. I też nie to nie są klatki zduplikowane jako rama tego samego obrazu. Już prościej chyba też się nie da wytłumaczyć.

No tylko dla 5070 bazowa liczba klatek, to 45, co będzie powodować większego input laga, niż dla 4090 z jego 70 klatkami. Dlatego pisanie, że 5070 osiągnie wydajność 4090 niby jest prawdą, ale ma swoje haczyki. I tu jest problem. DLSS, to fajna technika, tylko tego rodzaju marketing powoduje, że ludzie się wkurzają. I trochę słusznie, bo nie jest do końca prawdą, że 5070 osiągnie wydajność 4090 - generowanie klatek ma swoje ograniczenia. Ty podałeś przykładowe 45 fps, jako bazowe, ale jeśli będzie to 30? Wtedy zrobienie z tego 90 może skutkować już masakrycznym input lagiem i jest już niemalże kłamstwem mówienie, że w takim przypadku 5070 dorówna 4090. W tym rzecz, a więc w marketingu, który wychwala coś pod niebiosa, ale przemilcza haczyki, które się za tym kryją.

Ty i ja wiemy, jak działa DLSS i FG, ale ktoś inny może nie wiedzieć, kupić tańszą kartę, a później się rozczarować, bo niby liczba klatek się będzie zgadzać, ale granie będzie jakieś takie nieprzyjemne.

I za moment pojawi się kuba czy inny twardogłowy i napisze :) ale przecież to nie jest wydajność w czystej restyryzacji (sucha wydajność bez DLSS/FSR) no nie jest ale co z tego ? Użytkownika końcowego interesuje to jak wygląda obraz i jak coś działa a nie na jakiej zasadzie to działa. Istotne jest to aby działało to dobrze.

Faktem jest, że grafika w grach komputerowych, to festiwal sztuczek i oszustw. To nie jest tak, że jeśli ktoś przemierza świat, przykładowo, Cyberpunka, to całe Night City jest zawsze wygenerowane w pamięci w pełnej jakości. Generowane jest to, co widzi gracz, w jakości zależnej, na przykład, od odległości. Im dalej, tym mniejsza szczegółowość. DLSS, to po prostu kolejny trik, który ma odciążyć sprzęt i zapewnić możliwie jak najlepsze wrażenia wizualne. No tylko znów kłania się marketing, a nie mówienie, jak jest. Szkoda, bo to bardzo dobra rzecz, w końcu nie trzeba redukować detali, żeby uzyskać więcej klatek, spadek jakości grafiki jest nieznaczny, tylko niedopowiedzenia powodują, że ludzie nie rozumieją, co się dzieje i myślą, że się ich w konia robi. Po części mają rację.

Prawda w podanym przypadku 5070 i 4090 45 i 70 imput lag będzie większy po stronie 5070 i też prawda jak bazowe będzie 30 to już mogą być granice akceptacji imput laga. Niemniej w przypadku kiedy mamy 60 wyjściowe lub okolice w natywnej i przejdziemy w DLSS to prawdopodobnie dostaniemy ok. 200fps w DLSS4 z podobnym imput lagiem jak w natywnych 60 (mówimy w obrębie tej samej kart natywne vs DLSS4) i tutaj to jest przełom. 30 stycznia będzie wszystko jasne lub i wcześniej.

No tylko sam DLSS, to co innego niż FG, a to niby zrównanie wydajności 5070 i 4090 jest zasługą również generowania klatek. Gdyby chodziło tylko o DLSS, to co innego. Kolejna rzecz, input lag przy bazowych klatkach na poziomie 30, z których FG zrobi 90, nie będzie na granicy, tylko najpewniej będzie nie do przyjęcia. Dlatego jest mocnym nadużyciem twierdzenie, że nowa 70-tka zrówna się z topową kartą poprzedniej generacji. To oczywiście nie zmienia faktu, że nadchodzące modele mogą przynieść spory wzrost "czystej wydajności" i być jak najbardziej warte zakupu. No tylko nie można tak bezkrytycznie podchodzić do tego rodzaju marketingu, który jest w dodatku niepotrzebny, jeśli seria 5000 rzeczywiście ma argumenty. Chyba, że ma takie średnie. Niedługo się przekonamy.

Powoli, pomalutku, nVidia właśnie skręca z "nowa karta, więcej mocy w bonusie DLSS" do "nowa karta, nowy DLSS, trochę więcej mocy". Trzeba być naprawdę bardzo krótkowzrocznym, aby nie zauważyć gdzie to zmierza (zwłaszcza biorąc pod uwagę, że nVidia nie otwiera się ze swoimi rozwiązaniami na innych) i trzeba mieć naprawdę wyprany mózg, aby to pochwalać. Uzależnianie wydajności od AI to tragedia, bo wchodzimy tutaj bardzo mocno w uzależnienie od softu. Wszystkim przyklaskującym gratuluje braku wyobraźni, bo jeśli to się przyjmie, to znając nVidię, zaraz będziecie mieli dodatkowe, zablokowane przez software, płatne ficzery do kart. Intel starał się to zrobić w prockach, nie wyszło, ale nVidia jak już za pośrednictwem swoich wyznawców będzie miała wszystko, to...powodzenia :) Wisienka na torcie jest sama jakość gier pod względem kodu + to jak będzie to działać u konkurencji.

A jeśli komuś się wydaje, że przesadzam, to niech przejrzy jak postępował rozwój tej firmy i dzięki inwestycjom w co tak się rozrosła. Trzeba być bardzo, bardzo naiwnym aby założyć, że nVidia nie będzie chciała zarobić na tym samym w przypadku rynku konsumenckiego, wszystko już mają :]

Ludzie są ślepi i myślą, że coś takiego jak wymagania gier istnieją, a nie istnieją przynajmniej od 15 lat, wszystko jest sztucznie podtrzymywane, chyba Google chciało to zmienić jeszcze z 2 lata temu ale zostało szybko spacyfikowane przez pożytecznych idiotów i konkurencję czyli Nvidię.

h ttps://komorkomania.pl/koniec-grania-w-chmurze-google-zamyka-stadie-ale-w-sposob-godny-pochwaly,6817677975059296a

Dokładnie, jak to się przyjmie to np na Multi-Frame-Generation może zostać wprowadzony miesięczny abonament, nie zapłacisz to graj sobie bez :)

Orgazm alexa wystarczy żeby wiedzieć, aby trzymać się od tej generacji z daleka.

Ja tam liczę na płynne granie w 8K + 200fps w 4K w cyberpunku na 5090tce. Więc jeśli o mnie chodzi to tak czekam na premierę.

A.l.e.X nie bierzesz kilka rzeczy pod uwagę. Optymalizacja. Wierzysz serio, że w 2025 wszyscy zaczną wydawać gry bez błędów? Telewizory 8K pozwalają na wyświetlanie pikseli niewidocznych dla ludzkiego oka. Czy dochodzimy do momentu, w którym rozdzielczość ekranów rośnie tak bardzo, że nie zrobi to dla nas różnicy. Po co nam tyle milionów pikseli w telewizorach, skoro nie możemy ich zobaczyć? Ludzkie oko ma swoje własne ograniczenia fizjologiczne i pole widzenia wynoszące około 135 stopni. Producenci telewizorów używają tzw. rozdzielczości kątowej, czyli liczby pikseli przypadających na jeden kąt widzenia, aby wyjaśnić jakość swoich ekranów. Im bliżej jesteśmy ekranu, tym lepiej widzimy piksele, im dalej od ekranu, tym szersze pole widzenia.

Przykładowo, obecnie standardem pozwalającym oglądać rozdzielczość 4K jest posiadanie 55-calowego ekranu umieszczonego dokładnie 1 metr od naszego wzroku. W przypadku telewizorów 8K mówimy o ekranach o przekątnej ponad 75 cali w odległości 1,50 metra. Pojęcie to nazywane jest odległością Lechnera, która określa odległości, przy których ludzkie oko jest w stanie rozróżnić szczegóły w rozdzielczości telewizora.

Techpowerup gotowy na premiere 50x0. Nowa platforma na procesorze 9800X3D i nowe gry do testow.

"Aby przygotować się na pojawienie się kart graficznych nowej generacji, które pojawią się na rynku w styczniu 2025 r., przeprowadziliśmy ponowne testy wszystkich istniejących kart graficznych na nowym komputerze. Na przystawkę postanowiliśmy zaprezentować wyniki wydajności tych kart."

https://www.techpowerup.com/review/gpu-test-system-update-for-2025/

Te karty to wielka ściema i robienie z ludzi idiotów. Natywnie mają moc na poziomie poprzedniej generacji serii 4000. Spokojnie ta technologia Multi Frame Generation mogła być zaimplementowana w serii 4000 tylko chodzi o skok na kasę. Już w sieci latają "cudowne" testy wydajnościowe kart RTX 5090 które NIE RADZĄ sobie natywnie w 60 FPS przy rozdzielczości 4K w takich tytułach jak: Alan Wake 2, Black Myth Wukong, Cyberpunk 2077. To tylko pokazuje jak można się dać nabić w butelkę.Ale jest ponoć szansa że nieoficjalnie uda sie odblokować obsługę Multi Frame Generation na kartach serii 4000 które już mają Frame Generation. Przypominam że Multi Frame Generation wymaga również mocnego procesora by móc wygenerować do 3 dodatkowych klatek z wykorzystaniem AI a nie 1 dodatkową jak miało to miejsce w Frame Generation (to nie są oczywiście klatki generowane w 100% zgodnie z prawdziwym obrazem który wytwarza karta a tylko ich imitacja, co może oczywiście prowadzić do artefaktów graficznych). Poza tym generowanie az 3 dodatkowych klatek powoduje znaczny input lag który juz był odczuwalny w niektórych tytułach przy włączonym Frame Generation. Nie byłbym tak optymistyczny patrząc na prawdziwą wydajność tych kart - stąd też ta niby "niska" cena sugerowana przez NVIDIA.

No i ostatnia sprawa to że NVIDIA ma ponoć wydawac teraz nowe serie kart znacznie częściej jak to miało miejsce w poprzednich latach. Czyli doszli do wniosku że mniejszym kosztem ale częściej będą sprzedawać prawie ten sam produkt pod inną nazwą z wykorzystaniem technologii które mogły być swobodnie implemetowane wcześniej i nie wymagają znaczących modyfikacji sprzetowych.

Obawiam sie że może to być najgorsza seria kart ze względu na korzystanie z ułomnego generowania wielu klatek przez AI a na dodatek zwolni to deweloperów z optymalizacji swoich produktów w przyszłości co będzie tragiczne w skutkach.

Wiadomo że 9070 będzie na zasilaniu 2x8pin, 9070 xt zasili 3x8 pin.

Podoba mi się ta pierwsza.

AMD celuje w średnią półkę, dobrze gdyby ugruntowały mocniej tu pozycje i skupiły się na 1440p

Beta test na targach 9070

https://www.telepolis.pl/tech/sprzet/karta-graficzna-amd-radeon-rx-9070-test-wydajnosc