AMD zaprezentowało nowe karty graficzne z serii RX 7000

Wkradło się kilka błędów - zamiast rtx 4090 jest "4900" a zamiast 899 $ jest "899%"

Co do samych kart to wygląda to naprawdę fajnie, topowa karta sporo tańsza od 4080, o 4090 nie mówiąc. Pytanie jak się to ma do wydajności... Na plus na pewno pobór prądu.

Dziwi mnie tylko to nazewnictwo. Początkowo "XT" robiło za coś w rodzaju "Ti" od Nvidii. Potem używali jeszcze "50" a teraz dodali "XTX".... Nie za dużo aby tych dodatków? Wolałbym gdyby dawali po prostu seria kart, półka cenowa oraz XT dla podrasowanych wersji. Ewentualnie "50" dla odświeżonych układów plasujących się pomiędzy wcześniej wydanymi. To XTX to już moim zdaniem przesada.

Ale to drobiazg, ważne żeby same karty były dobre...

Dzięki za wiadomość, już poprawiam błędy.

Również liczyłem na więcej informacji porównawczych, szczególnie z kartami Nvidii. Niestety trzeba będzie na nie jeszcze poczekać.

ja jestem ciekaw na ile fsr 3 poprawi jakośc . bo wydajność i tak już spox ważniejsze aby mydło zmyli. bo wygląda to spoko dopiero na 8k. Wtedy różnica się załamuje. do dlss brakuje sporo. ale skoro nowa aktualizacja może nie będzie to problem. planuje zakup za 999. jeszcze trzeba zlokać bo 50 % rt względem starej seri to dalej w tyle za nvidią. ale przynajmniej tu dostaniemy czystą moc za normalną cenę,. i to jeszcze 24 gb w zapasie . no ja jestem zadowolony. teraz tylko jak mówie ten software jak to będzie wyglądało na 3 generacji. i czy fsr 3.0 dostaną wszystkie gry z 2.0

" RX 7900 XTX i RX 7900 XT uwzględniają teraz akceleratory AI, co sugeruje, że FSR 3.0 może je wykorzystać. AMD wciąż jednak nie mówi o tym konkretnym szczególe.

Zapytany o FSR 3.0 i jego potencjalne wykorzystanie AI przez Jarreda Waltona z Sprzęt Toma, Kierownictwo AMD odpowiedziało po prostu: „Obecne wersje FSR nie wykorzystują uczenia maszynowego”.Niech zaczną xD

a tu co innego https://youtu.be/_3Z8Ba6mrl4

Jeżeli dobrze policzyłem, XTX będzie na poziomie RTX3080Ti (1.5 razy większa wydajność w raytracingu od poprzedniej generacji). Czyli niestety "słabo" - bo w sumie nic nie zmieniło się w kwestii cena/FPS.

"50% more performance per CU" czyli trzeba jeszcze przemnożyć przez większą ilość CU w nowej generacji: 96/80*1.5 = 1.8.

IMO dość by nadgonić topowe Ampery, ale Lovelace wciąż poza zasięgiem niestety.

I jak z wydajnością topowego modelu amd w porównaniu z topowym modelem nv?

Ta karta będzie gorsza od RTXa 4090 o jakieś 15-20%, ALE będzie kosztować 2 razy mniej i pobierać znacznie mniej prądu, przez co nie trzeba zmieniać zasilacza, albo nawet obudowy i martwic się, że kabel będzie się topił.

To nie rywal RTXa 4090, bo to kompletnie inna półka cenowa. Ta karta to rywal RTXa 4080 16, który będzie za 1200$, ale to wciąż 200$ więcej, a to dużo.

Karta rywalizuje z 4080 nie z 4090

jeśli chodzi o czystą moc to rywalizacja z 4080 raczej wygrana. jeśli chodzi o AI + RT to bardziej rywalizacja z 3080ti . straszny rozstrzał . przydało by się jeszcze z 10 % więcej zrdzeni rt i lepszy soft z uczeniem maszynowym wreszcie

Takie porównanie się pojawi przy testach niezależnych. Bez sensu są takie porównania robione przez Nvidię czy AMD, bo oni dobierają sobie gry tak, by wyszło na ich korzyść. Tego typu porównań Nvidia vs AMD robionych przez AMD czy Nvidię, nie ma sensu pokazywać, zawsze będą zmanipulowane.

Zupełnie odwrotnie. Tak jak od swojej zapowiedzi 4080 nie miał żadnego sensu ekonomicznego, tak teraz ma go jeszcze mniej.

4090 pozostaje nietknięty, ale jeśli nvidia nie obniży ceny 4080 to pies z kulawą nogą się nim nie zainteresuje.

Dokładnie. Jeżeli testy potwierdzą slajdy AMD, to RTX4080 przegrywa w rasteryzacji, mimo bycia droższą kartą.

Wybór będzie opierał się głównie na tym, czy ktoś chce Raytracing (bo 1.5 lepsza wydajność w RT u AMD oznacza poziom RTX3080Ti), DLSS czy czystą moc.

No i AMD wydaje się być znacznie lepsza karta pod rozdzielczości mniejsze od 4K - nawet RTX4090 nie jest w stanie wyciągnąć tyle fpsow w Warzone co niby nowe AMD w fullHD.

4080 jest naprawdę mocno "przycięte" w tej generacji. Patrząc po samych teraflopach oferuje raptem jakieś 59% mocy obliczeniowej wyższego modelu (dla porównania 3080 miał 83% teraflopów 3090).

Tak więc wcale tak łatwo 80-tka ie będzie miała z ta ceną imo.

W cyberpunku w jednej z najbardziej wymagajacych gier z RT, 3090ti ma okolo 20-30% lepszy wynik i tylko w rozdzielczosci 4k, gdzie karta amd traci z powodu przepustowosci pamieci co zostalo poprawione w serii 7900.

Też nie słyszałem o testach, gdzie 3090Ti byłaby 3 krotnie silniejsza. RX6950 jest o 50% słabsze w RT od RTX3090Ti:

https://www.techpowerup.com/review/amd-radeon-rx-6950-xt-reference-design/32.html

Będzie "DO" 50% silniejszy - czyli w większości gier bedzie i tak przegrywał z RTX3090Ti, plasując się na wydajności pomiędzy RTX3080Ti a RTX3090Ti.

dodaj do tych wynikow 50-70%

https://www.youtube.com/watch?v=ark-nGbS-ak

https://www.youtube.com/watch?v=XX-ePtP1tW8

Ja cały czas piszę o RT. W teście który podałeś żadna gra nie była testowana z włączonym RT (chyba że ślepy jestem). Poza tym, mało rozpoznawalne źródła z tych filmików.

Samo AMD podało na swoich slajdach do 50% więcej wydajności, i w jednej grze podali 60% - wiadomo że nie wybrali najgorszych przypadków, więc skoro udało im się w 2/3 testów uzyskać 50% wydajności w RT, bo w rzeczywistości to będzie maks jaki osiągną te karty, co plasuje je tuż za RTX3090Ti.

Masz także testy chociażby na Tomshardware:

https://www.tomshardware.com/reviews/amd-radeon-rx-6950-xt-review/4

Od połowy, na drugich wykresach, jest średnia ilość fpsów dla gier z RT.

Dla RTX3090Ti jest to 31.5.

Dla 6950XT Sapphire 19.2 - czyli RTX3090Ti jest w RT średnio 60% mocniejszy.

Takze jak dla mnie 7900xtx bedzie prezentowal podobny poziom w raytracingu co 3090ti, natomiast w rasteryzacji bedzie od niego znacznie wydajniejszy.

No, ale to sie okaze po premierze narazie to wszystko przy zalozeniu, ze slajdy amd sa prawdziwe, a tego nie mozna byc pewnym, bo nvidia i amd potrafi niezle lgac na swoich prezentacjach.

AMD podało DO 70%.

I podało przykłady testów gier z RT, gdzie dwie miały 50%, jedna 60%.

Myślenie życzeniowe, że przegoni RTX3090Ti nie zmieni faktów - o ile AMD nie zaniżyła wyników (a po co miała by to robić), to karta w RT nie dogania RTX3090Ti.

zakończmy na tym że jak ktoś bardzo chce mieć więcej gier z si (jednak dlss to exkluziw) i to 20-40 % więcej klatek w rt pewnie . to wybierze 4080-4070ti

Jeśli ktoś chce CZYSTĄ NIESKALANĄ MOC. z dobrze prosperującym softwerem (ale wymagającym troszeczki poprawy jakości w nowych wersjach) bo już wydajności mamy sporo. to wybierze xtx. I chyba mnie właśnie najabardziej boli że to dlss to exkluziw. AMD gdyby też zrobiło exkluziw wtedy bym patrzył na gry które zagram next 3 lata. bo pewnie znowu wrócę na nvidie za 3 lata . Jednak wtedy przy 8k tv i możliwości przez SI będzie dla mnie ta exkluzywność dlss NAPRAWDE DUŻO ZNACZYŁA. Chyba że amd wgra jakoś fsr do każdej gry z poziomu sterowników. To była by miła sprawa :D

Karty idealne do grania w 4k ze wszystkimi ustawieniami na maksa, no może trochę z raytracingiem będą problemy, ale ta opcja mniej najmniej obchodzi akurat.

Na Reddicie wysnuto wnioski na bazie danych z prezentacji AMD i testów Techspotu - podano średnią liczbę fps dla 13 gier w 4K:

So stack will probably look as follows for raster

- 4090 144 fps ($1,600)

- 7900XTX 131 fps ($999)

- 7900XT 115 fps ($899)

- 4080 16 110 fps ($1,200)

- 4080 12 90 fps ($900) - or whatever it's renamed to

For RT it might be more like (I did raster * 0.65 for NV and raster * 0.5 for AMD here)

- 4090 94 fps ($1,600) 66 fps with new scaling

- 4080 16 72 fps ($1,200) 51 fps with new scaling

- 7900XTX 65 fps ($999) 41 fps with new scaling

- 4080 12 59 fps ($899) 41 fps with new scaling

- 7900XT 55 fps ($899) 37 fps with new scaling

Jeśli AMD dowiezie, to oferta jest super.

Faktycznie dla tak wysokiej półki cenowej wygląda to dość ciekawie. Mnie jednak, pewnie tak jak i większość interesuje półka cenowa 500$ lub poniżej. A tutaj nie ma co spodziewać się dramatycznych różnic w wydajności w tej samej cenie. Poza tym wydajność RT znowu bardzo kiepska, a FSR 3 pewnie i tak będzie działać gorzej niż DLSS3.

Mnie tam interesuje półka do 250$, bo chcę upolować 6600XT w okolicach Black Friday ;)

A tutaj nie ma co spodziewać się dramatycznych różnic w wydajności w tej samej cenie.

Dlaczego nie? Skoro ich obecna topowa karta kosztuje 1000$, to średni segment też powinien być sensownie wyceniony. RX 6900 XT kosztował na premierę tyle samo co 7900 XTX, a był pewnie gdzieś o połowę słabszy.

Zakładając, że wzrost wydajności modeli z tej samej półki pomiędzy następującymi seriami jest liniowy, 7700 XT powinien być gdzieś między 6800, a 6800 XT, w dodatku przy niższym poborze prądu.

Poza tym wydajność RT znowu bardzo kiepska, a FSR 3 pewnie i tak będzie działać gorzej niż DLSS3.

Powiedziałbym, że wydajność wszystkich kart, poza 4090, jest kiepska w RT. To chyba jedyna, która pozwala grać z RT, bez kompromisów w postaci niższej rozdzielczości, czy obniżania innych ustawień. Chociaż nadal nie da rady w 144 fpsach.

Jak teraz o tym myślę to amd wygrywa z 4080 jeśli chodzi o dlss. bo bez upscalingu ma tyle fps co nvidia z nim na quality (nie licząc 3.0 wersji ) jeśli chodzi o exkluzywność. Więc jakby sprawy nie ma większej dużo nie tracimy. A w rt jeśli nawet straci 20 % to worth tego że czysta moc większa

Żeby się nie skończyło tak, że jak się zacznie promocja z grami to karty nagle o parę stów podrożeją :P

Widać jednak, że chcą się wyprzedawać, czyli resztę kart 7000 może zobaczymy całkiem wkrótce.

Hmmmm. 7900 XTX ma być za około 6tys - za tyle można teraz dostać 3090Ti.

Zastanawiam się co wybrać, bo znając życie to w dniu premiery w polskich sklepach, Radeony będą miały zawyżone ceny, plus trzeba będzie czekać oraz fajnie by było w końcu olać Nvidię za to co ostatnio odwala.

Jak się zaczaisz w pierwszej minucie sprzedaży to powinieneś kupić w cenie premierowej, podwyższanie cen się zaczyna jak im się kończą stany.

Hmmmm. 7900 XTX ma być za około 6000tys - za tyle można teraz dostać 3090Ti.

6 000 000 Złotych? Ale inflacja zapiernicza.

7900xtx bedzie znacznie wydajniejszy w rasteryzacji, a w raytracingu beda mialy podobna wydajnosc.

Ja tam celuję w jak najpłynniejsze 1080p (przy 23 calowym monitorze więcej mi nie trzeba), a RT mi wisi, także RX 7900 XT powinien być niezłym wyborem na kilka najbliższych lat, lepszym niż np. RTX 4080 czy cokolwiek z serii RTX 30XX.

To nie lepiej juz na steam decku grac niz na takiej malej rozdzialce i malym monitorze?

RX 7900 XT to też trochę overkill do 1080p - chyba że planujesz także zmienić w nieodległym czasie na jakieś 1440p lub 4K.

Ja podchodzę do tego długofalowo, wolę mieć kartę, która uciągnie mi wszystko na maksa w 60FPS/1080 przez 5-7 lat, niż bawić się w zazwyczaj niewiele wnoszący RT, czy wyższe rozdziałki, bo na moim monitorze gołym okiem różnicy i tak nawet nie zobaczę. Oczywiście nie mam nic przeciwko 1440p, ale dla mnie to raczej wisienka na torcie, niż wyznacznik komfortowego grania (tak jak chociażby 60 FPS, które uważam za absolutne minimum).

Obecnie siedzę na GTX 1070, który wszystko jeszcze odpala, ale raczej w średnio-niskich ustawieniach, więc przesiadkę muszę zrobić. Seria 40XXX się moim zdaniem finansowo nie opłaca, więc do tej pory myślałem raczej o RTX 3080 lub RTX 3080TI, ale biorąc pod uwagę niewielkie różnice cenowe względem nowych GPU od AMD, 7900 XT wydaje się być po prostu lepszym wyborem, także z uwagi moje priorytety i preferencje.

7900XTX będzie ostro zapychał 1080p procesor.

W jakim sensie "zapychał"?

Też mi się wydaje, że 1080 to trochę mało do takiej karty. Osobiście planuję przesiadkę na 1440 po zakupie nowej karty, a celuję w średnią półkę. Tak że jak wystarcza ci 1080, to raczej zastanowiłbym się nad czymś trochę słabszym, ale jak lubisz czuć się bezpiecznie to też nie ma problemu, najwyżej sobie wymienisz monitor na większy.

Oczywiście gadasz głupoty Hydro. Jeśli pierwsze wykresy się potwierdzą to RX 7900XTX demoluje 3090 wydajnością, stosunkiem cena/wydajność jak i efektywnością energetyczną. Bez drastycznej korekty cen ze strony Nvidii to poza 4090 żadna z jej kart w wysokim segmencie nie ma zbytnio racji bytu.

Ja wiem, że prawie 1000$ za kartę to jest jakiś absurd cenowy, który ciężko zaakceptować rozsądnemu człowiekowi, ale w porównaniu z Nvidią wypada nadzwyczaj dobrze. Szczególnie dla osób, które nadal uważają RT bardziej jako ciekawostkę niż coś potrzebnego.

Uuuu trochę wtopa AMD. Zrobili marketingowy zakłamanie, zupełnie jak Nvidia w 3 generacji.

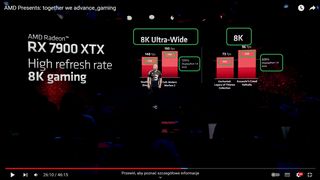

Z wydajnością w 8K przekłamali - w endnote podali jakiej użyli rozdzielczości, i nie było to 8K (7680 x 4320 pikseli) lecz ultrawide "8K" (7680 x 2160) - czyli połowa pikseli potrzebnych do wyświetlenia. To w sumie wyjaśnia skąd w Call of Duty wyciągneli takie kosmiczną ilość FPSów.

Ładnie to wyjaśnił Gamers Nexus (od 06:05):

https://www.youtube.com/watch?v=pAUxrWCZV50&t=413s

Nie widzę tutaj wielkiego zakłamania czy manipulacji. Steve chyba zrobił burzę w szklance wody. Informacja o rozdzielczości pojawia się nie tylko w endnote, ale też na samych slajdach. Dodatkowo na samej prezentacji "8K ultrawide" jest zestawione obok siebie z "8K" na dwóch odrębnych slajdach. Trzeba mieć dużo samozaparcia żeby "nie zrozumieć", że rozdzielczości monitorów ultrawide nie są takie same jak klasycznych monitorów w formacie 16:9.

Można się owszem czepiać nazewnictwa - ale to już uwaga do całej branży, bo producenci monitorów chętnie używają 4K czy 8K w przypadku monitorów, które z oczywistych przyczyn (układ pixeli) tej rozdzielczości nie mają.