Posiadasz RTX 4090? Obejrzyj wtyczkę zasilania

Co za imbecyl zaprojektował te połączenia jako lutowane ? Połączenia lutowane są przystosowane do łączenia kabli sygnałowych. Do łączenia przewodów zasilania się ich nie używa. Tzn. używa się ich na PCB, do mocowania złącza zasilania, ale tam oprócz tych lutowań gniazdo jest mechanicznie połączone z płytą, tak by nie było możliwości sił działających na lutowania. Poza tym, pola lutownicze są duże i mogą odprowadzać ciepło.

Cyna ma wyższą rezystancję niż miedź, przez co bardziej się nagrzewa. Przy okazji takie złącze ma średnią wytrzymałość termiczną i mechaniczną.

Nvidia powinna wymienić wszystkie przejściówki na takie, które zaprojektował inżynier, który wie co robi... Zresztą nawet spora część techników wie, że w ten sposób się nie robi...

Nawet na płytkach takie połączenia projektuje się, zwracając uwagę na to, by odprowadziły ciepło i nie doszło do ich uszkodzenia. Używanie lutowań poza płytką PCB ogranicza się do przewodów sygnałowych.

Wygląda więc na to, że winne są: wadliwa konstrukcja i słaba jakość wykonania przejściówki.

^^Grzała za grube tysiące, a dziady oszczędzają na wtyczce :/ Ale wstyd!

Co za imbecyl zaprojektował te połączenia jako lutowane ? Połączenia lutowane są przystosowane do łączenia kabli sygnałowych. Do łączenia przewodów zasilania się ich nie używa. Tzn. używa się ich na PCB, do mocowania złącza zasilania, ale tam oprócz tych lutowań gniazdo jest mechanicznie połączone z płytą, tak by nie było możliwości sił działających na lutowania. Poza tym, pola lutownicze są duże i mogą odprowadzać ciepło.

Cyna ma wyższą rezystancję niż miedź, przez co bardziej się nagrzewa. Przy okazji takie złącze ma średnią wytrzymałość termiczną i mechaniczną.

Nvidia powinna wymienić wszystkie przejściówki na takie, które zaprojektował inżynier, który wie co robi... Zresztą nawet spora część techników wie, że w ten sposób się nie robi...

Nawet na płytkach takie połączenia projektuje się, zwracając uwagę na to, by odprowadziły ciepło i nie doszło do ich uszkodzenia. Używanie lutowań poza płytką PCB ogranicza się do przewodów sygnałowych.

Wygląda więc na to, że winne są: wadliwa konstrukcja i słaba jakość wykonania przejściówki.

^^Grzała za grube tysiące, a dziady oszczędzają na wtyczce :/ Ale wstyd!

Dziady oszczedzaja na zasilaczu. Gdyby zasilacz spelnial standard, to przejsciowka nie bylaby potrzebna.

Gdyby zasilacz spelnial standard - w tym wypadku byłbym powiedział, że "gdyby złącze zasilania karty graficznej spełniało standard". Rozumiem takie rozwiązanie za rok czy dwa lata, tymczasem jednak obecne wymagania dotyczące zasilania dla serii 40xx są nowością a nie standardem (owszem staną się nim z czasem, jednak producent GPU powinien o tym pomyśleć wcześniej lub przynajmniej dołączać adapter, który "daje radę").

Czyli dziady nie powinni kupowac czegokolwiek z serii 40xx, bo to nowosc. Rozumiem takie rozwiązanie za rok czy dwa lata, tymczasem jednak powinni sie od nowosci trzymac z daleka skoro standard ATX 3.0 wyklada ich na lopatki.

Problem solved.

https://eustore.cablemod.com/product/cablemod-pro-modflex-12vhpwr-pci-e-cable-extension/

Tylko miesiąc się czeka.:-(

Ale kaszana, ludzie z własnej woli wydają kasę, żeby zostać testerami, do czego ten świat zmierza? Taki wał za taką kasę xD. A tak dzięki takim debilom mającym za dużo pieniędzy dostajemy coraz gorsze produkty w coraz wyższych cenach...

Serio winny kupujący, a nie producent? Myślałem, że jak ktoś chce kupić coś - nieważne, czy za duże, czy za małe pieniądze to kupuje z myślą, że będzie coś działało - gdzie tu ich wina?

Dlatego kieruję zasada "nie kupuję coś za tanio, ale też nie za drogo". Zbyt tanie rzeczy często mają gorsze wykonanie i materiały. Zbyt drogie rzeczy niewiele oferują w stosunku do ceny (więcej zapłacisz niż otrzymasz).

Trzeba mieć trochę wiedzy i doświadczenie o konkretne rzeczy, by móc kupić produkt z sensowny jakość za rozsądne ceny. Sprzedawcy często wykorzystują niewiedzy klienci, by wciskać "gorsze produkty" tyle, ile się dało za jak najwięcej zysków. Nawet ceny promocyjne dla niektóre towary to w rzeczywistości normalne ceny.

Nie wszystkie produkty za naprawdę niskie ceny coś dużo oferują np. hity gry AAA za niskie ceny. To zależy.

Więc podsumowując: Kup, ale z rozsądkiem! Nie za wszelką cenę, nie od razu itd. Zawsze możesz kupować póżniej i poczekać na lepsze ceny/lepsze wersje urządzeń. Tak to ludzie robią z siebie testerów z tym, że to oni słono płacą za testowanie i często nawet o tym nie wiedzą. TO właśnie wykorzystują wszelkie firmy i korporacje jakie by nie były, zawsze próbują tak wykorzystywać ludzi i zyskać jak najwięcej. Nie można im tak po prostu ulegać, bo oni to zawsze wykorzystają, trzeba mieć godność i rozum. Skoro ludzie robią z siebie ofiary, to niech to robią, ale tak jak mówiłem: tym sposobem wpływają szkodliwie na rynek, więc jednak szkoda, że to robią.

pawel1812 ma całkowicie rację. Poza tym, RTX 4090 kosztuje prawie 10 tysiące złotych, więc oni nie mają żadne usprawiedliwienie. NVIDIA nawalili na całego.

To już lepiej kupić 3080Ti/3090. Wydajność wyzsza, co pokazały testy, do tego karty znacznie tańsze. Chyba, że ktoś ma chorobę na nówki ze sklepu i lubi tracić hajs, to przepraszam. Ja patrzę na wydajność i cenę ponad wszystko

Kłania się brak testowanie produktów.

Jakby zatrudnili kilka doświadczonych gości, żeby sprzęt testowali udając różnych użytkowników od pedanta, który robiłby wszystko powolini delikatnie aż po serwisanta, któremu montaż zajmuje 5 sekund i powtarzali to kilkaset razy to by wszystkie wady złącz, luzy, uszkodzenia fizyczne wyszły na jaw już w pierwszym dniu testów.

Takie błędy u tak doświadczonego producenta w produkcję z cena absolutnie premium nie mają prawa zaistnieć.

Nvidia się skompromitowała w ten sposób nie mniej niż Samsung w czasach wybuchających baterii w Galaxy S7 notę.

Takie rzeczy mogłyby wyjść na chińskich podrobkach montowanych z elektrosmieci, a podejrzewam, że i tu ci co Takie coś montują znają się materiałach, które używają.

Nvidia się skończyła jako poważna firma, teraz to kolejny dziad, który sprzedaje byle co żeby dupczyć ludzi na kase co generację większą.

Skoro to się pali po tygodniu od premiery to co będzie za lat 5 czy 10 z takimi gównianymi produktami? Ludzie będą ginąc w pożarach mieszkań? Takie coś nadaje się na przymusowe wycofanie produktu z rynku jako zagrażające życiu i zdrowiu.

tyle pieniedzy za karte to jeszcze wtyczki sie palą no normalnie brawo dla Nvidii..tak chcą zmiażdzyc AMD ze zapominaja o prostych rzeczach

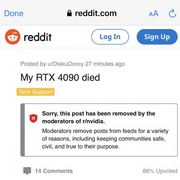

Oczywiście nie można napisać że twój RTX 4090 właśnie zdechł bo to niedobra jest...

Tyle jeśli chodzi o wolność wypowiedzi na Reddicie.

Pokaż co zawierał ten post to będzie można oceniać czy był warty usunięcia.

to jest problem z brakiem zasilaczy pod PCIE5.0 i trzeba podłączyć 4 kable przejściówką pod jedno złącze (totalnie bez sensu) sam zamówiłem gigabyte ud1000gm mimo degradacji mocy z 1475 na 1000W bo po prostu nie ma innych niż gigabyte z tym złączem i jednym kablem zasilacz <-> GPU

Najlepsze jes to że intel już w lipcu poprzedniego roku mówił o wprowadzeniu nowego standardu w zasilaczach i płytach głównych i przyszłych nowościach!

to wszyscy go wyśmiali ! mówili ze to skok na kasę !

A jednak teraz widzimy że intel miał racje !

Problem dotyczy wyłącznie przejściówek. Nvidia solidnie zawaliła tutaj sprawę. Ja na szczęście od początku korzystałem z wtyczki z PSU (bequiet Pure Power 10, trzeba było dokupić osobno przewód), karta od początku ostro katowana, ale i tak na wszelki wypadek sprawdziłem przewód, coby nie sfajczyć chaty.

Nie manipuluj. Zdjęcia przesłane przez użytkownika nie dotyczyły topnienia, tylko jak wrażliwa jest wtyczka - przy wyciąganiu wyrwał przewód. Nie ma żadnego związku z palącymi się adapterami i przewodami.

Masz rację, użytkownik nie powinien szarpać za przewód zamiast plastiku - ta sytuacja nie powinna mieć miejsca, ale tutaj zawinił enduser, nie twórca.

Jeszcze potrafię czasem zrozumieć takie akcje u nowych niedoświadczonych producentów. Ale NVidia nie powstała wczoraj.

Dlatego dobrze, ze mam z przodu 3 zamiast 4. W 4K brak roznic (fraps pokaże 2x mniej w 4K DLSS), ale ciężko cokolwiek wyłapać, bo nie spotkałem się z grat, w której widzialem mniej niż 6 z przodu przy liczbie dwucyfrowej). Do tego w obu jest 24 gb więc ta świadomość mi wystarczy. Oszczędność prądu też 50% w dół, a cenowo za samą kartę 120% w dół (przy 80%-owej stracie wydajności) i 0 problemu z wtyczkami. Za to starczy mi 12-letni zasilacz, który zresztą napędza mi ową kartę.

Durnoty wypisujecie. Te blaszki lutownicze to terminale. Przewody są do nich lutowane i bardzo dobrze się trzymają. Problem w tym, że te terminale są tak cienkie i usztywnione przez przylutowane przewody, że zginając przewody można urwać cały terminal od reszty złącza. Tak oderwany terminal jest nadal w obudowie i może nadal dotykać reszty, ale ma dużo większy opór i może dochodzić do iskrzenia. Wtedy to miejsce styku się nagrzewa i topi wtyczkę. Problem nie jest w przewodach czy spoinach, a w samej blaszce łączącej terminal z gniazdem wtyczki. Inne adaptery lub przewody od zasilaczy są bezpośrednio zaciśnięte lub wlutowane w piny wtyczki, NVIDIA zamiast tego oddzieliła je cienką blaszką, która jest słabym punktem. NVIDIA też zdawała sobie sprawę z potencjalnego problemu i dlatego ich wtyczka ma gumowe usztywnienie tam, gdzie każdy inny producent nie ma nic. Wiedzieli więc o słabym punkcie, zabezpieczyli go dodatkową gumą, ale nadal niedostatecznie i nadal terminale się odrywają.

To jakby powiesić telewizor na regipsach, które oderwały się od ściany. To nie wina kołków mocujących go do płyty, cała płyta się urwała. Problem jest w konstrukcji sciany. Problem jaki ma NVIDIA to potrzeba zmostkowania wszystkich 6 linii. Kiedy mamy 6 przewodów, to na każdy terminal przypada jeden przewód, wszystko jest małe i niezależne. Przy 4 przewodach rozdzielonych na 6 pinów trzeba zastosować jakiś mostek i on wydłuża wtyczkę tworząc potencjalny słaby punkt.

Zaraz, czegoś nie rozumiem. Te przejściówki są ponoć z czterech złącz 8pin na jedno 12pin.

W każdym złączu 8pin są trzy przewody 12v więc dlaczego w adapterze zrobiono przejście z 4 na 12, zamiast wykorzystać wszystkie 12 (4x3)?

Producenci zasilaczy już przybili na pomoc -> https://www.x-kom.pl/p/1082944-akcesorium-do-zasilacza-be-quiet-12vhpwr-pci-e-50-adapter-cp-6610.html

Jak ktoś wydaje 11K na kartę i pewnie z 1K na zasilacz to taki dedykowany kabelek nie będzie problemem.

Na wszelki sposób dopisze, żeby ktoś błędu nie zrobił:

Przewody nie są wymienne pomiędzy producentami. Wejścia do PSU nie są ustandaryzowane - jedynie końcówki są (do karty, płyty głównej, CPU).

Przewód bequiet może być zamontowany wyłącznie w zasilaczu bequiet (a i to tylko w niektórych modelach). Corsair ma własne przewodu, inne marki tak samo.

Użycie przewodu producenta X do zasilacza producenta Y może uszkodzić komponenty.

Albo:

1. Jesteś w czepku urodzony,

2. Kolejny raz manipulujesz.

Na 100%. Na pewno. Jak Pan Bóg przykazał. Położenie pinów jest różne pomiędzy producentami. Nie ma standaryzacji przewodów - jest jedynie standaryzacja wejść na płytę główną/Sata/GPU.

Nie można wymieniać przewodów pomiędzy PSU różnych producentów.

Nie można zostawiać starych przewodów tego samego producenta przy zmianie zasilacza - chyba że sam producent zastrzega, że kable są kompatybilne pomiędzy generacjami (nie przy zmianie na mocniejszy/słabszy zasilacz).

Jedyne co można w teorii zostawić, to podpięcie pod zasilacz - przewód który wpinany jest do gniazdka.