Między 500 nitów, a 1000 aż tak wielkiej różnicy nie ma, a nawet na 300 nitach jakiś tam sens tego HDR jest, ale pod warunkiem że matryca ma strefowe podświetlenie LED.

HDR najłatwiej przedstawić jako zwiększoną jasność, ale nie w tym rzecz. HDR to przede wszystkim nowy standard przesyłania strumienia video, gdzie metadane opisują jasność każdego piksela.

Pozwala to wyeliminować banding, bo ciemne sceny mogą w końcu korzystać z całego 8-bitowego zakresu składowych, po prostu podświetlenie matrycy będzie na niskiej wartości.

Innymi słowy HDR daje bardzo plastyczny obraz, gdzie widzimy detale w cieniach i jasnych punktach, a jednocześnie ciemne miejsca są ciemne, a jasne rażą w oczy.

SDR vs HDR to jak wprowadzenie telewizji kolorowej.

HDR nie da się opisać. To trzeba zobaczyć na własne oczy. Najlepsze wrażenie robią źródła światła w grach. Czy to lampy samochodów w Forzie, czy LEDy futurystycznych strojów w Mass Effect albo Gears of War 4.

HDR dodaje obrazowi głębi i nawet po dwóch latach oglądania treści HDR nadal zachwyca.

Największego kopa daje jednak to, gdy po obejrzeniu serialu w HDR, przełączymy się na zwykłą TV. Zwykły obraz HD wygląda tragicznie.

Gry to już w ogóle pokazówka dla HDRu, bo mogą generować zakresy jasności nieosiągalne dla profesjonalnych kamer filmowych. Choć trzeba przyznać, że każdy kolejny serial HDR od Netflixa robi z tego coraz lepszy użytek.

Bardzo się cieszę że taki wątek się na GOLu pojawił, naprawdę miło zobaczyć to wszystko w jednym miejscu :D

Sam na razie przy moim budżecie mogę o "zestawie HDR" pomyśleć jak o planie na najwcześniej 2019, ale niewątpliwie widząc że coraz więcej gier korzysta z tej technologii chciałbym w przyszłym roku grać już w nowe produkcje na monitorze przynajmniej HDR 600. I już tam nawet nie dbam o 4K bo 1440p przy 27 calach było by dla mnie doskonałą opcją.

Nie ukrywam że sama perspektywa ogrywania serii Assassin's Creed w dobrym HDR jest tym co mnie kupuje więc do wątku na pewno będę regularnie zaglądał i liczę że za kilkanaście miesięcy, już po targach CES 2019 będzie w Polsce konkretny wybór monitorów HDR 600 w lepszych cenach niż teraz.

Heinrich07 - HDR w monitorach 4K dostępne jest w opcjach 1080p i 4K, w 1440p oraz innych bo może to być monitor np. 32:9 jest dostępna w rozdzielczości natywnej. Teoretycznie obraz na ekranie 4K ładnie się skaluje w dół do 1080p więc można jak ktoś nie chce inwestować w potężny sprzęt kupić albo 4K i grać np. w nowsze gry z HDR w 1080p lub kupić o innej natywnej rozdzielczości jak np. 1440p.

Odpowiadając na drugie pytanie HDR działa z Freesync i G-Synciem, najlepszy obecnie monitor technologicznie Asus ma 144Hz w 4K z HDR i G-Sync, niestety ze względu na DisplayPort 1.4 HDR może być wyświetlany maksymalnie w 98hz przy RGB 10bit pełnym w 4K. Dopiero wprowadzenie wyższego standardu złącza i przepustowości pozwoli na np. 144Hz w HDR z 4K (tylko trzeba by było obecnie mieć min 3x1080TI do takiej ilości fps w 4K)

Niedzielny Graczy - tu nie chodzi o "podniecanie się" tylko o fakt który stał się. Po 10 ostatnich latach zastoju została wprowadzona technologia która całkowicie zmienia jakość w wyświetlanym obrazie, a gry głównie na tym skorzystały. To jak wygląda gra w SDR / i ta sama w HDR to przepaść nie do opisania, musisz to po prostu zobaczyć aby się wypowiedzieć inaczej będziesz pisał to co ja kiedyś właśnie o HDR / też mi się wydawało że można za pomocą np. SFX ustawić kolorystykę. Nie chodzi jednak o nią tylko o rozpiętość barw pomiędzy pkt mroku i światła.

Niedzielny Gracz - Nie jestem w stanie ci odpowiedz na pytanie dlaczego nie umiesz włączyć opcji HDR w swoim TV ;) bo na HDR właśnie MS postawił jako pierwszy robiąc m.in wrzutkę w Gears of War 4.

Jakby ci tutaj wytłumaczyć najprościej, może tak. Jak masz normalny monitor/TV z 8bit matrycą to masz ok. 256 odcieni szarości (w rezultacie tak naprawdę 220 które przy podświetleniu 100cd/m2 były wystarczające do przejścia tonalnego, w przypadku obrazu HDR ze względu na dużo większe zakres podświetlenie np. 1000cd/m2 (HDR domyślnie do 10000cd/m2) trzeba było wprowadzić dodatkowe wypełnienie aby odcienie nie wyglądały jak paleta składająca się z kwadratowych kolorów, dlatego matryce 10bit mają 1024 odcieni szarości. (tak wygląda przejście tonalne - zakres ten został znacząco poszerzony). M.in dlatego dostajesz gigantyczną większą ilość kolorów 8bit ma ich 16.7Miliona, a 10bit ma ich 1.07Miliarda (64x więcej) - to jeśli chodzi tylko o kolorystykę i przejście tonalne. Druga różnica to możliwość wyświetlania punktów bardzo jasnych i bardzo ciemnych w jednej scenie co daje dużo większe możliwości wyświetlenia obrazu. Pomijam tutaj jarzący się miecz świetlny w Star Wars czy pioruny w Gears of War 4, lub punkty świetlne po włączeniu plecaka odrzutowego w Mass Effect chodzi m.in. o możliwość pokazania scen złożonych jak np. chmur na niebie wraz z słońcem które nie jest już flarą, a przez chmury przechodzą promienie słoneczne, pomieszczeń np. jaskiń w AC: Origin gdzie wchodząc do jaskini widzisz mrok oraz jednocześnie naturalny wygląd świec, itc. itc.

Mógłbyś zadać np. pytanie dlaczego nie każda gra ma HDR albo nie da się go włączyć odp. HDR musi być zaimplementowany w danej grze są to dodatkowe dane opisujące tworzoną scenę. M.in dlatego do HDR potrzebne są odpowiednie złącza które mogą te dane przesłać w odpowiedni czasie o czym napisałem w poście nr 1.

Obok załączam ci jeszcze mały schemat abyś mógł to lepiej zrozumieć.

W B7 jest 21ms wiec pod tym wzgledem jest bajecznie.

edit: Celuj jednak w tegoroczna serie szczegolnie, ze B7 ma dosyc przyciemniony tryb HDR Gra. LG obnizylo jasnosc panelu po jednej z aktualizacji systemu TV. Narobila sie wokol tego spora afera, byly petycje, ale temat umarl. W tym roku jest lepiej ze wzgledu na Dynamic Tone Mapping w trybie HDR Gra.

https://youtu.be/cU1f2nHRLus w 12 minucie filmu masz wyjasnione co i jak.

Amadeusz - dlatego na PC wprowadzono w końcu standard VESA400/600/1000 teraz wiadomo że monitor będzie miał oznaczenie HDR z tym oznaczeniem, 400 szczytowe 400cd/m2 (efekt niewielki ale 10bit i tak daje różnice w cieniowaniu + 200cd/m2 więcej niż na zwykłym monitorze da nam efekt punku świetlnego), w przypadku VESAHDR600 efekt jest już odczuwalny i wyraźna różnica względem SDR, za to już VESAHDR1000 to już absolutny top i "opad szczęki" ludzie którzy pierwszy raz widzą 1000+ nitów i 10bit są w takim szoku, że zazwyczaj przez chwile nic nie mówią.

Dodatkowo nowa kompilacja Windowsa jest już moim zdaniem plug'play - aczkolwiek nie wszystkie gry tak, np. w shadow of war opcja HDR jest ukryta w opcji jasności i tylko wtedy się pojawi jak Windows ma włączony HDR w Windows (bez sensu), wolę jak to robią inne gry czyli przełączają tryb tylko w grze, a windows wracają do SDR. Jednak Shadow of War to była jedna z pierwszych gier, ostatnie jak np. FarCry 5 to ustawienie HDR w grze w 5 sekund.

Wszystkie gry z HDR testowałem na PC więc jak ktoś ma jakieś pytania co do ustawień to służę pomocą, tak samo jak ustawienie jasności jeśli jest inaczej opisana niż na dwóch białych boxach.

Widziałem HDR w Media Markcie na TV za 14 koła. Powiem wprost. To żadna rewolucja, a miły dodatek. Największa rewolucję poczułem, kiedy na głowie miałem HTC VIVE z kontrolerami ruchowymi. To jest prawdziwa technologia, która w pełni daje satysfakcję obcowania z czymś nowym. HDR pewnie bedzie niedlugo standardem ale nie ma to jakiegos super ultra wpływu na wrazenia wizualne. Jestem za tym, aby wspierali i rozwijali VR!

Ja znam HDR głownie z gier i kojarzy mi sie ten efekt z tym ze wszystko w nich swieci się ja psu jajca!

Odświeżam po to, bo przez najbliższe tygodnie temat będzie mi potrzebny :P

PS - Szczególne podziękowania dla użytkowników VirtualManiac i Likwidator no i dla Alexa za sam temat :)

VirtualManiac - potem zobaczę dokładniej czy coś się zmieniło ale prawdopodobnie będzie tak jak napisał Likfidator, nie za dużo, bardziej można co najwyżej zwrócić uwagę na dodatki jak ambilight od Philipsa, czy inne funkcje. Na pewno przy cenie 10K to nie ma co nawet myśleć o czymś innym niż oled. TV Oled używam jeśli do gier to tylko konsolowych, na PC monitorów, więc nie jestem w stanie zweryfikować nic na temat wypalania o czym ostatnio jest głośno. Ja mam oledy od początku i nie sądzę żeby któryś miał coś wypalone.

obok porównanie czerni, dlatego że jest nieskończona, oled przy 700cd/m2 daje efekt HDR jak 1100+ na LCD czyli spektakularny !

Temat zostanie w ciągu dwóch tygodni zaktualizowany o nowe gry wspierające HDR oraz listę monitorów w poście nr 1.

Niemniej warto dodać że dzisiaj wyszedł patch HDR na PC do Hellblade: Senua's Sacrifice

Cześć Alex, potrzebuję Twojej opinii przy wyborze monitora. Dotychczas byłem zdecydowany na Dell AW3418DW, ponieważ ma wszystko czego chciałem: IPS, 3440x1440, G-sync, minimum 100hz, duży zakrzywiony ekran o proporcjach 21:9.

Jednak, po przeczytaniu Twojego artykułu naszło mnie strasznie na HDR. Obserwowałem Twoją aktywność w wielu wątkach o grach i wydajesz się być osobą oczytaną w tematach sprzętu komputerowego, więc jeśli mówisz że HDR jest tego warty, to jestem w stanie w to uwierzyć.

Problem w tym, że nie ma jeszcze na rynku monitorów jak ten powyżej tylko że z HDR. Dowiedziałem się że na początku 2019r. powinny wejść na rynek dwa fajne modele mające wszystko co AW3418DW (poza typem matrycy) z HDR 1000. Te modele to Acer Predator X35 i ASUS

ROG Swift PG35VQ. Monitory te miały wielokrotnie przekładaną datę premiery (ostatnie dane w internecie wskazują na Q4 2018), więc spodziewam się że powinny wyjść jakoś w Q1 2019.

Na monitor planuje przeznaczyć ile trzeba będzie, chcę żeby był to zakup przyszłościowy na co najmniej 5 lat. Zależy mi głównie na 21:9 curved i ładnych (ale realistycznych, nie przesyconych) kolorach i płynnym obrazie w ruchu. Nie gram w gry zawodowo, raczej delektuję się grafiką i immersją.

W związku z powyższym mam do Ciebie dwa konkretne pytania:

1) Kartę graficzną jaką posiadam to Zotac RTX 2080 AMP Edition. Mam nadzieję że będzie wystarczająca żeby obsłużyć HDR 1000 w 3440x1440, 100hz+?

2) Główna zagwozdka jaką mam przy wyborze tych dwóch monitorów to typ matrycy. Dell ma IPS, a dwa pozostałe monitory VA. Z tego co czytałem VA lepiej nadaje się do HDR, ponieważ ma lepszy kontrast, większa różnica między najciemniejszym a najjaśniejszym punktem monitora. Martwi mnie jednak smużenie (ghosting) matryc VA. Zależy mi na tym by obraz był krystalicznie wyraźny w ruchu i posiadał ładne kolory. Słyszałem też że IPS oferuje "lepsze", bardziej równomierne kolory. No i nie ma ghostingu.

Temat o HDR i matrycach VA a mi właśnie paradoksalnie najmniej chyba zależy na jakiejś mega czerni. Bardziej wyobrażam sobie ze będę grał w "jasne" gry (wiem, głupio to brzmi). Albo może nie zdaje sobie sprawy z różnicy...?

Nie jestem też pewien jak ważne są tu kąty widzenia, które IPS ma lepsze, wszak 21:9 to większe kąty patrzenia na boki obrazu. Czy kolory na bocznych skrajach nie ucierpią patrząc na wprost monitora 21:9 z matrycą VA?

Wiem, że IPS może posiadać backlight bleed, ale nie wiem jaki może mieć to wpływ na odczucia z rozgrywki. W zasadzie nie mogę przewidzieć nic, zarówno przy IPS jak i VA, bo dotychczas siedzę na 10 letnim 4:3 TN.

Który z tych monitorów będzie najlepszym zakupem Twoim zdaniem? Czy ewentualne wady matryc VA będą zrekompensowane przez obraz w HDR? Dodajmy też, że głównie nowe gry korzystają z HDR, ja z grami zatrzymałem się na 2007 roku więc zamierzam ograć też wiele starszych tytułów. Gram głównie w action RPG, choć FPSy też lubię.

Dzięki :)

Szkoda tylko że osoba która zebrała tyle wiedzy na temat HDR, w tym samym wątku I momencie do tego stopnia pozbawiona jest podstaw wiedzy o VR... Trochę odbiera to powagi wątkowi, który mógłby być całkiem przyjemny gdyby nie było tu całkowicie błędnych i pozbawionych elementarnego doświadczenia wstawek :)

Co do HDR, Efekt potrafi zachwycić dzięki dużo szerszej palecie barwnej, szkoda tylko że w LCD z jakimi miałem kontakt (półka ok 5K), był całkowicie nieużywalny ze względu na zrujnowaną w tym trybie czerń…

Technologia jest bardzo fajna i na sensownym TV/monitorze rzeczywiście robi wrażenie (szczególnie w ciemnych pomieszczeniach z OLEDową czernią - kontrast absolutnie urywa dupę i jest to coś co nie było możliwe kilka lat temu).

Jest jednak kilka rzeczy które bardzo mnie wkurzają:

- HDR HDRowi absolutnie nierówny, przeciętny Kowalski musi robić x-godzinny research żeby się tak naprawdę dowiedzieć jakie rodzaje HDRu występują i czym się różnią. Jest coraz więcej standardów które tylko wprowadzają zamieszanie,

- na rynku jest mnóstwo sprzętu 'z HDR' na którym HDR jest w ogóle niewidoczny - za niska jasność. Wprowadzanie ludzi w bambuko oznaczeniami, bo jak wyświetlacz nie potrafi osiągnąć tych 400-500cd/m2 to to dupa a nie HDR - a naklejka jest,

- zamieszanie z kablami - niektóre w ogóle nie mają oznaczeń czy obsługują HDMI 2.0, ogólnie też często brakuje informacji że jest to absolutny requirement. Inna sprawa że 2.1 jeszcze nawet nie wyszło.

- zabugowany software, jak chciałem sobie podłączyć TV do telewizora to musiałem sprzętowo wyłączać inna podłączone monitory i bawić się w inne dupsy zanim HDR się łaskawie włączył. Bardzo kapryśne zachowanie i zmarnowałem kilkadziesiąt minut na troubleshooting,

Technologia przyszłości (za 10 lat każdy na ekrany bez dobrego HDR będzie patrzył tak jak teraz patrzy się na rozdzielczości <1080p) i bezdyskusyjnie zmieniająca jakość obrazu, ale bardzo raczkująca i po prostu upierdliwa, chyba że ktoś gra na konsoli, takie PS4Pro się podłącza dołączonym kablem i ma wszystko w nosie (super odskocznia po cyrkach z PC).

Od czasu, czyli gdzieś roku 2006, kiedy 40' plazmy przestały kosztować po 30tyś złotych za sztukę, byliśmy kuszeni telewizorami LCD z coraz lepszą prezentacją obrazu poprzez zwiększanie kontrastu. W 2006 idealny obraz był przy 500:1, w 2008 roku już 2000:1 itd itd. W końcu spece od marketingu oszaleli, i zaczęli reklamować tv z kontrastem 20000:1, czy nawet 200000:1. Wszystko po to, by naiwni klienci znowu kupili nowy telewizor.

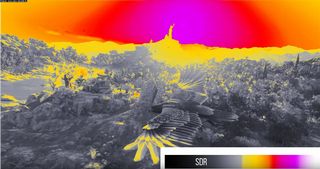

Dziś podkręcanie kontrastu przebiło skale absurdu, więc ktoś wymyślił nowy wabik i numer się powtarza. Na tym zdjęciu, które dodał Alex, różnica jest taka, że obraz po prawej ma znacznie większy kontrast. Tylko tyle. To wszystko przestawi się w ustawieniach telewizora. I nic poza tym, co by było warte wydania kilku tysięcy złotych więcej.

I nic poza tym, co by było warte wydania kilku tysięcy złotych więcej.

Bez przesady, HDR to fakt, gamut jest duzo wiekszy.

Ale obrazki takie jak ten sa o kant dupy roztrzas :) bo przeciez nie da sie pokazac jak lepszy jest obraz HDR na monitorze nie-HDR, stad takie zagrania z kontrastem.

Niedzielny Gracz, nie rozumiesz. Matryce LCD z roku na rok miały coraz lepsze parametry, aż w pewnym momencie standard zapisu obrazu w strumieniu zaczął je ograniczać.

HDR to nowy standard przesyłu informacji o obrazie. Bardzo przyszłościowy, bo nawet podstawowy HDR10 zakłada jasność aż 10 000 nitów, mimo iż najlepsze TV nie przekraczają 2000 nitów.

Efektu HDR nie zobaczysz na tradycyjnym wyświetlaczu. To tak jakbyś miał wytłumaczyć daltoniście czym różni się zielony od czerwonego.

HDR nie zobaczysz też w sklepie, bo tryb ten zakłada oglądanie ekranu w ciemnym pomieszczeniu.

Mówiąc jeszcze inaczej, oglądając zwykłą TV twoje oko pracuje na stałej szerokości źrenicy. W przypadku HDR źrenica będzie musiała pracować i dynamicznie zmieniać rozmiar, wyzwalając efekt oślepienia np. wybuchem czy innym jasnym rozbłyskiem.

Nie spotkałem się jeszcze z przypadkiem, by HDR nie zrobił wrażenia na kimś. Zawsze kończyło się to na "WOW".

Niedzielny Gracz - nie czytałeś tego co napisałem. Nie da się pokazać screena HDR nie da się też pokazać filmu, można nagrać w HDR i odtworzyć na odbiorniku HDR tylko. Screen który jest wrzucony w wątku nie przedstawia obrazu porównawczego HDR tylko przykład różnicy spektakularnej. Jakbyś zobaczył w SW:Battlefornt ostatnią walkę statków na pustynnej planecie przy zachodzącym słońcu to byś nie był w stanie zrozumieć tej przepaści jakościowej, że czujesz ten żar oraz ten gorący piasek przy sobie. To tylko taki mały przykład bo gry w HDR są zrobione całkowicie na podstawie metadanych z dodatkową informacją. Sam z wielką przyjemnością skończyłem jeszcze raz CoDWW2 oraz Battlefront 1.

Likfidator - różnica pomiędzy 500nitów, a 1000 jest wręcz kolosalna. Spodziewałem się że różnica będzie (ze względu na sugestie z HDTVPolska ale nie sądziłem że aż tak niesamowicie duża. Dlatego m.in. napisałem też o standardach). Jak ktoś chce z miejsca zostać wyrwany z butów to na ten moment ma trzy monitory do wybory z VESAHDR1000.

Fajny wątek, dzięki.

Pytanko - jaka rozdziałka jest najlepsza dla HDR? Standardowo - im większa tym lepsza? No i co, jeśli chciałbym na nowej budzie i nowym monitorze pozostać przy FHD, ale skosztować HDR?

No i jak HDR ma się z technologiami typu g-sync i freesync - czy jedno nie blokuje drugiego?

A.l.e.X

Gram na XOX z dedykowanym przez MS oledem.

HDR to tylko kwestia ogromnego kontrastu względem starych typów telewizorów. Ładnie to wygląda, ale to żadna rewelacja na miarę skoku jakościowego np. trinitronów. Reszta to tylko umiejętny marketing, który, jak zawsze, znajduje gorliwych wyznawców.

Znalazłem fajny materiał porównawczy SDR do HDR który warto obejrzeć aby zrozumieć różnice.

https://www.youtube.com/watch?v=BJ6_cQjSgfw

W przypadku monitorów HDR600 na ten moment mamy dostępne :

HP Pavilion Gaming 32 HDR Display – który uzyskał wynik ok. 600 cd/m2

Samsung CHG70 – który uzyskał wynik ok. 600cd/m2

Samsung CHG90 – który uzyskał wynik ok. 600cd/m2

Skąd są te wyniki? Patrzę np na CHG70:

https://allegro.pl/monitor-samsung-qled-27-chg70-lc27hg70qquxen-i7296787796.html Jasność (cd/m2):350

https://www.electro.pl/monitory-led/monitor-samsung-curved-qled-lc32hg70qquxen,id-991670?utm_source=ceneo&utm_medium=cpc&utm_content=875958&utm_campaign=2018-07&utm_term=MONITORY-LED&ceneo_spo=true też 350cd/m˛

Pierwszy mi spadł w oko Dell U2518D 25'*

https://allegro.pl/monitor-dell-u2518d-25-wqhd-2560x1440-ips-hdmi-i7220399671.html

Ma HDR i też Jasność (cd/m2):350

* już wiem czemu taka cena- wystarczy zerknąć na zdjęcia podświetlenia w komentarzach...

https://www.x-kom.pl/p/375837-monitor-led-24-269-dell-u2518d-5ms-8bit-hdr-hdmi-20.html

Póki co zbyt mało produkcji z niego korzysta. Większość gier z listy w [1] mnie nie interesuje. Plus póki co siedzę na W7 a znając życie trza mieć W10.

.:Jj:. - ponieważ dostały taki certyfikat VESA HDR600 co znaczy że musiały mieć peak jasności na planszy testowej w ok. 600 cd/m2. Średni wynik dla tego monitora to 382 cd/m2 z peak w trybie HDR 600 cd/m2

Samsung CHG70

https://www.tomsguide.com/us/samsung-chg70-curved-monitor,review-5160.html

HP Pavilion Gaming 32 HDR Display

https://www.displayspecifications.com/en/model/413b1231

Pamiętaj że aby był osiągnięty standard HDR10 musi być 10bit pokrycia + jasność powyżej 400cd/m2 dla VESA HDR400, dla VESAHDR600 to samo z 600cd/m2 jeśli jest to panel 8 bitowy nie ma mowy o HDR10. Możesz co prawda uzyskać w jednej scenie jasne i ciemne elementy ale nie będzie dodatkowych kolorów i odcieni (brak detali w obrazie o którym się mówi w HDR)

Listę monitorów będę się starał uzupełniać w miarę możliwości. Gier z HDR na PC obecnie jest ok. 30 i każda nowa AAA będzie miała HDR dostępny oraz kolorystykę (na pewno wszystkie od Ubisoftu i EA). Różnice w obrazie są tak gigantyczne że (o ile dysponujesz budżetem na zakup takiego monitora) nawet nie brałbym pod uwagę zakupu takiego co nie wspiera tej technologii.

dla treści HDR są obecnie dwa oznaczenia standard HDR10 (dostępny dla PC w monitorach i najbardziej wspierany), oraz Dolby Vision (dla TV i dodatkowych treści filmowych) różnice poniżej.

Secification HDR 10

Peak Brightness 4000 nits with current target 1000 nits with 0.05 nits of black level or 540 nits with 0.0005 nits of black level

Color Gamut DCI P3

Depth Of Color 10 Bits

Shades of Color 68 billion

Remapping Color and Brightness Data Sent Static (meta data sent once at beginning)

Secification Dolby Vision

Peak Brightness 10,000 nits with current target 4000 nits

Color Gamut Rec.2020

Depth Of Color 12 Bits

Shades of Color 1.07 billion

Remapping Color and Brightness Data Sent Dynamic (meta data sent frame by frame)

Alex to jest trochę bardziej skomplikowane. HDR10 jedynie określa format metadanych, reszta jest kwestią strumienia. HDR10 będzie działał na 8, 10 czy 12 bitach. Najczęściej z przestrzenią BT.2020.

Różnica w metadanych jest taka, że HDR10 tylko na początku przesyła dane konfiguracyjne, a w późniejszych klatkach tylko informacje o jasności. Meta dane słane są cały czas.

Dolby Vision zakłada od razu wyższe parametry strumienia i format metadanych jest bardziej wszechstronny.

Dla obecnych wyświetlaczy użyty format nie ma różnicy, bo nie spełniają norm ani HDR10, ani tym bardziej DV.

Jest jeszcze trzeci format HLG, używany przez nadawców telewizyjnych. W ogóle nie używa metadanych i jest wstecznie kompatybilny ze zwykłymi TV. To jednak tylko namiastka HDRu.

Komputery PC wspierają zarówno HDR10 jak i DV. Mass Effect: Andromeda może wyświetlać obraz w obu formatach.

Xbox One ma dostać wsparcie dla DV niedługo, ale na razie tylko dla strumieni.

No i jest jeszcze ulepszony HDR10+, który rozszerza HDR10 do specyfikacji Dolby Vision.

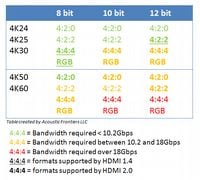

Likfidator - wszystko się zgadza, w pewnym sensie, jednakże standard VESA HDR 400/600/1000 czyli certyfikacja dla monitorów PC wymusza pewne wartości dla koloru / cd/m2 / oraz 10 bit per color - obok tabela. Wszystkie nowe monitory HDR będą zawężone już do tej grupy, przynajmniej tak to wygląda. Mass Effect Andromeda dostał DV ponieważ to były początki HDR dla gier, prawdopodobnie zostanie to uporządkowane. Na ten moment sprawdziłem wszystkie gry na PC. Przed chwilą skończyłem Halo Wars 2 z dodatkami (i jeszcze jestem w szoku)

Alex, mam wrażenie, że mylisz tutaj standard transmisji strumienia video (HDR10 i DolbyVision) z certyfikatem jakości wyświetlacza (VESA HDR 400/600/1000).

Komputer, czy konsola nie ma pojęcia jakie parametry ma monitor. Po prostu uzgadnia obsługiwane formaty np. rozdzielczość 2160p, 30-bitowy kolor, przestrzeń BT.2020, 60 Hz i kompatybilność z metadanymi HDR10 czy Dolby Vision.

Resztą zajmuje się wyświetlacz.

VESA HDR pełni tę samą rolę co "HDR Premium", "HDR Pro", "HDR1000" czy "SUHD" u różnych producentów TV, którzy w ten sposób pozwalają w łatwy sposób odróżnić konsumentowi lepszy TV od gorszego.

DisplayHDR od VESY poza informacją dla klienta nie ma żadnej wartości dla komunikacji PC - ekran.

Wciąż będziesz musiał kalibrować jasność HDR w menu opcji, bo jeden wyświetlacz wymaksuje jasność na 1000 nitów, a inny na 4000. Jest to trochę upierdliwe, bo np. w ramach testów podłączam Xboxa czy PCta do moich TV 4K i każdy wymaga innych ustawień w grze.

Ba, wstępnie trzeba nawet pobawić się ustawieniami jasności, kontrastu itd. w menu TV.

Może z Dolby Vision jest mniej problemów, bo to bardziej doszlifowany standard, ale póki co mam tylko telefon obsługujący ten format.

Na pewno w przyszłości problem ten zostanie jakoś sensownie rozwiązany i wyświetlacz wymieni się danymi kalibracyjnymi z urządzeniem dostarczającym treść.

Likfidator - wszystko co napisałeś to 100% racji. Tak, prawdopodobnie zawsze będziesz musiał za nim gra nie dostanie tabeli informacji o parametrach monitora/tv kalibrować biel albo na pudełkach albo podając wartości jak w grach od Ubi. Chodziło mi o to że na PC powstała pewna standaryzacja dla HDR od VESY na co zgodzili się jak widać producenci bo właśnie dostarczają monitory z taką certyfikacją, dzięki temu istnieje b. duże prawdopodobieństwo (o ile się nikt nie wyłamie) że to rozwiąże całkowicie problem bałaganu o HDR jaki powstał przy TV. Obecnie jak sam wiesz i napisałeś to że w menu gry da się włączyć opcje HDR (pc/konsola) nie przekłada się to na te same doznania, a wszystko zależy od jakości TV. Na PC wydaje się to dzisiaj dość proste wybierasz po prostu monitor z certyfikacją VESY najlepiej VESA HDR 1000.

hinson - tutaj masz pierwszą grę wspierającą HDR to było dość dawno temu (dzisiaj tych gier jest b. dużo na PC ok 30 z efektami takimi że "wyrywa z butów" np. Assassins Creed Origin / Shadow of War / Halo Wars 2 / SW BF2 itd.) masz tam suwaki dla treści SDR i HDR to są tylko przykładu po zrobieniu zdjęć, bo HDR screenów nie da się pokazać ale i tak możesz porównując te zrzuty suwakiem dojść do wniosków ile metadanych w treści SDR brakuje względem HDR

https://hdtvpolska.com/forza-horizon-3-hdr-test-i-recenzja-trybu-hdr-na-xbox-one-s-wideo/

Kupiłem Sony Bravie XE9005, TV w którym HDR zaczyna już wchodzić na przyzwoity poziom a i tak do perfekcji sporo mu brakuje. Podłączyłem PS 4 Pro, odpaliłem Horizon Zero Dawn w 4k+HDR i... opad szczęki. HDR to zupełnie inna jakość jeżeli chodzi o konsumpcję treści na telewizorze. Rozmawianie o tej technologii gdy ktoś jej nigdy nie widział to jak gadanie ze ślepym o kolorach - nie da się.

Na ps4 mam uncharted 4 i lost legacy, tego drugiego jeszcze nie przeszedłem. Na pc mam andromede i Final Fantasy ale moj GTX 1080 nie wyrobi w 4K, czekam tu na nowe karty, zanim przejdę Horizona i Lost Legacy to powinny juz byc 2080/1180 to wtedy będzie można podłączyć pc do telewizora

Hydro2 - projektor ma ten plus że efekt HDR na nim zobaczysz spektakularny nawet przy 300-400cd/m2. Wszystkie gry wymajają ustawienia parametru HDR w nich, jest to dość jasno opisane jakbyś jednak miał z tym problem i chciał właściwie to zawsze możesz tutaj napisać lub łapać mnie na steam.

W 55" kupisz LG B7. Lepszego nie potrzebujesz. We wszystkich modelach OLEDów matryce są identyczne, a modele na 2018 rok mają dodane AI z którego i tak mało kto będzie korzystał.

https://www.mediaexpert.pl/telewizory/telewizor-lg-oled65b7v,id-823490

Za 8300 zł jest nawet 65". Ceny mocno poleciały w dół w ostatnim czasie. Przy takich cenach nawet nie warto myśleć o jakimkolwiek LCD.

Likfidator i A.l.e.X Dziękuję za odzew. No faktycznie jest przepaść między LCD a OLED. A jak jest z input lag? TV będzie głównie służył do gier, więc jak wiecie input lag jest bardzo ważny. Żeby nie był za duży.

Alex, Pecetowy Shadow od TR też ma wg tej listy obsługiwać hdr. Warto dopisać :> Ps - dzięki temu tematowi aktualizuję system do 1803. Do teraz siedziałem na 1607 i mi to w pełni wystarczało, ale jak widać, jak chcę hdr, to muszę trzymać się najnowszej wersji systemu. Chore to, ale co zrobić :P

1.

Amadeusz ^^

Inna sprawa że 2.1 jeszcze nawet nie wyszło.

Nie doczytałem się, żeby ktoś to sprostował, a nie jest to prawda - kabel jest już od jakiegoś czasu do kupienia np. w sklepie Apple i nie kosztuje fortuny:

https://www.apple.com/pl/shop/product/HLL52ZM/A/przewód-hdmi-belkin-ultra-high-speed-4k-2-m

2. Używam LG OLED65B7 jako monitora do PC przy cały czas włączonym HDRze. Drobnym problemem jest często poruszany na forach zamglony obraz (wyprane kolory). Nie doczytałem się, żeby ktoś miał na to rozwiązanie, ale sam odkryłem, że po uruchomieniu komputera wystarczy wejść w ustawienie HDR/WCG i kliknąć na suwak jasności aplikacji SDR - jasność i kolory stają się takie, jak powinny. Szkoda, że nie znalazłem sposobu, żeby ograniczyć to do odpalenia jakiegoś skryptu w PowerShellu czy batchu, bo byłoby to cokolwiek mniej upierdliwe.

Jest też druga upierdliwość - w niektórych aplikacjach (np. przeglądarka Vivaldi) po okresie bezczynności jasność ulega ograniczeniu, jak w przypadku oszczędzania energii przez wyświetlacz, jednak to nie jest w żaden sposób powiązane z opcjami oszczędzania energii i na to permanentnego rozwiązania już nie znalazłem, jak dotychczas. Muszę, niestety, klikać na inną zakładkę przeglądarki, czy na moment przełączyć się na inny program, żeby wróciła właściwa jasność. Samo ruszanie kursorem myszy nie wystarczy.

Na ten moment używam ustawnień 4K@60Hz+RGB+8bpc (zmiana na 4:x:x w moim przypadku nie umożliwia skorzystania z 10/12bpc - do tego musiałem zmniejszać rozdzielczość, ale gradienty tak czy siak były bez szału, więc odpuściłem) , ale lektura tego wątku skłoniła mnie, żeby po powrocie do domu dać jeszcze szansę dla 30Hz i 10/12bpc.

3. Wbrew powtarzanym często tu i ówdzie twierdzeniom, przyzwoity PCet obecnej generacji (i7-6700K + GTX1080) bez problemu ciągnie w 4K na ULTRA takie tytuły jak Wiedźmin 3 czy Rise of the Tomb Raider (z zastrzeżeniem, że w DX11, bo w DX12 na GTX1080 grać się jak najbardziej da, ale przerywniki na enginie gry tną już okrutnie).

Jeśli mam Panasonic EX700e i nie widzę zbytnio różnicy w obrazie z HDR i bez to przez to, że ma on słaby HDR czy ja jestem niewymagający

Tak na marginesie, 10 bit (dokładniej 3 x 10 bit dla RGB) to trochę ponad miliard kolorów a nie cztery miliardy.

Sorry za wprowadzanie w błąd - jednak daje się na LG65B7 ustawić 4K@60Hz:

a) 4:2:0 w 8 lub 12 bpc

b) 4:2:2 w 8, 10 i 12 bpc

tyle że:

1. Najpierw trzeba zatwierdzić zmianę formatu koloru wyjściowego - bez zatwierdzenia lista rozwijana zawierać będzie tylko 8bpc właściwe formatowi RGB.

2. Przy ustawionym formacie 4:2:X i przy włączonym HDRze zmiana głębi kolorów powoduje zanik sygnału z komputera na telewizorze - nie pomaga nawet odczekanie kilkunastu sekund, bo sama zmiana głębi nie wywołuje pytania o powrót do dotychczasowych ustawień. Żeby odzyskać obraz, trzeba wyciągnąć i ponownie włożyć kabel HDMI. Aby zmienić głębię, trzeba najpierw wyłączyć HDR, dokonać zmiany i ponownie włączyć HDR.

Oznaczenie monitora np HDR600 oznacza, że osiągnął on jasność HDR 600 cd/m2 na planszy testowej L20 czy w jakimś bardziej realnym scenariuszu? Mój TV na planszy L20 osiaga ponad 900 cd/m2 i ciekawi mnie jaki monitor odpowiada takiej jasności.

Tal_Rascha - to zależy od danego panelu + czasem też aktualizacji oprogramowania ale są to wartości o wiele wyższe, dla przykładu monitor Samsung C32HG70 który ma certyfikat HDR VESA 600

Monitor ten zgodnie ze specyfikacją spełnia wymogi standardu VESA DisplayHDR 600, co oznacza, że jest zdolny do osiągnięcia w trybie HDR co najmniej luminancji na poziomie 600 cd/m2 (zarówno punktowo, jak i na całej powierzchni panelu).

W trybie HDR przy włączonym FreeSync 2 Samsung osiąga luminancję na poziomie 678,23 cd/m2, po zainstalowaniu firmware'u w wersji 1019.1 panel świeci zauważalnie jaśniej osiągając jasność znacznie przekraczającą 800 cd/m2.

Np. w przypadku mojego monitora HDR VESA 1000 maksymalny zmierzony peak to ok. 1300 cd/m2.

To takie pytanie o hitmana w hdr. Przeszedłem ostatnio Shadow of War z hdr i działało to ok a z hitmanem miałem problem by hdr wyglądał dobrze bo coś tam się aktywowało, ale obraz był mega ciemny, duża utrata detali w ciemnych miejscach i nie dałem rady tego wyregulować. Ta gra tak ma? Puszczam obraz na oleda lg b8.

Do pierwszego posta można dorzucić ten link z listą gier wspierających HDR:

(Sorry - skracałem przez tinyurl, ale GOL chyba nie wyświetla takich linków)

https://tinyurl dot com/ycyzvyo4

Powracam z problemem hdr w hitmanie. Posiedziałem właśnie nad tym teraz i za cholerę nie chce to ruszyć. W samej grze w ustawieniach widnieje tekst, że nie wykryto obsługi hdr. Przetestowałem kombinacje z on/off hdr/hlg w ustawieniach ekranu pod win10, pod dx11 i dx12, z on/off hdr tym z konfiguratora ustawień przed włączeniem gry plus jeszcze odłączyłem monitor na czas testu bo trafiłem gdzieś na informację, że w razie problemów zostawić tylko podłączony odbiornik z hdr i efektu żadnego. Hitman ze steama więc wszystkie łatki są, win wersja 1803.

W innych grach problemu nie miałem, ostatnio przeszedłem shadow of war i było wszystko w porządku.

Radzik -> na zdjęciu z ustawień tv widzę, że masz jasność na 55. Jak nie miałeś kalibracji i ustawiałeś to sam to generalnie błąd bo tego się w 99% przypadków nie powinno ruszać. Trzeba to zostawić na 50 tak jak jest fabrycznie, poniżej 50 traci się detale w ciemnych miejscach a powyżej 50 rozświetlasz czerń, która już nie jest wtedy taka jaka powinna być. Jasnością tv steruje się poprzez oświetlenie oled, które akurat w trybie hdr jest na maksa i tak ma zostać ;)

Jako, że kupiłem sobie PS4 Pro i odpaliłem God of War na TV z HDR, to coś mnie tknęło by także spróbować to włączyć na PC. Wcześniej widziałem w akcji tylko przez Netflix. Nie powiem, trochę musiałem sie naklikać, żeby sygnał HDR szedł przez amplituner i na TV. Może się komuś przyda taki mały poradnik:

1. TV sygnał 'Ulepszony format' - Sony KD-65X8505C

Home > Ustawienia > Zewnętrzne wejścia > Formaty sygnały HDMI > wybór wejścia > Ulepszony format

- co ciekawe, TV informuje, że mogę ustawić "takie jak 4K 60p 4:2:0 10bit, 4:4:4, 4:2:2 (w tym z HDR)", ale prawda jednak jest chyba zdeczko inna.

2. Amplituner sygnał 'Wzmocniony' - Denon AVR-X3400H

Setup > Video > Format Sygnału 4K > Wzmocniony

- tutaj mam taką fajną tabelkę, która pokazuje co i jak (w sumie z tego wynika, że sygnał standardowy też by dał radę): http://manuals.denon.com/AVRX3400H/EU/PL/DRDZSYzvebvotm.php

3. PC- NVIDIA GeForce GTX 1070. Sygnał 30Hz, RGB i 8bpc.

Warto dodać, że w każdym przypadku należy mieć najnowsze sterowniki/firmware, bo np. Sony dodało wsparcie dla HDR dopiero w jednej z aktualizacji.

Przy takich ustawieniach (chociaż teraz mam wątpliwości, czy było to potrzebne, bo 30Hz, 8b w 4K powinno iść RGB normalnie) mogłem włączyć HDR w Windows, zrobić szybki test w Shadow of the Tomb Raider i wygląda na to, że śmiga. Jest jaśniej ;-)

Tylko nie wiem do końca jaki ten TV daje HDR, jakie ma podświetlenie...

Niestety w żadnej innej konfiguracji 4K mi nie działa, a np. chciałem spróbować w 60Hz, 8b, YCbCr 4:2:0 :(

Temat zaktualizowany post nr 1 o listę i opis dostępnych monitorów HDR z certyfikacją HDR VESA. W następnym tygodniu uzupełnię o pełną listę gier PC + konsolę oraz napiszę o moim subiektywnym, ale popartym analizą i sygnału i rozkładu gradacji w dostępnych grach.

Świetny temat AleX, dzięki za włożony czas w skompilowanie tego wszystkiego. Orientujesz się może, czy na horyzoncie jest coś podobnego do monitorów ponizej, ale 2.5k i Freesync?

Acer Predator X27 – 27” 4K 144Hz, G- Sync podświetlanie LED, powyżej 1000cd/m2

ASUS ROG Swift PG27UQ – 27” 4K 144Hz, G-Sync podświetlanie LED, powyżej 1000cd/m2

Alex, czy mógłbym prosić Cię o odpowiedź do mojego posta kilka wiadomości wyżej?

Ktoś jest w stanie wyjaśnić czy między Samsungiem 27 a 32CHG70 jest jakaś różnica w jakości? O dziwo 27 calowa wersja ma znacznie gorsze opinie w porównaniu do większego brata. Mam dylemat wciąż się waham z kupnem czy monitor spełni moje oczekiwania, a teraz doszedł kolejny problem z wyborem cali.

O dziwo nigdzie w większych sklepach czy to media Markt, xkom nie mają monitorów do zaprezentowania tylko z możliwością zamówienia go...

Druga kwestia czy do HDR potrzeba jakiegoś konfiguracji sprzętowej ? (obecnie mam gtx od msi 1070, i5 2500k podkręcony do 4,4 i 16gb ram) domyślam się ze z PS4 wystarczy podpiąć HDMI 2.0

I jak z kablami, wystarczą te co są załączone do Samsunga C32HG70 czy jednak trzeba kupować coś lepszego dodatkowo aby cieszyć się z HDR ?

Alex, jest szansa że odpowiesz na mój post? Nie wiem, czy warto czekać na monitory które wymieniłem, czy lepiej brać aw3418dw.

Dzięki Alex za obszerną odpowiedź. Mam jeszcze dwa krótkie pytania:

1) Dlaczego Predator x35 to tylko VESA HDR600 skoro może osiągnąć jasność 1000cd/m2? Czy to znaczy że nie będzie taki wow jak monitory z HDR1000?

2) Jak myślisz, w jakich granicach mogą kosztować te monitory jak wyjdą?

Pozdrawiam

Nie mogłem zedytować postu, więc jeszcze dwa pytania:

3) Wyczytałem, że te monitory mają mieć 512 stref podświetlania FALD (czy jakoś tak). Napisałeś że 384 to teraz top. Czy to w takim razie również powinno przełożyć się na lepszą jakość obrazu? Czy może chodzi o to, że monitor jest 21:9, a więc ma większą powierzchnię i dlatego ma więcej stref?

4) Rozumiem , że ghosting matryc VA nie powinien stanowić znaczącego problemu we współczesnych monitorach VA, skoro na pierwszym miejscu wybrałbyś właśnie tę matrycę?

Dzięki Alex, takich odpowiedzi mi trzeba było. Zdecydowałem się zatem poczekać do Q1 2019, jeśli do tego czasu nie wydadzą tych monitorów, to biorę co innego. Wydaję mi się jednak że mogą kosztować od 5k wzwyż, gdyż taki aw3418dw to prawie to samo co tam, tylko z matrycą ips i bez hdr a kosztuje 4300zł na chwilę obecną.

Czy uważasz, że postęp graficzny w grach w następnych latach będzie miał więcej wspólnego z takimi bajerami jak hdr i innymi technologiami dodającymi obrazu smaku, aniżeli ciągły wyścig za zwiększaniem rozdzielczości ekranu i produkowaniem kart graficznych, które tą rozdzielczość mogą udźwignąć?

Nie bardzo wiem po co komuś większa rozdzielczość w monitorze niż 4k, z racji odległości w jakiej się siedzi od monitora, co innego technologie jak hdr, realnie wpływające na jakość obrazu. Więc ta ścieżka wydaje się bardziej naturalną drogą rozwoju w przyszłości.

Alex zachwycał się "HDR" w RDR2 na premierę, a wiadomo jak Digital Foundry zweryfikowało to pseudo HDR, zakłada i prowadzi o tym wątek...

#ekspertroku#fachowiec

AIex - hdr trzeba konfigurować na komputerze? Przykładowo w Far Cry 5, Oddyseya i w nowym Tomb Raider to tylko w opcjach włączam HDRa różnice widać spora między SDR, a HDR Chociaz nigdzie nie mogłem znaleźć jakichś opcji nie licząc tego co jest wbudowane w Windowsie jak go włączę to filmy odpalone w odtwarzaczu wyglądają obrzydliwie jasno.

Przyznam że obecnie gry na nowym monitorze wyglądają kilka poziomów graficznie wyżej w porównaniu do mojego starego.

Jakieś programy konfigurujace hdr. Stestowanie go czy reszta opcji działa jak należy aby wyciśniąć maksimum z monitora również w zakresie hdr?

HDR w RDR2 ssie. To jest fakt..

Ale zrozum, ze HDR to nie tylko nity... To rowniez detale w bielach i czerniach i tutaj to lezy. Linkowalem Ci juz raz filmik Vincenta na YT. Tak sie sklada, ze evilboris, od ktorego wrzucasz tu zdjecia z nim pracuje. Te pseudo ustawienia w tej grze, owszem podbijaja peak, ale podbijaja zarazem ogolna jasnosc, przez co gra robi sie wyprana... Ogolne zalozenie HDRu tutaj lezy i koniec tematu.

Jestem purysta dobrej jakosci obrazu. HDR w tej grze tego nie oferuje, dlatego dla wiekszej glebi wole grac w SDR. I zeby nie bylo, poziom detali w tej grze, podobnie jak Ciebie mnie po prostu powalil, ale HDR ssie, niestety. Mam nadzieje, ze w koncu wyjdzie jakis patch i naprawi ten problem.

Ogarnąłem pierwszy film w HDR i mam problem. Co kilka sekund obraz we filmie robi się jaśniejszy na 2-3 sekundy po czym z powrotem wraca do jakości HDR

Miał ktoś podobny problem? Wie jak go rozwiązać ? I czy w ogóle jest sens oglądania filmów w HDR bo znaczących różnic w jakości obrazu, a do tego co mam w grach nie widzę. Jeśli chodzi o mój problem to nigdzie w internecie nie mogę znaleźć podobnego problemu.

Używam DisplayPort. W VLC Media Player obraz mam strasznie ciemny w porównaniu do Media Player Classic gdzie w obu odtwarzaczach obraz po kilku sekundach oglądania robi się jaśniejszy (czynność powtarza się co chwile)

Czekajac na nowe monitory PG35VQ i X35, zastanawiam się czy nie lepiej kupić telewizora OLED z HDR i do tego konsolę np. LG OLED55B8. Co da lepsze gaming experience? 21:9 curved 34" czy taki telewizor? I czy powinienem przejmować się wypalaniem obrazu w OLEDach? Czy technologia OLED to naprawdę "game changer"?

Mam mały pokój dla siebie do grania i szukam niedużego monitora. Moje pytanie jest takie, czekać na OLED-y , które mają wyjść w tym roku, czy kupić ASUS ProArt PA24AC, albo BenQ EW277HDR ? Pomóżcie proszę , bo chcę kupuć RTX2060 w tym roku, a do tego i win10,żeby nowe efekty były, plus monitor na HDR. Dodatkowo może KTOŚ MA, albo zna cechy ASUSA PA24AC ? Gram praktycznie w same RPG-i, zero FPS-ów, ale nie kupię od tak monitor w ciemno.

Cyberfan Inaczej pisząc, radzisz czekać na OLED-y. Też tak myślałem, ale jak w tym roku znów nie wyjdą ? Mam dość wiecznego czekania "w następnym roku" . Tym bardziej ,że patrząc na obecną ofertę monitorów HDR, to z mojej perspektywy, to jest bardzo źle. Szukam nie dużego, najlepiej na VA, min.75 Hz odświeżania i super, jak by to był 16:10 max 24". Jak pisałem wcześniej tylko Benq, albo Asus znalazłem w przybliżonych parametrach, a tak to jakieś zakrzywione i dużo za duże.

@A.l.e.X

Padają w tym wątku stwierdzenia na temat vr które są u podstaw całkowicie błędne technicznie. Jak mowie, odbiera to powagę temu wątkowi, a szkoda, bo w temacie HDR sam się tutaj paru autentycznie ciekawych rzeczy dowiedziałem. No ale jak się jednocześnie czyta takie kwiatki... Po prostu tworząc wątek na jeden temat, lepiej nie pisać o innych rzeczach których się nie zna.

Sam nie będę ich prostował w tym wątku, bo jest to wątek na inny temat i nie ma sensu mieszanie tematów. Miej jednak świadomość że Twoje "zapewnienia", są błędne. W szczególności te techniczne. "Waga", a już tym bardziej "rozdzielczość", od dawna nie są problemem, choć samo użycie tych terminów jest kolosalnym błędem samym w sobie.

Natomiast HDR jak sam napisałeś - zależy od jakości sprzętu. To nie jest wcale tak że "jest dostępne wszędzie". Bo w wielu, o ile nie większości przypadków (nie wiem, na tyle co sam widziałem), bardziej niszczy wrażenia, niż coś dodaje. Piekne kolory. Tragiczna czerń.

Osobiście mam wrażenie że to ma prawo działać tylko i wyłącznie na oledzie. Natomiast nie może to dobrze działać na matrycy podświetlanej, nawet kwantowej z lokalnym wygaszaniem. Tam to tym bardziej halo bije po oczach aż boli i to nawet w dzień przy włączonym świetle.... Lcd się nie nadaje do takiej zabawy. IMHO. To właśnie ta technologia musi wydaje mi się jeszcze kilka lat poczekać - na najlepiej microledy.... Dopiero wtedy będzie zabawa.

Osobiście póki co korzystam z 200calowego projektora - to dopiero robi efekt... Nawet bez hdr :)

Paradoksalnie projektory maja tu spore pole do popisu, bo w dlp "czarne piksele" nie emitują światła, jak w Oled. A źródła światła Ostatnio przechodzą potężną rewolucję.

A.l.e.X rozumiem, ale ja potrzebuję nieduży monitor. Stąd moje pytanie, kupować Asusa PA24AC, czy czekać na OLED-y ?Asus na CES2018 zapowiadał monitory OLED 22", ale od tej pory cisza. Ba nawet jeden pokazał 24" OLED 4K, ale od tamtej chwili cisza. Zmieniam kartę graficzną i system na win10,żeby te wszystkie nowe funkcję mieć, stąd moje rozważania, pytania i zdenerwowanie bo pod moje wymagania, potrzeby nie ma monitora. A nie dam 11 tysięcy za Asusa 27" :/

Siemacie ;)

Mam pytanie, czy monitor 2560x1440 75Hz z HDR600 będzię śmigał na karcie NVidii (1080ti) tak jak należy? Czy tylko w 8 bitach i 60 hercach? Czytam na necie sporo sprzecznych opinii, dodam że zarówno karta jak i monitor wspierają HDMI 2.0b, monitor ma też DisplayPort 1.2a, ale HDR na DisplayPort jest wspierane tylko od wersji 1.4.

Bo że w 4K z HDR na HDMI 2.0b to tylko w formatach 4:2:2 albo 4:2:0 na NVidii to wiem (choć nie wiem jak na Vedze od AMD). Ktoś coś?

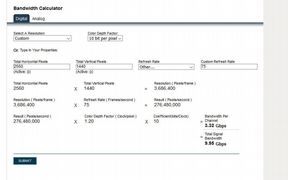

premium - a czemu ma nie działać, przepustowość HDMI 2.0 (a/b) to 18Gbps 10bit przy 1440p i 75Hz to połowa tego, na HDMI jesteś w stanie przesłać w tej rozdzielczości w 10bitach obraz bez problemu w 120Hz na tym złączu. DisplayPort 1.2 także wspiera HDR tak samo jak DP1.4 wszystko rozchodzi się tylko o przepustowość która w przypadku 1.4 jest bardzo duża. Oczywiście mówimy tutaj o sygnale RGB lub 4:4:4 bez żadnej kompresji koloru. Poza tym w specyfikacji monitora będzie dokładnie opisane w jakich parametrach HDR pracuje.

https://k.kramerav.com/support/bwcalculator.asp

Cubi_ - bardzo wątpię, aby peak jasności był duży potrzeba dużej matrycy szczególnie w oledzie, w przypadku tak niewielkich ekranów jak 22-24" bardzo wątpię czy przekroczy 400-500cd/m2 (bo pewnie nawet tego nie przekroczy). W pierwszym poście masz listę monitorów do wyboru, ja bym na tak małego oleda nie czekał.

Alex, rozeznajesz się w sprzęcie PC znacznie lepiej ode mnie, więc mam jedno proste pytanie, bo w takim zbiorczym wątku zadać je łatwiej.

Czy warto kupować teraz monitor z HDRem i czy są w ogóle jakieś przyzwoite na rynku, czy czekać jeszcze rok-dwa na upwoszechnien ie się OLEDów?

W salonie mam LG B6 spięte z PS4 Pro i nawet kompletny laik czasami przyglądający się grom czy choćby produkcjom z Netflixa obsługującym HDR lub Dolby Vision zauważa rażącą różnice w jakości obrazu i samej przyjemności z oglądania, a dla mnie jest to o tyle bardziej widoczne, że pracuję na całkiem przywoitym LCD iiyamy w zwykłej rozdziałce full HD i może przy klepaniu w Wordzie nie jest to tragedia, ale już przy odpaleniu jakiejkolwiek gry różnica w odbiorze w stosunku do telewizora jest rażąca (dlatego też mam na dole TV spięty po skrętce w ścianie z kompem na piętrze, gdy mam ochotę zobaczyć czerń i kontrast :)).

Od dwóch lat się przesiadam na nowy monitor i się przesiąść nie mogę, zwłaszcza po zakupie nowego telewizora. Jest coś faktycznie godnego polecenia na rynku już teraz, czy jednak się wstrzymać?

Mam B7 (też spięte z PS4 Pro) i jestem bardzo zadowolony z zakupu, ale nigdy w życiu nie kupiłbym OLEDa w charakterze monitora, i nie sądzę żeby te szybko pojawiły się na rynku na szeroką skalę.

Jest już nieźle udokumentowane że o ile nie przeginasz pały - wypalenia są ekstremalnie rzadkie ( https://www.youtube.com/watch?v=nOcLasaRCzY ) ale statyczny taskbar i jasne elementy przeglądarki to po prostu proszenie się o kłopoty - jakby nie patrzeć Chrome to coś co jest odpalone czasem tysiące godzin w skali roku.

Na mojej S8 Relay for Reddit miał czarny theme (0, 0, 0 na RGB) i jasny navbar, a że jest to jedyna aplikacja której używam dziesiątki godzin tygodniowo (swoją drogą naprawili tą anomalię i navbar jest tego samego koloru co theme, ale już po ptokach) - mam wypalony pasek, który wybitnie nie przeszkadza, ale jest ewidentnie widoczny przy niektórych kolorach (czasem zaś kompletnie niewidoczny).

MicroLED z kolei dopiero raczkuje.

Ok, mam już swój nowy monitor a konkretnie kupiłem model HP Pavilion Gaming 32 HDR Display – 32” 1440p, 75Hz, FreeSync 600cd/m2

W sklepach podają że wspiera tylko DisplayPort w wersji 1.2a, jednak wspiera też wersje 1.4 co jest miłym zaskoczeniem (można w opcjach wybrać tryb DP 1.1, DP 1.2 i DP 1.4), wspiera także HDMI 2.0b.

Ale, jeśli chcę ustawić RGB Full 10 bitów w nVidii Control Panel to jest to tylko możliwe przy 60hz, przy 75hz ustawienia wracają na 8 bitów automatycznie, testowałem też HDMI ale wtedy jest tylko 8 bitów do wyboru a 10 bitów niema nawet w opcjach karty (GTX 1080Ti). A szkoda bo chciałem 1440p, 75hz i HDR 10bit.

To jest dziwne, gdyż na DisplayPort 1.4 powinno działać nawet na 4K w 10 bitach z HDR i do 98Hz (do 120hz na Radeonach lub do 144Hz ale wtedy tnie colory do 4.2.2 albo niżej nawet). Chyba poczekam na Radeona VII, niech stracę 10% wydajności, ale na radkach jest mniej cyrków z tym HDR/HDMI/DisplayPort, nawet niektóre recki np. na Guru3D o tym wspominają.

Oczywiście HDR działa w tych 8 bitach i wygląda bardzo dobrze np. w demie Resident Evil 2, ale skoro może działać nawet lepiej...

Ciekawy eksperyment przeprowadziłem, mój kolega ma Radeona Vegę 56, przetestowaliśmy na nim używając DisplayPort 1.4, 2560x1440, HDR 10 bitów RGB Full i z 75Hz działa! Choć Freesync razem z HDR też nie działa, ale to już dlatego, że monitor wspiera Freesync 1 a nie Freesync 2. W każdym bądź razie przynajmniej HDR z 10bit i 75Hz działa ok, więc czekam na Radka 7 ;)

NVidia ma coś namieszane, i z tego co czytam nie jestem jedyny z tym.

Ok, teraz już w sumie wszystko wiem, dzięki za porady, pozdro.

To ja się pochwalę,że mam nowego ASUS PA24AC i w sumie jest prawie idealny ! Zacznę od kolorów i głębi czerni, ideał ! Wcześniej miałem Eizo na S-PVA i no nie było tak pięknie. Do gier super ! Nigdy nie widziałem tylu szczegółów i tyle kolorów. Pomimo tylko 60Hz, coś kosztem czegoś, bo chciałem mieć jak najmniejszy monitor, to grając nawet w FPS-y nie ma smużenia, tu technologia ASUSA pomoga, a imput lag , według mnie nie ma. Ogólnie super monitor do multimediów, gry, filmów , neta z nowoczesnymi opcjami. A dlaczego nie jest idealny ? Więcej Herców by mógł mieć, min 75, plus mam wrażenie , że mimo zaznaczonego G-sync i obługiwanego FreeSync przez monitor , nie chodzi on za dobrze. A mam pytanie w panelu zmiany rozdzielczości jest format koloru wyjściowego YCBCR444, z tego co czytałem to większa liczba kolorów, ale jak ją ustawiam to wyjściowy zakres tonalny AUTOMATYCZNIE mam ograniczony i nie da się go zmienić. Zostawić na standardowych ustawieniach czy zmienić coś ??? A i w opisie technicznym ASUS podaje wyjście DP 1.2, a to MUSI BYĆ 1.2a, żeby obsługiwało FreeSync. Dzwoniłem do ASUS POLSKA i pan...powiedział,że to 1.2a, ale szczerze to mało przekonująco to powiedział, sam pewnie nie wiedział. ASUS powinien szczegółowiej to pisać. Ale ogólnie MONITOR BARDZO POLECAM ! :)

Tak jeszcze na chwile wracajac do tematu:

„Cainoor - na PC na HDMI 2.0 możesz ustawić 8bit 4:4:4 lub RGB pełne i 60Hz, 10bit 4:4:2 w 60Hz lub 10bit 4:4:4 pełne RGB w 30Hz. Obraz w HDR musi być ustawiony na 10 lub jak ktoś chce 12bit tylko pozostaje otwarte pytanie dla tych którzy zachwalają ekrany w TV 12 bitowe na jakim złączu chcą przesłań dane w HDR 4K w 12bit i w powyżej 30Hz, bo takiego nie ma.”

Niestety nie dziala mi 4k i 60Hz w zadnej konfiguracji, a i chcialem chociaz mieć 50Hz, 4:2:0 i 8bit do testu :(

W 30Hz i owszem. Chociaz tylko RGB i 8bit. W ogole w Panelu sterowania NVidia nie moge wybrac ani 4:2:0 ani 10bit. Ktos cos?

Zobacz, czy nie ma nowszej wersji sterownika, coś mi się kojarzy, że był problem z 10-bitami w jakiejś wersji i też kiedyś nie mogłem włączyć mimo iż zawsze się załączało.

Druga rzecz, sprawdź czy monitor/TV ma włączony Deep Color oraz złącze jest ustawione na HDMI 2.0.

Co wydaje się najbardziej prawdopodobne, bo jak HDMI pracuje w 1.4 to pozwala tylko na 4K w 30 Hz.

Cainoor - Jeśli chodzi o 4K to możliwość uzyskania 60Hz+ oraz 4K i 10bit w pełnym RGB jest możliwe tylko przy użyciu Display Portu. W przypadku TV gdzie mamy tylko HDMI2.0 (dopiero w 2020 mają wyjść telewizory z HDMI2.1 ale nadal nie ma GPU z tym złączem seria 2xxx ma tylko HDMI2.0 na wyjściu) więc na TV obraz 4K w 60Hz będzie 4:4:2 przy HDMI. W przypadku monitorów 1080p i 1440p problemu nie ma bo ilość danych w 10bitach dla tej rozdzielczości jest poniżej 19Gbps. U mnie na Display Porcie ma nawet 98Hz na monitorze ASUS w 10bit i 4K. 12bit w TV to chwyt komediowy dla komediantów ;) Konsole mają 30Hz-50Hz w 4K, lub ubscaling z niższej rozdzielczości więc są w stanie w 4K wyświetlić HDR ale nie ma mowy o uzyskaniu na tym złączu 60Hz + na 10 a tym bardziej na 12 bitach. Likfidator ma najprawdopodobniej rację TV/monitor pracuje w HDMI1.4 (ustawienia, może być to też wina kabla, lub karty graficznej)

Cubi__ - ten monitor ma pełne pokrycie RGB ale ma tylko 8bit wiec HDR w nim dotyczy tylko bieli i czerni (niestety) nie dostaniesz rozszerzonej palety barw koloru, co oczywiście nie zmienia faktu że efekt HDR uzyskasz ale nie pełny. Poza tym jest to b. dobry monitor i ma dość dużą jasność jak na 24" bo czym mniejszy panel tym trudniej podbić cd/m2.

A.l.e.X no to mnie pocieszyłeś -_-....a ja się tak cieszyłem,że ma taką dużą paletę barw...., lepsze przejście tonalne kolorów, które nie wiem czy trzeba jakoś ustawić czy automatycznie na DP jest już włączone. Producent napisał,że wykorzystuje on 14 bitową tablicę referencyjną, dlatego faktycznie liczyłem, na płynne przejście barw, co pewnie mam, ale się czepiam szczegółów , jak to ja ;P , no i liczyłem na format koloru wyjściowego YCBCR4222, bo przy okazji recenzji tego najdroższego Asusa 27" do gier , to przeczytałem,że to daje najlepszą szczegółowość obrazu i ilość barw, dlatego tak się o to DOPYTUJE i to "Wyjściowy zakres tonalny" ograniczony mnie wnerwia . Pomijam to,że na stronie asusa jest napisane DP 1.2 i ,że obsługuje "Adaptive-Sync supported :Yes", a powinno być napisane ,że DP to 1.2a bo poniżej AS nie jest obsługiwany. Ale ogólnie na prawdę monitor prawie idealny. Kolory, barwy, ich głębia, czarny, no pięknie jest. Plus fabryczna kalibracja. Jak od dłuższego czasu nie ufam tej firmie, to przy tym monitorze to majsterszczyk no i NAJMNIEJSZY MONITOR Z CERTYFIKOWANYM HDR co widać.

ten monitor ma pełne pokrycie RGB ale ma tylko 8bit wiec HDR w nim dotyczy tylko bieli i czerni (niestety) nie dostaniesz rozszerzonej palety barw koloru

Alex, nie pisz głupot, bo robisz tylko niepotrzebne zamieszanie. Ilość bitów matrycy nie ma żadnego znaczenia dla poziomu wypełnienia przestrzeni barw. 10-bitów ledwie pomaga w usuwaniu bandingu, ale jest to praktycznie pomijalne. Specjaliści na stronie rtings.com pisali nie raz, że 10-bit == 8-bit + FRC.

Tak naprawdę nawet FRC nie jest konieczny, bo przy wysokich rozdzielczościach dithering skutecznie usuwa banding, co pokazują testy gradientów z Rtings na low-endowych TV.

To co jest istotne, to przetwarzanie obrazu w 10-bitach. Ze względu na specyfikację algorytmów kompresji wideo dużo łatwiej jest przechować 10, 12 czy 16-bitowe składowe niż wygładzający szum. Dlatego to zadanie jest przekazywane elektronice matrycy.

Co więcej, HDR + 8-bit daje lepsze rezultaty niż 10-bit bez HDR. Pisałem już kiedyś, że metadane skalują zakres jasności każdej sceny. W przypadku LCD pozwala to ustawić podświetlenie na np. 10% i używać całego zakresu 0-255 dla sceny ciemnej. To właśnie to jest powodem dla którego HDR ma tyle detali w cieniach i jasnych punktach.

12bit w TV to chwyt komediowy dla komediantów ;)

I tak i nie. 10-bit + meta dane HDR mają więcej treści niż 12-bitów. Tak na marginesie, silniki gier używają 16-bitowych składowych, które na późnym etapie są konwertowane do HDR czy SDR algorytmem tone mappingu.

12-bitów może mieć sens, w momencie gdy wyświetlacze osiągną pełne pokrycie rozszerzonych przestrzeni barw, a zakres jasności osiągnie 4000-10000 nitów.

Rozumiem. Czyli co, tylko OLED-y ? Tylko OLED będzie miało odpowiednią technologię, technikę,żeby w "niedużych" (do 24 cali) monitorach było np. HDR1000,czy 600 ??? I znów czekanie...Tak czy siak SUPER za ten wątek. Wreszcie coś konkretnego i z tego wątku kupiłem mój monitor. Jeszcze raz dzięki A.l.e.X

Czy Samsung CHG70 to naklepsze co można dostać w cenie do 2500zl?

Szukam czegoś z HDR 600, 27 cali, 1440p, odświeżanie większe niż 60 hz byłoby miłym dodatkiem. A moze w najbliższych miesiącach wyjdzie coś ciekawego w tym przedziale cenowym?

Monitory HDR to dla mnie za droga zabawa (nie mam nawet jak to zobaczyć) ale nadal żyje w boomie telewizorów Samsung 3D.

Wciagnalem się w to dopiero 3 lata temu, testujac 3D który - byl to grzech bylo nie sprawdzić.

Kino S-F typu Marvel/DC w 3D to totalny sztos.

W kolejce m.in mam Kapitan Marvel, Avengers Endgame, Shszam, Alita, Dumbo, Aquaman.

Nie uwazam ze moda minela, filmy 3D nadal sie swietnie rozchodza i wychodzi sporo nowych. Moim zdaniem odebrano technike dla wsparcia kin. Nigdy mi HDR w tv nie zastapi 3D aktywnego

Dotarł do mnie wczoraj monitor i jestem bardzo zawiedziony. W trybie HDR obraz jest wyprany z kolorów, długo bawiłem się wszelkimi ustawieniami i nic nie przynosiło sensownego efektu, obraz w hdr jest gorszy niż sdr. Dla porównania mam telewizor Sony Bravia gdzie HDR faktycznie jest niesamowity.

Mnie bardzo pozytywnie zaskoczył mój laptop Asus TUF Gaming odnośnie HDR.Naprawdę fajnie efekt daje ta funkcja, jak na matrycę FullHD i nie spodziewałem się kupując go, że będzie ją posiadał.

Moglbys mnie Alex pokierować jak to poprawnie ustawic? Zachwalany pod kątem hdr assassin's Creed odyssey na HDR wyglada o wiele gorzej niż sdr

Posprawdzałem parę gier, większość na HDR wygląda gorzej niż SDR, zwłaszcza Assassin's Creed Odyssey, ale są i takie które wyglądają ślicznie np Battlefield 1, nie wiem od czego to zależy, czego to jest wina i jak to naprawić.

Tal_Rascha - niestety miałem ten sam problem z którym nie mogłem się uporać ale jest opcja że nie ogarnąłem po prostu i straciłem cierpliwość (https://www.gry-online.pl/S043.asp?ID=14945102). Monitor oddałem, potem testowałem jeszcze dwa i o ile HDR w żadnym nie działał jak powinien tak ten Samsung poza tym był naprawdę spoko i chce do niego wrócić, kupić już normalnie zamiast się bawić we zwroty. Tylko że no... ten HDR dobrze by było mieć jak należy. W każdym razie, jakbyś znalazł jakieś rozwiązanie jak to wszystko ogarnąć, ustawić, proszę daj znać w tym wątku.

Czyli podobnie jak z rtx nie warto tracić pieniędzy i poczekać na mainstreamowy support.

HDR to taki sam przełom w TV jak przeskok z SD do HD. Problemem jest jednak to jak telewizory czy wyświetlacze interpretują sygnał z konsoli czy komputera.

Najmniej problemów jest przy odtwarzaniu filmów z pendrive'a czy używaniu Netflixa, Amazona i innych appek ze smart TV. Kodeki telewizora doskonale wiedzą jak interpretować sygnał HDR.

Przesyłanie HDR przez HDMI bywa jednak problematyczne. Dlatego prawie wszystkie gry z HDR mają dwa suwaki jasności, jedna dla jasności białej kartki (czy jasności SDR), druga dla maksymalnej jasności. Niestety to nie wystarczy, bo trzeba jeszcze kombinować z suwakami telewizora czy monitora.

Tryb HDR ustawia się inaczej niż SDR. Często trzeba ustawić "jasność" poniżej 50/100, np. na wartość 40-45. Nie oznacza to, że obraz będzie ciemny, bo HDR inaczej liczy jasność. Zmniejszając parametr jasności uzyskujemy bardziej nasycone barwy.

Może być tak, że przy jasności 50/100 telewizor wymaksuje się nam na 1000 nitów, a jak ustawimy 40/100 wymaksuje się dopiero na 2000 czy wyżej.

Najpierw ustawiamy suwaki w TV, potem suwaki w grze.

Ja miałem tak w przypadku Forzy na telewizorze LG. Obraz był wyprany z kolorów. Zmniejszenie jasności i ponowna regulacja suwaków pomogła.

Po prostu nie ma na to łatwej odpowiedzi. Po prostu trzeba usiąść i testować najróżniejsze opcje. Po godzinie takich testów wyczujemy jak to należy ustawiać i każda kolejna gra będzie łatwiejsza do regulacji.

Część gier lepiej też znosi złe ustawienia TV np. Battlefield 1 czy Mass Effect Andromeda.

Dlatego polecam właśnie Forzę Horizon 4, bo jak już w niej się uda dobrze zestawić wyświetlacz, to wszystko inne będzie piękne.

EDIT:

ciężko nawet wywnioskować czy winny jest monitor, NVIDIA czy Windows

Nie wiem czy jest sens winić Nvidię i Windows. Mam 2 TV Samsunga z 2016 i 2018. Do tego LG z 2016 i także budżetowego TCLa. Na każdym z tych TV HDR jest w grach wyświetlany poprawnie, na tyle na ile te matryce potrafią uzyskać HDR.

Ściągnąłeś sterowniki do tego monitora? Samsung ma na swojej stronie profile do monitorów. Nie wiem czy to pomoże, ale warto spróbować.

A.L.e.X

Pojawiła się aktualizacja co do certyfikacji VESA HDR i nowy poziom 1400, więc możesz zaktualizować w wolnej chwili wstępniak, twój wymarzony pułap 1500 powoli nadchodzi ;)

https://pclab.pl/news81831.html

Ja natomiast wystawiałem niedawno Samsunga CHG70. Cena w zakupie oczywiście rewelacyjna i nieosiągalna do kupienia przez tradycyjne sklepy czy pomarańczowy portal, ale chwilowo nie potrzebuję tego monitora, niemniej sprzęcik kusi, oj kusi :D

Cześć, przymierzam się do kupna monitora, czas zmienić mojego starego TN 75 HZ. Cena do 2500 PLN, monitor musi mieć rozdziałkę 1440p ( czas się przesiąść wyżej z FHD ), 120-144 HZ, nie chcę już TN, więc VA lub IPS, ładne nie wyprane kolory i fajnie jakby właśnie miał dobrze zaimplementowany chociaż ten HDR400 ( nie tylko pseudo ), wiem że w tej cenie nic wyżej nie ma oprócz tego Samsunga CHG70 ale czytałem i nie pasuje mi ten monitor.

Nie wiem też co z wielkością do tej rozdzielczości ( biurko mam chyba dosyć szerokie 75-80 cm ), czy najlepiej 27 cali, a czy 31,5 nie jest już trochę za wielki i obraz nie będzie tak ostry ?

Możecie polecić jakieś modele w tej cenie ?

coś co znalazłem np.

https://www.x-kom.pl/p/380148-monitor-led-27-aoc-agon-ag273qcx-curved-hdr.html#Specyfikacja

Największa ciekawostka z tych moich podboi wobec HDR jest na załączonym obrazku.

Po prawej zdjęcie monitora z obrazem, czyli jak ja to widzę. Po lewej zrobiony zrzut ekranu, czyli jak widzi to windows. Zrobione w tym samym czasie. Pomijając fakt że obie strony wyglądają nie poprawnie to jednak, przede wszystkim chciałbym się zapytać, o co k... chodzi? :D

Mam pytanie, zrezygnowałem na razie z wymiany monitora na jakiś obsługujący HDR, ale chciałem przetestować jakość obrazu z tą opcją w grach, i jako, że mam TV Oled z HDrem, a nie mam konsoli, to postanowiłem, że podłącze PC-ta pod telewizor i sprawdzę parę gier typu AC:O jak to wygląda i czy warto w przyszłości odłożyć na porządny monitor. Pytanie jakim kablem podłączyć, żeby ten HDR działał pomiędzy pc - tv w 4K. ? TV ma wejścia tylko HDMI, więc nie wiem czy wystarczy zwykły kabel HDMI 2.0 z dwoma końcówkami, czy pod kartę graficzną powinienien podpiąć kabel z końcówką DIsplay Port, a do TV wyjście HDMI ? Karta od czerwonych Vega 64, nie Nvidia

Cainnor - już raz ci odpisywałem jeśli chodzi o Dolby Atmos / świetnie działa ale musisz mieć przynajmniej dwie tylne satelity.

LG-SN11RG-714

https://www.proshop.pl/Kino-domowe/LG-SN11RG-714-channel-Dolby-Atmos-Soundbar/2873914

Sonos Arc

https://www.sonos.com/pl-pl/shop/surround-set-arc-sub-one-sl.html

Mam zestaw Sonos Arc i polecam, LG-SN11RG -714 nie miałem ale słyszałem że też jest bardzo dobry.

Cainnor - jeśli chodzi o projektor to uważam że nie ma lepszego obecnie od laserowego projektora krótkiego rzutu

https://www.euro.com.pl/projektory-multimedialne/optoma-projektor-optoma-uhz65ust.bhtml

sam mam ten ale czarny

https://www.euro.com.pl/projektory-multimedialne/epson-projektor-epson-eh-ls500w_1.bhtml

obraz na tym prezentuje się genialnie ale wymaga odpowiedniego podkładu tj. ekranu projekcyjnego ARL (poniżej 120" co jest optymalne do 50m2 pomieszczenia kinowego)

https://ekranownia.pl/sklep/grandview-dynamique-266x149cm/

Moim zdaniem nic lepszego obecnie nie ma do domowych zastosowań

https://www.youtube.com/watch?v=YXe0vvcJjOQ&t=391s

https://www.youtube.com/watch?v=T3FQjCyNtdw&t=170s

Zbieram info, bo zaczynam budowe domu. Jestem na etapie „optymalnego pomieszczenia” tj zbieram info o rozmiarach ekranow i planowaniu rozmiarow. Pokój do kina planuje wrzucic na -1, wiec wysokosc 2.8 to chyba max i w zwiazku z tym optymalne rozmiary to cos kolo 4x7. Dosyc wasko, wiec jeszcze mysle. Powinien zmiescic sie w tej szerokosci z dolby atmos, i ekran 120” i kanapa dla 6 osob...

W związku że nastąpił wysyp świetnych TV które mogą służyć jako monitor (złącze HDMI2.1 i 120Hz w 4K G-Sync/FS2) z HDR kilka wartych uwagi pozycji i serii :

Karty serii GeForce RTX 3xxx i AMD Radeon 6xxx mają wsparcie dla trybu HDMI2.1

Przykłady czterech TV 4K

LG OLED C1 - HDR na planszy testowej 0-10% pod 750 cd/m2 w przypadku OLED jest to wartość na którą można porównać w odczuciu odbioru do ok. 1000 (LED)

https://www.flatpanelshd.com/review.php?subaction=showfull&id=1622779286

LG OLED G1 eVO - HDR na planszy testowej tak samo 0-10% pod 750 cd/m2 - jest to kolejna inny wizualnie wariant modeli oled na 2021 rok od LG

https://www.avforums.com/reviews/lg-g1-oled65g1-oled-evo-tv-review.18618

Neo QLED Samsung QN95A - HDR który deklasuje wszystkie oledy 1500cd/m2 powoduje że HDR wskakuje na następny poziom odczuć wizualnych

https://hdtvpolska.com/samsung-neo-qled-qn95a-mini-led-test-recenzja/?showfull=1

Neo QLED Samsung QN85A - HDR na poziomie 1200cd/m2, pozostałe zalety takie same jak przy całej serii neo qled

https://spidersweb.pl/2021/04/neo-qled-qn85a-recenzja.html

Alex, a nie masz wrażenia ze ten twój projektor jest jednak zbyt głośny? 37dB to chyba już sporo na jakieś ciche momenty

Amadeusz ^^

Likfidator

A.l.e.X

Zachowujecie się jakbyście mieli 19 lat i pierwszy raz na studniówce złapali dziewczynę za biust :)

kaersol - aby zobaczyć materiał HDR musi być od puszczony na TV, a nie mieć naklejkę HDR UPremium / cena TV nie ma tutaj żadnego znaczenia a raczej wielkość cd/m2 (poza tym 14K za TV powiedzmy oled to żadna cena). Rozpiętość tonalna która widzisz na materiale HDR (musiałby być taki włączony z metadanymi) nie dostaniesz na SDR co powoduje że obraz na standardowym urządzeniu wygląda jak z innej epoki. W grach to jest to tak jakbyś grał na low, a w przypadku HDR na ultra z podbitym cfg.

Jeśli chodzi o HTC VIVE lub inne gadżety VR które ważą po 300-500g to pograj w tym przez 3-4 godziny a zapewniam cię że następną porcie zabawy zapewnisz sobie dopiero jak na tym gadżecie będzie z półcentymetrowa warstwa kurzu ;) Pomijam już dostępne materiały oraz technologiczne niedoskonałości : waga/poręczność/rozdzielczość.

A.l.e.X Jaki TV byś mi zaproponował z prawdziwym 4K, matrycą OLED i z HDR 1000 nitów? Wielkość TV to minimum 55". A budżet to max 10 000 zł, chociaż wolałbym coś tańszego. Jakość adekwatna do ceny.

Z góry dziękuję za odpowiedź i pozdrawiam.

ALEX - dzięki za te odpowiedzi i za ten cytat:

Jak masz normalny monitor/TV z 8bit matrycą to masz ok. 256 odcieni szarości (w rezultacie tak naprawdę 220 które przy podświetleniu 100cd/m2 były wystarczające do przejścia tonalnego, w przypadku obrazu HDR ze względu na dużo większe zakres podświetlenie np. 1000cd/m2 (HDR domyślnie do 10000cd/m2) trzeba było wprowadzić dodatkowe wypełnienie aby odcienie nie wyglądały jak paleta składająca się z kwadratowych kolorów, dlatego matryce 10bit mają 1024 odcieni szarości. (tak wygląda przejście tonalne - zakres ten został znacząco poszerzony). M.in dlatego dostajesz gigantyczną większą ilość kolorów 8bit ma ich 16.7Miliona, a 10bit ma ich 4.3Miliarda (256x więcej) - to jeśli chodzi tylko o kolorystykę i przejście tonalne. Druga różnica to możliwość wyświetlania punktów bardzo jasnych i bardzo ciemnych w jednej scenie co daje dużo większe możliwości wyświetlenia obrazu. Pomijam tutaj jarzący się miecz świetlny w Star Wars czy pioruny w Gears of War 4, lub punkty świetlne po włączeniu plecaka odrzutowego w Mass Effect chodzi m.in. o możliwość pokazania scen złożonych jak np. chmur na niebie wraz z słońcem które nie jest już flarą, a przez chmury przechodzą promienie słoneczne, pomieszczeń np. jaskiń w AC: Origin gdzie wchodząc do jaskini widzisz mrok oraz jednocześnie naturalny wygląd świec, itc. itc.

Żałuję, że nie przeczytałem tego wcześniej. Świetnie wytłumaczone. :) Sporą wiedzę w tym temacie nabrałem.

Obscure - sprawdzisz jak ci się będzie podobać praca na 400cd/m2 i potem kupisz coś lepszego, na pewno efekt już zobaczysz pomiędzy SDR a HDR aczkolwiek daleko będzie mu to tego przy którym podtrzymujesz szczękę ręką :)

Do HDR potrzebna jest w przypadku NV karta serii 9xx dla trybu HDMI, a od 10xx HDR jest dostępny za pośrednictwem i HDMI, i DP. W twoim przypadku możesz przy tej rozdzielczości korzystać i z HDMI2.0 jak i z DP, ja wybrałbym podłączenie go za pomocą DP. Jeśli chodzi o sprzęt nie ma żadnych większych wymagań HDR / SDR jeśli chodzi o wydajność to może ci uciąć na serii kart 10xx maksymalnie 2-5% wydajności w zależności od gry. W przypadku 20xx nie ma już żadnego obcinania wydajności.

Jeśli chodzi o samsunga to jak każdy sprzęt elektroniczny masz 14 dni do zwrotu o ile nie zdemolujesz go i pudełka (bez podawania przyczyny). Zawsze może ci się trafić gorszy lub lepszy egzemplarz. Sam w życiu odsyłałem monitor tylko raz ale dostałem naprawdę wersje nie do przyjęcia. Zawsze możesz zamówić dwa postawić obok siebie potestować i zostawić jeden z dwóch, który będzie ci bardziej odpowiadał. Samsung ma peak jasności ponad 800cd/m2 a to gigantyczna różnica.

Cyberfan - w weekend postaram się odpowiedzieć, na ten moment brakuje mi czasu na to. Postaram się też zrobić update co do gier.

Cyberfan / Cubi_ - Oled jest na ten moment bezkonkurencyjny szczególnie jeśli ma peak w HDR do 700cd/m2 to wtedy w HDR też trzyma wysoki poziom obrazu. Oczywiście aby docenić HDR na Oledzie trzeba mu stworzyć dobre warunki czyli ciemne pomieszczenie. Wadą jest za to ograniczona jasność w SDR oraz tryb dziennej pracy. Oczywiście dotyczy to głównie całościowego odbioru obrazu, w przypadku nastawienia się tylko na doznania HDR to najlepiej wypadają Qledy (TV). Nie nazwałbym Oled przysłowiową zmianą jakości, po prostu za nim nie wprowadzą monitorów z setkami / tysiącami stref/punktów wygaszania to absolutną czerń można uzyskać tylko na oledzie, ponieważ w tym wypadku można przyjąć że stref wygaszania w oledzie jest tyle ile pikseli.

Nie spotkałem się z wypalonym obrazem na oledzie, aczkolwiek problem chyba występuje bo pojawia się w wielu miejscach, jeśli chodzi o proporcje to 21:9 zawsze wygra z 16:9 jeśli chodzi o filmowość doznań. O ile wiem konsole współpracują bezbłędnie tylko w proporcjach 16:9 (mogę się mylić może coś w tej kwestii się zmieniło, nie sprawdzałem ostatnio)

titanium - nie wypowiadam się o VR poza moim subiektywnym stwierdzeniem że to jeszcze nie ten czas, nie mówię że doświadczenie VR nie jest przyjemne bo i pierwszy kontakt był zaskakujący, jednak była to dla mnie tylko chwilowa ciekawostka, sprzęt VR w każdym wydaniu jaki mam jest tylko odbiornikiem kurzu bo stoi nieużywany albo sporadycznie używany, za to HDR jest dostępne i używane wszędzie gdzie występuje. Moim zdaniem VR w tym wydaniu przeminie jak okulary 3D czy gogle różnego typu, może w następnej dekadzie kto wie. HDR w monitorach czy TV niestety zależy głownie od jakości sprzętu, musi mieć dużo stref wygaszania dobrą matrycę lub być oledem.

Cubi_ - aby odbiornik miał dużą jasność musi być w miarę duża matryca tak samo czym mniejsza i rośnie ilość stref wygaszania jeśli to nie oled (bo takich nie ma na ten moment) będzie wpływać na cenę. Oledy nie mają bezpośredniego podświetlania więc nie ma szans na więcej niż 700cd/m2 przy naprawdę dużych ekranach jak 65"+ cali. W monitorach oled raczej będzie nie wykonalne nawet 300 (mogę się mylić oczywiście).

Tal_Rascha - w tej cenie nie znajdziesz niczego lepszego, potem masz już skok do ponad 10K PLN jak w przypadku oparte na ACER Predator i ASUS ROG Swift. Poza tym ten konkretny monitor CHG70 po aktualizacji oprogramowania ma ponad 800cd/m2 więc w nadwyżce do HDR VESA 600. W tym przedziale cenowym nic nie wyjdzie ten monitor i tak staniał z prawie 4 tysięcy do poniżej 3 tysięcy.

Alex, jako znawca powiedz mi, czy jest jakis sposób, by na wyświetlaczu 4K na pececie odpalić HDR np w 1440p? Jesyem prawie pewien, ze da się jakoś oszukać system. Mam guzik HDR na pilocie, ale samo jego włączenie w trybie SDR daje tylko artefakty HDR'owe. Ale gdyby ten guzik jakoś wykorzystać do włączenia rzeczywistego HDR'u? Musi być jakiś sposób.

Alex, czytałeś 3 posty wyzej?

Alex - po co Pan korzysta z TV, jak ma projektor z HDR'em?

1. aby dostać pełny certyfikat VESA HDR1000 musi być spełnione kryterium z tabeli w poście 22, o ile wiem te monitory mimo b. wysokiego peak jasności nie spełniają całego kryterium pod VESA HDR1000, niemniej na ten moment jeszcze nie zostały wprowadzone do sprzedaży i nie dostały certyfikatu więc może będzie to HDR VESA1000. Na jakość HDR ma przede wszystkim wpływ jakość matrycy oraz cd/m2 jeśli będzie to ok. 1000 lub nawet i więcej to będzie to pokazany HDR w najlepszym wydaniu.

2. Ciężko powiedzieć ale na pewno nie będą kosztować jak low endy szczególnie że dostają wszystkie najnowsze rozwiązania stawiam na okolice 3.5-5K PLN brutto

3. na ten moment 384 to top, więc wszystko powyżej to jeszcze lepiej. Chodzi o możliwość wygaszania tak aby uzyskać jak najlepszą czerń i brak poświat dalszych od jasnych elementów (które w HDR mają b. wysokie wartości w nitach).

4. nie ma żadnego problemu VA dla mnie osobiście to najlepsza matryca po Oledzie. Niemniej trzeba brać pod uwagę całość wykonania monitora świetny monitor na IPS i tak wypadnie lepiej od przeciętnego na VA.

Tal_Rascha - to nie jest wina monitora tylko windowsa 10. Podlacz go do konsoli to od razu bedziesz miał dostęp do jego możliwości. Jeśli chodzi o windows to ustawisz wszystko z poziomu nvidia panel sterujacy tj. bity + nasycenie kolorów i gamme. Po prostu nie robisz tego z poziomu monitora ale sterowania gpu. Poradzisz sobie.

Sorry że nie odpisałem bo nie widziałem tematu. Musisz wszystko ustawić z pozycji Nvidia Panel kontrolny, bo winą jest Windows 10, po prostu nie jest w stanie wyświetlić poprawnie kolorystyki na scenie SDR przy włączonym trybie HDR (Windows10). Jeśli gra ma bazową możliwość nasycenia dla kolorystyki np. gry które przejdą w tryb HDR po włączeniu gry lub gry które mają samą konfigurację jak Halo Wars 2, Forza Motosport 7, Forza H4, FarCry 5, itd. to żadnego problemu nie będzie i masz idealnie tak samo jak po podpięciu do konsoli. Jednak jeśli gra do odpalenia HDR wymusza przejście w Windowsie do trybu HDR (np. Shadow of War) to wtedy musisz ustawić z panelu kontrolnego nasycenie jakie ci odpowiada. Z TV jest prościej o tyle że możesz sobie regulować TV, w przypadku monitora pewne funkcje są cyfrowo zablokowane dla panelu sterowania.

Proponuję abyś wziął dwie gry na test tj. Far Cry 5, ustawiając tam HDR dla FS2 oraz Shadow of Tomb Raider lub FM7, FH4 - od nich przeszedł do innych. Zrobisz to bezproblemowo, nie jest to wina monitora bo sprawdziłeś podpinając go pod konsole.

Obraz w HDR to przepaść względem SDR i wszystkie gry z HDR (mam wszystkie na PC z HDR) działają perfekcyjnie.

blood - gier z RT jest niewiele ale tam gdzie została użyta ta technologia to jest ziemia / a niebo jeśli chodzi o aspekt wizualny. Poza tym dzięki pascalowi można teraz włączyć GI dla większości gier (obecnie mam betę reshade dla DX12 i też działa) więc mogę nawet powiedzieć że dla wszystkich, z SSR sprawia że gry po prostu wyglądają niesamowicie względem tego jak zostały dostarczone w wersji podstawowej.

efekt choćby tutaj

https://www.youtube.com/watch?v=yztbcnE-0PA

https://www.youtube.com/watch?v=KIJfBeANLVo

https://www.youtube.com/watch?v=Qo3h895soM0

Najlepiej wykonane gry w HDR scena gradacja 0-4000cd/m2 dla Assassin's Creed Odyssey

wymaga większego zachodu z ustawieniami nic więcej i mimo że przez odcięcie na 600 powoduje że nie dostaniemy aż takiej głębi scen dalekich to i tak płomienie, ogniska, pochodnie, lampy słonce, a nawet elementy otoczenia budują scenę w HDR o wiele lepszą niż w SDR. Ty masz oled w tym wypadku może być jedynie problem przy ustawieniach maksymalnych jeśli nie wyłączysz radaru który dostał maksymalną jasność że go przeniesiesz do innych gier ;)

Fredgard - to nie również tylko przede wszystkim detale w bielach które zobaczysz właśnie mając większą rozpiętość. Analizę Vincenta widziałem zresztą często oglądam jego materiały, nie powiedział w tej analizie niczego co by nie było prawdą. Zakres jasności kończy się na 600 jednostkach, prawdą też jest to że jedyny suwak który podnosi jasność sceny to jasność całego ekranu, co nie zmienia faktu że wybierając w twoim B7 jasność 500 max w grze, nie jesteś w stanie ustawieniami TV w tym gammą, kontrastem, jasnością, czy ciepłotą ustawić aby było idealnie, bo oczywiście że możesz to zrobić jeśli tylko chcesz i to nawet na tym testowym ekranie gdzie pokazane jest niebo i chmury. Po to masz tyle ustawień w TV że wszystko możesz dopasować pod własne preferencje. Efekt HDR jest w grze odczuwalny nawet na białych płatkach kwiatów, nie mówiąc już o miejscach b. jasnych. Poświęć trochę czasu to sam ustawisz sobie to idealnie, prawdą jest natomiast to że jeśli chcesz zrobić to tylko z poziomu gry to dając na 500 stracisz detale w bielach, a ciemne miejsca staną się jasne, ale przecież nikt by tak nie grał.

Bzdury totalne w większości grach efekt jest mizerny, choć faktycznie w niektórych daje wow.

Pamiętam jak jeszcze niedawno skrót HDR kojarzył mi się z ustawieniami w opcjach gry Half-Life 2. Następnie nastała kolejna fala mody na sprzęt który wnosi coś nowego. Wszyscy pamiętamy jeszcze niedawny boom na telewizory, a potem monitory 3D, oraz jak to jeszcze nie tak dawno świat miał oszaleć na punkcie zabawy VR. Moda przeminęła wprowadzone technologię okazały się dużo słabsze niż można było oczekiwać, ostatecznie rynek je wchłoną i o nich zapomniał.

Teraz mamy nowe hasło reklamowe 4K oraz HDR – czy to faktycznie nowa jakość ?

HDR czyli High Dynamic Range to oznaczenie szerokiego zakresu dynamiki, w skrócie można uznać że obraz ma dużo większą rozpiętość tonalną (dużo większą dostępność kolorów oraz odcieni). Obecnie standardowe monitory oraz telewizory mają 8 bitowe matryce (8bpc) oraz maksymalną jasność na poziomie 200-300 cd/m2 (nitów). W przypadku monitorów HDR mamy 10bitów (10bpc) oraz jasność przekraczająca 500cm/m2. W przypadku TV nawet 12bpc. Nie tak dawno wprowadzono oznaczenia certyfikujące które zostały dodane do monitorów jako VESA HDR 400 / 600 oraz najwyżej 1000.

Wraz z najnowszą wersją Windows 10 oznaczoną buildem 1803 z 21.05.2018 dostaliśmy możliwość włączenia HDR w opcjach windowsa. Ustawienia Ekranu -> Format HDR i WCG. [ta opcja pojawi się tylko wtedy kiedy Windows rozpozna monitor oraz kartę która umożliwi wyświetlenie treści HDR) Czy faktycznie to działa i jak to działa.

Po pierwsze należałoby wyjaśnić pewne aspekty techniczne (karta graficzna)

W przypadku kart graficznych obraz HDR możemy uzyskać na kartach graficznych Nvidia serii 9xx na wyjściu HDMI2.0 (nie ma możliwości uzyskania obrazu HDR na złączu DisplayPort), oraz Nvidia serii 10xx na złączu HDMI2.0 i DisplayPort1.4. (Niestety w przypadku kart AMD nie jestem w stanie tego precyzyjne określić ale prawdopodobnie jest on dostępny wraz z oznaczeniami kart RX 4/5.. (jeśli ktoś jest w stanie to zweryfikować to proszę o komentarz do uzupełnienia tematu). Obraz HDR jest wyświetlany tylko w pełnym ekranie (wynika to ze zmiany trybu pracy) nie można uruchomić gry w tym trybie w oknie, oraz jest dostarczany w rozdzielczości natywnej odbiornika. W przypadku monitorów 4K dostępny jest tylko w trybie 4K i 1080p. W przypadku monitorów HDR 1440p lub innych będzie dostępny w rozdzielczości natywnej.

(monitor/TV)